Wetenschap

Als de AI-ethiek verkeerd is, kan de technische vooruitgang teniet worden gedaan

AI kan worden gebruikt om potentiële daders van geweldsdelicten te identificeren en het risico op recidive in te schatten. Krediet:Max pixel, gelicentieerd onder CC0

Een intelligent waterpistool dat gezichtsherkenning gebruikt om zijn doelen te identificeren, helpt enkele van de opkomende mensenrechtenkwesties rond kunstmatige intelligentie (AI) te benadrukken - een onderzoeksgebied dat in opkomst is naarmate nieuwe technologieën steeds vaker voorkomen in onze dagelijkse leeft.

"Het is heel moeilijk om nu een AI-onderzoeker te zijn en je niet bewust te zijn van de ethische implicaties die deze algoritmen hebben, " zei professor Bernd Stahl, directeur van het Centre for Computing and Social Responsibility aan de Montfort University in Leicester, VK.

"We moeten tot een beter begrip komen van niet alleen wat deze technologieën kunnen doen, maar hoe ze zullen uitpakken in de samenleving en de wereld als geheel."

Hij leidt een project genaamd SHERPA, die probeert te worstelen met een aantal ethische kwesties rond slimme informatiesystemen die gebruikmaken van machine learning, een vorm van AI, en andere algoritmen om grote datasets te analyseren.

Het intelligente waterpistool is gemaakt met als doel te benadrukken hoe vooroordelen in algoritmen kunnen leiden tot discriminatie en oneerlijke behandeling. Gebouwd door een kunstenaar voor SHERPA, het waterpistool kan worden geprogrammeerd om zijn doelen te selecteren.

"Onze kunstenaar heeft een waterpistool gebouwd met gezichtsherkenning, zodat het alleen water naar vrouwen zal spuiten of het kan worden veranderd om een enkel individu of mensen van een bepaalde leeftijd te herkennen. " zei prof. Stahl. "Het idee is om mensen te laten nadenken over wat dit soort technologie kan doen."

Terwijl water naar mensen spuiten misschien onschuldig plezier lijkt, de problemen zijn allesbehalve. AI wordt al gebruikt om gezichten op sociale media te identificeren, reageren op vragen over digitale thuisassistenten zoals Alexa en Siri, en producten voorstellen aan consumenten wanneer ze online winkelen.

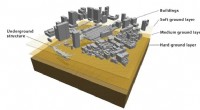

Het wordt ook gebruikt om te helpen maken oordelen over het recidiverisico van criminelen of zelfs om identificeren van degenen die mogelijk gewelddadige misdaden plegen . verzekeraars en Belastingdienst gebruiken het om fraude op te sporen, banken hebben zich tot AI gewend om leningaanvragen te verwerken en het wordt zelfs uitgeprobeerd bij grenscontroleposten .

effecten

Het afgelopen jaar, Prof. Stahl en zijn collega's hebben 10 casestudies samengesteld waarin ze de effecten van deze technologieën in een aantal sectoren empirisch hebben geanalyseerd. Deze omvatten het gebruik van AI in slimme steden, het gebruik ervan door de verzekeringssector, in het onderwijs, gezondheidszorg, landbouw en door overheden.

"Er zijn een aantal zeer spraakmakende dingen die sectoroverschrijdend zijn, zoals privacy, gegevensbescherming en cyberbeveiliging, ", aldus prof. Stahl. "AI creëert ook nieuwe uitdagingen voor het recht op werk als algoritmen de banen van mensen kunnen overnemen. of het recht op vrije verkiezingen als het kan worden gebruikt om zich in het democratische proces te mengen, zoals we zagen bij Cambridge Analytica."

Misschien is een van de meest controversiële nieuwe toepassingen van AI in predictive policing, waar algoritmen worden getraind op historische gegevenssets om patronen in gedrag en kenmerken van daders te ontdekken. Dit kan vervolgens worden gebruikt om gebieden te voorspellen, groepen of zelfs individuen die in de toekomst bij misdaden betrokken zouden kunnen zijn. Soortgelijke technologie wordt al uitgeprobeerd in sommige delen van de VS en het VK.

vooroordelen

Maar deze algoritmen kunnen ook de vooroordelen leren die al in datasets bestaan. Als uit een politiedatabase blijkt dat vooral jonge, zwarte mannen worden gearresteerd voor een bepaald misdrijf, het is misschien geen eerlijke weerspiegeling van het werkelijke daderprofiel en in plaats daarvan weerspiegelt het historisch racisme binnen een kracht. Het gebruik van AI die op dit soort gegevens wordt aangeleerd, kan problemen zoals racisme en andere vormen van discriminatie verergeren.

"Transparantie van deze algoritmen is ook een probleem, "zei prof. Stahl. "Deze algoritmen classificeren gegevens op een manier die het bijna onmogelijk maakt om te zien hoe dat precies is gebeurd." Dit roept belangrijke vragen op over hoe rechtssystemen, bijvoorbeeld, kunnen eerlijk en rechtvaardig blijven als ze beginnen te vertrouwen op ondoorzichtige 'black box' AI-algoritmen om veroordelingsbeslissingen of oordelen over iemands schuld te informeren.

De volgende stap voor het project zal zijn om te kijken naar mogelijke interventies die kunnen worden gebruikt om een aantal van deze problemen aan te pakken. Het zal bekijken waar richtlijnen kunnen helpen ervoor te zorgen dat AI-onderzoekers eerlijkheid inbouwen in hun algoritmen, waar nieuwe wetten het gebruik ervan kunnen regelen en of een regelgever negatieve aspecten van de technologie onder controle kan houden.

Maar een van de problemen waarmee veel regeringen en regelgevers worden geconfronteerd, is het snelle tempo van veranderingen in nieuwe technologieën zoals AI, volgens professor Philip Brey, die techniekfilosofie studeert aan de Universiteit Twente, in Nederland.

"De meeste mensen begrijpen de technologie tegenwoordig niet omdat het erg complex is, ondoorzichtig en snel bewegend, ", zei hij. "Om die reden is het moeilijk om de effecten op de samenleving te anticiperen en te beoordelen, en om daar adequate regelgevende en wetgevende reacties op te hebben. Het beleid loopt meestal flink achter."

Prof. Brey is coördinator van het SIENNA-project, die aanbevelingen en gedragscodes ontwikkelt voor een reeks opkomende technologieën, inclusief menselijke genomica, menselijke verbetering, AI en robotica.

Mijnbouw

"Informatietechnologie heeft, natuurlijk, al een grote impact hadden op de privacy via internet en de mobiele apparaten die we gebruiken, maar kunstmatige intelligentie is in staat om verschillende soorten informatie te combineren en te ontginnen op een manier die fundamenteel nieuwe informatie en inzichten over mensen onthult, "zei Prof. Brey. "Het kan dit op een zeer snelle en efficiënte manier doen."

AI-technologie opent de deur naar realtime analyse van het gedrag van mensen, emoties samen met het vermogen om details over hun mentale toestand of hun bedoelingen af te leiden.

"Dat was iets wat voorheen niet mogelijk was, "zei prof. Brey. "Wat je dan met deze informatie doet, roept nieuwe zorgen op over privacy."

Het SIENNA-team geeft workshops, raadplegingen van deskundigen en opiniepeilingen die tot doel hebben de zorgen van burgers in 11 landen in kaart te brengen. Ze bereiden zich nu voor op het opstellen van een reeks aanbevelingen die degenen die met AI en andere technologieën werken, kunnen omzetten in normen die ervoor zorgen dat ethische en mensenrechtenoverwegingen in de ontwerpfase worden vastgelegd.

Dit bredere publieke begrip van hoe de technologie hen waarschijnlijk zal beïnvloeden, kan van cruciaal belang zijn voor het voortbestaan van AI op de langere termijn, volgens prof. Stahl.

"Als we de ethiek niet goed krijgen, dan gaan mensen weigeren het te gebruiken en dat zal elke technische vooruitgang vernietigen, " hij zei.

Het verborgen pad van perovskietvorming onthullen

Het verborgen pad van perovskietvorming onthullen Onderzoekers bieden nieuwe methode om onderzoek naar schone energie te stimuleren

Onderzoekers bieden nieuwe methode om onderzoek naar schone energie te stimuleren Hoe gebruik je een rubberen stop in de chemie

Hoe gebruik je een rubberen stop in de chemie Een tweestapsbenadering gebruiken om alifatische amines om te zetten in onnatuurlijke aminozuren

Een tweestapsbenadering gebruiken om alifatische amines om te zetten in onnatuurlijke aminozuren Nieuwe moleculaire sondes voor opioïde receptoren

Nieuwe moleculaire sondes voor opioïde receptoren

Feiten over Caterpillars

Feiten over Caterpillars Hoe klimaatverandering het landelijke noordoosten zal beïnvloeden:verwacht drie weken hitte

Hoe klimaatverandering het landelijke noordoosten zal beïnvloeden:verwacht drie weken hitte Rina nu een grote post-tropische storm in de noordelijke centrale Atlantische Oceaan

Rina nu een grote post-tropische storm in de noordelijke centrale Atlantische Oceaan Gerecycleerde elektrische producten leiden tot gevaarlijke chemicaliën in alledaagse voorwerpen

Gerecycleerde elektrische producten leiden tot gevaarlijke chemicaliën in alledaagse voorwerpen De stijgende zeespiegel slokt de stranden van Outer Banks op, nieuw rapport zegt:

De stijgende zeespiegel slokt de stranden van Outer Banks op, nieuw rapport zegt:

Hoofdlijnen

- Studie:Grote witte haaien zwemmen steeds dieper

- Lymphatic System Science Activities

- Ontwikkeling van een zeer nauwkeurig computermodel van het menselijk metabolisme

- Saoedi-Arabische rotskunst toont riemen op prehistorische honden

- Welke soort apparatuur wordt gebruikt om DNA te analyseren?

- Studie onderzoekt obesitas en reproductieve status van dierentuinolifanten

- Nieuwe statistische methode voor het evalueren van reproduceerbaarheid in studies van genoomorganisatie

- Dieetbeperking en levensduur bij mannelijke en hermafrodiete wormen

- Vier belangrijke typen chromosomen

- Techreuzen beloven tegen 2022 het aantal vrouwelijke managers te verdubbelen

- Streaming titanen zoeken doorgang naar India voor nieuwe groei

- Kan Afrika bezuiden de Sahara in 2030 duurzame toegang tot energie voor iedereen bereiken?

- Computerwetenschappers gebruiken kunstmatige intelligentie om een aardbevingsfysica-simulator een boost te geven

- Hoe warmte kan worden gebruikt om duurzame energie op te slaan

Hoe Carrier Battle Groups werken

Hoe Carrier Battle Groups werken  Wetenschappers creëren manier om pacemaker van stroom te voorzien met licht

Wetenschappers creëren manier om pacemaker van stroom te voorzien met licht Huawei getroffen door Amerikaanse exportcontroles, mogelijk importverbod

Huawei getroffen door Amerikaanse exportcontroles, mogelijk importverbod Soorten booreilanden

Soorten booreilanden  NASA op jacht naar genieën in de ruimte-kak

NASA op jacht naar genieën in de ruimte-kak Hoe jezelf te beschermen tegen Lightning

Hoe jezelf te beschermen tegen Lightning Biochemistry Blotting Techniques

Biochemistry Blotting Techniques  Afbeelding:ESA's Cheops-satelliet

Afbeelding:ESA's Cheops-satelliet

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com