Wetenschap

Licht:een mogelijke oplossing voor een duurzame AI

De Franse startup LightOn werkt momenteel aan de ontwikkeling van door licht aangedreven technologieën. Krediet:Dmitriy Rybin / Shutterstock

We zijn getuige van de versnelde adoptie van kunstmatige intelligentie (AI), die het potentieel heeft om zich te vertalen in een verscheidenheid aan maatschappelijke veranderingen, inclusief verbeteringen aan de economie, betere levensomstandigheden, gemakkelijker toegang tot onderwijs, welzijn, en amusement. Zo'n langverwachte toekomst, echter, is besmet met kwesties met betrekking tot privacy, verklaarbaarheid, verantwoordelijkheid, om er een paar te noemen, die een bedreiging vormen voor de vlotte adoptie van AI, en die centraal staan in verschillende debatten in de media.

Een misschien zorgwekkender aspect houdt verband met het feit dat de huidige AI-technologieën volledig onhoudbaar zijn, en tenzij we snel handelen, dit zal het grootste obstakel worden voor de brede acceptatie van kunstmatige intelligentie in de samenleving.

AI en Bayesiaanse machine learning

Maar voordat we ingaan op de duurzaamheid van AI, wat is AI? AI is gericht op het bouwen van kunstmatige agenten die in staat zijn om hun omgeving te voelen en te redeneren, en uiteindelijk leren door ermee om te gaan. Machine Learning (ML) is een essentieel onderdeel van AI, wat het mogelijk maakt om correlaties en causale verbanden vast te stellen tussen variabelen die van belang zijn op basis van gegevens en voorkennis van de processen die de omgeving van de agent kenmerken.

Bijvoorbeeld, in de levenswetenschappen, ML kan nuttig zijn om de relatie tussen het volume van de grijze stof en de progressie van de ziekte van Alzheimer te bepalen, overwegende dat het in de milieuwetenschappen nuttig kan zijn om het effect van CO . te schatten 2 uitstoot op het klimaat. Een belangrijk aspect van sommige ML-technieken, in het bijzonder Bayesiaanse ML, is de mogelijkheid om dit te doen door rekening te houden met de onzekerheid door het gebrek aan kennis van het systeem, of het feit dat er een eindige hoeveelheid gegevens beschikbaar is.

Een dergelijke onzekerheid is van fundamenteel belang bij het nemen van beslissingen wanneer de kosten die met verschillende uitkomsten gepaard gaan, onevenwichtig zijn. Een paar voorbeelden van domeinen waar AI enorm kan helpen, zijn onder meer een verscheidenheid aan medische scenario's (bijv. diagnose, prognose, persoonlijke behandeling), milieuwetenschappen (bijv. klimaat, aardbeving/tsunami), en beleidsvorming (bijv. verkeer, sociale ongelijkheid aan te pakken).

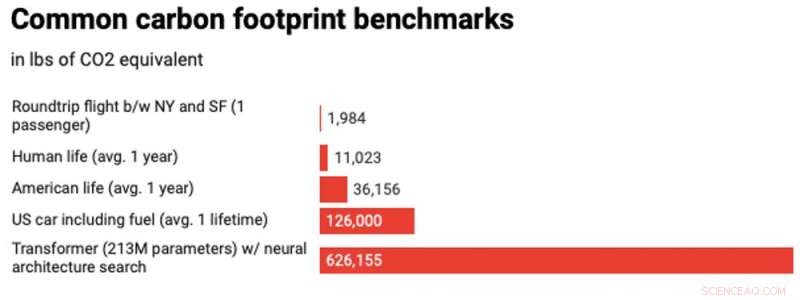

Credit:MIT Technology Review Bron:Strubell et al.

Niet-duurzame AI

Recente spectaculaire ontwikkelingen in ML hebben bijgedragen aan een ongekende toename van interesse in AI, die enorme hoeveelheden particuliere financiering in het domein heeft veroorzaakt (Google, Facebook, Amazone, Microsoft, OpenAI). Dit alles duwt het onderzoek in het veld, maar op de een of andere manier negeert het de impact ervan op het milieu. Het energieverbruik van de huidige computerapparatuur groeit ongecontroleerd. Geschat wordt dat binnen de komende tien jaar het stroomverbruik van computerapparatuur 60% zal bedragen van de totale hoeveelheid geproduceerde energie, en dit zal in 2040 volledig onhoudbaar worden.

Recente studies tonen aan dat de ICT-industrie vandaag de dag ongeveer 2% van de wereldwijde CO₂-uitstoot genereert, vergelijkbaar met de wereldwijde luchtvaartindustrie, maar de scherpe groeicurve die wordt voorspeld voor op ICT gebaseerde emissies is werkelijk alarmerend en overtreft de luchtvaart ver. Omdat ML en AI snelgroeiende ICT-disciplines zijn, dit is een zorgwekkend perspectief. Recente studies tonen aan dat de CO2-voetafdruk van het trainen van een beroemd ML-model, auto-encoder genoemd, kunnen tijdens hun leven maar liefst vijf auto's vervuilen.

Indien, om betere levensomstandigheden te creëren en onze risico-inschatting te verbeteren, we hebben zo'n grote impact op het milieu, we zijn gedoemd te mislukken. Wat kunnen we doen om dit radicaal te veranderen?

Laat er licht zijn

Transistorgebaseerde oplossingen voor dit probleem beginnen te verschijnen. Google heeft de Tensor Processing Unit (TPU) ontwikkeld en in 2018 beschikbaar gesteld. TPU's verbruiken per rekeneenheid een veel lager stroomverbruik dan GPU's en CPU's. Maar kunnen we ons losmaken van op transistors gebaseerde technologie voor computers met een lager vermogen en misschien wel sneller? Het antwoord is ja! In de laatste paar jaar, er zijn pogingen geweest om licht te benutten voor snelle en energiezuinige berekeningen. Dergelijke oplossingen zijn enigszins rigide in het ontwerp van de hardware en zijn geschikt voor specifieke ML-modellen, bijv. neurale netwerken.

interessant, Frankrijk loopt hierin voorop, met hardwareontwikkeling uit private financiering en nationale financiering voor onderzoek om deze revolutie concreet mogelijk te maken. Het Franse bedrijf LightOn heeft onlangs een nieuw optisch apparaat ontwikkeld, die ze Optical Processing Unit (OPU) noemden.

In praktijk, OPU's voeren een specifieke bewerking uit, dat is een lineaire transformatie van invoervectoren gevolgd door een niet-lineaire transformatie. interessant, dit wordt gedaan in hardware die gebruik maakt van de eigenschappen van verstrooiing van licht, zodat deze berekeningen in de praktijk met de snelheid van het licht en met een laag stroomverbruik gebeuren. Bovendien, het is mogelijk om zeer grote matrices te verwerken (in de orde van miljoenen rijen en kolommen), wat een uitdaging zou zijn met CPU's en GPU's. Door de verstrooiing van het licht, deze lineaire transformatie is het equivalent van een willekeurige projectie, bijv. de transformatie van de invoergegevens door een reeks willekeurige getallen waarvan de verdeling kan worden gekarakteriseerd. Zijn willekeurige projecties nuttig? Verrassend ja! Een proof-of-concept dat dit nuttig kan zijn om berekeningen voor sommige ML-modellen (kernelmachines, die een alternatief zijn voor neurale netwerken) is hier gerapporteerd. Andere ML-modellen kunnen ook gebruikmaken van willekeurige projecties voor voorspelling of detectie van veranderingspunten in tijdreeksen.

Wij geloven dat dit een opmerkelijke richting is om moderne ML schaalbaar en duurzaam te maken. De grootste uitdaging voor de toekomst, echter, is hoe het ontwerp en de implementatie van Bayesiaanse ML-modellen te heroverwegen om de berekeningen die OPU's bieden te kunnen benutten. Pas nu beginnen we met het ontwikkelen van de methodologie die nodig is om deze hardware volledig te benutten voor Bayesian ML. Ik heb onlangs een Franse beurs gekregen om dit mogelijk te maken.

Het is fascinerend hoe licht en willekeur niet alleen alomtegenwoordig zijn in de natuur, ze zijn ook wiskundig bruikbaar voor het uitvoeren van berekeningen die echte problemen kunnen oplossen.

Dit artikel is opnieuw gepubliceerd vanuit The Conversation onder een Creative Commons-licentie. Lees het originele artikel.

Een eenvoudige methode ontwikkeld voor 3D-biofabricage op basis van bacteriële cellulose

Een eenvoudige methode ontwikkeld voor 3D-biofabricage op basis van bacteriële cellulose The Differences Between Anionic and Cationic Single Replacement

The Differences Between Anionic and Cationic Single Replacement  Een methode voor computerondersteunde modellering en simulatie van grote eiwitten en andere biomoleculen

Een methode voor computerondersteunde modellering en simulatie van grote eiwitten en andere biomoleculen Nieuwe techniek lokaliseert locaties van individuele moleculen in hun cellulaire buurten

Nieuwe techniek lokaliseert locaties van individuele moleculen in hun cellulaire buurten Regeling van bellenvorming op elektroden

Regeling van bellenvorming op elektroden

Hoofdlijnen

- Onderzoekers ontdekken moleculaire add-ons die eiwitinterfaces aanpassen

- Hoe is de katoenplant aangepast om te overleven?

- Wetenschappers vinden potentiële wapens voor de strijd tegen antibioticaresistentie

- De oudste kleur van de aarde was roze

- Waar zijn spiervezels van gemaakt?

- Hoe werkt ruw ER met Ribosomes?

- Hoe verschilt gisting van cellulaire ademhaling?

- U kunt gecodeerde woorden lezen - onder bepaalde omstandigheden

- Opnieuw klonen van de eerste gekloonde hond die tot nu toe als succesvol werd beschouwd

- Nepalese sociale-mediawet wekt bezorgdheid over de vrijheid van meningsuiting

- Ierse gegevensautoriteit onderzoekt Facebook wegens inbreuk op accounts van 50 miljoen

- Ford gaat wereldwijd personeelsbestand schrappen

- Toekomstige millimetergolfnetwerken die zijn ingesteld om de beste eigenschappen van hoge en lage frequenties te leveren

- Om waterstof echt schoon te maken, moet het gemaakt zijn met hernieuwbare energiebronnen, geen steenkool

Zou het mogelijk zijn geweest om de vulkaanuitbarsting in Nieuw-Zeeland te voorspellen?

Zou het mogelijk zijn geweest om de vulkaanuitbarsting in Nieuw-Zeeland te voorspellen? Gekoelde elektriciteit

Gekoelde elektriciteit Oudste carbonaten in het zonnestelsel

Oudste carbonaten in het zonnestelsel Fraudeonderzoek richt zich op top Porsche-bazen:rapport

Fraudeonderzoek richt zich op top Porsche-bazen:rapport Surveillance in onze scholen:onder de vriendelijke buitenkant van ClassDojo

Surveillance in onze scholen:onder de vriendelijke buitenkant van ClassDojo Berekening van de winddruk op Banners

Berekening van de winddruk op Banners Menselijke impact op de atmosfeer van de aarde

Menselijke impact op de atmosfeer van de aarde Nieuwe katalyse met één atoom zorgt voor reductieve amineringsreactie

Nieuwe katalyse met één atoom zorgt voor reductieve amineringsreactie

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com