Wetenschap

Verbetering van de beveiliging naarmate kunstmatige intelligentie naar smartphones wordt verplaatst

Krediet:Ji Lin

Smartphones, beveiligingscamera's, en luidsprekers zijn slechts enkele van de apparaten waarop binnenkort meer kunstmatige-intelligentiesoftware zal worden uitgevoerd om beeld- en spraakverwerkingstaken te versnellen. Een compressietechniek die kwantisatie wordt genoemd, maakt de weg vrij door deep learning-modellen kleiner te maken om de reken- en energiekosten te verlagen. Maar kleinere modellen, het blijkt, maken het voor kwaadwillende aanvallers gemakkelijker om een AI-systeem te misleiden tot wangedrag - een punt van zorg omdat complexere besluitvorming wordt overgedragen aan machines.

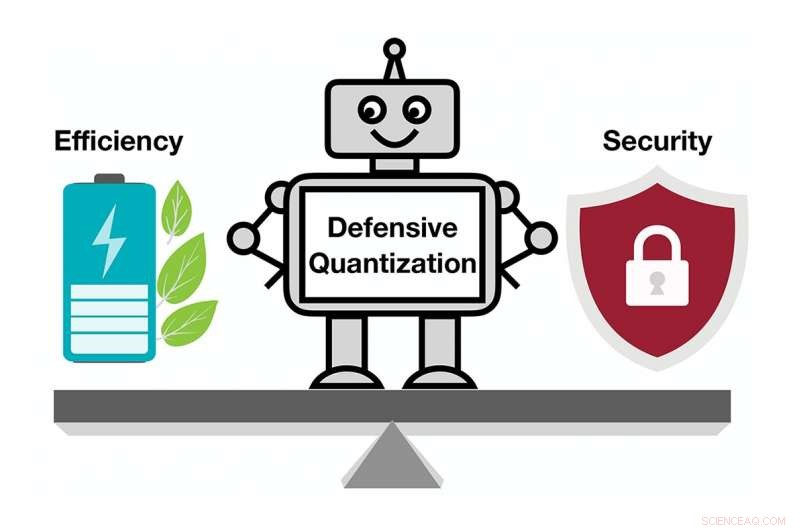

In een nieuwe studie, MIT- en IBM-onderzoekers laten zien hoe kwetsbaar gecomprimeerde AI-modellen zijn voor vijandige aanvallen, en ze bieden een oplossing:voeg een wiskundige beperking toe tijdens het kwantiseringsproces om de kans te verkleinen dat een AI ten prooi valt aan een licht gewijzigd beeld en een verkeerde classificatie van wat ze zien.

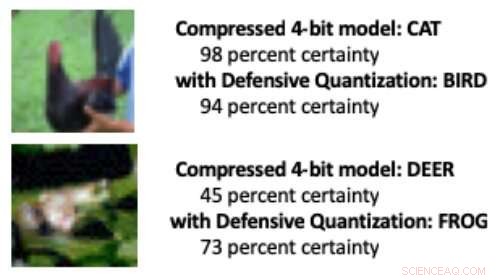

Wanneer een deep learning-model wordt teruggebracht van de standaard 32 bits naar een lagere bitlengte, het is waarschijnlijker dat gewijzigde afbeeldingen verkeerd worden geclassificeerd als gevolg van een foutversterkingseffect:het gemanipuleerde beeld wordt meer vervormd met elke extra verwerkingslaag. Aan het eind, het model zal eerder een vogel voor een kat aanzien, bijvoorbeeld, of een kikker voor een hert.

Modellen die zijn gekwantificeerd tot 8 bits of minder zijn gevoeliger voor vijandige aanvallen, de onderzoekers laten zien, met een nauwkeurigheid die daalt van een toch al lage 30-40 procent tot minder dan 10 procent naarmate de bitbreedte afneemt. Maar het beheersen van de Lipschitz-beperking tijdens kwantisering herstelt enige veerkracht. Toen de onderzoekers de beperking toevoegden, ze zagen kleine prestatiewinst bij een aanval, waarbij de kleinere modellen in sommige gevallen beter presteren dan het 32-bits model.

Toen een paar pixels in de bovenstaande afbeeldingen werden gemanipuleerd om een vijandige aanval te simuleren, een standaard gecomprimeerd model classificeerde de kip verkeerd als "kat" en de kikker als "hert". Maar toen onderzoekers een beperking toevoegden tijdens compressie, het model classificeerde de dieren correct, zelfs beter presteren dan een 32-bits model met volledige precisie. Krediet:Massachusetts Institute of Technology

"Onze techniek beperkt foutversterking en kan zelfs gecomprimeerde deep learning-modellen robuuster maken dan modellen met volledige precisie, " zegt Song Han, een assistent-professor aan de afdeling Elektrotechniek en Computerwetenschappen van MIT en lid van de Microsystems Technology Laboratories van MIT. "Met de juiste kwantisering, we kunnen de fout beperken."

Het team is van plan de techniek verder te verbeteren door deze te trainen op grotere datasets en toe te passen op een breder scala aan modellen. "Deep learning-modellen moeten snel en veilig zijn naarmate ze een wereld van met internet verbonden apparaten binnengaan, " zegt studie co-auteur Chuang Gan, een onderzoeker bij het MIT-IBM Watson AI Lab. "Onze defensieve kwantiseringstechniek helpt op beide fronten."

De onderzoekers, waaronder MIT-afgestudeerde student Ji Lin, presenteren hun resultaten op de International Conference on Learning Representations in mei.

Door AI-modellen kleiner te maken, zodat ze sneller werken en minder energie verbruiken, Han gebruikt AI zelf om de grenzen van modelcompressietechnologie te verleggen. In gerelateerd recent werk, Han en zijn collega's laten zien hoe wapeningsleren kan worden gebruikt om automatisch de kleinste bitlengte voor elke laag in een gekwantiseerd model te vinden op basis van hoe snel het apparaat waarop het model draait afbeeldingen kan verwerken. Deze flexibele bitbreedtebenadering vermindert latentie en energieverbruik met maar liefst 200 procent in vergelijking met een vast, 8-bits model, zegt Han. De onderzoekers presenteren hun resultaten op de conferentie Computer Vision and Pattern Recognition in juni.

Dit verhaal is opnieuw gepubliceerd met dank aan MIT News (web.mit.edu/newsoffice/), een populaire site met nieuws over MIT-onderzoek, innovatie en onderwijs.

Hoofdlijnen

- Ecosysteem: definitie, types, structuur en voorbeelden

- De structuur van een eukaryote cel

- Wetenschappers volgen aseksuele kleine wormen - waarvan de afstamming 18 miljoen jaar teruggaat

- Wisseling van de wacht - onderzoek werpt licht op hoe planten ademen

- Hoe werken het ademhalingsstelsel en het cardiovasculaire systeem samen?

- Nieuwe interactieve technologie maakt zeldzame celtypes zichtbaar

- Lijst met waterverontreinigende stoffen

- Ryk heeft een begeleider nodig

- Alles in de familie:gerichte genomische vergelijkingen

- Een nieuwe ontwerpstrategie om 2D elektronische apparaten te fabriceren met behulp van ultradunne diëlektrica

- Thuiswerken om corona te voorkomen? Met deze technologie kun je (bijna) het kantoor nabootsen

- Een digitale tweeling ontwikkelen

- Quibi lanceert Hollywood voor onderweg streaming tijdens lockdown

- Vulkanische groei voor bitcoin in koud IJsland

Wat veroorzaakt zwaartekracht op aarde?

Wat veroorzaakt zwaartekracht op aarde?  NASA eert 7 doden op spaceshuttle Columbia 15 jaar geleden

NASA eert 7 doden op spaceshuttle Columbia 15 jaar geleden Chinese fusietool duwt voorbij 100 miljoen graden

Chinese fusietool duwt voorbij 100 miljoen graden Pinterest, YouTube zegt optreden tegen antivaccinatieberichten

Pinterest, YouTube zegt optreden tegen antivaccinatieberichten Onderzoekers onderzoeken de perceptie van klimaatverandering bij producenten van speciale gewassen

Onderzoekers onderzoeken de perceptie van klimaatverandering bij producenten van speciale gewassen Opwarmende Groenlandse ijskap passeert point of no return

Opwarmende Groenlandse ijskap passeert point of no return Hoe de berekeningen voor spectrofotometers te berekenen

Hoe de berekeningen voor spectrofotometers te berekenen Zelfrijdende auto's zijn er al, maar de wegen zijn er nog niet klaar voor

Zelfrijdende auto's zijn er al, maar de wegen zijn er nog niet klaar voor

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com