Wetenschap

Informatietheorie biedt verrassingen voor machine learning

Krediet:CC0 Publiek Domein

Nieuw SFI-onderzoek daagt een populaire opvatting uit over hoe algoritmen voor machine learning 'denken' over bepaalde taken.

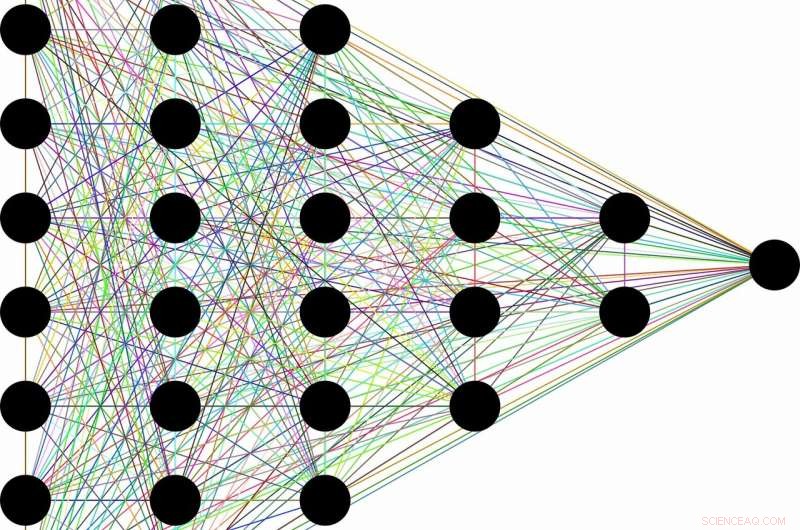

De conceptie gaat ongeveer als volgt:vanwege hun vermogen om nutteloze informatie weg te gooien, een klasse van algoritmen voor machinaal leren die diepe neurale netwerken worden genoemd, kan algemene concepten leren van onbewerkte gegevens, zoals het identificeren van katten in het algemeen na tienduizenden afbeeldingen van verschillende katten in verschillende situaties. Dit schijnbaar menselijke vermogen zou ontstaan als een bijproduct van de gelaagde architectuur van de netwerken. Vroege lagen coderen het 'kat'-label samen met alle onbewerkte informatie die nodig is voor voorspelling. Volgende lagen comprimeren dan de informatie, als door een bottleneck. Irrelevante gegevens, zoals de kleur van de vacht van de kat, of het schoteltje melk ernaast, wordt vergeten, waarbij alleen algemene kenmerken achterblijven. Informatietheorie geeft grenzen aan hoe optimaal elke laag is, in termen van hoe goed het de concurrerende eisen van compressie en voorspelling in evenwicht kan brengen.

"Vaak als je een neuraal netwerk hebt en het leert gezichten aan namen te koppelen, of afbeeldingen naar numerieke cijfers, of verbazingwekkende dingen zoals Franse tekst naar Engelse tekst, het heeft veel tussenliggende verborgen lagen waar informatie doorheen stroomt, " zegt Artemy Kolchinsky, een SFI Postdoctoral Fellow en de hoofdauteur van de studie. "Dus er is een al lang bestaand idee dat als ruwe input wordt getransformeerd naar deze tussenliggende representaties, het systeem verhandelt voorspelling voor compressie, en het bouwen van concepten op een hoger niveau door deze informatieknelpunt."

Echter, Kolchinsky en zijn medewerkers Brendan Tracey (SFI, MIT) en Steven Van Kuyk (Universiteit van Wellington) ontdekten een verrassende zwakte toen ze deze uitleg toepasten op veelvoorkomende classificatieproblemen, waarbij elke ingang één correcte uitgang heeft (bijv. waarin elke afbeelding van een kat of van een hond kan zijn). In dergelijke gevallen, ze ontdekten dat classificaties met veel lagen over het algemeen geen enkele voorspelling opgeven voor verbeterde compressie. Ze ontdekten ook dat er veel "triviale" representaties van de inputs zijn, vanuit het oogpunt van informatietheorie, optimaal in termen van hun balans tussen voorspelling en compressie.

"We ontdekten dat deze knelpuntmeting voor informatie compressie niet op dezelfde manier ziet als jij of ik. Gezien de keuze, het is net zo blij om 'martini-brillen' op één hoop te gooien met 'Labradors', zoals het is om ze op één hoop te gooien met champagnefluiten, '" legt Tracey uit. "Dit betekent dat we moeten blijven zoeken naar compressiemaatregelen die beter passen bij onze opvattingen over compressie."

Hoewel het idee om invoer te comprimeren nog steeds een nuttige rol kan spelen bij machine learning, dit onderzoek suggereert dat het niet voldoende is voor het evalueren van de interne representaties die worden gebruikt door verschillende machine learning-algoritmen.

Tegelijkertijd, Kolchinsky zegt dat het concept van een afweging tussen compressie en voorspelling nog steeds geldt voor minder deterministische taken, zoals het weer voorspellen op basis van een luidruchtige dataset. "We zeggen niet dat informatieknelpunt nutteloos is voor gesuperviseerd [machine] leren, " benadrukt Kolchinsky. "Wat we hier laten zien, is dat het zich contra-intuïtief gedraagt bij veel voorkomende machine learning-problemen, en dat is iets waar mensen in de machine learning-gemeenschap zich bewust van moeten zijn."

Activiteiten voor het onderwijzen van warme en koude temperaturen

Activiteiten voor het onderwijzen van warme en koude temperaturen  Feiten over calciumchloride

Feiten over calciumchloride Elektronische neus ontwikkeld om darmziekten op te sporen

Elektronische neus ontwikkeld om darmziekten op te sporen Hoe een Vietnamese rauwe varkenssnack ons kan helpen voedsel vers te houden, van nature

Hoe een Vietnamese rauwe varkenssnack ons kan helpen voedsel vers te houden, van nature Onderzoekssamenwerking kan spuitgieten een nieuwe vorm geven

Onderzoekssamenwerking kan spuitgieten een nieuwe vorm geven

Wat is het stedelijk hitte-eilandeffect?

Wat is het stedelijk hitte-eilandeffect?  Onderzoek suggereert dat er overblijfselen zijn van de Beringstraat en andere menselijke migratiepaden onder water op knelpunten

Onderzoek suggereert dat er overblijfselen zijn van de Beringstraat en andere menselijke migratiepaden onder water op knelpunten Een wereldkaart om veranderende bossen te begrijpen

Een wereldkaart om veranderende bossen te begrijpen Krachtige tyfoon Faxai teistert de regio Tokio

Krachtige tyfoon Faxai teistert de regio Tokio Voorheen onbekend mechanisme veroorzaakt een verhoogd gebruik van boswater, nieuwe studie zegt

Voorheen onbekend mechanisme veroorzaakt een verhoogd gebruik van boswater, nieuwe studie zegt

Hoofdlijnen

- In de strijd tegen virale infectie, spelling telt

- De geleidbaarheid van zenuwcellen in het centrale zenuwstelsel

- Wetenschappers ontcijferen mechanismen die ten grondslag liggen aan de biologie van veroudering

- Morfogenese en de ontwikkeling van levende vormen

- Epigenetica: definitie, hoe het werkt, voorbeelden

- Otzi the Iceman at een vetrijke laatste maaltijd

- Vijf belangrijke orgaansystemen van het lichaam

- Celmodel onthult dynamische aard van segmentatieklok die de vorming van wervels stimuleert

- Gebruik van recombinant DNA in Agriculture

Dode zone Golf van Mexico deze zomer kleiner dan gemiddeld door stormen

Dode zone Golf van Mexico deze zomer kleiner dan gemiddeld door stormen Betere kleuren gebruiken in de wetenschap

Betere kleuren gebruiken in de wetenschap Nabijheid van actieve sites op maat van zeoliet voor efficiënte productie van pentaan-biobrandstoffen

Nabijheid van actieve sites op maat van zeoliet voor efficiënte productie van pentaan-biobrandstoffen Nanotech kan ons veiliger, groenere luiers en sanitaire producten

Nanotech kan ons veiliger, groenere luiers en sanitaire producten Rihanna slaat Snapchat over kloppende advertentie, het verzenden van aandelen tuimelen

Rihanna slaat Snapchat over kloppende advertentie, het verzenden van aandelen tuimelen Schade door kanjer-orkanen die om vele redenen toenemen

Schade door kanjer-orkanen die om vele redenen toenemen Nieuw biomateriaal ontwikkeld voor injecteerbare neuronale controle

Nieuw biomateriaal ontwikkeld voor injecteerbare neuronale controle Computermodel suggereert dat aardbevingen tot ver buiten de vloeistofinjectiezones worden veroorzaakt

Computermodel suggereert dat aardbevingen tot ver buiten de vloeistofinjectiezones worden veroorzaakt

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Swedish | German | Dutch | Danish | Norway | Portuguese |

-

Wetenschap © https://nl.scienceaq.com