Wetenschap

Twitter-bots hadden een onevenredige rol bij het verspreiden van verkeerde informatie bij de verkiezingen van 2016:studie

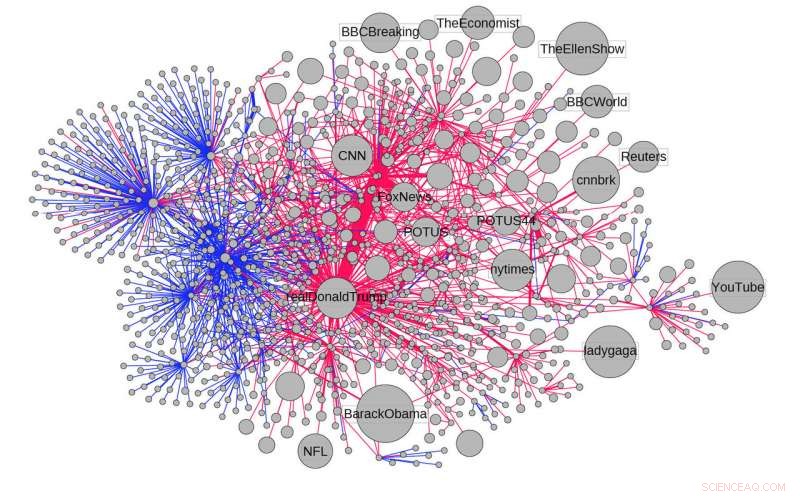

De verspreiding van een artikel dat beweerde dat 3 miljoen illegale immigranten hebben gestemd bij de Amerikaanse presidentsverkiezingen van 2016. De links tonen de verspreiding van het artikel via retweets en geciteerde tweets, in blauw, en antwoorden en vermeldingen, in het rood. Krediet:Filippo Menczer, Universiteit van Indiana

Een analyse van informatie die tijdens de Amerikaanse presidentsverkiezingen van 2016 op Twitter is gedeeld, heeft uitgewezen dat geautomatiseerde accounts (of 'bots') een onevenredige rol speelden bij het verspreiden van verkeerde informatie online.

De studie, uitgevoerd door onderzoekers van Indiana University en gepubliceerd op 20 november in het tijdschrift Natuurcommunicatie , analyseerde 14 miljoen berichten en 400, 000 artikelen gedeeld op Twitter tussen mei 2016 en maart 2017, een periode die het einde van de presidentiële voorverkiezingen van 2016 en de presidentiële inauguratie op 20 januari overspant, 2017.

Een van de bevindingen:slechts 6 procent van de Twitter-accounts die door het onderzoek werden geïdentificeerd als bots, waren voldoende om 31 procent van de "lage geloofwaardigheid" -informatie op het netwerk te verspreiden. Deze accounts waren ook verantwoordelijk voor 34 procent van alle artikelen die werden gedeeld vanuit bronnen met een "lage geloofwaardigheid".

Uit het onderzoek bleek ook dat bots een belangrijke rol speelden bij het promoten van inhoud met een lage geloofwaardigheid in de eerste paar momenten voordat een verhaal viraal ging.

De korte duur van deze tijd - 2 tot 10 seconden - benadrukt de uitdagingen van het tegengaan van de verspreiding van verkeerde informatie online. Soortgelijke problemen doen zich voor in andere complexe omgevingen zoals de aandelenmarkt, waar in enkele ogenblikken ernstige problemen kunnen ontstaan door de impact van hoogfrequente handel.

"Deze studie stelt vast dat bots een belangrijke bijdrage leveren aan de verspreiding van desinformatie online - en laat zien hoe snel deze berichten zich kunnen verspreiden, " zei Filippo Menczer, een professor aan de IU School of Informatics, Informatica en techniek, die de studie leidde.

Uit de analyse bleek ook dat bots het volume en de zichtbaarheid van een bericht vergroten totdat het waarschijnlijker is dat het breed wordt gedeeld, ondanks het feit dat ze slechts een klein deel vertegenwoordigen van de accounts die virale berichten verspreiden.

"Mensen hebben de neiging om meer vertrouwen te hebben in berichten die van veel mensen afkomstig lijken te zijn, " zei co-auteur Giovanni Luca Ciampaglia, een assistent-onderzoeker bij het IU Network Science Institute op het moment van het onderzoek. "Bots jagen op dit vertrouwen door berichten zo populair te laten lijken dat echte mensen worden misleid om hun berichten voor hen te verspreiden."

Informatiebronnen die in het onderzoek als weinig geloofwaardig werden bestempeld, werden geïdentificeerd op basis van hun verschijning op lijsten die zijn opgesteld door onafhankelijke externe organisaties van verkooppunten die regelmatig valse of misleidende informatie delen. Deze bronnen, zoals websites met misleidende namen zoals 'USAToday.com.co', bevatten verkooppunten met zowel een naar rechts als naar links gericht standpunt.

De onderzoekers identificeerden ook andere tactieken voor het verspreiden van verkeerde informatie met Twitter-bots. Deze omvatten het versterken van een enkele tweet - mogelijk gecontroleerd door een menselijke operator - over honderden geautomatiseerde retweets; herhalende links in terugkerende berichten; en gericht op zeer invloedrijke accounts.

Bijvoorbeeld, de studie citeert een geval waarin een enkel account @realDonaldTrump noemde in 19 afzonderlijke berichten over miljoenen illegale immigranten die stemmen bij de presidentsverkiezingen - een valse bewering die ook een belangrijk gespreksonderwerp van de regering was.

De onderzoekers voerden ook een experiment uit in een gesimuleerde versie van Twitter en ontdekten dat de verwijdering van 10 procent van de accounts in het systeem - op basis van hun waarschijnlijkheid om bots te zijn - resulteerde in een grote daling van het aantal verhalen uit bronnen met een lage geloofwaardigheid in het netwerk.

"Dit experiment suggereert dat de eliminatie van bots uit sociale netwerken de hoeveelheid verkeerde informatie op deze netwerken aanzienlijk zou verminderen, ' zei Menzer.

De studie suggereert ook stappen die bedrijven zouden kunnen nemen om de verspreiding van verkeerde informatie op hun netwerken te vertragen. Deze omvatten het verbeteren van algoritmen om bots automatisch te detecteren en het vereisen van een "mens in de lus" om geautomatiseerde berichten in het systeem te verminderen. Bijvoorbeeld, gebruikers moeten mogelijk een CAPTCHA invullen om een bericht te verzenden.

Hoewel hun analyse gericht was op Twitter, de auteurs van het onderzoek voegden eraan toe dat andere sociale netwerken ook kwetsbaar zijn voor manipulatie. Bijvoorbeeld, platforms zoals Snapchat en WhatsApp kunnen moeite hebben om verkeerde informatie op hun netwerken te controleren, omdat hun gebruik van codering en vernietigbare berichten de mogelijkheid bemoeilijkt om te bestuderen hoe hun gebruikers informatie delen.

"Naarmate mensen over de hele wereld zich steeds meer tot sociale netwerken wenden als hun primaire bron van nieuws en informatie, de strijd tegen desinformatie vereist een gefundeerde beoordeling van de relatieve impact van de verschillende manieren waarop deze zich verspreidt, "Zei Menczer. "Dit werk bevestigt dat bots een rol spelen in het probleem - en suggereert dat hun vermindering de situatie zou kunnen verbeteren."

Om verkiezingsberichten te bekijken die momenteel op Twitter worden gedeeld, De onderzoeksgroep van Menczer heeft onlangs ook een tool gelanceerd om 'Bot Electioneering Volume' te meten. Gemaakt door IU Ph.D. studenten, het programma toont het niveau van botactiviteit rond specifieke verkiezingsgerelateerde gesprekken, evenals de onderwerpen, gebruikersnamen en hashtags die ze momenteel pushen.

Onderzoek toont aan dat druk ongewoon hoge elektrische geleidbaarheid induceert in polyjodide

Onderzoek toont aan dat druk ongewoon hoge elektrische geleidbaarheid induceert in polyjodide Nieuwe methode versnelt simulaties, nieuwe inzichten geven in eiwitvouwing

Nieuwe methode versnelt simulaties, nieuwe inzichten geven in eiwitvouwing Kirigami kan terahertz-stralen in realtime ronddraaien om in biologisch weefsel te kijken

Kirigami kan terahertz-stralen in realtime ronddraaien om in biologisch weefsel te kijken Hoe chemische reacties te voltooien

Hoe chemische reacties te voltooien Hoe een natriumchlorideoplossing te maken

Hoe een natriumchlorideoplossing te maken

Grote landvormen in de regio Midwesten

Grote landvormen in de regio Midwesten  Historische waterstanden bij reservoirs en dammen in Irak:Ambtenaren

Historische waterstanden bij reservoirs en dammen in Irak:Ambtenaren Over milieubescherming, Bidens-verkiezing betekent een ommezwaai van 180 graden van het beleid van Trump

Over milieubescherming, Bidens-verkiezing betekent een ommezwaai van 180 graden van het beleid van Trump Wat zijn verschillende soorten blizzards?

Wat zijn verschillende soorten blizzards?  Gas stijgt wereldwijd terwijl groene groepen huilen

Gas stijgt wereldwijd terwijl groene groepen huilen

Hoofdlijnen

- Nurture to Nature: hoe uw opvoeding uw hersenen kan beïnvloeden

- Alfred Russel Wallace: Biography, Theory of Evolution & Facts

- Geboren onder een ongunstige maan, babyvissen vertragen nederzetting op koraalriffen

- Moderne genomica gebruiken om krokodillenschubben in vogelachtige veren te veranderen

- Wat zijn de vier organische moleculen in levende dingen?

- Zwarte neushoorn keert terug naar Tsjaad na deal met Zuid-Afrika

- Hoe het placebo-effect werkt

- Wat zijn de structurele delen van de lange botten in het lichaam?

- Wat is een voorbeeld van een recessief fenotype?

- Waarom Amazon je foto's van je veranda stuurt

- AI-aangedreven camera's worden nieuw hulpmiddel tegen massale schietpartijen

- Apple zegt dat Amerikaanse tarieven op China averechts werken

- Duitse aanklagers vallen Audi-baas aan wegens valsspelen met diesel

- Honda nettowinst stijgt met 70% door belastingverlagingen VS stevige verkoop

Hebben cellen exotische vibrerende eigenschappen?

Hebben cellen exotische vibrerende eigenschappen? Kan een nieuwe ruimtewedloop de wereld verbinden met internet?

Kan een nieuwe ruimtewedloop de wereld verbinden met internet? Nieuwe kankerdodende deeltjes volgen met MRI

Nieuwe kankerdodende deeltjes volgen met MRI Kunnen drijvende steden mensen helpen zich aan te passen aan de stijgende zeespiegel?

Kunnen drijvende steden mensen helpen zich aan te passen aan de stijgende zeespiegel? NASA-maanbomen staan nog steeds als testament voor Apollo 14

NASA-maanbomen staan nog steeds als testament voor Apollo 14  Nieuwe Hubble-galerij toont objecten uit de populaire niet-komeet Messier-catalogus

Nieuwe Hubble-galerij toont objecten uit de populaire niet-komeet Messier-catalogus De ontdekking van fantoomvulkanen geeft nieuwe hoop aan voor olie- en gasexploratie in de Noordzee

De ontdekking van fantoomvulkanen geeft nieuwe hoop aan voor olie- en gasexploratie in de Noordzee Plastic vormt een grote bedreiging voor het milieu, maar wordt het overdreven?

Plastic vormt een grote bedreiging voor het milieu, maar wordt het overdreven?

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com