Wetenschap

Nieuwe methode gluurt in de zwarte doos van kunstmatige intelligentie

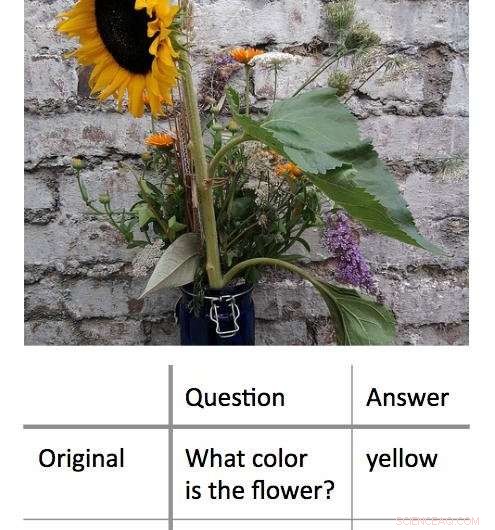

Een nieuwe methode om de besluitvormingsprocessen die worden gebruikt door 'black box' machine learning-algoritmen te decoderen, werkt door de minimale invoer te vinden die nog steeds een correct antwoord oplevert. In dit voorbeeld, de onderzoekers presenteerden eerst een algoritme met een foto van een zonnebloem en vroegen 'Welke kleur heeft de bloem?' Dit resulteerde in het juiste antwoord, 'geel.' De onderzoekers ontdekten dat ze hetzelfde juiste antwoord konden krijgen, met een even hoge mate van vertrouwen, door het algoritme een vraag van één woord te stellen:'Bloem?' Krediet:Shi Feng/Universiteit van Maryland

Kunstmatige intelligentie, in het bijzonder machine learning - maakt deel uit van het dagelijks leven van computer- en smartphonegebruikers. Van het automatisch corrigeren van typefouten tot het aanbevelen van nieuwe muziek, machine learning-algoritmen kunnen het leven gemakkelijker maken. Ze kunnen ook fouten maken.

Het kan voor computerwetenschappers een uitdaging zijn om erachter te komen wat er in dergelijke gevallen is misgegaan. Dit komt omdat veel algoritmen voor machine learning leren van informatie en hun voorspellingen doen in een virtuele "black box, " en laat weinig aanwijzingen achter voor onderzoekers om te volgen.

Een groep computerwetenschappers van de Universiteit van Maryland heeft een veelbelovende nieuwe benadering ontwikkeld voor het interpreteren van machine learning-algoritmen. In tegenstelling tot eerdere pogingen, die doorgaans probeerden de algoritmen te "breken" door sleutelwoorden uit de invoer te verwijderen om het verkeerde antwoord op te leveren, de UMD-groep verminderde in plaats daarvan de invoer tot het absolute minimum dat nodig is om het juiste antwoord te geven. Gemiddeld, de onderzoekers kregen het juiste antwoord met een invoer van minder dan drie woorden.

In sommige gevallen, de modelalgoritmen van de onderzoekers gaven het juiste antwoord op basis van een enkel woord. Vaak, het ingevoerde woord of zinsdeel leek weinig duidelijk verband te houden met het antwoord, onthullende belangrijke inzichten in hoe sommige algoritmen reageren op specifieke taal. Omdat veel algoritmen zijn geprogrammeerd om hoe dan ook een antwoord te geven, zelfs als ze worden gevraagd door een onzinnige invoer, kunnen de resultaten computerwetenschappers helpen om effectievere algoritmen te bouwen die hun eigen beperkingen kunnen herkennen.

De onderzoekers presenteren hun werk op 4 november, 2018 op de 2018-conferentie over empirische methoden in natuurlijke taalverwerking.

"Black-box-modellen lijken beter te werken dan eenvoudigere modellen, zoals beslisbomen, maar zelfs de mensen die de eerste code hebben geschreven, kunnen niet precies zeggen wat er gebeurt, " zei Jordan Boyd-Graber, de senior auteur van de studie en een universitair hoofddocent computerwetenschappen aan de UMD. "Als deze modellen onjuiste of onzinnige antwoorden geven, het is moeilijk om erachter te komen waarom. Dus in plaats daarvan, we hebben geprobeerd de minimale invoer te vinden die het juiste resultaat zou opleveren. De gemiddelde invoer was ongeveer drie woorden, maar in sommige gevallen zouden we het tot een enkel woord kunnen herleiden."

Krediet:CC0 Publiek Domein

In een voorbeeld, de onderzoekers voerden een foto van een zonnebloem in en de op tekst gebaseerde vraag, "Welke kleur heeft de bloem?" als invoer in een modelalgoritme. Deze invoer leverde het juiste antwoord 'geel' op. Na het herformuleren van de vraag in verschillende kortere woordcombinaties, de onderzoekers ontdekten dat ze hetzelfde antwoord konden krijgen met "bloem?" als de enige tekstinvoer voor het algoritme.

In een andere, complexer voorbeeld, de onderzoekers gebruikten de prompt, "In 1899, John Jacob Astor IV investeerde $ 100, 000 voor Tesla om een nieuw verlichtingssysteem verder te ontwikkelen en te produceren. In plaats daarvan, Tesla gebruikte het geld om zijn experimenten in Colorado Springs te financieren."

Vervolgens vroegen ze het algoritme, "Waar heeft Tesla het geld van Astor aan uitgegeven?" en kreeg het juiste antwoord, "Colorado Springs-experimenten." Het reduceren van deze invoer tot het enkele woord "deed" leverde hetzelfde juiste antwoord op.

Het werk onthult belangrijke inzichten over de regels die machine learning-algoritmen toepassen bij het oplossen van problemen. Veel echte problemen met algoritmen ontstaan wanneer een invoer die logisch is voor mensen resulteert in een onzinnig antwoord. Door aan te tonen dat het tegenovergestelde ook mogelijk is - dat onzinnige inputs ook correcte, verstandige antwoorden - Boyd-Graber en zijn collega's demonstreren de behoefte aan algoritmen die kunnen herkennen wanneer ze een onzinnige vraag met een hoge mate van vertrouwen beantwoorden.

"Waar het op neerkomt is dat al dit mooie machine learning-gedoe eigenlijk best dom kan zijn, " zei Boyd-Graber, die ook co-aanstellingen heeft aan de University of Maryland Institute for Advanced Computer Studies (UMIACS) en het UMD's College of Information Studies and Language Science Center. "Als computerwetenschappers deze modellen trainen, we laten ze meestal alleen echte vragen of echte zinnen zien. We laten ze geen onzinnige zinnen of losse woorden zien. De modellen weten niet dat ze door deze voorbeelden in de war moeten worden gebracht."

De meeste algoritmen zullen zichzelf dwingen om een antwoord te geven, zelfs met onvoldoende of tegenstrijdige gegevens, volgens Boyd-Graber. Dit zou de kern kunnen zijn van enkele van de onjuiste of onzinnige resultaten die worden gegenereerd door machine learning-algoritmen - in modelalgoritmen die worden gebruikt voor onderzoek, evenals real-world algoritmen die ons helpen door spam-e-mail te markeren of alternatieve routebeschrijvingen aan te bieden. Als u meer over deze fouten begrijpt, kunnen computerwetenschappers oplossingen vinden en betrouwbaardere algoritmen bouwen.

"We laten zien dat modellen kunnen worden getraind om te weten dat ze verward moeten worden, "Zei Boyd-Graber. "Dan kunnen ze gewoon naar buiten komen en zeggen:'Je hebt me iets laten zien dat ik niet kan begrijpen.'"

Gemanipuleerde gist kan het bereik van biobrandstoffen vergroten

Gemanipuleerde gist kan het bereik van biobrandstoffen vergroten Er kunnen meer monden worden gevoed door het aantal plantporiën te vergroten

Er kunnen meer monden worden gevoed door het aantal plantporiën te vergroten Doorbraak in het bestuderen van het enzym dat uiteindelijk het visgeursyndroom veroorzaakt

Doorbraak in het bestuderen van het enzym dat uiteindelijk het visgeursyndroom veroorzaakt Verbrandingskalium Nitraat

Verbrandingskalium Nitraat Rekbaar, zelfherstellende en halfgeleidende polymeerfilms voor elektronische huid (e-skin)

Rekbaar, zelfherstellende en halfgeleidende polymeerfilms voor elektronische huid (e-skin)

Nieuwe studie toont manieren om de temperatuurverlagende voordelen van groene daken in Chicago te maximaliseren

Nieuwe studie toont manieren om de temperatuurverlagende voordelen van groene daken in Chicago te maximaliseren VS halen Saoedi-Arabië in als producent van ruwe olie:IEA

VS halen Saoedi-Arabië in als producent van ruwe olie:IEA Nieuwe VN-tool brengt overstromingen sinds 1985 in kaart tot straatniveau, zal helpen bij het plannen van rampen, vooral in Global South

Nieuwe VN-tool brengt overstromingen sinds 1985 in kaart tot straatniveau, zal helpen bij het plannen van rampen, vooral in Global South De olieachtige waarheid over palmolie

De olieachtige waarheid over palmolie  Slechts 10 riviersystemen dragen tot 95 procent bij aan plastic in oceanen

Slechts 10 riviersystemen dragen tot 95 procent bij aan plastic in oceanen

Hoofdlijnen

- Stamcelvaccins: de nieuwe grens in kankertherapie?

- Zeeschildpadden sterven nadat ze verstrikt zijn geraakt in plastic afval

- Ecologie: definitie, soorten, belang en voorbeelden

- 10 oudst bekende ziekten

- Relatie tussen DNA-basen Genen, eiwitten en eigenschappen

- Cell Analogy Project Ideas

- Welke soort is het meest geschikt voor het leven? Allen hebben een gelijke kans, wetenschappers zeggen:

- Inspanningen zijn bedoeld om de verspreiding van vuurmieren in de VS te beperken

- Een veranderend klimaat, wijn wisselen

- Praten over hoe we praten over de ethiek van kunstmatige intelligentie

- Facebook klaagt analysebedrijf aan voor misbruik van gegevens

- Winst Amazon stijgt terwijl aandelen wegglijden (update)

- De druk op YouTube neemt toe om jonge gebruikers beter te beschermen

- Emotieherkenning heeft een privacyprobleem - zo los je het op

Experts verklaren het effect van klimaatverandering op infrastructuur

Experts verklaren het effect van klimaatverandering op infrastructuur Wetenschappers en studenten publiceren blauwdrukken voor een goedkopere microscoop met één molecuul

Wetenschappers en studenten publiceren blauwdrukken voor een goedkopere microscoop met één molecuul Postglaciale geschiedenis van Lake of the Woods

Postglaciale geschiedenis van Lake of the Woods Iets groots heeft net Jupiter geraakt

Iets groots heeft net Jupiter geraakt Nieuw platform voor risicotriage lokaliseert toenemende bedreigingen voor de Amerikaanse infrastructuur

Nieuw platform voor risicotriage lokaliseert toenemende bedreigingen voor de Amerikaanse infrastructuur Mieren offeren hun koloniegenoten op als onderdeel van een dodelijke desinfectie

Mieren offeren hun koloniegenoten op als onderdeel van een dodelijke desinfectie Veiligheidszone redt gigantische manen van dodelijke duik

Veiligheidszone redt gigantische manen van dodelijke duik Het geheim van het volgen van dodelijke infecties? Het zou Mosquito Pee

Het geheim van het volgen van dodelijke infecties? Het zou Mosquito Pee

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | German | Dutch | Danish | Norway | Swedish |

-

Wetenschap © https://nl.scienceaq.com