Wetenschap

Emotieherkenning heeft een privacyprobleem - zo los je het op

Krediet:CC0 Publiek Domein

Met apparaten die overal meeluisteren, privacykwesties zijn endemisch voor de voortschrijdende technologie. Bijzonder gevoelig zijn verschillende technieken die worden aangedreven door audio van uw smartphones en luidsprekers, consumenten in een constante kosten-batenanalyse te plaatsen tussen privacy en nut.

Nemen, bijvoorbeeld, een mobiele app of virtuele assistent die kan leren zich aan te passen aan de stemming van een gebruiker en emoties in realtime te herkennen. Dit soort aanpassing kan natuurlijker vloeiende gesprekken creëren, en nuttiger, menselijk begrip van stemassistenten. Maar waar trekt de gebruiker de grens als de audio die deze inzichten aandrijft, vol was opgeslagen met identificatiegegevens over hun geslacht en demografische informatie?

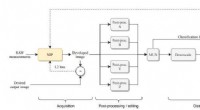

Een nieuw artikel van CSE Ph.D. student Mimansa Jaiswal en prof. Emily Mower Provost stellen een methode voor om deze barrière weg te nemen en veiligere technologieën mogelijk te maken die zijn gebaseerd op machine learning (ML). Door het gebruik van vijandige ML, ze hebben aangetoond dat ze deze gevoelige identifiers kunnen "afleren" van audio voordat het wordt opgeslagen, en gebruik in plaats daarvan uitgeklede representaties van de spreker om modellen voor emotieherkenning te trainen.

Emotie herkenning, sentiment analyse, en andere technieken voor het automatisch identificeren van verschillende complexe kenmerken van spraak worden mogelijk gemaakt door ML-modellen die zijn getraind op enorme hoeveelheden gelabelde gegevens. Om op betrouwbare wijze patronen in de spraak van een gebruiker te herkennen, het model moet aanzienlijke trainingservaring hebben met soortgelijke spraak die het helpt bij het identificeren van bepaalde gemeenschappelijke kenmerken.

Deze systemen die zich bezighouden met het dagelijkse leven van typische smartphonegebruikers, zullen dan moeten worden getraind in een breed scala aan gewone menselijke spraak - in wezen, opnames van gesprekken.

"De hoop van dit artikel is om aan te tonen dat deze machine learning-algoritmen uiteindelijk behoorlijk wat informatie over iemands geslacht of demografische informatie coderen, ", zegt Jaiswal. Deze demografische informatie wordt opgeslagen op bedrijfsservers die een bepaalde mobiele app of stemassistent aansturen, waardoor de gebruiker openstaat voor identificatie door het bedrijf of, slechter, eventuele kwaadwillende afluisteraars.

"De implicaties van het lekken van gevoelige informatie zijn ingrijpend, ", schrijven de auteurs. "Onderzoek heeft aangetoond dat discriminatie plaatsvindt over variabelen van leeftijd, ras, en geslacht bij het aannemen, politie, en kredietwaardigheid."

Deze identificerende audiogegevens, opgeslagen in zijn ruwe vorm, kan zelfs de opt-out-opties negeren die door de gebruiker elders in de app zijn geselecteerd. Om dit aan te pakken, services verplaatst naar het opslaan van representaties die zijn verkregen na voorverwerking in de cloud, informatielekken te voorkomen.

Bij eerdere werkzaamheden aan het coderen van audiogegevens met het oog op privacy werd geprobeerd willekeurige ruis aan de dataset toe te voegen. Hoewel de techniek werkte als de luisteraar niet wist wat voor soort ruis er werd gebruikt, op het moment dat de aanvaller toegang kreeg tot het netwerk, waardoor de anonimiteit ontstond, viel de methode uit elkaar.

In plaats daarvan, Jaiswal en Mower Provost gebruiken vijandige ML-technieken om de codering van demografische en privékenmerken van de onbewerkte audio te verminderen voordat deze ooit is opgeslagen. Wat overblijft is een geabstraheerde datarepresentatie van de originele opname. De auteurs gebruiken deze voorstellingen om de feitelijke inhoud van het gesprek gedeeltelijk te verdoezelen, het elimineren van de risico's voor de privacy die gepaard gaan met grootschalige gegevensopslag.

De uitdaging was, dan, om ervoor te zorgen dat dit nieuwe formaat van privacybeschermde gegevens nog steeds kan worden gebruikt om ML-modellen effectief te trainen in hun hoofdtaak. Wat de onderzoekers ontdekten, was dat naarmate de sterkte van de vijandige component toeneemt, de privacystatistiek neemt meestal toe - en de prestaties op de primaire taak zijn ongewijzigd, of slechts in geringe mate wordt aangetast.

"We vinden dat de prestaties ofwel behouden blijven, of er is een lichte afname van de prestaties voor sommige opstellingen, " schrijven de auteurs. In meerdere gevallen identificeerden ze zelfs een significante prestatieverbetering, wat impliceert dat het blind maken van het model voor gender de robuustheid ervan vergroot door geen associaties tussen gender- en emotielabels te leren.

Jaiswal hoopt deze bevindingen te gebruiken om onderzoek naar machine learning veiliger en veiliger te maken voor gebruikers in de echte wereld.

"ML-modellen zijn meestal black box-modellen, " ze zegt, "wat betekent dat je meestal niet weet wat ze precies coderen, welke informatie ze hebben, of die informatie op een goede of kwaadaardige manier kan worden gebruikt. De volgende stap is om het verschil te begrijpen in de informatie die wordt gecodeerd tussen twee modellen, waarbij het enige verschil is dat er een is getraind om de privacy te beschermen."

"We willen verbeteren hoe mensen deze modellen waarnemen en ermee omgaan."

Dit onderzoek is gepubliceerd in het artikel "Privacy Enhanced Multimodal Neural Representations for Emotion Recognition, " gepubliceerd op de 2020 Association for the Advancement of Artificial Intelligence (AAAI) Conference.

Oude Egyptenaren geloofden dat katten goddelijke energie hadden

Oude Egyptenaren geloofden dat katten goddelijke energie hadden  Nieuw-Zeeland ligt bovenop de overblijfselen van een gigantische oude vulkanische pluim

Nieuw-Zeeland ligt bovenop de overblijfselen van een gigantische oude vulkanische pluim Opinie:het is onzin om te zeggen dat fracking veilig kan worden gemaakt, welke richtlijnen we ook bedenken

Opinie:het is onzin om te zeggen dat fracking veilig kan worden gemaakt, welke richtlijnen we ook bedenken Twee maanden op zee om de bijdrage van de Zuidelijke Oceanen aan klimaatregulering te verkennen

Twee maanden op zee om de bijdrage van de Zuidelijke Oceanen aan klimaatregulering te verkennen Ruimtelijke variatie in carbonaatkoolstofisotopen tijdens Cambrian SPICE-evenement in het oosten van Noord-China

Ruimtelijke variatie in carbonaatkoolstofisotopen tijdens Cambrian SPICE-evenement in het oosten van Noord-China

Hoofdlijnen

- Genen die mensen scheiden van fruitvliegen gevonden

- Wat veroorzaakt het uitsterven van planten en dieren?

- Onderzoek suggereert vrouwelijk voordeel in levensverwachting gerelateerd aan fundamentele biologische wortels

- Onderzoek opent poorten voor betere gerichte medicijnen

- Hoe gelukkig te zijn in een relatie

- Wat is de chemische vergelijking voor aërobe ademhaling?

- Ambien

- Wilde zwijnengif veldtesten in Texas, Alabama in 2018

- UV-licht: positieve en negatieve effecten

- Digitale vervalsingen aanpakken met AI-geleerde artefacten

- Chinas ZTE belooft strijd tegen het verbod op Amerikaanse leveranciers

- Hey Alexa:Amazons virtuele assistent wordt een persoonlijke assistent voor softwareontwikkelaars

- De collaboratieve robots van Amazon bieden een kijkje in de toekomst

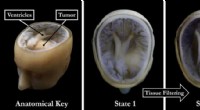

- Nieuwe 3D-printtechniek maakt snellere, beter, en goedkopere modellen van patiëntspecifieke medische gegevens

Beken stoten mogelijk meer koolstofdioxide uit in een warmer klimaat

Beken stoten mogelijk meer koolstofdioxide uit in een warmer klimaat Wat zijn de graden van een vierzijdige?

Wat zijn de graden van een vierzijdige?  Aardgas benutten om water uit de lucht te halen, kan twee grote problemen tegelijk oplossen

Aardgas benutten om water uit de lucht te halen, kan twee grote problemen tegelijk oplossen Nieuwe isolatietechniek maakt de weg vrij voor krachtigere en kleinere spanen

Nieuwe isolatietechniek maakt de weg vrij voor krachtigere en kleinere spanen De tropen breiden zich uit, en klimaatverandering is de belangrijkste boosdoener

De tropen breiden zich uit, en klimaatverandering is de belangrijkste boosdoener Nieuwe hoogwaardige tribo-elektrische materialen vervaardigd uit bijproducten van het aardolieraffinageproces

Nieuwe hoogwaardige tribo-elektrische materialen vervaardigd uit bijproducten van het aardolieraffinageproces Amazon-personeelsbestand stijgt tijdens vakantie

Amazon-personeelsbestand stijgt tijdens vakantie Warmere winters veranderen de samenstelling van het water in de Zwarte Zee

Warmere winters veranderen de samenstelling van het water in de Zwarte Zee

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | French |

-

Wetenschap © https://nl.scienceaq.com