Wetenschap

Team doorbreekt exaop-barrière met deep learning-applicatie

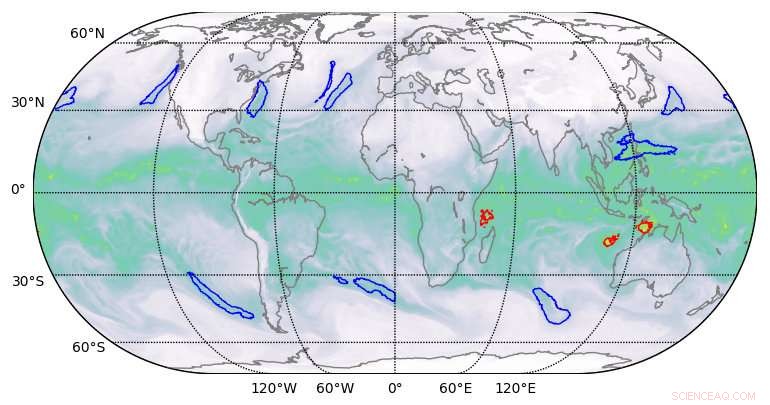

Segmentatieresultaten van hoge kwaliteit geproduceerd door deep learning op klimaatdatasets. Krediet:Berkeley Lab

Een team van computationele wetenschappers van het Lawrence Berkeley National Laboratory (Berkeley Lab) en Oak Ridge National Laboratory (ORNL) en ingenieurs van NVIDIA heeft, Voor de eerste keer, demonstreerde een exascale-klasse deep learning-toepassing die de exaop-barrière heeft doorbroken.

Met behulp van een klimaatdataset van Berkeley Lab op ORNL's Summit-systeem bij de Oak Ridge Leadership Computing Facility (OLCF), ze trainden een diep neuraal netwerk om extreme weerspatronen te identificeren uit klimaatsimulaties met hoge resolutie. Summit is een IBM Power Systems AC922 supercomputer aangedreven door meer dan 9 000 IBM POWER9 CPU's en 27, 000 NVIDIA Tesla V100 Tensor Core GPU's. Door gebruik te maken van de gespecialiseerde NVIDIA Tensor Cores die op grote schaal in de GPU's zijn ingebouwd, de onderzoekers behaalden een piekprestatie van 1,13 exaops en een aanhoudende prestatie van 0,999 - het snelste deep learning-algoritme dat tot nu toe is gerapporteerd en een prestatie die hen een plek opleverde op de lijst van finalisten van dit jaar voor de Gordon Bell Prize.

"Deze samenwerking heeft een aantal unieke prestaties opgeleverd, " zei Prabhat, die het Data &Analytics Services-team leidt bij Berkeley Lab's National Energy Research Scientific Computing Center en co-auteur is van de Gordon Bell-inzending. "Het is het eerste voorbeeld van deep learning-architectuur die segmentatieproblemen in de klimaatwetenschap heeft kunnen oplossen, en op het gebied van diep leren, het is het eerste voorbeeld van een echte toepassing die de exascale-barrière heeft doorbroken."

Deze prestaties werden mogelijk gemaakt door een innovatieve mix van hardware- en softwaremogelijkheden. Aan de hardwarekant, Summit is ontworpen om 200 petaflops zeer nauwkeurige computerprestaties te leveren en is onlangs uitgeroepen tot de snelste computer ter wereld, in staat om meer dan drie exaops (3 miljard miljard berekeningen) per seconde uit te voeren. Het systeem heeft een hybride architectuur; elk van zijn 4, 608 compute nodes bevat twee IBM POWER9 CPU's en zes NVIDIA Volta Tensor Core GPU's, allemaal verbonden via de NVIDIA NVLink high-speed interconnect. De NVIDIA GPU's zijn een sleutelfactor in de prestaties van Summit, waardoor tot 12 keer hogere piek teraflops voor training en 6 keer hogere piek teraflops voor gevolgtrekking in deep learning-toepassingen in vergelijking met zijn voorganger, de Tesla P100.

"Onze samenwerking met Berkeley Lab en Oak Ridge National Laboratory toonde het ware potentieel van NVIDIA Tensor Core GPU's voor AI- en HPC-toepassingen, " zei Michael Houston, senior vooraanstaand ingenieur van deep learning bij NVIDIA. "Om exascale werkelijkheid te maken, ons team maakte gebruik van de multi-precisiemogelijkheden die zijn verpakt in de duizenden NVIDIA Volta Tensor Core GPU's op Summit om topprestaties te bereiken in training en inferentie in deep learning-toepassingen."

Verbeterde schaalbaarheid en communicatie

Aan de softwarekant, naast het verstrekken van de klimaatdataset, het Berkeley Lab-team ontwikkelde patroonherkenningsalgoritmen voor het trainen van het DeepLabv3+ neurale netwerk om classificaties op pixelniveau van extreme weerspatronen te extraheren, die kunnen helpen bij het voorspellen van hoe extreme weersomstandigheden veranderen naarmate het klimaat warmer wordt. Volgens Thorsten Kurth, een applicatieprestatiespecialist bij NERSC die dit project leidde, het team bracht wijzigingen aan in DeepLabv3+ die de schaalbaarheid en communicatiemogelijkheden van het netwerk verbeterden en de exaops-prestatie mogelijk maakten. Dit omvatte het aanpassen van het netwerk om het te trainen om functies op pixelniveau en classificatie per pixel te extraheren en de communicatie van knooppunt naar knooppunt te verbeteren.

"Wat indrukwekkend is aan deze inspanning, is dat we een hoogproductief raamwerk zoals TensorFlow kunnen schalen, die technisch is ontworpen voor snelle prototyping op kleine tot middelgrote schaal, tot 4, 560 knooppunten op Summit, " zei hij. "Met een aantal prestatieverbeteringen, we waren in staat om het framework op bijna de hele supercomputer te laten draaien en prestaties op exaop-niveau te bereiken, wat bij mijn weten het beste is dat tot nu toe is bereikt in een nauw gekoppelde toepassing."

Andere innovaties waren onder meer snelle parallelle datastaging, een geoptimaliseerde pijplijn voor gegevensopname en segmentatie via meerdere kanalen. Traditionele beeldsegmentatietaken werken op driekanaals rood/blauw/groen beelden. Maar wetenschappelijke datasets omvatten vaak veel kanalen; in klimaat, bijvoorbeeld, deze kunnen temperatuur omvatten, windsnelheden, drukwaarden en vochtigheid. Door het geoptimaliseerde neurale netwerk op Summit uit te voeren, de extra rekenmogelijkheden maakten het gebruik van alle 16 beschikbare kanalen mogelijk, waardoor de nauwkeurigheid van de modellen drastisch werd verbeterd.

"We hebben aangetoond dat we diepgaande leermethoden kunnen toepassen voor segmentatie op pixelniveau op klimaatgegevens, en mogelijk op andere wetenschappelijke domeinen, " zei Prabhat. "Meer in het algemeen, ons project heeft de basis gelegd voor exascale deep learning voor de wetenschap, evenals commerciële toepassingen."

Hoofdlijnen

- Gevild karkas van zeeotter gevonden op strand in Californië

- Wel of niet fokken? Trekkende vrouwelijke vlinders staan voor een moessondilemma

- Nieuwe benadering van onderzoek naar vogelnavigatie leidt tot ontwikkeling van besluitvormingsmodel voor dieren

- Welke Organelle vormt de basis voor Cilia en Flagella?

- Hoe wordt ureum gemaakt?

- Studie onthult hoe de adelborst zijn paar uur lang in stand houdt

- Wat zijn lobben in een kern?

- Hoe toont hemoglobine de vier niveaus van eiwitstructuur?

- Voordelen en nadelen van klonen

- Modulaire blokken kunnen laboratoria over de hele wereld in staat stellen om goedkoop en gemakkelijk hun eigen diagnostiek te bouwen

- In competitie, mensen worden ontmoedigd door competente robots

- Onderzoekers bevorderen de productie van zonnemateriaal

- Foto's van succes bij 3D-printen

- Microproductietechnologie belooft een revolutie in bloedonderzoek

Mysterieuze draaiende neutronenster gedetecteerd in de Melkweg blijkt een uiterst zeldzame ontdekking te zijn

Mysterieuze draaiende neutronenster gedetecteerd in de Melkweg blijkt een uiterst zeldzame ontdekking te zijn Houden niet-leuke schimmels kunstmest van planten?

Houden niet-leuke schimmels kunstmest van planten? Samen beter:Mitochondriale fusie ondersteunt celdeling

Samen beter:Mitochondriale fusie ondersteunt celdeling Botsingen na maanvorming hebben de vroege aarde geremodelleerd

Botsingen na maanvorming hebben de vroege aarde geremodelleerd Koolwaterstoffen verteren

Koolwaterstoffen verteren Wiskundige tool helpt eigenschappen van kwantummaterialen sneller te berekenen

Wiskundige tool helpt eigenschappen van kwantummaterialen sneller te berekenen Hoe warmte kan worden gebruikt om duurzame energie op te slaan

Hoe warmte kan worden gebruikt om duurzame energie op te slaan Nieuw bewijs gevonden voor de rituele betekenis van een klassiek Maya-zweetbad in Guatemala

Nieuw bewijs gevonden voor de rituele betekenis van een klassiek Maya-zweetbad in Guatemala

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | Italian |

-

Wetenschap © https://nl.scienceaq.com