Wetenschap

Verdediging tegen vijandige aanvallen met behulp van machine learning en cryptografie

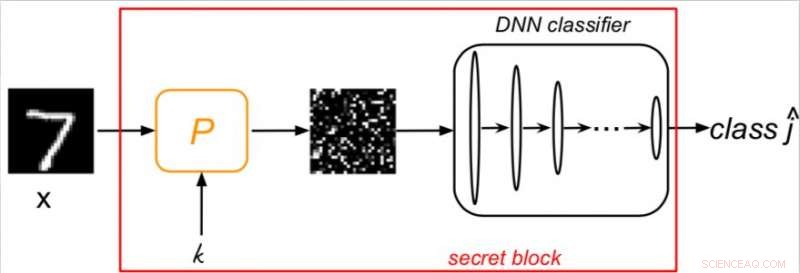

Schema conceptualisering van de nieuwe aanpak. Krediet:Taran, Rezaefar, &Voloshynovskiy

Onderzoekers van de Universiteit van Genève hebben onlangs een nieuw verdedigingsmechanisme ontwikkeld dat werkt door machine learning te overbruggen met cryptografie. Het nieuwe systeem, geschetst in een paper dat vooraf is gepubliceerd op arXiv, is gebaseerd op het tweede cryptografische principe van Kerckhoffs, waarin staat dat zowel verdedigings- als classificatie-algoritmen bekend zijn, maar de sleutel niet.

In de afgelopen decennia, machine learning-algoritmen, met name diepe neurale netwerken (DNN's), opmerkelijke resultaten hebben bereikt bij het uitvoeren van een breed scala aan taken. Niettemin, deze algoritmen worden blootgesteld aan aanzienlijke veiligheidsrisico's, vooral vijandige aanvallen, de implementatie ervan op vertrouwensgevoelige taken te beperken.

"Ondanks de opmerkelijke vooruitgang die is geboekt door diepe netwerken, ze staan bekend als kwetsbaar voor vijandige aanvallen, "Olga Taran, een van de onderzoekers die het onderzoek heeft uitgevoerd, vertelde TechXplore . "Adversariële aanvallen zijn gericht op het ontwerpen van zo'n verstoring van originele samples die, in het algemeen, voor mensen niet waarneembaar, maar het is in staat om de DNN-output te misleiden."

De meeste bestaande verdedigingsmaatregelen kunnen gemakkelijk worden omzeild door de steeds geavanceerdere aanvalsstrategieën. Dit komt vooral omdat deze verdedigingsmethoden meestal gebaseerd zijn op machine learning en verwerkingsprincipes, zonder cryptografische component, dus ze zijn ontworpen om vijandige verstoringen te detecteren en af te wijzen of uit te filteren. Aangezien de meeste aanvalsalgoritmen gemakkelijk kunnen worden aangepast om de beveiligingsmaatregelen van de aangevallen DNN te misleiden, momenteel, er is geen verdedigingsmechanisme dat consequent goed omgaat met vijandige aanvallen.

"Het fundamentele probleem met de voorgestelde tegenmaatregelen is de veronderstelling dat de verdediger en aanvaller dezelfde hoeveelheid informatie hebben of zelfs dezelfde of vergelijkbare trainingsdatasets delen, "Slava Voloshynovskiy, vertelde een van de onderzoekers die het onderzoek uitvoerden aan TechXplore. "In zo'n scenario de verdediger heeft geen informatievoordeel ten opzichte van de aanvaller. Dit verschilt wezenlijk van de klassieke beveiligingsbenaderingen die in de cryptografische gemeenschap zijn ontwikkeld."

Voloshynovskiy en zijn collega's besloten daarom een nieuwe benadering te bedenken die machine learning en cryptografie overbrugt, in de hoop dat het effectiever zou zijn in het verdedigen van DNN-algoritmen tegen vijandige aanvallen. De techniek die ze bedachten is gebaseerd op het cryptografische principe van Kerckhoffs, waarin staat dat de sleutel om toegang te krijgen tot een systeem verondersteld wordt onbekend te blijven.

"We hebben een randomisatiemechanisme geïntroduceerd in de classificatiestructuur die wordt geparametriseerd door een geheime sleutel, ' zei Taran. 'Natuurlijk, een dergelijke sleutel is niet beschikbaar voor de aanvaller. Hierdoor ontstaat een informatievoordeel van de verdediger ten opzichte van de aanvaller. Bovendien, deze sleutel kan niet worden geleerd uit de trainingsdataset. Het randomisatiemechanisme is een voorverwerkingsblok dat op verschillende manieren kan worden geïmplementeerd, waaronder willekeurige permutatie, bemonstering en inbedding."

De onderzoekers evalueerden hun systeem en het vermogen om te reageren op twee van de meest bekende state-of-the-art aanvallen, de snelle gradiënttekenmethode (FGSM) en de aanvallen voorgesteld door N. Carlini en D. Wagner (CW), in black box en grey box scenario's. Hun resultaten waren veelbelovend, met hun afweermechanisme dat beide effectief tegengaat.

"Als het goed is opgelost, het gebruik van DNN kan meer vertrouwen krijgen in echte applicaties. Wij zijn van mening dat ons werk slechts een eerste stap is in de richting van de oplossing van dit probleem, "Zei Voloshynovskiy. "We zouden ook graag meer specialisten uit het domein van cryptografie aantrekken om in dialoog te gaan met de machine learning-gemeenschap."

Het door de onderzoekers ontwikkelde afweermechanisme zou kunnen worden toegepast op verschillende bestaande DNN-classificaties. Toekomstige tests op complexere datasets of het gebruik van een breder scala aan geavanceerde vijandige aanvallen zullen helpen om de effectiviteit ervan verder te bepalen.

"We zijn nu van plan ons werk uit te breiden naar meer algemene randomisatieprincipes en het te testen op de echte grote afbeeldingen, ' zei Voloshynovskiy.

© 2018 Tech Xplore

De leiding nemen om de juiste balans te vinden voor geavanceerde opto-elektronische apparaten

De leiding nemen om de juiste balans te vinden voor geavanceerde opto-elektronische apparaten Welke twee ingrediënten zijn nodig voor de gisting?

Welke twee ingrediënten zijn nodig voor de gisting?  Vergroening van biomaterialen en steigers die worden gebruikt in regeneratieve geneeskunde

Vergroening van biomaterialen en steigers die worden gebruikt in regeneratieve geneeskunde Door kwallen geïnspireerde elektronische huid gloeit als hij pijn doet

Door kwallen geïnspireerde elektronische huid gloeit als hij pijn doet Nieuwe aanpak kan leiden tot ontworpen kunststoffen met specifieke eigenschappen

Nieuwe aanpak kan leiden tot ontworpen kunststoffen met specifieke eigenschappen

10 jaar sinds de aardbeving in Darfield Nieuw-Zeeland deed schudden:wat hebben we geleerd?

10 jaar sinds de aardbeving in Darfield Nieuw-Zeeland deed schudden:wat hebben we geleerd? Welke platen zijn gebruikt om de Paricutin-vulkaan te vormen?

Welke platen zijn gebruikt om de Paricutin-vulkaan te vormen?  Wat zijn de voordelen en nadelen van economische omgevingsfactoren?

Wat zijn de voordelen en nadelen van economische omgevingsfactoren?  NASA ziet krachtige stormen met oprukkende moesson in Golf van Bengalen

NASA ziet krachtige stormen met oprukkende moesson in Golf van Bengalen Welke schade veroorzaakt Tsunamis?

Welke schade veroorzaakt Tsunamis?

Hoofdlijnen

- De voor- en nadelen van mutatie

- Ecologie: definitie, soorten, belang en voorbeelden

- Wat gebeurt er in de interfase van de celcyclus?

- Voorbeelden van sensorische aanpassing

- Japanse wetenschappers kweken medicijnen in kippeneieren

- Vroegtijdige waarschuwing gezondheids- en welzijnssysteem kan boeren miljoenen ponden besparen

- Veiligheid, geen voedsel, lokt ganzen naar steden

- Milieubeheer van inheemse naties bij het aanpakken van invasieve soorten

- Voetafdrukken gebruiken om reuzenpanda's in het wild te identificeren en te volgen

- Google bekentenis:Ja, we volgen uw locatie, zelfs als je Locatiegeschiedenis uitschakelt

- Patent talk:IBM's verkeerssignaaltiming wordt cognitief

- Huawei-eenheid schrapt meer dan 600 banen na Amerikaanse sancties

- Rechtszaak hernieuwt focus op privacybeleid voor mobiele apps

- Instagram breidt factchecking wereldwijd uit

Kabul verslikt zich in vuile lucht terwijl de temperatuur daalt

Kabul verslikt zich in vuile lucht terwijl de temperatuur daalt Een behendige supermacht:verschillende rollen van China in Afrika en het Noordpoolgebied

Een behendige supermacht:verschillende rollen van China in Afrika en het Noordpoolgebied Een eed van Hippocrates voor datawetenschap? Wel genoegen nemen met wat meer datageletterdheid

Een eed van Hippocrates voor datawetenschap? Wel genoegen nemen met wat meer datageletterdheid De mechanische eigenschappen van grafeen lijken overeenkomsten te hebben met grafiet

De mechanische eigenschappen van grafeen lijken overeenkomsten te hebben met grafiet Vertraagd internetproject in Kentucky wordt geconfronteerd met nieuwe tegenslag voor eekhoorns

Vertraagd internetproject in Kentucky wordt geconfronteerd met nieuwe tegenslag voor eekhoorns Eens waren voorbij het stadium van angst, waar leggen we de schuld voor de COVID-19 pandemie?

Eens waren voorbij het stadium van angst, waar leggen we de schuld voor de COVID-19 pandemie? Kan een computer op een dag zichzelf opnieuw bedraden? Nieuw nanomateriaal 'stuurt' stroom in meerdere dimensies

Kan een computer op een dag zichzelf opnieuw bedraden? Nieuw nanomateriaal 'stuurt' stroom in meerdere dimensies Hoe de afmetingen van een vierkant te vinden met het gebied

Hoe de afmetingen van een vierkant te vinden met het gebied

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | German | Dutch | Danish | Norway | Swedish |

-

Wetenschap © https://nl.scienceaq.com