Wetenschap

Deep learning strekt zich uit tot wetenschappelijke supercomputers

Onderzoekers leverden 15 petaflop deep-learning software en lieten deze draaien op Cori, een supercomputer bij het National Energy Research Scientific Computing Center, een Department of Energy Office of Science gebruikersfaciliteit. Krediet:Lawrence Berkeley National Laboratory

machinaal leren, een vorm van kunstmatige intelligentie, geniet ongekend succes in commerciële toepassingen. Echter, het gebruik van machine learning in high-performance computing voor de wetenschap is beperkt. Waarom? Geavanceerde tools voor machine learning zijn niet ontworpen voor grote datasets, zoals die werden gebruikt om sterren en planeten te bestuderen. Een team van Intel, Nationaal Energieonderzoek Wetenschappelijk Rekencentrum (NERSC), en Stanford veranderde die situatie. Ze ontwikkelden de eerste 15 petaflop deep-learning software. Ze demonstreerden het vermogen om grote datasets te verwerken via testruns op de Cori-supercomputer.

Met behulp van machine learning-technieken op supercomputers, wetenschappers konden inzichten halen uit grote, complexe datasets. Krachtige instrumenten, zoals versnellers, enorme datasets produceren. De nieuwe software zou 's werelds grootste supercomputers in staat kunnen stellen om dergelijke gegevens in te passen in deep learning-toepassingen. De resulterende inzichten kunnen de modellering van aardsystemen ten goede komen, fusie-energie, en astrofysica.

Machine learning-technieken bieden mogelijkheden om wetenschappers in staat te stellen waardevolle inzichten te extraheren uit grote, complexe datasets die worden geproduceerd door versnellers, lichtbronnen, telescopen, en computersimulaties. Hoewel deze technieken veel succes hebben gehad in een verscheidenheid aan commerciële toepassingen, het gebruik ervan in high-performance computing voor de wetenschap is beperkt omdat bestaande tools niet zijn ontworpen om te werken met de terabyte tot petabyte datasets die in veel wetenschappelijke domeinen worden aangetroffen.

Om dit probleem aan te pakken is een samenwerking tussen Intel, het National Energy Research Scientific Computing Center, en Stanford University heeft gewerkt aan het oplossen van problemen die zich voordoen bij het gebruik van deep learning-technieken, een vorm van machine learning, op terabyte en petabyte datasets. Het team ontwikkelde de eerste deep-learningsoftware van 15 petaflops. Ze demonstreerden de schaalbaarheid voor data-intensieve toepassingen door een aantal trainingsruns uit te voeren met behulp van grote wetenschappelijke datasets. De runs gebruikten op fysica en klimaat gebaseerde datasets op Cori, een supercomputer in het National Energy Research Scientific Computing Center. Ze behaalden een pieksnelheid tussen 11,73 en 15,07 petaflops (enkele precisie) en een gemiddelde aanhoudende prestatie van 11,41 tot 13,47 petaflops. (Een petaflop is een miljoen miljard berekeningen per seconde.)

Bij veldproeven, apparaat haalt water uit woestijnlucht

Bij veldproeven, apparaat haalt water uit woestijnlucht Is het vermogen om metalen op te lossen een fysische of chemische eigenschap?

Is het vermogen om metalen op te lossen een fysische of chemische eigenschap?  Onderzoek wijst het proces aan dat mogelijk tot de eerste organische moleculen heeft geleid

Onderzoek wijst het proces aan dat mogelijk tot de eerste organische moleculen heeft geleid Wetenschappers onthullen verborgen katalytisch oppervlak van Ni-Au-kernschil in kooldioxidehydrogenering

Wetenschappers onthullen verborgen katalytisch oppervlak van Ni-Au-kernschil in kooldioxidehydrogenering Wetenschappers duwen microscopie naar submoleculaire resolutie

Wetenschappers duwen microscopie naar submoleculaire resolutie

Hoofdlijnen

- Hoe maak je een 3D-tandmodel voor een schoolproject

- Genoomgrootte beïnvloedt of planten invasief worden

- Biologen ontdekken tastzin van bacteriën

- Hoe empathie werkt

- Maki's zijn raar omdat het fruit van Madagascar raar is

- Wat zijn de vier stikstofhoudende bases van DNA?

- Herziening van historische voorraadroutes kan zeldzame stukken inheemse planten en dieren in gevaar brengen

- Urban Coopers-haviken overtreffen hun landelijke buren

- Honden zijn expressiever als iemand kijkt

- Headsetkijkers kunnen filmveranderingen verwachten op basis van hoe ze zich voelen

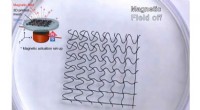

- Onderzoekers maken 3D-geprinte robots van zacht gaas

- Twitter brengt verkiezingslabels terug voor Amerikaanse kandidaten voor 2020

- Power to the people:elektriciteit bereikt eindelijk Indiase mijlpaal

- Staten klagen aan om Sprint-T-Mobile-deal van $ 26,5 miljard te stoppen

Ultralichte wetenschap-grenslaagmetingen van laagvliegende bron

Ultralichte wetenschap-grenslaagmetingen van laagvliegende bron Sneller en koeler is het beste voor kleding

Sneller en koeler is het beste voor kleding Nieuwe videogame schakelt spelers in om wetenschappelijk onderzoek vooruit te helpen

Nieuwe videogame schakelt spelers in om wetenschappelijk onderzoek vooruit te helpen Robot helpt ernstig zieke Everton-fan geschiedenis te schrijven

Robot helpt ernstig zieke Everton-fan geschiedenis te schrijven Waarom experimenteren we met muizen?

Waarom experimenteren we met muizen?  China overweegt nieuwe acties om het markeren van geboortecijfers op te heffen

China overweegt nieuwe acties om het markeren van geboortecijfers op te heffen Ik maak een herbruikbare raketreis voor $ 43 miljoen,

Ik maak een herbruikbare raketreis voor $ 43 miljoen,  Onderzoekers brengen de bling om implantaten te verbeteren

Onderzoekers brengen de bling om implantaten te verbeteren

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com