Wetenschap

Techleiders ondertekenen wereldwijde belofte tegen autonome wapens

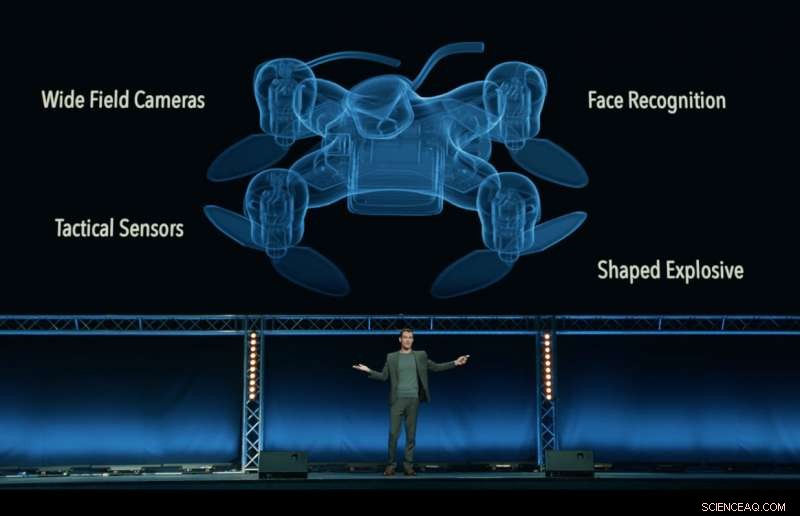

Still uit de 'Slaughterbots'-video, geproduceerd door het Future of Life Institute, die een fictieve dystopische toekomst toont van moordende drones die over de wereld zwermen. Krediet:Future of Life Institute

Een wie is wie van CEO's, ingenieurs en wetenschappers uit de technologische industrie, waaronder Google DeepMind, de XPRIZE Foundation en Elon Musk - hebben een belofte ondertekend om "noch deel te nemen aan, noch de ontwikkeling te ondersteunen, vervaardiging, handel, of gebruik van dodelijke autonome wapens".

Uitgebracht in Stockholm op de 2018 International Joint Conference on Artificial Intelligence (IJCAI), 's werelds toonaangevende AI-onderzoeksbijeenkomst met meer dan 5, 000 deelnemers, de belofte werd ondertekend door 150 bedrijven en meer dan 2, 400 personen uit 90 landen die werken in kunstmatige intelligentie (AI) en robotica.

Ondertekenaars van bedrijven zijn onder meer Google DeepMind, Universiteits Hogeschool Londen, Stichting XPRIZE, ClearPath-robotica/OTTO-motoren, de Europese Vereniging voor AI, en de Zweedse AI Society. Individuen zijn onder meer hoofd onderzoek bij Google.ai Jeff Dean, AI-pioniers Stuart Russell, Yoshua Bengio, Anca Dragan en Toby Walsh, en het Britse Labour-parlementslid Alex Sobel.

de belofte, georganiseerd door het Future of Life Institute, daagt regeringen uit, academische wereld en industrie om hun voorbeeld te volgen, zeggen:"Wij, de ondergetekende, een beroep doen op regeringen en regeringsleiders om een toekomst te creëren met sterke internationale normen, regels en wetten tegen dodelijke autonome wapens. ... We vragen dat technologiebedrijven en organisaties, evenals leiders, beleidsmakers, en andere individuen, sluit u bij ons aan bij deze belofte."

Max Tegmark, hoogleraar natuurkunde aan het Massachusetts Institute of Technology en voorzitter van het Future of Life Institute, kondigde de toezegging aan.

"Ik ben verheugd om te zien dat AI-leiders overschakelen van praten naar actie, het implementeren van een beleid dat politici tot nu toe niet hebben uitgevoerd, Tegmark zei. "AI heeft een enorm potentieel om de wereld te helpen - als we het misbruik ervan stigmatiseren en voorkomen. AI-wapens die autonoom besluiten mensen te doden, zijn net zo walgelijk en destabiliserend als biowapens, en moet op dezelfde manier worden behandeld."

Dodelijke autonome wapensystemen (LAWS) - ook wel 'killer robots' genoemd - zijn wapens die kunnen identificeren, doelwit, en een persoon doden, zonder een menselijke 'in-the-loop'. Dat is, niemand neemt de uiteindelijke beslissing om dodelijk geweld toe te staan:de beslissing en autorisatie over het al dan niet overlijden van iemand wordt overgelaten aan het autonome wapensysteem. Dit omvat niet de drones van vandaag, die onder menselijke controle staan; noch autonome systemen die zich alleen tegen andere wapens verdedigen.

De belofte begint met de verklaring:"Kunstmatige intelligentie staat op het punt een steeds grotere rol te spelen in militaire systemen. Er is een dringende kans en noodzaak voor burgers, beleidsmakers, en leiders om onderscheid te maken tussen acceptabel en onaanvaardbaar gebruik van AI."

Een andere belangrijke organisator van de belofte, Toby Walsh, een professor in kunstmatige intelligentie aan de Australische Universiteit van New South Wales in Sydney, wijst op de netelige ethische kwesties rond WETTEN:"We kunnen de beslissing over wie leeft en wie sterft niet overlaten aan machines. Ze hebben niet de ethiek om dit te doen. Ik moedig u en uw organisaties aan om te beloven ervoor te zorgen dat oorlog niet op deze manier nog verschrikkelijker worden."

Ryan Gariepy, Oprichter en CTO van zowel Clearpath Robotics als OTTO Motors, een sterke tegenstander van dodelijke autonome wapens, herhaalde de oproep:"Clearpath blijft geloven dat de verspreiding van dodelijke autonome wapensystemen een duidelijk en aanwezig gevaar blijft voor de burgers van elk land ter wereld. Geen enkel land zal veilig zijn, hoe krachtig ook.

"De zorgen van Clearpath worden gedeeld door een groot aantal andere belangrijke bedrijven en ontwikkelaars van autonome systemen, en we hopen dat regeringen over de hele wereld besluiten hun tijd en moeite te investeren in autonome systemen die hun bevolking gezonder maken, veiliger, en productiever in plaats van systemen waarvan het enige gebruik het gebruik van dodelijk geweld is, " hij voegde toe.

Toby Walsh, hoogleraar kunstmatige intelligentie aan de Australische Universiteit van New South Wales in Sydney, met een Baxter-robot. Krediet:Grant Turner/UNSW

Naast de verontrustende ethische vragen rond dodelijke autonome wapens, veel voorstanders van een internationaal verbod op WETTEN zijn bezorgd dat ze moeilijk te controleren zullen zijn - gemakkelijker te hacken, meer kans om op de zwarte markt te belanden, en gemakkelijker te verkrijgen voor terroristen en despoten - wat voor alle landen destabiliserend zou kunnen worden. Een dergelijk scenario speelt zich af in de door FLI uitgebrachte video Slaughterbots.

In december 2016, de toetsingsconferentie van de Verenigde Naties van het Verdrag inzake conventionele wapens (CCW) begon de formele discussie over WETTEN. 26 landen die de conferentie bijwoonden, hebben tot dusver hun steun aangekondigd voor een soort verbod, inclusief China.

Een dergelijk verbod is niet zonder precedent:ook biologische wapens en chemische wapens werden verboden, niet alleen om ethische en humanitaire redenen, maar ook voor de destabiliserende dreiging die ze vormden.

De volgende VN-vergadering over WET zal plaatsvinden in augustus 2018, en ondertekenaars van de belofte hopen dat hun belofte wetgevers zal aanmoedigen om zich te committeren aan een internationale overeenkomst tussen landen.

Zoals de belofte zegt:"Wij, de ondergetekende, een beroep doen op regeringen en regeringsleiders om een toekomst te creëren met sterke internationale normen, regels en wetten tegen dodelijke autonome wapens. ... We vragen dat technologiebedrijven en organisaties, evenals leiders, beleidsmakers, en andere individuen, sluit u bij ons aan bij deze belofte."

De volledige tekst van de belofte

Kunstmatige intelligentie (AI) staat op het punt een steeds grotere rol te spelen in militaire systemen. Er is een dringende kans en noodzaak voor burgers, beleidsmakers, en leiders om onderscheid te maken tussen aanvaardbaar en onaanvaardbaar gebruik van AI.

In dit licht, wij ondergetekenden zijn het erover eens dat de beslissing om een mensenleven te nemen nooit mag worden gedelegeerd aan een machine. Deze positie heeft een morele component, dat we machines niet mogen toestaan beslissingen te nemen waar anderen – of niemand – verantwoordelijk voor zijn.

Er is ook een krachtig pragmatisch argument:dodelijke autonome wapens, het selecteren en aangrijpen van doelen zonder menselijke tussenkomst, zou gevaarlijk destabiliserend zijn voor elk land en individu. Duizenden AI-onderzoekers zijn het erover eens dat door het risico weg te nemen, toerekenbaarheid, en moeilijkheid om mensenlevens te nemen, dodelijke autonome wapens kunnen krachtige instrumenten van geweld en onderdrukking worden, vooral wanneer gekoppeld aan bewakings- en gegevenssystemen.

Bovendien, dodelijke autonome wapens hebben kenmerken die heel anders zijn dan nucleaire, chemische en biologische wapens, en de unilaterale acties van een enkele groep zouden te gemakkelijk een wapenwedloop kunnen ontketenen die de internationale gemeenschap niet over de technische instrumenten en mondiale bestuurssystemen beschikt om te beheren. Het stigmatiseren en voorkomen van een dergelijke wapenwedloop zou een hoge prioriteit moeten hebben voor de nationale en mondiale veiligheid.

We, de ondergetekende, een beroep doen op regeringen en regeringsleiders om een toekomst te creëren met sterke internationale normen, regels en wetten tegen dodelijke autonome wapens. Deze zijn momenteel afwezig, we kiezen ervoor om onszelf aan een hoge standaard te houden:we zullen niet deelnemen aan of ondersteunen van de ontwikkeling, vervaardiging, handel, of het gebruik van dodelijke autonome wapens. We vragen dat technologiebedrijven en organisaties, evenals leiders, beleidsmakers, en andere individuen, sluit je bij ons aan bij deze belofte.

Mijnafval kan worden gebruikt als ingrediënt voor goedkopere productie van waterstofbrandstof

Mijnafval kan worden gebruikt als ingrediënt voor goedkopere productie van waterstofbrandstof Nieuwe nanosheetcoating kan niet-recyclebare gemetalliseerde films in voedselverpakkingen vervangen

Nieuwe nanosheetcoating kan niet-recyclebare gemetalliseerde films in voedselverpakkingen vervangen Nieuwe hybride 3D-printtechniek voegt een vierde dimensie toe aan additive manufacturing

Nieuwe hybride 3D-printtechniek voegt een vierde dimensie toe aan additive manufacturing Hoe het toevoegen van groene thee-extract aan kant-en-klaar voedsel het risico op norovirus kan verminderen?

Hoe het toevoegen van groene thee-extract aan kant-en-klaar voedsel het risico op norovirus kan verminderen? Het bespioneren van eetgewoonten van cellen kan de diagnose van kanker helpen

Het bespioneren van eetgewoonten van cellen kan de diagnose van kanker helpen

Australië slaagt er niet in om Great Barrier Reef te beschermen:activisten

Australië slaagt er niet in om Great Barrier Reef te beschermen:activisten Brandverbod in Brazilië wordt van kracht terwijl Amazon-branden woeden

Brandverbod in Brazilië wordt van kracht terwijl Amazon-branden woeden Wat is stedelijke aantasting?

Wat is stedelijke aantasting?  Record-setting orkaan Dorian blijft het noorden van Bahama's beuken

Record-setting orkaan Dorian blijft het noorden van Bahama's beuken Cryptische koraalrifwezens vertonen diversiteitspatronen op de plank

Cryptische koraalrifwezens vertonen diversiteitspatronen op de plank

Hoofdlijnen

- Ecologische successie: definitie, types, stadia en voorbeelden

- Onderzoek levert test op om bittere pitstoornis in Honeycrisp-appels te voorspellen

- Massive Angel Oak is getuige geweest van 500 jaar geschiedenis van South Carolina

- Passagiersduivengenoom toont effecten van natuurlijke selectie in een enorme populatie

- Een plantenceldiagram maken

- Bron van Beperking Enzymes

- Wat is de levensduur van huidcellen?

- Hoe isoleer ik bacteriën uit de bodem?

- Oplossen van hoe een complexe ziekte eiken bedreigt

- De tekens herkennen

- Hitachi gaat ABB's elektriciteitsnet kopen voor $ 7 miljard:rapport

- Franse regering sluit verkoop Air France-KLM-belang uit

- Om ons kwetsbare weg- en spoorsysteem te versterken, moeten we een micromobiliteitsnetwerk toevoegen

- Nieuwe normen ontwikkeld om het testen van metaaldetectoren te verbeteren

Hoe planten met sporen zich voortplanten

Hoe planten met sporen zich voortplanten  Het maandag-effect is echt - en heeft invloed op je Amazon-pakketbezorging

Het maandag-effect is echt - en heeft invloed op je Amazon-pakketbezorging De topologie van ongeordende 3D-grafenen:Rosalind Franklins pre-DNA-probleem ontward

De topologie van ongeordende 3D-grafenen:Rosalind Franklins pre-DNA-probleem ontward Eerste detectie van materie die met 30 procent van de lichtsnelheid in een zwart gat valt

Eerste detectie van materie die met 30 procent van de lichtsnelheid in een zwart gat valt Astronomen definiëren de echt bewoonbare zone:planeten die gin-tonic kunnen produceren

Astronomen definiëren de echt bewoonbare zone:planeten die gin-tonic kunnen produceren Weibo ziet uitbreiding naar Chineessprekende wereld

Weibo ziet uitbreiding naar Chineessprekende wereld AQM+:een nieuw model voor het genereren van visuele dialoogvragen

AQM+:een nieuw model voor het genereren van visuele dialoogvragen Datawetenschapstechniek helpt atomaire posities nauwkeuriger te meten

Datawetenschapstechniek helpt atomaire posities nauwkeuriger te meten

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com