Wetenschap

Onderzoekers vinden algoritme voor grootschalige hersensimulaties

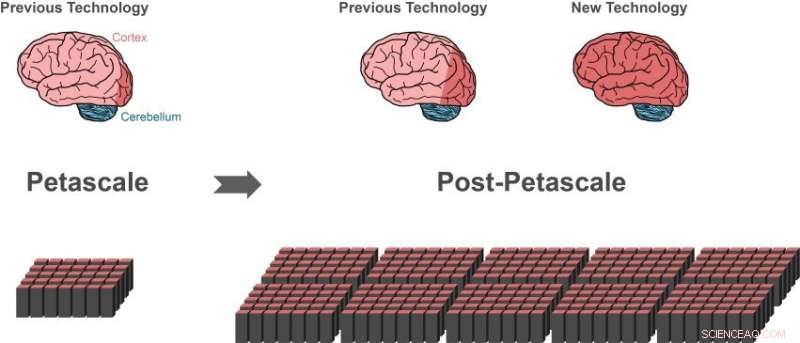

Eerdere simulatietechnologie kan ongeveer 1 procent van de zenuwcellen (neuronen) in een menselijk brein vertegenwoordigen (donkerrood hersengebied links) met behulp van een petascale-supercomputer (linksonder). Slechts een kleine vooruitgang (donkerrood gebied van het middelste brein) zou mogelijk zijn op de volgende generatie supercomputers die de prestaties van de hedendaagse high-end supercomputers 10 tot 100 keer zullen overtreffen. Met de nieuwe technologie kunnen grotere delen van het menselijk brein worden weergegeven, dezelfde hoeveelheid computergeheugen gebruiken (rechtsonder).i 10 procent van de hersenen is ongeveer zo groot als de hele cortex (donkerrood hersengebied rechts), wat essentieel is voor een hogere verwerking. Een groot deel van de overige neuronen bevindt zich in het cerebellum (blauw). Krediet:Forschungszentrum Jülich

Een internationale groep onderzoekers heeft een beslissende stap gezet in de richting van het creëren van de technologie om simulaties van hersenschaalnetwerken op toekomstige supercomputers van de exaschaalklasse te realiseren. De doorbraak, gepubliceerd in Grenzen in neuro-informatica , kunnen grotere delen van het menselijk brein worden weergegeven, dezelfde hoeveelheid computergeheugen gebruiken. Tegelijkertijd, het nieuwe algoritme versnelt de hersensimulaties op bestaande supercomputers aanzienlijk.

Het menselijk brein is een orgaan van ongelooflijke complexiteit, samengesteld uit 100 miljard onderling verbonden zenuwcellen. Echter, zelfs met behulp van de krachtigste supercomputers die er zijn, het is momenteel onmogelijk om de uitwisseling van neuronale signalen in netwerken van deze omvang te simuleren.

"Sinds 2014 onze software kan ongeveer één procent van de neuronen in het menselijk brein met al hun verbindingen simuleren, " zegt Markus Diesmann, Directeur van het Jülich Instituut voor Neurowetenschappen en Geneeskunde (INM-6). Om deze indrukwekkende prestatie te bereiken, de software vereist het volledige hoofdgeheugen van petascale-supercomputers, zoals de K-computer in Kobe en JUQUEEN in Jülich.

Diesmann werkt al meer dan 20 jaar aan de simulatiesoftware NEST, een gratis, open-source simulatiecode die wijdverbreid wordt gebruikt door de neurowetenschappelijke gemeenschap en een kernsimulator van het European Human Brain Project, waarin hij projecten leidt op het gebied van Theoretical Neuroscience en op het High-Performance Analytics and Computing Platform.

Met NES, het gedrag van elk neuron in het netwerk wordt weergegeven door een handvol wiskundige vergelijkingen. Toekomstige exaschaalcomputers, zoals de post-K-computer gepland in Kobe en JUWELS in Jülich, zal de prestaties van de hedendaagse high-end supercomputers 10 tot 100 keer overtreffen. Voor de eerste keer, onderzoekers zullen de computerkracht ter beschikking hebben om neuronale netwerken op de schaal van het menselijk brein te simuleren.

Schijnbaar een doodlopende weg

Terwijl de huidige simulatietechnologie onderzoekers in staat stelde te beginnen met het bestuderen van grote neuronale netwerken, het betekende ook een doodlopende weg op weg naar exascale technologie. Supercomputers bestaan uit ongeveer 100, 000 kleine computers, knooppunten genoemd, elk uitgerust met een aantal processors die de eigenlijke berekeningen uitvoeren.

"Voordat een neuronale netwerksimulatie kan plaatsvinden, neuronen en hun verbindingen moeten virtueel worden gecreëerd, wat betekent dat ze moeten worden geïnstantieerd in het geheugen van de knooppunten. Tijdens de simulatie weet een neuron niet op welke van de knooppunten het doelneuronen heeft, daarom, zijn korte elektrische pulsen moeten naar alle knooppunten worden gestuurd. Elk knooppunt controleert vervolgens welke van al deze elektrische pulsen relevant zijn voor de virtuele neuronen die op dit knooppunt bestaan, " legt Susanne Kunkel van KTH Royal Institute of Technology in Stockholm uit.

Het huidige algoritme voor het maken van netwerken is efficiënt omdat alle knooppunten tegelijkertijd hun specifieke deel van het netwerk bouwen. Het verzenden van alle elektrische pulsen naar alle knooppunten is echter niet geschikt voor simulaties op exaschaalsystemen.

"Om de relevantie van elke elektrische puls efficiënt te controleren, is één bit informatie per processor nodig voor elk neuron in het hele netwerk. Voor een netwerk van 1 miljard neuronen, een groot deel van het geheugen in elk knooppunt wordt verbruikt door slechts dit ene stukje informatie per neuron, ", vult Markus Diesmann aan.

Dit is het grootste probleem bij het simuleren van nog grotere netwerken:de hoeveelheid computergeheugen die per processor nodig is voor de extra Bits per neuron neemt toe met de omvang van het neuronale netwerk. Op de schaal van het menselijk brein, hiervoor zou het beschikbare geheugen voor elke processor 100 keer groter moeten zijn dan in de huidige supercomputers. Dit, echter, waarschijnlijk niet het geval zal zijn in de volgende generatie supercomputers. Het aantal processors per compute node zal toenemen, maar het geheugen per processor en het aantal compute nodes zullen eerder gelijk blijven.

Doorbraak door nieuw algoritme

De doorbraak gepubliceerd in Grenzen in neuro-informatica is een nieuwe manier om het neuronale netwerk in de supercomputer te bouwen. Dankzij de algoritmen het benodigde geheugen op elk knooppunt neemt niet langer toe met de netwerkgrootte. Aan het begin van de simulatie, de nieuwe technologie stelt de knooppunten in staat om informatie uit te wisselen over wie neuronale activiteitsgegevens naar wie moet sturen. Zodra deze kennis beschikbaar is, de uitwisseling van neuronale activiteitsgegevens tussen knooppunten kan zo worden georganiseerd dat een knooppunt alleen de informatie ontvangt die het nodig heeft. Een extra Bit voor elk neuron in het netwerk is niet langer nodig.

Een gunstige bijwerking

Tijdens het testen van hun nieuwe ideeën, de wetenschappers maakten een extra belangrijk inzicht, meldt Susanne Kunkel:"Bij het analyseren van de nieuwe algoritmen realiseerden we ons dat onze nieuwe technologie niet alleen simulaties op exaschaalsystemen mogelijk zou maken, maar het zou ook simulaties sneller maken op de momenteel beschikbare supercomputers."

In feite, aangezien het geheugengebruik nu onder controle is, de snelheid van simulaties wordt de belangrijkste focus van verdere technologische ontwikkelingen. Bijvoorbeeld, een grote simulatie van 0,52 miljard neuronen verbonden door 5,8 biljoen synapsen die op de supercomputer JUQUEEN in Jülich draaide, had voorheen 28,5 minuten nodig om één seconde biologische tijd te berekenen. Met de verbeterde simulatie van datastructuren, de tijd wordt teruggebracht tot 5,2 minuten.

"Met de nieuwe technologie kunnen we het toegenomen parallellisme van moderne microprocessors veel beter benutten dan voorheen, wat nog belangrijker zal worden in exascale computers, " merkt Jakob Jordan op, hoofdauteur van de studie, van Forschungszentrum Jülich.

"De combinatie van exascale-hardware en geschikte software brengt onderzoek naar fundamentele aspecten van de hersenfunctie, zoals plasticiteit en leren dat zich ontvouwt in minuten biologische tijd die binnen ons bereik ligt, ", vult Markus Diesmann aan.

Met een van de volgende releases van de simulatiesoftware NEST, de onderzoekers zullen hun prestatie vrij beschikbaar stellen aan de gemeenschap als open source.

"We hebben NEST gebruikt voor het simuleren van de complexe dynamiek van de basale ganglia-circuits in gezondheid en de ziekte van Parkinson op de K-computer. We zijn verheugd om het nieuws over de nieuwe generatie NEST te horen, waarmee we simulaties op hele hersenschaal kunnen uitvoeren op de post-K-computer om de neurale mechanismen van motorische controle en mentale functies te verduidelijken, ", zegt Kenji Doya van het Okinawa Institute of Science and Technology (OIST).

"De studie is een prachtig voorbeeld van de internationale samenwerking in het streven om exascale computers te bouwen. Het is belangrijk dat we applicaties gereed hebben die deze kostbare machines kunnen gebruiken vanaf de eerste dag dat ze beschikbaar zijn, " concludeert Mitsuhisa Sato van het RIKEN Advanced Institute for Computer Science in Kobe.

Hoofdlijnen

- Hoe de Amoeben zich reproduceren?

- Wat gebeurt er met een Zygote na bevruchting?

- Microbeads zorgen ervoor dat ultrasone golven cellen veiliger kunnen stimuleren

- Samengestelde ogen een continu kenmerk van evolutie

- Lijst van eencellige organismen

- Van motief naar methode,

- Twee fasen van fotosynthese

- Dodelijk beheer van wolven op één plek kan de situatie in de buurt erger maken

- Hoe vogelgenetica zich aanpast aan klimaatverandering

- Op weg om een betaalbare auto te maken, Tesla schrapt banen

- AT&T haalt Friends van Netflix voor zijn streamingdienst

- Amazon opent eerste Go-winkel die contant geld accepteert

- Apple patenteert snoop-proof schermen

- Eerste op reputatie gebaseerde blockchain garandeert beveiliging tegen aanvallen van 51 procent

Modulair apparaat voor buitenaardse experimenten

Modulair apparaat voor buitenaardse experimenten Hoe sociale media kunnen helpen om de gezondheid van ecosystemen in de gaten te houden

Hoe sociale media kunnen helpen om de gezondheid van ecosystemen in de gaten te houden Veranderende veestapel in het oude Europa weerspiegelt politieke verschuivingen

Veranderende veestapel in het oude Europa weerspiegelt politieke verschuivingen Water zou antwoord kunnen bieden op grafeen-nano-elektronica

Water zou antwoord kunnen bieden op grafeen-nano-elektronica Onderzoekers brengen pad naar goedkopere flexibele zonnecellen in kaart

Onderzoekers brengen pad naar goedkopere flexibele zonnecellen in kaart Nieuwe theorie legt uit hoe de binnenkern van de aarde solide blijft ondanks extreme hitte

Nieuwe theorie legt uit hoe de binnenkern van de aarde solide blijft ondanks extreme hitte Kolonisatie van de Antillen door Zuid-Amerikaanse fauna:gigantische verzonken eilanden als doorgang?

Kolonisatie van de Antillen door Zuid-Amerikaanse fauna:gigantische verzonken eilanden als doorgang? Gammastraling-telescopen kunnen ruimteschepen detecteren die worden aangedreven door een zwart gat

Gammastraling-telescopen kunnen ruimteschepen detecteren die worden aangedreven door een zwart gat

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com