Wetenschap

Robots leren wat mensen willen

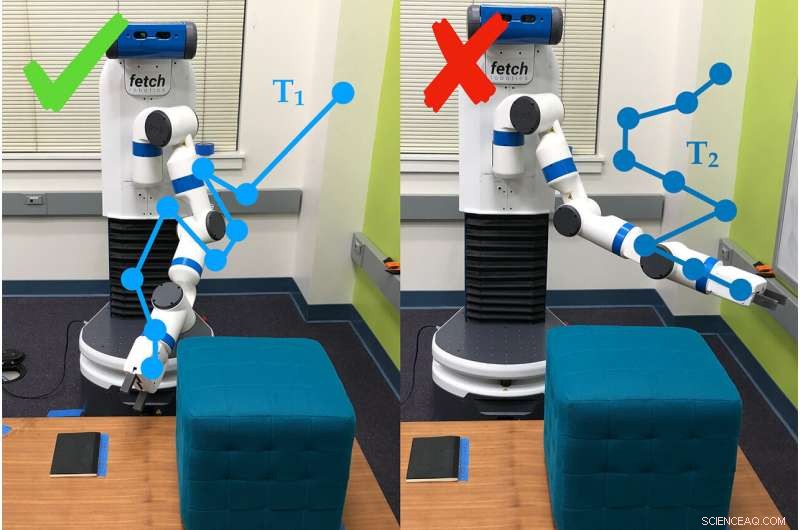

Een voorbeeld van hoe de robotarm enquêtevragen gebruikt om de voorkeuren van de persoon die hem gebruikt vast te stellen. In dit geval, de persoon geeft de voorkeur aan traject #1 (T1) boven traject #2. Krediet:Andy Palan en Gleb Shevchuk

Verteld om te optimaliseren voor snelheid tijdens het racen over een circuit in een computerspel, een auto duwt het pedaal naar het metaal ... en gaat verder met draaien in een krappe kleine cirkel. Niets in de instructies vertelde de auto om rechtdoor te rijden, en dus improviseerde het.

Dit voorbeeld - grappig in een computerspel, maar niet zozeer in het leven - is een van de voorbeelden die de onderzoekers van Stanford University motiveerden om een betere manier te bedenken om doelen te stellen voor autonome systemen.

Dorsa Sadigh, universitair docent informatica en elektrotechniek, en haar lab hebben twee verschillende manieren gecombineerd om doelen voor robots te stellen in één proces, die beter presteerde dan elk van zijn onderdelen alleen in zowel simulaties als experimenten in de echte wereld. De onderzoekers presenteerden het werk op 24 juni op de Robotica:wetenschap en systemen conferentie.

"In de toekomst, Ik verwacht volledig dat er meer autonome systemen in de wereld zullen zijn en dat ze een concept nodig hebben van wat goed en slecht is, " zei Andy Palan, afgestudeerde student in computerwetenschappen en co-hoofdauteur van het artikel. "Het is cruciaal, als we deze autonome systemen in de toekomst willen inzetten, dat we dat goed vinden."

Het nieuwe systeem van het team voor het geven van instructies aan robots - ook wel beloningsfuncties genoemd - combineert demonstraties, waarin mensen de robot laten zien wat hij moet doen, en gebruikersvoorkeurenquêtes, waarin mensen vragen beantwoorden over hoe ze willen dat de robot zich gedraagt.

"Demonstraties zijn informatief, maar kunnen luidruchtig zijn. voorkeuren bieden, hoogstens, een beetje informatie, maar zijn veel nauwkeuriger, "zei Sadigh. "Ons doel is om het beste van twee werelden te krijgen, en gegevens uit beide bronnen intelligenter combineren om beter te leren over de favoriete beloningsfunctie van mensen."

Demonstraties en enquêtes

In eerder werk, Sadigh had zich alleen gericht op voorkeurenquêtes. Deze vragen mensen om scenario's te vergelijken, zoals twee trajecten voor een zelfrijdende auto. Deze methode is efficiënt, maar het kan wel drie minuten duren om de volgende vraag te genereren, die nog steeds traag is voor het maken van instructies voor complexe systemen zoals een auto.

Om dat te versnellen, de groep ontwikkelde later een manier om meerdere vragen tegelijk te produceren, die snel achter elkaar door één persoon kunnen worden beantwoord of over meerdere mensen kunnen worden verdeeld. Deze update versnelde het proces 15 tot 50 keer in vergelijking met het één voor één maken van vragen.

Het nieuwe combinatiesysteem begint met een persoon die een gedrag vertoont aan de robot. Dat kan autonome robots veel informatie geven, maar de robot heeft vaak moeite om te bepalen welke onderdelen van de demonstratie belangrijk zijn. Mensen willen ook niet altijd dat een robot zich net zo gedraagt als de mens die hem heeft getraind.

"We kunnen niet altijd demonstraties geven, en zelfs wanneer we kunnen, we kunnen vaak niet vertrouwen op de informatie die mensen geven, " zei Erdem Biyik, een afgestudeerde student elektrotechniek die het werk leidde bij het ontwikkelen van de enquêtes met meerdere vragen. "Bijvoorbeeld, eerdere studies hebben aangetoond dat mensen willen dat autonome auto's minder agressief rijden dan zijzelf."

Dat is waar de enquêtes binnenkomen, de robot een manier geven om te vragen, bijvoorbeeld, of de gebruiker de voorkeur geeft aan zijn arm laag bij de grond of omhoog naar het plafond. Voor deze studie is de groep gebruikte de langzamere enkele vraagmethode, maar ze zijn van plan om enquêtes met meerdere vragen in later werk te integreren.

Bij testen, het team ontdekte dat het combineren van demonstraties en enquêtes sneller was dan alleen het specificeren van voorkeuren en, in vergelijking met demonstraties alleen, ongeveer 80 procent van de mensen gaf er de voorkeur aan hoe de robot zich gedroeg toen hij met het gecombineerde systeem werd getraind.

"Dit is een stap om beter te begrijpen wat mensen willen of verwachten van een robot, "zei Sadigh. "Ons werk maakt het voor mensen gemakkelijker en efficiënter om te communiceren en robots te leren, en ik kijk er naar uit om met dit werk verder te gaan, vooral bij het bestuderen hoe robots en mensen van elkaar kunnen leren."

Beter, sneller, slimmer

Mensen die de gecombineerde methode gebruikten, meldden dat ze moeite hadden om te begrijpen waar het systeem op doelde met sommige van zijn vragen, die hen soms vroeg om te kiezen tussen twee scenario's die hetzelfde leken of irrelevant leken voor de taak - een veelvoorkomend probleem bij op voorkeuren gebaseerd leren. De onderzoekers hopen deze tekortkoming te verhelpen met eenvoudigere enquêtes die ook sneller werken.

"Kijkend naar de toekomst, het is mij niet 100 procent duidelijk wat de juiste manier is om beloningsfuncties te maken, maar realistisch gezien heb je een soort combinatie die complexe situaties kan aanpakken met menselijke input, "Zei Palan. "Het is een grote uitdaging om beloningsfuncties te ontwerpen voor autonome systemen. belangrijk probleem dat in de academische wereld niet de aandacht heeft gekregen die het verdient."

Het team is ook geïnteresseerd in een variatie op hun systeem, waarmee mensen tegelijkertijd beloningsfuncties voor verschillende scenario's kunnen creëren. Bijvoorbeeld, een persoon wil misschien dat zijn auto conservatiever rijdt in langzaam verkeer en agressiever wanneer het verkeer licht is.

Wanneer demo's mislukken

Soms slagen demonstraties er niet in om het doel van een taak over te brengen. Bijvoorbeeld, een demonstratie in dit onderzoek liet mensen de robotarm leren bewegen totdat deze naar een specifieke plek op de grond wees, en om dat te doen terwijl je een obstakel ontwijkt en zonder boven een bepaalde hoogte te komen.

Nadat een mens de robot 30 minuten lang op de proef had gesteld, de robot probeerde de taak autonoom uit te voeren. Het wees gewoon recht omhoog. Het was zo gericht op het leren om het obstakel niet te raken, het miste volledig het eigenlijke doel van de taak - naar de plek wijzen - en de voorkeur om laag te blijven.

Handcodering en beloningshacking

Een andere manier om een robot te leren, is door code te schrijven die als instructies fungeert. De uitdaging is om precies uit te leggen wat je wilt dat een robot doet, vooral als de taak complex is. Een veelvoorkomend probleem staat bekend als "beloningshacking, " waarbij de robot een gemakkelijkere manier bedenkt om de gespecificeerde doelen te bereiken, zoals de auto die in cirkels ronddraait om het doel van snel rijden te bereiken.

Biyik kreeg te maken met het hacken van beloningen toen hij een robotarm programmeerde om een cilinder vast te pakken en in de lucht te houden.

"Ik vertelde het de hand moet worden gesloten, het object moet een hoogte hebben die hoger is dan X en de hand moet op dezelfde hoogte zijn, " beschreef Biyik. "De robot rolde het cilinderobject naar de rand van de tafel, sloeg het omhoog en maakte toen een vuist ernaast in de lucht."

Groene aanpak versnelt procesoptimalisatie en terugwinning van schakelbare oplosmiddelen

Groene aanpak versnelt procesoptimalisatie en terugwinning van schakelbare oplosmiddelen Studie onthult doorbreking van dansende barrière die kristalgroei regelt

Studie onthult doorbreking van dansende barrière die kristalgroei regelt Uitleg van het verschil tussen viscositeit en drijfvermogen

Uitleg van het verschil tussen viscositeit en drijfvermogen Een 20% -suikeroplossing maken

Een 20% -suikeroplossing maken Onderzoekers creëren nieuwe goedkope, duurzaam materiaal voor het verminderen van lucht- en watervervuiling

Onderzoekers creëren nieuwe goedkope, duurzaam materiaal voor het verminderen van lucht- en watervervuiling

Uit onderzoek blijkt dat wereldwijde actie nodig is om aanvaardbare klimaattoekomsten te verzekeren

Uit onderzoek blijkt dat wereldwijde actie nodig is om aanvaardbare klimaattoekomsten te verzekeren NASA brengt nieuwe, gedetailleerde Groenlandse gletsjergegevens

NASA brengt nieuwe, gedetailleerde Groenlandse gletsjergegevens De donkere kant van plantaardig voedsel:het gaat meer om geld dan je misschien denkt

De donkere kant van plantaardig voedsel:het gaat meer om geld dan je misschien denkt Waardoor komt er een einde aan een ijstijd?

Waardoor komt er een einde aan een ijstijd? Het complexe verband tussen bevolkingsafname en een opwarmende planeet

Het complexe verband tussen bevolkingsafname en een opwarmende planeet

Hoofdlijnen

- Wit vlees of donker vlees? Big data serveren om het Thanksgiving-diner te ontcijferen

- Wat doet het endoplasmatisch reticulum?

- Invasieve superschurkenkrab kan door zijn kieuwen heen eten

- Kunnen data dolfijnen redden? Hoe wetenschappers NASA-gegevens gebruiken om het verband tussen zonnestormen en het stranden van dieren te bestuderen

- Welk deel van het Nephron is verantwoordelijk voor de reabsorptie van water?

- Hands-on Science-activiteiten over bloed

- Hebben mensen en bananen echt 50 procent van hetzelfde DNA?

- UV-licht: positieve en negatieve effecten

- Waarom zetten we de radio zachter als we verdwaald waren?

- Populaire app uit het Midden-Oosten beschuldigd van spionage op Google Play

- Kabelbedrijf Altice USA schept streaming nieuwssite Cheddar . op

- Nieuwe vingertopsensoren om veteranen te helpen door hun prothese heen te voelen

- Frankrijk houdt Ryanair-vliegtuig aan de grond om terugbetaling van subsidie af te dwingen

- De nauwkeurigheid van een neuraal netwerk voorspellen voorafgaand aan de training

Wetenschappers herbekijken het koude geval van koude kernfusie

Wetenschappers herbekijken het koude geval van koude kernfusie De levensstijl van grijze nomaden biedt een model om op afstand te leven

De levensstijl van grijze nomaden biedt een model om op afstand te leven Lawaai kan je van je eten afhouden

Lawaai kan je van je eten afhouden Principes van stoomdestillatie

Principes van stoomdestillatie Sociale emotiedetector:emotionele reacties op sociale gebeurtenissen onderzoeken

Sociale emotiedetector:emotionele reacties op sociale gebeurtenissen onderzoeken Wetenschappers ontwerpen manier om onschadelijke bacteriën te gebruiken om zware metalen in drinkwater te detecteren

Wetenschappers ontwerpen manier om onschadelijke bacteriën te gebruiken om zware metalen in drinkwater te detecteren Het vermogen van de kwelders om koolstof af te zinken kan worden bedreigd door stikstofvervuiling

Het vermogen van de kwelders om koolstof af te zinken kan worden bedreigd door stikstofvervuiling Onderzoekers demonstreren praktische metalen nanostructuren

Onderzoekers demonstreren praktische metalen nanostructuren

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com