Wetenschap

Machines die taal leren zoals kinderen dat doen

MIT-onderzoekers hebben een "semantische parser" ontwikkeld die door observatie leert om het taalverwervingsproces van een kind beter na te bootsen, die de mogelijkheden van de computer aanzienlijk zouden kunnen uitbreiden. Krediet:Massachusetts Institute of Technology

Kinderen leren taal door hun omgeving te observeren, luisteren naar de mensen om hen heen, en het verbinden van de punten tussen wat ze zien en horen. Onder andere, dit helpt kinderen de woordvolgorde van hun taal vast te stellen, zoals waar onderwerpen en werkwoorden in een zin vallen.

Bij informatica, het leren van taal is de taak van syntactische en semantische parsers. Deze systemen zijn getraind op zinnen die door mensen zijn geannoteerd en die de structuur en betekenis achter woorden beschrijven. Parsers worden steeds belangrijker voor zoekopdrachten op internet, databasequery's in natuurlijke taal, en spraakherkenningssystemen zoals Alexa en Siri. Spoedig, ze kunnen ook worden gebruikt voor thuisrobotica.

Maar het verzamelen van de annotatiegegevens kan tijdrovend en moeilijk zijn voor minder gangbare talen. Aanvullend, mensen zijn het niet altijd eens over de annotaties, en de annotaties zelf geven mogelijk niet nauwkeurig weer hoe mensen van nature spreken.

In een paper die deze week wordt gepresenteerd op de Empirical Methods in Natural Language Processing-conferentie, MIT-onderzoekers beschrijven een parser die leert door observatie om het taalverwervingsproces van een kind beter na te bootsen, wat de mogelijkheden van de parser aanzienlijk zou kunnen uitbreiden. Om de structuur van taal te leren, de parser observeert ondertitelde video's, zonder andere informatie, en associeert de woorden met opgenomen objecten en acties. Gegeven een nieuwe zin, de parser kan dan gebruiken wat hij heeft geleerd over de structuur van de taal om de betekenis van een zin nauwkeurig te voorspellen, zonder het filmpje.

Deze "zwak gecontroleerde" benadering - wat inhoudt dat er beperkte trainingsgegevens nodig zijn - bootst na hoe kinderen de wereld om hen heen kunnen observeren en taal kunnen leren, zonder dat iemand directe context geeft. De aanpak kan de soorten gegevens uitbreiden en de inspanning verminderen die nodig is voor het trainen van parsers, volgens de onderzoekers. Een paar direct geannoteerde zinnen, bijvoorbeeld, kan worden gecombineerd met veel ondertitelde video's, die gemakkelijker te vinden zijn, prestaties te verbeteren.

In de toekomst, de parser kan worden gebruikt om de natuurlijke interactie tussen mensen en persoonlijke robots te verbeteren. Een robot uitgerust met de parser, bijvoorbeeld, kon constant zijn omgeving observeren om zijn begrip van gesproken commando's te versterken, ook wanneer de gesproken zinnen niet volledig grammaticaal of duidelijk zijn. "Mensen praten met elkaar in deelzinnen, op hol geslagen gedachten, en verwarde taal. U wilt een robot in uw huis die zich aanpast aan hun specifieke manier van spreken ... en toch uitvindt wat ze bedoelen, " zegt co-auteur Andrei Barbu, een onderzoeker in het Computer Science and Artificial Intelligence Laboratory (CSAIL) en het Centre for Brains, geesten, en Machines (CBMM) binnen het McGovern Institute van MIT.

De parser kan onderzoekers ook helpen beter te begrijpen hoe jonge kinderen taal leren. "Een kind heeft toegang tot overtollige, aanvullende informatie uit verschillende modaliteiten, inclusief het horen van ouders en broers en zussen die over de wereld praten, evenals tactiele informatie en visuele informatie, [die hem of haar helpen] de wereld te begrijpen, " zegt co-auteur Boris Katz, een hoofdonderzoeker en hoofd van de InfoLab Group bij CSAIL. "Het is een geweldige puzzel, om al deze gelijktijdige sensorische input te verwerken. Dit werk maakt deel uit van een groter stuk om te begrijpen hoe dit soort leren in de wereld plaatsvindt."

Co-auteurs op het papier zijn:eerste auteur Candace Ross, een afgestudeerde student bij de faculteit Elektrotechniek en Informatica en CSAIL, en een onderzoeker bij CBMM; Yevgeni Berzak Ph.D. '17, een postdoc in de Computational Psycholinguistics Group van het departement Hersen- en Cognitieve Wetenschappen; en CSAIL-afgestudeerde student Battushig Myanganbayar.

Visuele leerling

Voor hun werk, de onderzoekers combineerden een semantische parser met een computervisiecomponent die in objecten was getraind, menselijk, en activiteitsherkenning in video. Semantische parsers worden over het algemeen getraind in zinnen die zijn geannoteerd met code die betekenis toekent aan elk woord en de relaties tussen de woorden. Sommigen zijn getraind in stilstaande beelden of computersimulaties.

De nieuwe parser is de eerste die is getraind met behulp van video, zegt Roos. Gedeeltelijk, video's zijn nuttiger in het verminderen van ambiguïteit. Als de parser niet zeker is, zeggen, een actie of object in een zin, het kan verwijzen naar de video om dingen op te helderen. "Er zijn tijdelijke componenten - objecten die met elkaar en met mensen in wisselwerking staan - en eigenschappen op hoog niveau die je niet zou zien in een stilstaand beeld of alleen in taal, ' zegt Roos.

De onderzoekers stelden een dataset samen van ongeveer 400 video's waarin mensen een aantal acties uitvoeren, inclusief het oppakken of neerzetten van een object, en lopen naar een object. Deelnemers op het crowdsourcingplatform Mechanical Turk leverden vervolgens 1 200 bijschriften voor die video's. Ze hebben 840 video-ondertitelingsvoorbeelden apart gezet voor training en afstemming, en gebruikte 360 voor het testen. Een voordeel van het gebruik van op vision gebaseerde parsing is:"u hebt lang niet zoveel gegevens nodig, hoewel als u [de gegevens] had, je zou kunnen opschalen naar enorme datasets, ' zegt Barbu.

In opleiding, de onderzoekers gaven de parser het doel om te bepalen of een zin een bepaalde video nauwkeurig beschrijft. Ze hebben de parser een video en bijbehorend bijschrift gegeven. De parser extraheert mogelijke betekenissen van het bijschrift als logische wiskundige uitdrukkingen. De zin, "De vrouw pakt een appel, " bijvoorbeeld, kan worden uitgedrukt als:λxy. vrouw x, pick_up x y, appel j.

Die uitdrukkingen en de video worden ingevoerd in het computervisie-algoritme, genaamd "Zinnen Tracker, " developed by Barbu and other researchers. The algorithm looks at each video frame to track how objects and people transform over time, to determine if actions are playing out as described. In this way, it determines if the meaning is possibly true of the video.

Connecting the dots

The expression with the most closely matching representations for objects, humans, and actions becomes the most likely meaning of the caption. The expression, initially, may refer to many different objects and actions in the video, but the set of possible meanings serves as a training signal that helps the parser continuously winnow down possibilities. "By assuming that all of the sentences must follow the same rules, that they all come from the same language, and seeing many captioned videos, you can narrow down the meanings further, " Barbu says.

Kortom, the parser learns through passive observation:To determine if a caption is true of a video, the parser by necessity must identify the highest probability meaning of the caption. "The only way to figure out if the sentence is true of a video [is] to go through this intermediate step of, 'What does the sentence mean?' Anders, you have no idea how to connect the two, " Barbu explains. "We don't give the system the meaning for the sentence. We say, 'There's a sentence and a video. The sentence has to be true of the video. Figure out some intermediate representation that makes it true of the video.'"

The training produces a syntactic and semantic grammar for the words it's learned. Given a new sentence, the parser no longer requires videos, but leverages its grammar and lexicon to determine sentence structure and meaning.

uiteindelijk, this process is learning "as if you're a kid, " Barbu says. "You see world around you and hear people speaking to learn meaning. One day, I can give you a sentence and ask what it means and, even without a visual, you know the meaning."

In future work, the researchers are interested in modeling interactions, not just passive observations. "Children interact with the environment as they're learning. Our idea is to have a model that would also use perception to learn, " Ross says.

This work was supported, gedeeltelijk, by the CBMM, de Nationale Wetenschapsstichting, a Ford Foundation Graduate Research Fellowship, the Toyota Research Institute, and the MIT-IBM Brain-Inspired Multimedia Comprehension project.

Dit verhaal is opnieuw gepubliceerd met dank aan MIT News (web.mit.edu/newsoffice/), een populaire site met nieuws over MIT-onderzoek, innovatie en onderwijs.

Onderzoekers onthullen nieuwe inzichten in synthetische gencircuits

Onderzoekers onthullen nieuwe inzichten in synthetische gencircuits Onderzoekers vinden conformationele stoornis die de mobiliteit van ladingsdragers afstemt in 2D-perovskieten

Onderzoekers vinden conformationele stoornis die de mobiliteit van ladingsdragers afstemt in 2D-perovskieten Is Pewter Safe?

Is Pewter Safe?  Chemici ontwikkelen verschillende industrieel belangrijke synthetische processen

Chemici ontwikkelen verschillende industrieel belangrijke synthetische processen Zelfherstellend membraan voor papieren documenten voor brandstofceltoepassingen

Zelfherstellend membraan voor papieren documenten voor brandstofceltoepassingen

Hoofdlijnen

- Veiligheid, geen voedsel, lokt ganzen naar steden

- Bevindingen sonde cel samenwerking, massale migratie

- Waarom is de zon zo helder?

- Stamcelplatform werpt nieuw licht op het begin van menselijke ontwikkeling

- Hoe de gecorrigeerde WBC-telling te berekenen

- Welk bewijs is aanwezig Prokaryoten bestonden vóór eukaryoten?

- Wetenschappers ontdekken een genetisch mechanisme dat het opbrengstpotentieel van graangewassen zou kunnen verbeteren

- Eerste levensvormen op aarde onthuld in hete lente

- Nieuwe ontdekking daagt lang gekoesterde evolutietheorie uit

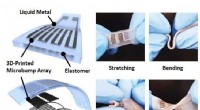

- Nieuwe draagbare druksensor van vloeibaar metaal voor toepassingen voor gezondheidsbewaking

- Geluidssoftware voor foutdetectie in machines

- Kunstmatige intelligentie leren om zintuigen zoals zien en aanraken te verbinden

- Hoe een eenvoudige generator te maken

- Gezichtsherkenningssoftware heeft een genderprobleem

Het verzorgen van Bobwhite kwartelkuikens

Het verzorgen van Bobwhite kwartelkuikens  Onderzoekers vergroten het begrip van bevochtiging van oppervlakken met nanopatronen

Onderzoekers vergroten het begrip van bevochtiging van oppervlakken met nanopatronen Hoe te testen op waterstofchloride

Hoe te testen op waterstofchloride  Broeikasgasfeedbacklus ontdekt in zoetwatermeren

Broeikasgasfeedbacklus ontdekt in zoetwatermeren Waarom is het zo stressvol om met de andere partij over politiek te praten?

Waarom is het zo stressvol om met de andere partij over politiek te praten? Welk type organisch macromolecuul is glucose?

Welk type organisch macromolecuul is glucose?  Grootte van het huis een factor bij het aanpakken van de wereldwijde noodsituatie in het klimaat

Grootte van het huis een factor bij het aanpakken van de wereldwijde noodsituatie in het klimaat Kan deliberatieve democratie Amerika depolariseren?

Kan deliberatieve democratie Amerika depolariseren?

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com