Wetenschap

Waarom diepe netwerken generaliseren ondanks dat ze tegen statistische intuïtie ingaan?

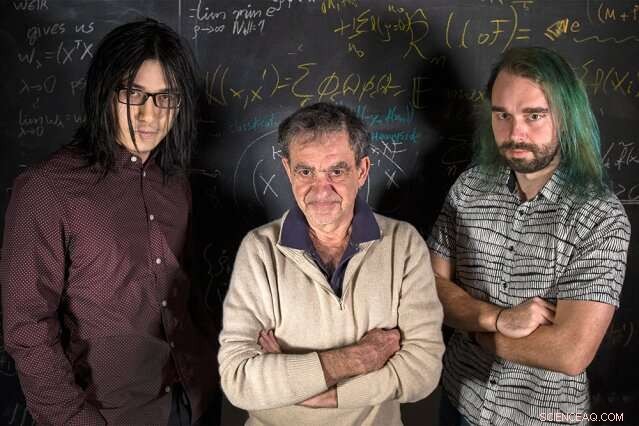

MIT-onderzoekers (van links naar rechts) Qianli Liao, Tomaso Poggio, en Andrzej Banburski staan met hun vergelijkingen. Krediet:Kris Brewer

Inleidende cursussen statistiek leren ons dat, bij het aanpassen van een model aan sommige gegevens, we zouden meer gegevens moeten hebben dan vrije parameters om het gevaar van overfitting te vermijden - het te nauw aansluiten van luidruchtige gegevens, en daardoor niet passen bij nieuwe gegevens. Het is verrassend, dan, dat het bij modern diep leren de praktijk is om orden van grootte meer parameters dan gegevens te hebben. Ondanks dit, diepe netwerken vertonen goede voorspellende prestaties, en in feite beter doen naarmate ze meer parameters hebben. Waarom zou dat zijn?

Het is al enige tijd bekend dat goede prestaties in machine learning voortkomen uit het beheersen van de complexiteit van netwerken, wat niet alleen een simpele functie is van het aantal vrije parameters. De complexiteit van een classificatie, zoals een neuraal netwerk, hangt af van het meten van de "grootte" van de ruimte van functies die dit netwerk vertegenwoordigt, met meerdere technische maatregelen die eerder zijn voorgesteld:Vapnik-Chervonenkis-dimensie, dekkende nummers, of Rademacher complexiteit, om er een paar te noemen. complexiteit, zoals gemeten door deze begrippen, kan tijdens het leerproces worden gecontroleerd door een beperking op te leggen aan de norm van de parameters - kortom, hoe "groot" ze kunnen worden. Het verrassende feit is dat een dergelijke expliciete beperking niet nodig lijkt te zijn bij het trainen van diepe netwerken. Valt deep learning buiten de klassieke leertheorie? Moeten we de fundamenten heroverwegen?

In een nieuwe Nature Communications-paper, "Complexiteitscontrole door gradiëntafdaling in diepe netwerken, " een team van het Centre for Brains, geesten, en machines onder leiding van directeur Tomaso Poggio, de Eugene McDermott Professor in het MIT Department of Brain and Cognitive Sciences, heeft enig licht geworpen op deze puzzel door de meest praktische en succesvolle toepassingen van modern deep learning aan te pakken:classificatieproblemen.

"Voor classificatieproblemen, we zien dat in feite de parameters van het model niet lijken te convergeren, maar in plaats daarvan onbeperkt in omvang groeien tijdens gradiëntafdaling. Echter, bij classificatieproblemen zijn alleen de genormaliseerde parameters van belang, d.w.z. de richting die ze bepalen, niet hun grootte, ", zegt co-auteur en MIT-promovendus Qianli Liao. "Het niet zo voor de hand liggende dat we hebben laten zien, is dat de veelgebruikte gradiëntafdaling op de niet-genormaliseerde parameters de gewenste complexiteitscontrole op de genormaliseerde parameters induceert."

"We weten al een tijdje dat in het geval van regressie voor ondiepe lineaire netwerken, zoals kernelmachines, dat iteraties van gradiëntafdaling een impliciete, verdwijnend regularisatie-effect, " zegt Poggio. "In feite, in dit eenvoudige geval weten we waarschijnlijk dat we de best gedragende maximale marge krijgen, minimumnorm oplossing. De vraag die we onszelf stelden, dan, was:Kan iets soortgelijks gebeuren voor diepe netwerken?"

De onderzoekers ontdekten van wel. Zoals co-auteur en MIT-postdoc Andrzej Banburski uitlegt:"Het begrijpen van convergentie in diepe netwerken laat zien dat er duidelijke aanwijzingen zijn voor het verbeteren van onze algoritmen. we hebben al hints gezien dat het beheersen van de snelheid waarmee deze niet-genormaliseerde parameters divergeren ons in staat stelt beter presterende oplossingen te vinden en deze sneller te vinden."

Wat betekent dit voor machine learning? Er zit geen magie achter diepe netwerken. Dezelfde theorie achter alle lineaire modellen is hier ook in het spel. Dit werk suggereert manieren om diepe netwerken te verbeteren, waardoor ze nauwkeuriger en sneller te trainen zijn.

Dit verhaal is opnieuw gepubliceerd met dank aan MIT News (web.mit.edu/newsoffice/), een populaire site met nieuws over MIT-onderzoek, innovatie en onderwijs.

Wateroppervlaktemoleculen verliezen energie door rotatie van vrije OH-groep

Wateroppervlaktemoleculen verliezen energie door rotatie van vrije OH-groep Onderzoekers lossen controverse op over energiekloof van Van der Waals-materiaal

Onderzoekers lossen controverse op over energiekloof van Van der Waals-materiaal Snelle vloeistofverpakking:watersilhouetten insluiten in 3D-polymeermembranen voor lab-in-a-drop-experimenten

Snelle vloeistofverpakking:watersilhouetten insluiten in 3D-polymeermembranen voor lab-in-a-drop-experimenten De beste undergraduate Chemical Engineering Schools

De beste undergraduate Chemical Engineering Schools De architecturen van binnenste mitochondriale membraaneiwitten begrijpen

De architecturen van binnenste mitochondriale membraaneiwitten begrijpen

Opwarming van de aarde intensiveert extreme neerslag in China

Opwarming van de aarde intensiveert extreme neerslag in China Team detecteert pathogene bacteriën in grondwater in Texas nabij aardgaswinningslocaties

Team detecteert pathogene bacteriën in grondwater in Texas nabij aardgaswinningslocaties Een op bliksem gebaseerde nowcast-waarschuwingsaanpak om kortdurende regenval te voorspellen

Een op bliksem gebaseerde nowcast-waarschuwingsaanpak om kortdurende regenval te voorspellen Experts benadrukken geavanceerde satellietgegevens als essentieel hulpmiddel bij het aanpakken van klimaatverandering

Experts benadrukken geavanceerde satellietgegevens als essentieel hulpmiddel bij het aanpakken van klimaatverandering Wat zijn de aanpassingen voor dieren om te overleven in de Taiga?

Wat zijn de aanpassingen voor dieren om te overleven in de Taiga?

Hoofdlijnen

- De kenmerken van de mitochondria

- orang-oetans, zoals mensen, geneeskrachtige planten gebruiken om gewrichts- en spierontsteking te behandelen

- Deoxyribonucleïnezuur (DNA): structuur, functie en belang

- Wat zijn de vier fasen van volledige glucose-afbraak?

- Wat zijn enkele kenmerken van DNA?

- Maak een lijst van de 3 stappen die optreden tijdens de interfase

- Hoe bloedzuigende insecten donkergecoat vee in het donker vinden

- Huismuizen kunnen hun vocalisaties moduleren, afhankelijk van het geslacht van de ontvanger

- Onkruidverdelger glyfosaat, controversieel maar nog steeds het meest gebruikt

- Innovatieve beeldvormingstechnologie leidt tot geautomatiseerde pathologische diagnose

- Hoe robots worden geïnspireerd door insecten

- Korean Air laat 70 procent van het personeel met verlof

- Samsung Electronics zegt dat de nettowinst in het vierde kwartaal met 38% daalt

- Zuid-Korea legt BMW een boete op van 10 miljoen dollar voor reactie op motorbrand

China stelt strengere richtlijnen op om patenten te beschermen, auteursrechten

China stelt strengere richtlijnen op om patenten te beschermen, auteursrechten Onderzoek bepaalt de redenen voor enorme branden in het zuiden van centraal Chili

Onderzoek bepaalt de redenen voor enorme branden in het zuiden van centraal Chili Burgerwetenschappers ontdekken cyclisch patroon van complexiteit in zonnestormen

Burgerwetenschappers ontdekken cyclisch patroon van complexiteit in zonnestormen Uber weer op weg in Wenen

Uber weer op weg in Wenen Wetenschappers vinden bloedmolecuul dat wolven aantrekt stoot mensen af

Wetenschappers vinden bloedmolecuul dat wolven aantrekt stoot mensen af Taal is een hulpmiddel geworden voor sociale uitsluiting

Taal is een hulpmiddel geworden voor sociale uitsluiting De missie om een mysterieuze aerosollaag boven de Himalaya-moessonwolken te ontcijferen

De missie om een mysterieuze aerosollaag boven de Himalaya-moessonwolken te ontcijferen When Is Skunk Mating Season?

When Is Skunk Mating Season?

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com