Wetenschap

Wanneer een licht een dief is die uw garagedeur vertelt te openen

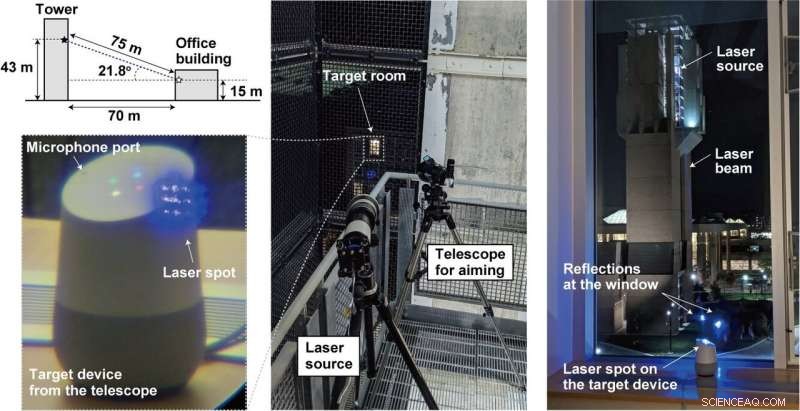

Krediet:lightcommands.com

Stralende lasers op stemassistenten zoals Alexa en Siri, onderzoekers uit Michigan en Japan bereikten een hack waarbij lasers de kracht hadden van commando's van de menselijke stem.

Door de laser door het raam te laten schijnen op microfoons in apparaten zoals tablets, of telefoons, een verafgelegen aanvaller kan op afstand onhoorbare en mogelijk onzichtbare commando's sturen waarop Alexa reageert, Portaal, Google-assistent of Siri.

Simpel gezegd, een aanvaller kan de stemassistent kapen en opdrachten verzenden.

Hoe heeft het team licht als geluid uitgevoerd? Er wordt misbruik gemaakt van een kwetsbaarheid in microfoons die gebruikmaken van micro-elektromechanische systemen (MEMS). De MEMS-componenten reageren onbedoeld op licht alsof het geluid is, zei Ars Technica .

Wat is het ergste dat kan gebeuren? Heel veel. Ars Technica beschreef de lasers die onhoorbare commando's in de apparaten injecteerden en heimelijk ervoor zorgden dat ze "deuren ontgrendelden, websites bezoeken, en lokaliseren, ontgrendelen, en start voertuigen."

De onderzoekers bespraken hun werk in hun paper dat maandag werd gepubliceerd. "Light Commands:Laser-Based Audio Injection Attacks on Voice-Controllable Systems" is geschreven door vijf auteurs met affiliaties van de University of Michigan (vier) en van The University of Electro-Communications, Japan (één).

"In onze krant " ze zeiden, "we demonstreren dit effect, met succes licht gebruiken om kwaadaardige commando's te injecteren in verschillende spraakgestuurde apparaten zoals slimme luidsprekers, tabletten, en telefoons over grote afstanden en door glazen ramen."

Hoe gemakkelijk was het om uit te voeren?

Om authenticatie te dwarsbomen, vrij gemakkelijk.

"Spraakgestuurde systemen vereisen vaak niet dat gebruikers zichzelf verifiëren, " schreef Ars Technica 's Dan Goodin. De aanval kon in die gevallen vaak worden uitgevoerd zonder dat wachtwoorden of pincodes nodig waren. Vaak. "Zelfs wanneer de systemen authenticatie vereisen voor bepaalde acties, " hij voegde toe, "het kan mogelijk zijn om de pincode bruut te forceren, omdat veel apparaten het aantal gissingen dat een gebruiker kan maken niet beperken."

Ook, de aanval was niet duur om uit te voeren. Lichtcommando's zijn goedkoop te monteren, zei een videopresentator, met behulp van gewone laserpointers. Dit kan zelfs tussen twee gebouwen.

Het team zei dat ze hun aanval op populaire spraakherkenningssystemen hebben geprobeerd, namelijk Amazon Alexa, Appel Siri, Facebook-portaal, en Google Assistent. Werkelijk, Hoewel, "elk systeem dat MEMS-microfoons gebruikt en op deze gegevens reageert zonder aanvullende gebruikersbevestiging, kan kwetsbaar zijn, " volgens hun eigen lichtcommandosite.

Wat is het gevaar met Light Commands?

Alexa, wat is het weer? Dat is ongevaarlijk. De aanvaller kan smarthome-schakelaars bedienen. Open slimme garagedeuren. Op afstand starten van voertuigen. In feite, je kunt een video bekijken waarin je "OK Google, open de garagedeur" naar een Google Home door gewoon met een goedkope laserpointer te schijnen.

Wat kan er worden gedaan om te beschermen tegen de kwetsbaarheid? De videopresentator zei dat de basiskwetsbaarheid niet kan worden aangepakt zonder een duur herontwerp van de microfoon.

"We werken samen met Amazon, Google, Appel, evenals andere verkopers over defensieve maatregelen." Ze hebben meer informatie en demonstraties op lightcommands.com.

"Een extra authenticatielaag kan effectief zijn om de aanval enigszins af te zwakken. in het geval dat de aanvaller de reactie van het apparaat niet kan afluisteren, het apparaat de gebruiker een eenvoudige willekeurige vraag laten stellen voordat de opdracht wordt uitgevoerd, kan een effectieve manier zijn om te voorkomen dat de aanvaller de opdracht met succes uitvoert.

"Fabrikanten kunnen ook proberen sensorfusietechnieken te gebruiken, zoals het verkrijgen van audio van meerdere microfoons. Wanneer de aanvaller een enkele laser gebruikt, slechts een enkele microfoon ontvangt een signaal terwijl de anderen niets ontvangen...

Een andere benadering bestaat uit het verminderen van de hoeveelheid licht die het diafragma van de microfoon bereikt met behulp van een barrière die rechte lichtstralen fysiek blokkeert om de zichtlijn naar het diafragma te elimineren, of implementeer een niet-transparante afdekking bovenop het microfoongat om de hoeveelheid licht die op de microfoon valt te dempen. Echter, we merken op dat dergelijke fysieke barrières slechts tot op zekere hoogte effectief zijn, aangezien een aanvaller altijd het laservermogen kan verhogen in een poging om de door de dekking veroorzaakte demping te compenseren of om door de barrières te branden, het creëren van een nieuw lichtpad."

Het bovenstaande verscheen op hun site met lichtcommando's, terwijl de paper ook mitigatiebenaderingen en -beperkingen besprak.

In de tussentijd, Mariella Moon binnen Engadget herinnerde haar lezers eraan dat dit niet de eerste keer zou zijn dat onderzoekers kwetsbaarheden in digitale assistenten vonden. "Onderzoekers van de Chinese Universiteit van Zheijiang ontdekten dat Siri, Alexa en andere stemassistenten kunnen worden gemanipuleerd met opdrachten die in ultrasone frequenties worden verzonden."

© 2019 Wetenschap X Netwerk

Hoe Inconel

Hoe Inconel Kleine enzym-nabootsende polymeren hebben mogelijk geholpen om het leven te beginnen

Kleine enzym-nabootsende polymeren hebben mogelijk geholpen om het leven te beginnen Nauwkeurige medicijndoseringen met protonvallen

Nauwkeurige medicijndoseringen met protonvallen Een metallopeptide richt zich op en verstoort de mitochondriale functie in stamcellen van borstkanker

Een metallopeptide richt zich op en verstoort de mitochondriale functie in stamcellen van borstkanker Wat gebeurt er nadat je een wortel in zout water hebt geplaatst?

Wat gebeurt er nadat je een wortel in zout water hebt geplaatst?

Onderzoekers beweren dat langdurige blootstelling aan luchtvervuiling in China tussen 2000 en 2016 30,8 miljoen mensen heeft gedood

Onderzoekers beweren dat langdurige blootstelling aan luchtvervuiling in China tussen 2000 en 2016 30,8 miljoen mensen heeft gedood Drie ton afval verzameld van Everest

Drie ton afval verzameld van Everest Wereldwijde poging tot herstel van koraalriffen in het Caribisch gebied

Wereldwijde poging tot herstel van koraalriffen in het Caribisch gebied Rookpluimen van bosbranden vanuit de ruimte observeren

Rookpluimen van bosbranden vanuit de ruimte observeren Food Speech Topics

Food Speech Topics

Hoofdlijnen

- Hoe goede bacteriën je genen beheersen

- Een genetische opstand in het vroege leven voorkomen

- Hoe hebben wetenschappers ontdekt dat genen zijn gemaakt van DNA?

- Bio-ingenieurs ontdekken mechanisme dat krachtpatsers van cellen reguleert

- De oproepen van pinguïns worden beïnvloed door hun leefgebied

- Wat zijn de functies van Triglyceride Phospholipid & Sterol?

- Kleine Braziliaanse kikkers zijn doof voor hun eigen roep

- Zeldzame aardkers kan binnenkort overal zijn,

- Overeenkomsten van de mitochondria en nucleus

- Vergeet vliegende tapijten, vliegende taxi's komen je kant op

- Botten, goed of slecht, domineren Twitter-gesprek:studie

- Cyberbeveiliging van geconnecteerde autonome voertuigen getest

- De geo-engineering van toestemming:hoe samenzweerders de klimaatwetenschappelijke inhoud van YouTube domineren

- Google Flights wil luchtreizigers geld besparen met nieuwe waarschuwingen op nabijgelegen luchthavens, reis data

Afbeeldingen van dokters in strips zijn realistischer geworden, genuanceerd

Afbeeldingen van dokters in strips zijn realistischer geworden, genuanceerd Appel, Salesforce werkt samen aan mobiele apps voor bedrijven

Appel, Salesforce werkt samen aan mobiele apps voor bedrijven Water brengen naar door droogte geteisterde dieren in Kenia

Water brengen naar door droogte geteisterde dieren in Kenia Manieren om te vertellen of iets een functie is

Manieren om te vertellen of iets een functie is  NASA duikt diep in de zoektocht naar leven

NASA duikt diep in de zoektocht naar leven Winst eerste halfjaar Ryanair daalt met 7% na wijdverbreide stakingen

Winst eerste halfjaar Ryanair daalt met 7% na wijdverbreide stakingen Grubhub koopt mobiele bestel- en betalingsbedrijf LevelUp voor $ 390 miljoen

Grubhub koopt mobiele bestel- en betalingsbedrijf LevelUp voor $ 390 miljoen Grafeenballonnen om edelgassen te identificeren

Grafeenballonnen om edelgassen te identificeren

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com