Wetenschap

Slimme voertuigen hun richtingsgevoel geven

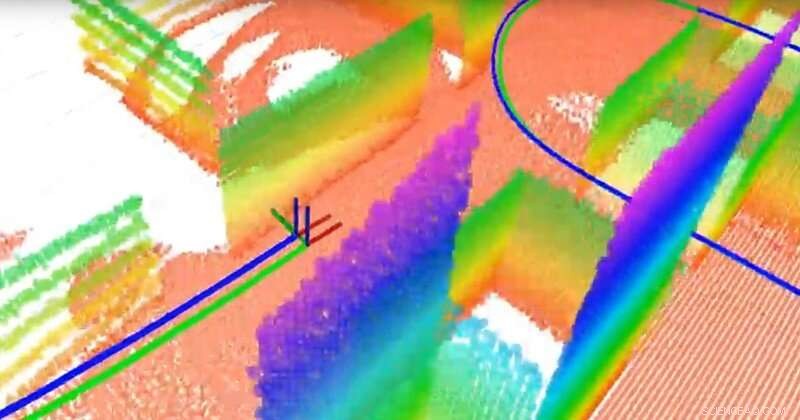

Het team bouwde een 3D-planetkaart met behulp van een 3D LiDAR en een traagheidssensor. LiDAR is als radar, maar gebruikt licht in plaats van radiogolven. Punten met verschillende kleuren zijn de verschillende vlakken (die dienen als oriëntatiepunten voor navigatie), de groene lijn is het werkelijke traject en de blauwe lijn is het geschatte traject berekend door het SLAM-algoritme (simultaneous localization and mapping) van het team. Krediet:Universiteit van Delaware

Wetenschappers over de hele wereld racen om zelfrijdende voertuigen te ontwikkelen, maar een paar essentiële componenten moeten nog worden geperfectioneerd. Een daarvan is lokalisatie:het vermogen van het voertuig om zijn plaats en beweging te bepalen. Een ander voorbeeld is het in kaart brengen van het vermogen van voertuigen om de omgeving te modelleren, zodat het passagiers veilig naar de juiste plaats kan vervoeren.

De vraag is:hoe geef je een voertuig richtinggevoel? Hoewel GPS-apparaten (Global Positioning Satellite) kunnen helpen, ze zijn niet in alle contexten beschikbaar of betrouwbaar. In plaats daarvan, veel experts onderzoeken gelijktijdige lokalisatie en mapping, of SLAM, een notoir moeilijk probleem op het gebied van robotica. Nieuwe algoritmen ontwikkeld door Guoquan (Paul) Huang, een assistent-professor werktuigbouwkunde, elektrotechniek en computertechniek, en computer- en informatiewetenschappen aan de Universiteit van Delaware, brengen het antwoord dichterbij.

Huang gebruikt visuele traagheidsnavigatiesystemen die traagheidssensoren combineren, die gyroscopen bevatten om de oriëntatie te bepalen en versnellingsmeters om de versnelling te bepalen, samen met camera's. Met behulp van gegevens van deze relatief goedkope, algemeen beschikbare componenten, Huang meet en berekent beweging en lokalisatie.

Bijvoorbeeld, toen zijn team hun systeem op een laptop verbond en het ronddroeg in het Spencer Laboratory van UD, thuisbasis van de faculteit Werktuigbouwkunde, ze genereerden voldoende gegevens om het gebouw in kaart te brengen terwijl ze de beweging van de laptop zelf volgden. In een autonoom voertuig, soortgelijke sensoren en camera's zouden worden bevestigd aan een robot in het voertuig.

Het vermogen van een autonoom voertuig om zijn eigen beweging en de beweging van objecten eromheen te volgen, is van cruciaal belang. "We moeten het voertuig lokaliseren voordat we het voertuig automatisch kunnen besturen, " zei Huang. "Het voertuig moet zijn locatie weten om verder te kunnen gaan."

Dan is er nog de kwestie van veiligheid. "In een stedelijk scenario, bijvoorbeeld, er zijn voetgangers en andere voertuigen, dus idealiter zou het voertuig in staat moeten zijn om zowel zijn eigen beweging als de beweging van bewegende objecten in zijn omgeving te volgen, " zei Huang.

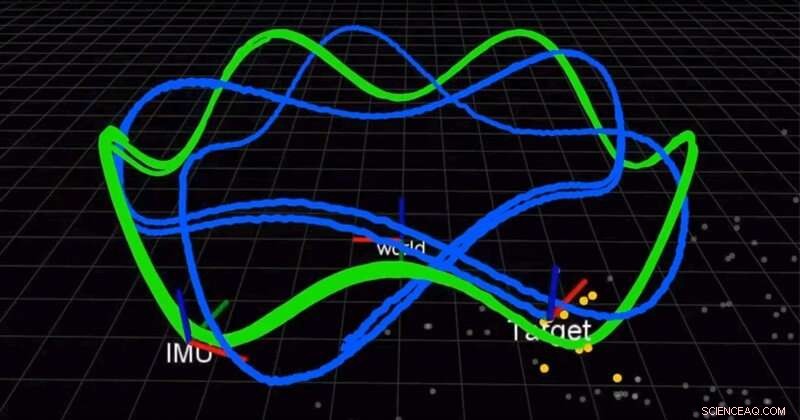

Het team gebruikt een camera en een traagheidsmeeteenheid (IMU) om tegelijkertijd een robot te lokaliseren en een bewegend doel te volgen. De groene lijn is de baan van de robot en de blauwe lijn is de baan van het doelwit. Krediet:Universiteit van Delaware

In een artikel dat eerder dit jaar in de International Journal of Robotics Research (IJRR), Huang en zijn team vonden een betere, nauwkeurigere oplossing voor het combineren van de traagheidsmetingen. Tot nu, wetenschappers gebruikten discrete integratie, een rekentechniek die het gebied onder een kromme benadert, oplossing benaderen. In plaats daarvan, De groep van Huang vond een oplossing en bewees dat deze beter was dan de bestaande methoden. Nog beter, ze delen hun oplossing.

"We openen onze code. Het staat op GitHub, " zei Huang. "Veel mensen hebben onze code voor hun systemen gebruikt." In een ander recent artikel van IJRR, Huang en zijn team herformuleerden het SLAM-probleem als een formule die kleine bewegingsstappen berekent door de robots die zijn uitgerust met de visuele en traagheidssensoren. Veel van deze onderzoeksvideo's zijn te vinden op het YouTube-kanaal van Huang's Lab.

Deze ontdekkingen kunnen toepassingen hebben die verder gaan dan autonome voertuigen, van auto's tot luchtdrones tot onderwaterschepen en meer. De algoritmen van Huang kunnen ook worden gebruikt om augmented reality- en virtual reality-toepassingen te ontwikkelen voor mobiele apparaten zoals smartphones, die al camera's en traagheidssensoren aan boord hebben.

"Deze sensoren zijn heel gebruikelijk, dus de meeste mobiele apparaten, smartphones, zelfs drones en voertuigen hebben deze sensoren, " zei Huang. "We proberen gebruik te maken van de bestaande goedkope sensoren en een lokalisatieoplossing te bieden, een oplossing voor het volgen van bewegingen."

In 2018 en opnieuw in 2019, Huang ontving een Google Daydream (AR/VR) Faculty Research Award om dit werk te ondersteunen.

"Mensen zien dat robots het volgende grote ding in het echte leven gaan worden, dus daarom is de industrie de drijvende kracht achter dit onderzoeksgebied, " zei Huang.

Microbiële cyborgs:bacteriën die energie leveren

Microbiële cyborgs:bacteriën die energie leveren Is methanol hetzelfde als methanol en isopropylalcohol?

Is methanol hetzelfde als methanol en isopropylalcohol?  Wetenschappers ontwikkelen innovatieve technieken voor analyse met hoge resolutie van hybride materialen

Wetenschappers ontwikkelen innovatieve technieken voor analyse met hoge resolutie van hybride materialen Films ontwikkelen met instelbare rek en breuk voor verschillende toepassingen

Films ontwikkelen met instelbare rek en breuk voor verschillende toepassingen Voedingswetenschappers creëren nieuwe magnetische nanodeeltjes voor snelle screening van bestrijdingsmiddelenresiduen in groenten

Voedingswetenschappers creëren nieuwe magnetische nanodeeltjes voor snelle screening van bestrijdingsmiddelenresiduen in groenten

Hoe micro-organismen ons kunnen helpen om negatieve uitstoot te verminderen

Hoe micro-organismen ons kunnen helpen om negatieve uitstoot te verminderen Kikkerfossielen vertellen ons iets nieuws over regenpatronen aan de westkust van Zuid-Afrika

Kikkerfossielen vertellen ons iets nieuws over regenpatronen aan de westkust van Zuid-Afrika Milieuproblemen in El Paso

Milieuproblemen in El Paso  NASA telt record regen in Australië op

NASA telt record regen in Australië op Meer intense bosbranden zijn hier om te blijven, en we moeten ons aanpassen, zegt verslag

Meer intense bosbranden zijn hier om te blijven, en we moeten ons aanpassen, zegt verslag

Hoofdlijnen

- Een zwaartekrachttheorie ontwikkelen voor ecologie

- Een diercel-diagram maken

- Hoe orchideeën werken

- Geen herten meer in de koplamp:onderzoek toont aan dat grote zoogdieren wel gebruik maken van wegkruisingsconstructies

- Wetenschappers identificeren het verband tussen licht en chloroplastontwikkeling

- Wetenschappers ontdekken methode om voedselverspilling om te zetten in biobrandstoffen

- De nadelen van biotechnologie

- 10 vreemdste bronnen voor antibiotica

- De effecten van zoutconcentratie op bacteriegroei

- Duitse crew stage demo op tweede dag van Lufthansa staking

- Slimme gadgets:manieren om privacy- en beveiligingsrisico's te minimaliseren

- Wetenschappers maken kunstmatig blad dat koolstof in brandstof verandert

- Zoekresultaten niet partijdig, Stanford studie vondsten

- Door batterijgevoede siliciumchips sneller en langer te laten werken

Facebook stelt politieke uitingen vrij van fact-checking

Facebook stelt politieke uitingen vrij van fact-checking Decennium van zware stormen heeft de gletsjers in het noordwesten geholpen, maar verwacht niet dat het zo blijft, onderzoeken tonen aan

Decennium van zware stormen heeft de gletsjers in het noordwesten geholpen, maar verwacht niet dat het zo blijft, onderzoeken tonen aan Het verhaal van Rum Jungle:een uraniummijn uit de Koude Oorlog die al tientallen jaren zuur in het milieu spuwt

Het verhaal van Rum Jungle:een uraniummijn uit de Koude Oorlog die al tientallen jaren zuur in het milieu spuwt Welke stoffen worden rood lakmoespapier blauw?

Welke stoffen worden rood lakmoespapier blauw?  Groot dipoolmoment geïnduceerd breedspectrum bismutchromaat voor efficiënte fotokatalytische prestaties

Groot dipoolmoment geïnduceerd breedspectrum bismutchromaat voor efficiënte fotokatalytische prestaties Welke menselijke activiteiten beïnvloeden de koolstofcyclus?

Welke menselijke activiteiten beïnvloeden de koolstofcyclus?  In Nigeria vervuild Ogoniland, tekenen van een opruiming

In Nigeria vervuild Ogoniland, tekenen van een opruiming Waarom je niet zomaar iets in de prullenbak kunt gooien

Waarom je niet zomaar iets in de prullenbak kunt gooien

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com