Wetenschap

Machines leren redeneren over wat ze zien

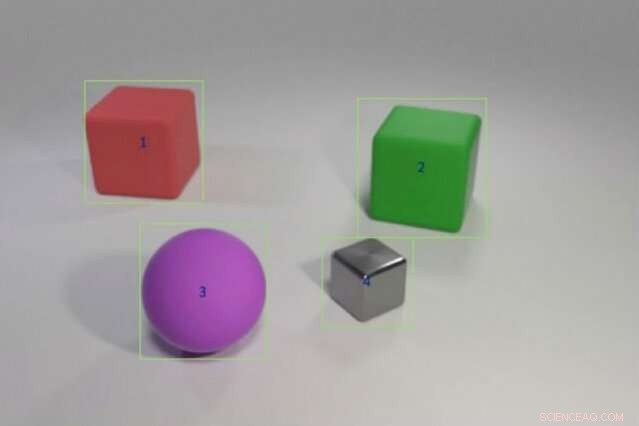

Onderzoekers hebben een hybride AI-model getraind om vragen te beantwoorden als "Heeft het rode object links van de groene kubus dezelfde vorm als het paarse, matte ding?" door het voorbeelden van objectkleuren en -vormen te geven, gevolgd door meer complexe scenario's met vergelijkingen tussen meerdere objecten. Het model zou deze kennis net zo goed of beter kunnen overbrengen naar nieuwe scenario's dan state-of-the-art modellen met een fractie van de trainingsgegevens. Krediet:Justin Johnson

Een kind dat nog nooit een roze olifant heeft gezien, kan er nog steeds een beschrijven - in tegenstelling tot een computer. "De computer leert van data, " zegt Jiajun Wu, een doctoraat student aan het MIT. "Het vermogen om iets te generaliseren en te herkennen dat je nog nooit eerder hebt gezien - een roze olifant - is erg moeilijk voor machines."

Deep learning-systemen interpreteren de wereld door statistische patronen in gegevens te ontdekken. Deze vorm van machine learning is nu overal, automatisch vrienden taggen op Facebook, Alexa's laatste weersvoorspelling vertellen, en het leveren van leuke weetjes via Google Zoeken. Maar statistisch leren heeft zijn grenzen. Het vereist tonnen gegevens, heeft moeite met het uitleggen van zijn beslissingen, en is verschrikkelijk in het toepassen van kennis uit het verleden op nieuwe situaties; Het kan een olifant niet begrijpen die roze is in plaats van grijs.

Om computers de mogelijkheid te geven om meer te redeneren zoals wij, kunstmatige intelligentie (AI) onderzoekers keren terug naar abstracte, of symbolisch, programmeren. Populair in de jaren 50 en 60, symbolische AI-draden in de regels en logica waarmee machines vergelijkingen kunnen maken en interpreteren hoe objecten en entiteiten zich verhouden. Symbolische AI gebruikt minder data, registreert de reeks stappen die nodig zijn om tot een beslissing te komen, en in combinatie met de brute verwerkingskracht van statistische neurale netwerken, het kan zelfs mensen verslaan in een ingewikkelde test voor het begrijpen van afbeeldingen.

Een nieuwe studie door een team van onderzoekers van MIT, MIT-IBM Watson AI Lab, en DeepMind toont de belofte van het samenvoegen van statistische en symbolische AI. Onder leiding van Wu en Joshua Tenenbaum, een professor in het MIT's Department of Brain and Cognitive Sciences en het Computer Science and Artificial Intelligence Laboratory, het team laat zien dat het hybride model objectgerelateerde concepten zoals kleur en vorm kan leren, en gebruik die kennis om complexe objectrelaties in een scène te interpreteren. Met minimale trainingsgegevens en geen expliciete programmering, hun model kon concepten overbrengen naar grotere scènes en steeds lastiger vragen beantwoorden, net zo goed of beter dan zijn ultramoderne collega's. Het team presenteert zijn resultaten op de International Conference on Learning Representations in mei.

"Een manier waarop kinderen concepten leren, is door woorden met afbeeldingen te verbinden, ", zegt hoofdauteur Jiayuan Mao van de studie, een student aan de Tsinghua University die als visiting fellow aan het MIT aan het project werkte. "Een machine die op dezelfde manier kan leren, heeft veel minder data nodig, en is beter in staat zijn kennis over te dragen naar nieuwe scenario's."

De studie is een sterk argument om terug te keren naar benaderingen met abstracte programma's, zegt Jacob Andreas, recent afgestudeerd aan de University of California in Berkeley, die dit najaar als universitair docent bij MIT begint en niet bij het werk betrokken was. "De truc, het blijkt, is om meer symbolische structuur toe te voegen, en om de neurale netwerken een weergave van de wereld te geven die is verdeeld in objecten en eigenschappen in plaats van het te voeden met onbewerkte beelden, "zegt hij. "Dit werk geeft ons inzicht in wat machines moeten begrijpen voordat het leren van talen mogelijk is."

Het team trainde hun model op afbeeldingen in combinatie met gerelateerde vragen en antwoorden, onderdeel van de CLEVR-beeldbegripstest die is ontwikkeld aan de Stanford University. Zoals het model leert, de vragen worden steeds moeilijker, van, "Wat is de kleur van het voorwerp?" naar "Hoeveel objecten bevinden zich beide rechts van de groene cilinder en hebben hetzelfde materiaal als de kleine blauwe bal?" Zodra concepten op objectniveau onder de knie zijn, het model vordert om te leren hoe objecten en hun eigenschappen aan elkaar te relateren.

Net als andere hybride AI-modellen, MIT werkt door de taak op te splitsen. Een waarnemingsmodule van neurale netwerken kraakt de pixels in elke afbeelding en brengt de objecten in kaart. Een taalmodule, ook gemaakt van neurale netten, haalt een betekenis uit de woorden in elke zin en creëert symbolische programma's, of instructies, die de machine vertellen hoe de vraag moet worden beantwoord. Een derde redeneermodule voert de symbolische programma's ter plaatse uit en geeft een antwoord, het model bijwerken wanneer het fouten maakt.

De sleutel tot de aanpak van het team is een waarnemingsmodule die het beeld vertaalt naar een objectgebaseerde representatie, waardoor de programma's gemakkelijker uit te voeren zijn. Ook uniek is wat ze curriculumleren noemen, of selectief het model trainen op concepten en scènes die steeds moeilijker worden. Het blijkt dat het op een logische manier invoeren van de machinegegevens, in plaats van lukraak, helpt het model sneller te leren en tegelijkertijd de nauwkeurigheid te verbeteren.

Als het model eenmaal een solide basis heeft, het kan nieuwe scènes en concepten interpreteren, en steeds moeilijkere vragen, bijna perfect. Gevraagd om een onbekende vraag te beantwoorden, zoals, 'Wat is de vorm van dat grote gele ding?' het presteerde beter dan zijn collega's in Stanford en het nabijgelegen MIT Lincoln Laboratory met een fractie van de gegevens.

Terwijl andere modellen trainden op de volledige CLEVR-dataset van 70, 000 afbeeldingen en 700, 000 vragen, het gebruikte MIT-IBM-model 5, 000 afbeeldingen en 100, 000 vragen. Omdat het model voortbouwde op eerder geleerde concepten, het absorbeerde de programma's die ten grondslag liggen aan elke vraag, het opleidingsproces te versnellen.

Hoewel statistisch, deep learning-modellen zijn nu ingebed in het dagelijks leven, een groot deel van hun besluitvormingsproces blijft aan het zicht onttrokken. Dit gebrek aan transparantie maakt het moeilijk om te anticiperen waar het systeem vatbaar is voor manipulatie, fout, of vooringenomenheid. Het toevoegen van een symbolische laag kan de zwarte doos openen, wat de groeiende belangstelling voor hybride AI-systemen verklaart.

"De taak opsplitsen en programma's een deel van het werk laten doen, is de sleutel tot het inbouwen van interpreteerbaarheid in deep learning-modellen, " zegt Lincoln Laboratory-onderzoeker David Mascharka, wiens hybride model, Transparantie door Design Network, wordt gebenchmarkt in de MIT-IBM-studie.

Het MIT-IBM-team werkt nu aan het verbeteren van de prestaties van het model op foto's uit de echte wereld en uitbreiden naar video-begrip en robotmanipulatie. Andere auteurs van de studie zijn Chuang Gan en Pushmeet Kohli, onderzoekers van het MIT-IBM Watson AI Lab en DeepMind, respectievelijk.

Dit verhaal is opnieuw gepubliceerd met dank aan MIT News (web.mit.edu/newsoffice/), een populaire site met nieuws over MIT-onderzoek, innovatie en onderwijs.

Een nieuwe tool om chemische complexiteit te creëren uit vetzuren

Een nieuwe tool om chemische complexiteit te creëren uit vetzuren Wetenschapsprojecten op gebotteld water vs. Tik op Water

Wetenschapsprojecten op gebotteld water vs. Tik op Water Herziening van de rol van planten in antibacteriële activiteit maakt nieuwe paden vrij voor het ontdekken van geneesmiddelen

Herziening van de rol van planten in antibacteriële activiteit maakt nieuwe paden vrij voor het ontdekken van geneesmiddelen Verbetering van de kristalgroei met behulp van polyelektrolytoplossingen en afschuifstroming

Verbetering van de kristalgroei met behulp van polyelektrolytoplossingen en afschuifstroming Voor altijd vechten tegen chemicaliën met microben

Voor altijd vechten tegen chemicaliën met microben

Greta Thunberg:het jeugdige klimaatgeweten ter wereld

Greta Thunberg:het jeugdige klimaatgeweten ter wereld Wat kunnen we leren door fossielen te bestuderen?

Wat kunnen we leren door fossielen te bestuderen?  Om het leven op aarde te redden, hier is de oplossing van $ 100 miljard per jaar

Om het leven op aarde te redden, hier is de oplossing van $ 100 miljard per jaar Hoeveel grond verdwijnt in de afvoer - nieuwe gegevens over bodem die verloren is gegaan door water

Hoeveel grond verdwijnt in de afvoer - nieuwe gegevens over bodem die verloren is gegaan door water Afwegingen tussen voedselzekerheid en klimaatmitigatie

Afwegingen tussen voedselzekerheid en klimaatmitigatie

Hoofdlijnen

- Wat zijn de functies van microfilamenten en microtubuli?

- Hoe het Curiosity-project werkt

- Genoomanalyse van vroege plantenafstamming werpt licht op hoe planten leerden te gedijen op het land

- Nieuwe mechanismen ontdekt die bacteriën gebruiken om zichzelf te beschermen tegen antibiotica

- 6 soorten vrij beweegbare gewrichten

- Hoe ziet een door vrouwen gerunde samenleving eruit?

- Matchmaking met gevolgen

- Wetenschappers ontwikkelen aardnoot die resistent is tegen aflatoxine

- Australische hagedissen eisen tol van schildpadeieren

Het mysterie,

Het mysterie,  Hoe werkt een torsieveer?

Hoe werkt een torsieveer?  Kwantumsystemen:hetzelfde, maar anders

Kwantumsystemen:hetzelfde, maar anders Mini-turbinewindbomen kunnen stroom opwekken voor huizen,

Mini-turbinewindbomen kunnen stroom opwekken voor huizen,  Wat voor soort boonzaad te gebruiken voor een wetenschappelijk experiment

Wat voor soort boonzaad te gebruiken voor een wetenschappelijk experiment De chemicaliën in zout, peper en suiker

De chemicaliën in zout, peper en suiker  Boodschappen laten bezorgen, zonder menselijke chauffeurs, is onderweg

Boodschappen laten bezorgen, zonder menselijke chauffeurs, is onderweg ExoMars ziet unieke groene gloed op de Rode Planeet

ExoMars ziet unieke groene gloed op de Rode Planeet

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com