Wetenschap

Big Brother-gezichtsherkenning heeft ethische voorschriften nodig

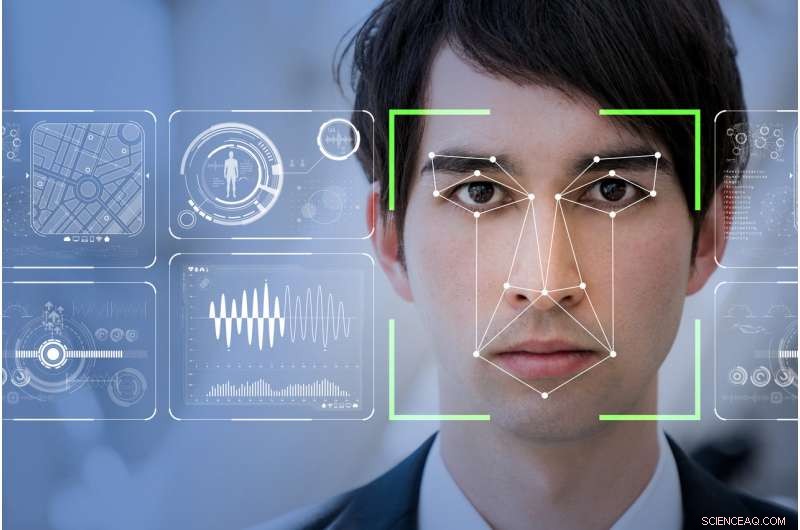

Zal gezichtsherkenningssoftware de wereld veiliger maken, zoals technologiebedrijven beweren, of zal het de gemarginaliseerden kwetsbaarder en gecontroleerder maken? Krediet:Shutterstock

Mijn moeder zei altijd dat ik een gezicht had voor radio. Godzijdank, aangezien radio misschien wel de laatste plaats is in deze door technologie verbeterde wereld waar je gezicht je sociale status of potentieel om een misdaad te plegen niet bepaalt.

Echte Netwerken, de wereldleider van een technologie die de naadloze digitale levering van audio- en videobestanden via internet mogelijk maakt, heeft zojuist zijn nieuwste computervisie uitgebracht:een softwarepakket voor machine learning. De hoop is dat deze nieuwe software zal detecteren, en mogelijk voorspellen, verdacht gedrag door gezichtsherkenning.

genaamd SAFR (Veilig, nauwkeurige gezichtsherkenning), de toolset is op de markt gebracht als een kosteneffectieve manier om soepel op te gaan in bestaande CCTV-videobewakingssystemen. Het zal in staat zijn om "miljoenen gezichten in realtime te detecteren en te matchen, "specifiek binnen schoolomgevingen.

Ogenschijnlijk, RealNetworks ziet zijn technologie als iets dat de wereld veiliger kan maken. De pakkende branding, echter, maskeert de echte ethische kwesties rond de inzet van gezichtsdetectiesystemen. Sommige van die problemen omvatten vragen over de inherente vooroordelen die zijn ingebed in de code en, uiteindelijk, hoe die vastgelegde gegevens worden gebruikt.

Het Chinese model

Grote Broer kijkt toe. Geen enkel ander land ter wereld heeft meer videobewaking dan China. Met 170 miljoen CCTV-camera's en zo'n 400 miljoen nieuwe geïnstalleerd, het is een land dat gezichtsherkenning op Orwelliaanse wijze heeft overgenomen en ingezet.

In de nabije toekomst, zijn burgers, en degenen onder ons die daarheen reizen, zullen worden blootgesteld aan een uitgebreid en geïntegreerd netwerk van gezichtsherkenningssystemen die alles controleren, van het gebruik van het openbaar vervoer, te versnellen tot hoeveel toiletpapier men in het openbare toilet gebruikt.

Het meest verontrustende element tot nu toe is de recente introductie van gezichtsherkenning om het gedrag van schoolkinderen op Chinese openbare scholen te volgen.

Als onderdeel van China's volledige integratie van hun al even Orwelliaanse sociale kredietsysteem - een stimuleringsprogramma dat de toewijding van elke burger aan de door de staat opgelegde moraal beloont - zal dit volledig geïntegreerde digitale systeem automatisch een persoon identificeren. Het kan dan iemands vermogen bepalen om vooruitgang te boeken in de samenleving - en bij uitbreiding de economische en sociale status van die persoon in de directe familie - door toezicht te houden op het niet-gesanctioneerde gedrag van de staat.

In essentie, gezichtsherkenning maakt het onmogelijk voor degenen die worden blootgesteld om de luxe te hebben een slechte dag te hebben.

Gezichtsherkenningssystemen die nu in Chinese scholen worden ingezet, houden alles in de gaten, van het aanwezig zijn in de klas tot of een kind aan het dagdromen is of oplet. Het is een volledig monitoringsysteem dat bepaalt, grotendeels, de toekomst van een kind zonder rekening te houden met het feit dat sommige kwaliteiten, zoals abstract denken, niet gemakkelijk kunnen worden gedetecteerd of op zijn best, gunstig bekeken, met gezichtsherkenning.

Het roept ook enkele zeer ongemakkelijke noties op van ethiek of het gebrek daaraan, vooral naar meer kwetsbare leden van de samenleving.

Behoefte aan openbare regelgeving

De lancering van SAFR door RealNetworks komt vlak op de hielen van het gepassioneerde manifest van Microsoft-president Brad Smith over de noodzaak van publieke regulering en maatschappelijk verantwoord ondernemen bij de ontwikkeling en toepassing van gezichtsherkenningstechnologie.

Smith wees er terecht op dat gezichtsherkenningstools nog steeds enigszins scheef zijn en "grotere foutenpercentages hebben voor vrouwen en mensen van kleur". Dit probleem is tweeledig, met een erkenning dat de mensen die coderen onbewust culturele vooroordelen kunnen insluiten.

De momenteel beschikbare datasets hebben mogelijk niet de objectieve robuustheid die nodig is om ervoor te zorgen dat de gezichten van mensen niet verkeerd worden geïdentificeerd, of nog erger, vooraf bepaald door gecodeerde vooringenomenheid, zoals nu begint te gebeuren in het Chinese schoolsysteem.

In een poging om dit en talloze andere gerelateerde problemen aan te pakken, Microsoft heeft een AI and Ethics in Engineering and Research (AETHER)-commissie opgericht. Dit comité is ook opgericht om hen te helpen te voldoen aan de nieuw afgedwongen Algemene Verordening Gegevensbescherming (AVG) van de Europese Unie en de eventuele toekomstige goedkeuring ervan, in een of andere vorm, in Noord-Amerika.

De vurige oproep van Smith stelt terecht vraagtekens bij het huidige en toekomstige beoogde gebruik en gebruik van gezichtsherkenningssystemen, maar verzuimt in te gaan op hoe Microsoft of, door verlenging, andere leiders op het gebied van AI-technologie, kunnen vooroordelen in hun basiscode of datasets vanaf het begin elimineren.

Minderheidsverslag

De trekken van ons gezicht zijn nauwelijks meer dan gebaren die gewoontekracht permanent heeft gemaakt .-Marcel Proust, 1919

Zoals veel technologieën, Pandora heeft de doos al verlaten. Als u een smartphone heeft en internet gebruikt, je hebt je al afgemeld voor alle basisbegrippen van persoonlijke anonimiteit in de westerse samenleving.

Nu de AVG nu volledig actief is in Europa, Als u een website bezoekt, moet u zich nu "aanmelden" voor de mogelijkheid dat die website persoonlijke gegevens verzamelt. Gezichtsherkenningssystemen kunnen de AVG-regels niet volgen, dus als zodanig, wij als samenleving zijn automatisch "opted-in" en dus volledig overgeleverd aan hoe onze gezichten worden opgenomen, verwerkt en opgeslagen door de overheid, bedrijfs- of zelfs particulier gebruikte CCTV-systemen.

Gezichtsherkenningsproeven die in Engeland zijn gehouden door de Londense Metropolitan Police hebben consequent een mislukkingspercentage van 98 procent opgeleverd. evenzo, in Zuidwest-Wales, tests hebben het slechts iets beter gedaan met minder dan 10 procent succes.

Omgekeerd, Universiteit van Californië, Berkeley, wetenschappers hebben geconcludeerd dat substantiële gezichtsvariatie een evolutionaire eigenschap is die uniek is voor de mens. Dus waar is de ontkoppeling?

Als, zoals Marcel Proust heeft gesuggereerd, ons leven en dus onze persoonlijkheden zijn uniek te herkennen aan onze gezichten, waarom kunnen gezichtsherkenningssystemen niet gemakkelijk positieve resultaten opleveren?

Het antwoord gaat terug naar hoe computerprogrammering is geschreven en de datasets die door die code worden gebruikt om een positieve overeenkomst te retourneren. onvermijdelijk, code is geschreven om een geïdealiseerde notie van gezichtstype te ondersteunen.

Als zodanig, uiterlijke variaties zoals natuurlijk voorkomende gezichtsmisvormingen of gelaatstrekken die zijn aangetast door fysiek of mentaal trauma vertegenwoordigen slechts een klein deel van de oneindige mogelijke gezichtsvariaties in de wereld. De datasets gaan ervan uit dat we homogene dubbelgangers van elkaar zijn, without addressing the micro-variations of peoples faces.

If that's the case, we are all subject to the possibility that our faces as interpreted by the ever-increasing deployment of immature facial recognition systems will betray the reality of who we are.

Dit artikel is oorspronkelijk gepubliceerd op The Conversation. Lees het originele artikel.

Hoe subatomaire deeltjes te berekenen

Hoe subatomaire deeltjes te berekenen Onderzoekers rapporteren bio-geïnspireerde selectieve antibiotica

Onderzoekers rapporteren bio-geïnspireerde selectieve antibiotica Wat zit er in maïssiroop dat een bubbel maakt?

Wat zit er in maïssiroop dat een bubbel maakt?  Duurzame sterk geleidende elektrodematerialen van ultradunne koolstof nanovezel aerogels afgeleid van nanofibrillated

Duurzame sterk geleidende elektrodematerialen van ultradunne koolstof nanovezel aerogels afgeleid van nanofibrillated Kleine filters helpen bij het opsporen van kankerachtige bloedcellen

Kleine filters helpen bij het opsporen van kankerachtige bloedcellen

Team ontdekt verband tussen rook van bosbranden, vervuilingsgebeurtenissen

Team ontdekt verband tussen rook van bosbranden, vervuilingsgebeurtenissen NASA stelt composiet samen van tropische storm Kong-Rey

NASA stelt composiet samen van tropische storm Kong-Rey Trump keurt Keystone XL-pijplijn goed fijne dag voor klussen

Trump keurt Keystone XL-pijplijn goed fijne dag voor klussen NASA analyseert nieuwe Atlantische depressies tropische regenval

NASA analyseert nieuwe Atlantische depressies tropische regenval Er zijn aanwijzingen dat er meer megadroogtes komen

Er zijn aanwijzingen dat er meer megadroogtes komen

Hoofdlijnen

- Ingenieurs hacken celbiologie om 3D-vormen te maken van levend weefsel

- De voordelen van Sticky End Enzymen

- Resultaten van Landmark NASA DNA Twin Study zijn binnen

- Overeenkomsten van de mitochondria en nucleus

- Wat zijn schadelijke genen?

- De rol van microben in de industrie

- Eerste Amerikaanse vrouw bevalt van getransplanteerde baarmoeder

- Wanneer wordt een mutatie in een DNA-molecuul doorgegeven aan nakomelingen?

- Welke sequenties zorgen ervoor dat DNA uitpakt en ademt?

- Canadees legioen vraagt Fortnite-gamers om pauze om oorlogsslachtoffers te eren

- Een vinger aan de pols van sensorontwikkelingen

- Moet u zich zorgen maken over Boeing 737's? Alleen als u een luchtvaartmaatschappij runt

- Berlijnse beurs een droomland voor wannabe zandmannen van slaaptechnologie

- Hotelkamers per uur of per minuut

Oedogonium Life Cycle

Oedogonium Life Cycle Hoe maak je een 12 Volt Heater

Hoe maak je een 12 Volt Heater Aanvullende Arctische weergegevens verhogen de voorspellingsnauwkeurigheid van koude golven in Japan

Aanvullende Arctische weergegevens verhogen de voorspellingsnauwkeurigheid van koude golven in Japan Kiezers belonen - of straffen - gevestigde schoolbestuurders op basis van de prestaties van blanke studenten

Kiezers belonen - of straffen - gevestigde schoolbestuurders op basis van de prestaties van blanke studenten De weg naar nul uitstoot begint eenvoudig, maar wordt steil

De weg naar nul uitstoot begint eenvoudig, maar wordt steil Geneesmiddelenresistentie bestrijden met snelle, kunstmatige verbetering van natuurlijke producten

Geneesmiddelenresistentie bestrijden met snelle, kunstmatige verbetering van natuurlijke producten 3D-geprint gereedschap snijdt door titanium, wint innovatieprijs

3D-geprint gereedschap snijdt door titanium, wint innovatieprijs Physical Geography Dissertation Ideas

Physical Geography Dissertation Ideas

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | Italian |

-

Wetenschap © https://nl.scienceaq.com