Wetenschap

Vraag en antwoord:Expert legt de fysica van AI uit

De ontwikkeling van een nieuwe theorie wordt doorgaans geassocieerd met de groten van de natuurkunde. Je zou bijvoorbeeld kunnen denken aan Isaac Newton of Albert Einstein. Er zijn al veel Nobelprijzen toegekend voor nieuwe theorieën.

Onderzoekers van Forschungszentrum Jülich hebben nu een kunstmatige intelligentie geprogrammeerd die deze prestatie ook beheerst. Hun AI is in staat patronen in complexe datasets te herkennen en deze te formuleren in een natuurkundige theorie. De bevindingen zijn gepubliceerd in het tijdschrift Physical Review X .

In het volgende interview legt prof. Moritz Helias van het Forschungszentrum Jülich's Institute for Advanced Simulation (IAS-6) uit waar de "Physics of AI" over gaat en in welke mate deze verschilt van conventionele benaderingen.

Hoe komen natuurkundigen met een nieuwe theorie?

Meestal begin je met observaties van het systeem voordat je probeert voor te stellen hoe de verschillende systeemcomponenten met elkaar omgaan om het waargenomen gedrag te verklaren. Hieruit worden vervolgens nieuwe voorspellingen afgeleid en op de proef gesteld.

Een bekend voorbeeld is de zwaartekrachtwet van Isaac Newton. Het beschrijft niet alleen de zwaartekracht op aarde, maar kan ook worden gebruikt om de bewegingen van planeten, manen en kometen, evenals de banen van moderne satellieten, redelijk nauwkeurig te voorspellen.

De manier waarop dergelijke hypothesen worden bereikt, verschilt echter altijd. Je kunt beginnen met algemene principes en basisvergelijkingen van de natuurkunde en daaruit de hypothese afleiden, of je kunt kiezen voor een fenomenologische benadering, waarbij je je beperkt tot het zo nauwkeurig mogelijk beschrijven van waarnemingen zonder de oorzaken ervan uit te leggen. De moeilijkheid ligt in het selecteren van een goede aanpak uit de vele mogelijke benaderingen, het indien nodig aanpassen en vereenvoudigen ervan.

Welke aanpak hanteert u met AI?

Over het algemeen gaat het om een aanpak die bekend staat als 'fysica voor machinaal leren'. In onze werkgroep gebruiken we natuurkundige methoden om de complexe functie van een AI te analyseren en te begrijpen.

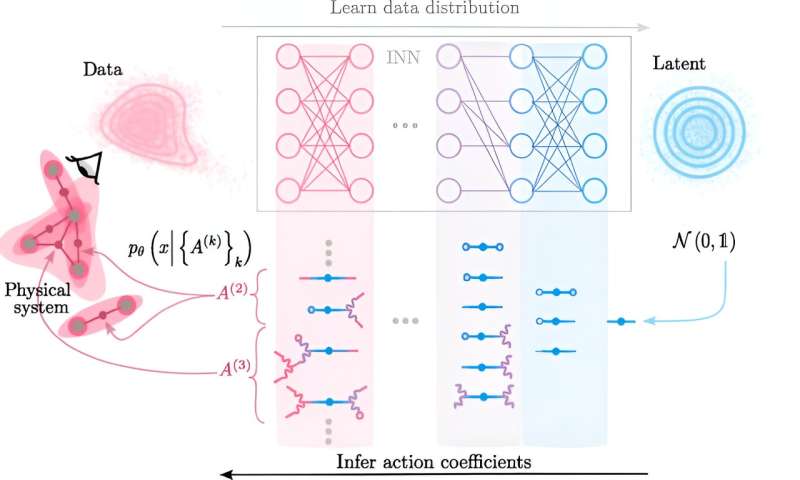

Het cruciale nieuwe idee ontwikkeld door Claudia Merger van onze onderzoeksgroep was om eerst een neuraal netwerk te gebruiken dat leert het waargenomen complexe gedrag nauwkeurig in kaart te brengen naar een eenvoudiger systeem. Met andere woorden:de AI heeft tot doel alle complexe interacties die we waarnemen tussen systeemcomponenten te vereenvoudigen. Vervolgens gebruiken we het vereenvoudigde systeem en creëren we een inverse mapping met de getrainde AI. Als we terugkeren van het vereenvoudigde systeem naar het complexe systeem, ontwikkelen we vervolgens de nieuwe theorie.

Op de terugweg worden de complexe interacties stukje bij beetje opgebouwd uit de vereenvoudigde. Uiteindelijk verschilt de aanpak dus niet zoveel van die van een natuurkundige, met als verschil dat de manier waarop de interacties tot stand komen nu wordt afgelezen uit de parameters van de AI. Dit perspectief op de wereld – dat wordt verklaard vanuit interacties tussen de verschillende delen ervan die bepaalde wetten volgen – is de basis van de natuurkunde, vandaar de term 'fysica van AI'.

In welke toepassingen werd AI gebruikt?

We gebruikten bijvoorbeeld een dataset van zwart-witafbeeldingen met handgeschreven cijfers, die vaak wordt gebruikt in onderzoek bij het werken met neurale netwerken. Als onderdeel van haar proefschrift onderzocht Claudia Merger hoe kleine substructuren in de beelden, zoals de randen van de cijfers, zijn opgebouwd uit interacties tussen pixels. Er worden groepen pixels gevonden die samen helderder zijn en zo bijdragen aan de vorm van de rand van het getal.

Hoe hoog is de rekeninspanning?

Het gebruik van AI is een truc die de berekeningen überhaupt mogelijk maakt. Je bereikt heel snel een zeer groot aantal mogelijke interacties. Zonder deze truc zou je alleen maar naar hele kleine systemen kunnen kijken. Niettemin is de benodigde rekeninspanning nog steeds hoog, wat te wijten is aan het feit dat er veel mogelijke interacties zijn, zelfs in systemen met veel componenten.

We kunnen deze interacties echter efficiënt parametriseren, zodat we nu systemen kunnen bekijken met ongeveer 1.000 op elkaar inwerkende componenten, dat wil zeggen beeldgebieden met maximaal 1.000 pixels. In de toekomst moeten door verdere optimalisatie ook veel grotere systemen mogelijk zijn.

Hoe verschilt deze aanpak van andere AI's zoals ChatGPT?

Veel AI's streven ernaar een theorie te leren over de gegevens die worden gebruikt om de AI te trainen. De theorieën die de AI’s leren, kunnen echter meestal niet worden geïnterpreteerd. In plaats daarvan worden ze impliciet verborgen in de parameters van de getrainde AI. Onze aanpak daarentegen haalt de geleerde theorie eruit en formuleert deze in de taal van interacties tussen systeemcomponenten, die ten grondslag ligt aan de natuurkunde.

Het behoort dus tot het gebied van de verklaarbare AI, met name de ‘fysica van AI’, aangezien we de taal van de natuurkunde gebruiken om uit te leggen wat de AI heeft geleerd. We kunnen de taal van interacties gebruiken om een brug te slaan tussen de complexe innerlijke werking van AI en theorieën die mensen kunnen begrijpen.

Meer informatie: Claudia Merger et al., Interacterende theorieën leren uit gegevens, Fysieke recensie X (2023). DOI:10.1103/PhysRevX.13.041033

Aangeboden door Forschungszentrum Juelich

Knijp er gewoon in - onderzoekers ontdekken wanneer ruimtes krap zijn, de natuur versoepelt haar wetten

Knijp er gewoon in - onderzoekers ontdekken wanneer ruimtes krap zijn, de natuur versoepelt haar wetten Door grote stille genen op te heffen, kunnen bacteriën nieuwe moleculen produceren, potentiële kandidaat-geneesmiddelen

Door grote stille genen op te heffen, kunnen bacteriën nieuwe moleculen produceren, potentiële kandidaat-geneesmiddelen Mijn ambitie? Nog een Nobelprijs zegt scheikunde laureaat

Mijn ambitie? Nog een Nobelprijs zegt scheikunde laureaat Stikstof verminderen met boor en bier

Stikstof verminderen met boor en bier Drugsspons kan bijwerkingen van kankerbehandeling minimaliseren

Drugsspons kan bijwerkingen van kankerbehandeling minimaliseren

Colorado natuurlijke hulpbronnen

Colorado natuurlijke hulpbronnen  Krachtige wind blaast vlammen op terwijl historische brand in Californië zich uitbreidt

Krachtige wind blaast vlammen op terwijl historische brand in Californië zich uitbreidt Informatie over de vier regio's in Californië

Informatie over de vier regio's in Californië Branden niet de enige bedreiging voor Amazon

Branden niet de enige bedreiging voor Amazon Complexe modellering door onderzoekers voorspelt dat bosbranden uiteindelijk kunnen afnemen

Complexe modellering door onderzoekers voorspelt dat bosbranden uiteindelijk kunnen afnemen

Hoofdlijnen

- Niet genoeg:bescherming van algenetende vissen onvoldoende om bedreigde koraalriffen te redden, concludeert studie

- Burgerwetenschappers helpen bij het vastleggen van wilde zoogdieren op camera

- Wereldwijde explosie van wegenbouw kan rampzalig zijn voor mens en natuur, zeggen wetenschappers

- Waarom blozen mensen?

- Het ontrafelen van de metabolische mysteries van grasmatten onder hittestress

- Wat is er nodig om de regent-honingeter te redden?

- Super Invader Tree treft Zuid, maar de vlooienkever kan een held zijn

- Nieuw model bevestigt dat bedreigde rechtse walvissen afnemen

- Kenmerken uit meerdere bronnen van de strategie voor het gebruik van gewaswater in extreem droge gebieden

- Ultrasnelle intra-atoombeweging gevolgd met behulp van synchrotronstraling

- Tijd bestaat misschien niet, volgens natuurkundigen en filosofen, maar dat geeft niet

- Kalibratiemethode verbetert wetenschappelijk onderzoek met smartphonecamera's

- SLAC maakt elektronencamera, een hulpmiddel van wereldklasse voor ultrasnelle wetenschap, beschikbaar voor wetenschappers over de hele wereld

- Ultrasnelle elektronenmeting levert belangrijke bevindingen op voor de zonne-industrie

Oost- en Centraal-China worden helderder door actie met schone lucht

Oost- en Centraal-China worden helderder door actie met schone lucht Geloof in 5G COVID-19-complottheorieën in verband met geweld, onthult studie

Geloof in 5G COVID-19-complottheorieën in verband met geweld, onthult studie Human Anatomy Projects

Human Anatomy Projects  Deze AI-vogelaar laat je kijken door de ogen van een machine

Deze AI-vogelaar laat je kijken door de ogen van een machine 3D-navigatietool onder MESSENGER's uiteindelijke leveringsproducten aan het planetaire gegevenssysteem

3D-navigatietool onder MESSENGER's uiteindelijke leveringsproducten aan het planetaire gegevenssysteem Micro-organismen inzetten voor slimme microsystemen

Micro-organismen inzetten voor slimme microsystemen Snelle detectie van toxische verbindingen

Snelle detectie van toxische verbindingen Onderzoek:de sleutel voor stevig bestuur als aandeelhouders het risico van politieke activiteiten inschatten

Onderzoek:de sleutel voor stevig bestuur als aandeelhouders het risico van politieke activiteiten inschatten

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com