Wetenschap

Grafische kaartenboerderij om te helpen bij het zoeken naar nieuwe fysica bij LHCb

Krediet:CC0 Publiek Domein

Voor de eerste keer, gegevens van LHCb, een groot natuurkundig experiment, zal worden verwerkt op een boerderij van GPU's. Deze oplossing is niet alleen veel goedkoper, maar het zal helpen de clustergrootte te verkleinen en data te verwerken met snelheden tot 40 Tbit/s. Het onderzoekspaper is gepubliceerd in Informatica en software voor grote wetenschap .

Een interdisciplinaire taskforce van onderzoekers van een van de grootste internationale samenwerkingsverbanden op het gebied van hoge-energiefysica LHC Beauty bij CERN heeft een nieuwe manier voorgesteld om de enorme gegevensstroom van de deeltjesdetector te verwerken. Het team bestaat uit onderzoekers van vooraanstaande Europese en Amerikaanse universiteiten. Het Russische deel van het team werd vertegenwoordigd door HSE en Yandex School of data-analyse. Het hoofddoel van het voorstel is om de samenwerking te voorzien van een robuust, efficiënte en flexibele oplossing die kan omgaan met de verwachte verhoogde gegevensstroom tijdens de komende periode van gegevensverzameling. Deze oplossing is niet alleen veel goedkoper, maar het zal helpen de clustergrootte te verkleinen en data te verwerken met snelheden tot 40 Tbit/s.

De LHC en LHCb in het bijzonder zijn gemaakt met het doel om te zoeken naar "nieuwe fysica, " iets dat verder gaat dan het standaardmodel. Hoewel het onderzoek matig succes heeft behaald, hoop volledig nieuwe deeltjes te vinden, zoals WIMP's, hebben gefaald. Veel natuurkundigen zijn van mening dat om nieuwe resultaten te bereiken, statistieken over deeltjesbotsingen bij de LHC moeten aanzienlijk worden verhoogd. Maar dit vereist niet alleen nieuwe versnellingsapparatuur - upgrades zijn momenteel aan de gang en moeten tegen 2021-2022 worden voltooid - maar ook gloednieuwe systemen om gegevens over botsingen met deeltjes te verwerken. Om de gebeurtenissen op LHCb als correct geregistreerd te detecteren, het gereconstrueerde spoor moet overeenkomen met het spoor dat door het algoritme is gemodelleerd. Als er geen match is, de gegevens zijn uitgesloten. Ongeveer 70% van alle botsingen in de LHC wordt op deze manier uitgesloten, wat betekent dat voor deze vooranalyse serieuze rekencapaciteiten nodig zijn.

Een groep onderzoekers, waaronder Andrey Ustyuzhanin, Mikhail Belous en Sergei Popov van HSE University, presenteerde een nieuw artikel met een algoritme van een boerderij van GPU's als een eerste trigger op hoog niveau (HLT1) voor gebeurtenisregistratie en detectie op de LHCb-detector. Het concept heeft de naam Allen gekregen, na Frances Allen, een onderzoeker in computationele systeemtheorie en de eerste vrouw die de Turing Award ontving.

In tegenstelling tot eerdere triggers, het nieuwe systeem brengt gegevens over van CPU's naar GPU's. Dit kunnen zowel professionele oplossingen zijn (zoals Tesla GPU's, de meest geavanceerde op de markt) en gewone "gamer" GPU's van NVIDIA of AMD. Dankzij dit, de Allen-trigger is niet afhankelijk van één specifieke leverancier van apparatuur, wat het creëren vergemakkelijkt en de kosten verlaagt. Met de meest performante systemen, de trigger kan gegevens verwerken tot 40 Tbit/s.

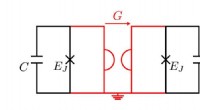

In een standaardschema is informatie over alle gebeurtenissen gaat van de detector naar een nul-niveau (L0) trigger, die bestaat uit programmeerbare chips (FPGA). Zij voeren selectie uit op basisniveau. In de nieuwe regeling er zal geen L0-trigger zijn. De gegevens gaan direct naar de boerderij, waarbij elk van de 300 GPU's tegelijkertijd miljoenen gebeurtenissen per seconde verwerkt.

Na de eerste gebeurtenisregistratie en -detectie, alleen de geselecteerde gegevens met waardevolle fysieke informatie gaan naar gewone x86-processors van triggers op het tweede niveau (HLT2). Dit betekent dat de belangrijkste rekenbelasting met betrekking tot gebeurtenisclassificatie uitzonderlijk op de boerderij plaatsvindt door middel van GPU's.

Dit raamwerk helpt bij het effectiever oplossen van de gebeurtenisanalyse- en selectietaken:GPU's worden in eerste instantie gemaakt als een meerkanaals systeem met meerdere kernen. En terwijl CPU's zijn gericht op opeenvolgende informatieverwerking, GPU's worden gebruikt voor massale gelijktijdige berekeningen. In aanvulling, ze hebben een meer specifieke en beperkte reeks taken, wat bijdraagt aan de prestaties.

Volgens Dennis Derkach hoofd van het LHCb-team van HSE University, dankzij de beslissing om geen CPU's te gebruiken, het nieuwe bedrijf is zeer geschikt voor toekomstige LHCb-gegevens. In aanvulling, Allen kost aanzienlijk minder dan een vergelijkbaar systeem op CPU's. Het zal ook eenvoudiger zijn dan de vorige evenementregistratiesystemen bij accelerators.

Vooral het langetermijnvoordeel van de nieuwe aanpak is belangrijk. Apparatuur voor veel natuurkundige experimenten wordt momenteel over de hele wereld geüpgraded. En vrijwel elke dergelijke upgrade leidt tot een groeiende stroom van verwerkte informatie. Eerder, experimenten maakten uitzonderlijk geen gebruik van systemen op basis van GPU's. Maar de voordelen van Allen - een eenvoudigere architectuur en lagere kosten - zijn zo duidelijk dat deze aanpak ongetwijfeld het voortouw zal nemen buiten het LHCb-experiment.

Hoofdlijnen

- Tropische diversiteit wortelt in relaties tussen schimmels en zaden

- Bijt hierop:onderzoeker ontdekt dat alligators haaien eten

- Dit is het seizoen om waakzaam te zijn:het risico op chocoladevergiftiging bij honden piekt met Kerstmis

- Een geslacht van Europese papierwespen voor het eerst herzien met behulp van integratieve taxonomie

- Wat is een interne regulator van de celcyclus?

- Gentherapie biedt langdurige behandeling voor muizen met diabetes

- Wat zijn sommige Cell Organelle-analogieën?

- 25 soorten onthuld voor 25 Genomes Project

- Kan een genetische test uitwijzen dat je chocolade-ijs lekker zult vinden?

- Onzichtbare tags:natuurkundigen schrijven, lezen en wissen met licht

- Nieuwe diamant harder dan een juweliersdiamant, snijdt door ultravaste materialen

- Onderzoekers observeren voor het eerst vertakte lichtstroom

- Natuurkundigen onderzoeken fundamentele limieten van kwantummotoren

- Blauwdruk voor fouttolerante qubits

Gepersonaliseerde social engineering

Gepersonaliseerde social engineering Kikkerfossielen vertellen ons iets nieuws over regenpatronen aan de westkust van Zuid-Afrika

Kikkerfossielen vertellen ons iets nieuws over regenpatronen aan de westkust van Zuid-Afrika De lijst met nuttige insecten

De lijst met nuttige insecten Luchtkwaliteit verbeterd tijdens lockdown in India, studie toont

Luchtkwaliteit verbeterd tijdens lockdown in India, studie toont Statistische techniek voor het automatisch opschonen van foutieve gegevens van weerballonwaarnemingen

Statistische techniek voor het automatisch opschonen van foutieve gegevens van weerballonwaarnemingen Eriochrome Black T Solution Preparation

Eriochrome Black T Solution Preparation  Nieuwe online tool om bewoners te helpen de impact van verkeersgerelateerde luchtvervuiling te verminderen

Nieuwe online tool om bewoners te helpen de impact van verkeersgerelateerde luchtvervuiling te verminderen Methoden voor machinaal leren bieden nieuwe inzichten in organisch-anorganische interfaces

Methoden voor machinaal leren bieden nieuwe inzichten in organisch-anorganische interfaces

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com