Wetenschap

Een blik in de toekomst:versneld computergebruik voor versnelde deeltjes

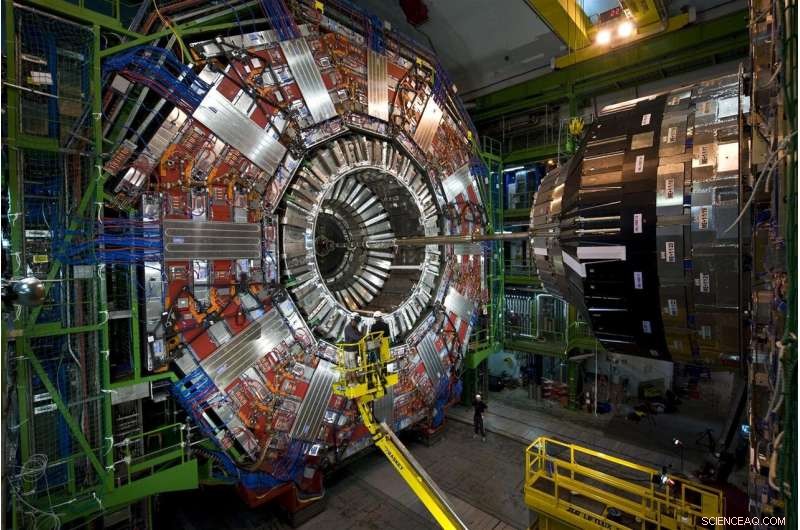

Deeltjes die voortkomen uit protonbotsingen bij CERN's Large Hadron Collider reizen door deze verhalenhoge, veellagig instrument, de CMS-detector. in 2026, de LHC zal 20 keer zoveel data produceren als nu, en CMS ondergaat momenteel upgrades om de gegevensstroom te lezen en te verwerken. Krediet:Maximilien Brice, CERN

Elke protonbotsing bij de Large Hadron Collider is anders, maar slechts enkele zijn speciaal. De speciale botsingen genereren deeltjes in ongebruikelijke patronen - mogelijke manifestaties van nieuwe, regelbrekende natuurkunde - of help ons onvolledige beeld van het universum in te vullen.

Het vinden van deze botsingen is moeilijker dan de spreekwoordelijke zoektocht naar de speld in de hooiberg. Maar baanbrekende hulp is onderweg. Wetenschappers van Fermilab en andere medewerkers hebben met succes een prototype machine-learningtechnologie getest die de verwerking 30 tot 175 keer versnelt in vergelijking met traditionele methoden.

Elke seconde geconfronteerd met 40 miljoen botsingen, wetenschappers van de LHC gebruiken krachtige, behendige computers om de edelstenen te plukken - of het nu een Higgs-deeltje is of hints van donkere materie - uit de enorme ruis van gewone botsingen.

Door gesimuleerde LHC-botsingsgegevens bladeren, de machine learning-technologie leerde met succes een bepaald postcollision-patroon te identificeren - een bepaalde spray van deeltjes die door een detector vliegt - terwijl het door een verbazingwekkende 600 beelden per seconde bladerde. Traditionele methoden verwerken minder dan één afbeelding per seconde.

De technologie zou zelfs als dienst op externe computers kunnen worden aangeboden. Door dit offloading-model te gebruiken, kunnen onderzoekers sneller meer gegevens analyseren en blijft er meer LHC-rekenruimte over voor ander werk.

Het is een veelbelovende inkijk in hoe machine learning-services een veld ondersteunen waarin al enorme hoeveelheden gegevens alleen maar groter zullen worden.

De uitdaging:meer data, meer rekenkracht

Onderzoekers zijn momenteel bezig met het upgraden van de LHC om protonen te vernietigen met vijf keer de huidige snelheid. tegen 2026, de 17-mijls cirkelvormige ondergrondse machine in het Europese laboratorium CERN zal 20 keer meer data produceren dan nu het geval is.

CMS is een van de deeltjesdetectoren bij de Large Hadron Collider, en CMS-medewerkers zitten midden in een aantal eigen upgrades, waardoor de ingewikkelde, verhalenhoog instrument om meer geavanceerde foto's te maken van de deeltjesbotsingen van de LHC. Fermilab is het leidende Amerikaanse laboratorium voor het CMS-experiment.

Als LHC-wetenschappers alle ruwe botsingsgegevens wilden bewaren die ze in een jaar van de High-Luminosity LHC zouden verzamelen, ze zouden een manier moeten vinden om ongeveer 1 exabyte (ongeveer 1 biljoen persoonlijke externe harde schijven) op te slaan, waarvan slechts een splinter nieuwe verschijnselen kan onthullen. LHC-computers zijn geprogrammeerd om deze kleine fractie te selecteren, in een fractie van een seconde beslissingen nemen over welke gegevens waardevol genoeg zijn om stroomafwaarts te worden verzonden voor verder onderzoek.

Momenteel, het computersysteem van de LHC houdt ongeveer één op de 100, 000 deeltjesgebeurtenissen. Maar de huidige opslagprotocollen kunnen de toekomstige datastroom niet bijhouden, die zich gedurende tientallen jaren van gegevensverzameling zullen ophopen. En de foto's met een hogere resolutie die zijn vastgelegd door de geüpgradede CMS-detector zullen het werk er niet gemakkelijker op maken. Het vertaalt zich allemaal in een behoefte aan meer dan 10 keer de computerbronnen dan de LHC nu heeft.

Deeltjesfysici onderzoeken het gebruik van computers met machine learning-mogelijkheden voor het verwerken van afbeeldingen van deeltjesbotsingen bij CMS, hen te leren om snel verschillende botsingspatronen te identificeren. Krediet:Eamonn Maguire/Antarctisch ontwerp

De recente prototypetest toont aan dat, met vooruitgang in machine learning en computerhardware, onderzoekers verwachten de gegevens die uit de aanstaande High-Luminosity LHC komen, te kunnen wannen wanneer deze online komt.

"De hoop hier is dat je heel geavanceerde dingen kunt doen met machine learning en ze ook sneller kunt doen, " zei Nhan Tran, een Fermilab-wetenschapper over het CMS-experiment en een van de leiders van de recente test. "Dit is belangrijk, omdat onze gegevens steeds complexer worden met verbeterde detectoren en drukkere botsingsomgevingen."

Machine learning om te redden:het verschil in gevolgtrekking

Machine learning in de deeltjesfysica is niet nieuw. Natuurkundigen gebruiken machine learning voor elke fase van gegevensverwerking in een collider-experiment.

Maar met machine learning-technologie die tot 175 keer sneller door LHC-gegevens kan kauwen dan traditionele methoden, deeltjesfysici bestijgen een baanbrekende stap op de koers voor botsingsberekening.

De hoge tarieven zijn te danken aan slim ontworpen hardware in het platform, Microsoft's Azure ML, wat een proces dat inferentie wordt genoemd, versnelt.

Om gevolgtrekkingen te begrijpen, overweeg een algoritme dat is getraind om het beeld van een motorfiets te herkennen:het object heeft twee wielen en twee handvatten die aan een grotere metalen behuizing zijn bevestigd. Het algoritme is slim genoeg om te weten dat een kruiwagen, die vergelijkbare eigenschappen heeft, is geen motorfiets. Terwijl het systeem nieuwe beelden scant van andere tweewielers, voorwerpen met twee handvatten, het voorspelt - of leidt daaruit af - wat motorfietsen zijn. En als de voorspellingsfouten van het algoritme worden gecorrigeerd, het wordt behoorlijk behendig in het identificeren ervan. Een miljard scans later, het is op zijn inferentiespel.

De meeste machine learning-platforms zijn gebouwd om te begrijpen hoe afbeeldingen, maar geen fysica-specifieke afbeeldingen. Natuurkundigen moeten ze het natuurkundegedeelte leren, zoals het herkennen van sporen die zijn gemaakt door het Higgs-deeltje of het zoeken naar hints van donkere materie.

Onderzoekers van Fermilab, CERN, MIT, de Universiteit van Washington en andere medewerkers hebben Azure ML getraind om afbeeldingen van top-quarks te identificeren - een kortlevend elementair deeltje dat ongeveer 180 keer zwaarder is dan een proton - uit gesimuleerde CMS-gegevens. specifiek, Azure moest op zoek naar afbeeldingen van top-quarkjets, wolken van deeltjes die uit het vacuüm zijn getrokken door een enkele top-quark die wegvliegt van de botsing.

"We hebben het de beelden gestuurd, het trainen op natuurkundige gegevens, " zei Fermilab-wetenschapper Burt Holzman, een voorsprong op het project. "En het vertoonde state-of-the-art prestaties. Het was erg snel. Dat betekent dat we een groot aantal van deze dingen kunnen pijplijnen. In het algemeen, deze technieken zijn redelijk goed."

Een van de technieken achter inferentieversnelling is het combineren van traditionele met gespecialiseerde processors, een huwelijk dat bekend staat als heterogene computerarchitectuur.

Gegevens van deeltjesfysica-experimenten worden opgeslagen op computerboerderijen zoals deze, het Grid Computing Center in Fermilab. Externe organisaties bieden hun computerparken aan als een dienst aan deeltjesfysica-experimenten, meer ruimte beschikbaar maken op de servers van de experimenten. Krediet:Reidar Hahn

Verschillende platforms gebruiken verschillende architecturen. De traditionele processors zijn CPU's (central processing units). De bekendste gespecialiseerde processors zijn GPU's (grafische verwerkingseenheden) en FPGA's (field-programmeerbare gate-arrays). Azure ML combineert CPU's en FPGA's.

"De reden dat deze processen moeten worden versneld, is dat dit grote berekeningen zijn. Je hebt het over 25 miljard operaties, " zei Tran. "Dat op een FPGA passen, dat in kaart brengen, en om het binnen een redelijke tijd te doen, is een echte prestatie."

En het begint te worden aangeboden als een service, te. De test was de eerste keer dat iemand heeft aangetoond hoe dit soort heterogene, as-a-service-architectuur kan worden gebruikt voor fundamentele fysica.

In de computerwereld is iets gebruiken "als een service" heeft een specifieke betekenis. Een externe organisatie biedt middelen - machine learning of hardware - als een service, en gebruikers - wetenschappers - putten waar nodig uit die bronnen. Het is vergelijkbaar met hoe uw videostreamingbedrijf urenlang tv-kijken biedt als een service. U hoeft niet over uw eigen dvd's en dvd-speler te beschikken. U gebruikt in plaats daarvan hun bibliotheek en interface.

Gegevens van de Large Hadron Collider worden doorgaans opgeslagen en verwerkt op computerservers bij CERN en partnerinstellingen zoals Fermilab. Omdat machine learning net zo gemakkelijk wordt aangeboden als elke andere webservice, intensieve berekeningen kunnen overal worden uitgevoerd waar de service wordt aangeboden, ook buiten de locatie. Dit versterkt de capaciteiten van de laboratoria met extra rekenkracht en middelen, terwijl ze hun eigen servers niet hoeven in te richten.

"Het idee van versneld computergebruik bestaat al tientallen jaren, maar het traditionele model was om een computercluster met GPU's te kopen en deze lokaal in het lab te installeren, Holzman zei. "Het idee om het werk over te dragen naar een boerderij buiten het terrein met gespecialiseerde hardware, het aanbieden van machine learning als een service - dat werkte zoals geadverteerd."

De Azure ML-farm bevindt zich in Virginia. Het duurt slechts 100 milliseconden voor computers in Fermilab bij Chicago, Illinois, om een afbeelding van een deeltjesgebeurtenis naar de Azure-cloud te verzenden, verwerk het, en retourneer het. Dat is een 2, 500 kilometer, data-dichte reis in een oogwenk.

"Het loodgieterswerk dat daarbij hoort, is een andere prestatie, "Zei Tran. "Het concept van het abstraheren van die gegevens als iets dat je gewoon ergens anders naartoe stuurt, en het komt gewoon terug, was het meest aangenaam verrassende aan dit project. We hoeven niet alles in ons eigen rekencentrum te vervangen door een heleboel nieuwe dingen. We houden het allemaal stuur de harde berekeningen weg en laat het later terugkomen."

Wetenschappers kijken ernaar uit om de technologie op te schalen om andere big data-uitdagingen bij de LHC aan te pakken. Ze zijn ook van plan om andere platforms te testen, zoals Amazon AWS, Google Cloud en IBM Cloud, terwijl ze onderzoeken wat er nog meer kan worden bereikt door machine learning, die de afgelopen jaren een snelle evolutie heeft doorgemaakt.

"De modellen die voor 2015 state-of-the-art waren, zijn tegenwoordig standaard, ' zei Tran.

Als gereedschap, machine learning blijft de deeltjesfysica nieuwe manieren geven om een glimp op te vangen van het universum. Het is op zich ook al indrukwekkend.

"Dat we iets kunnen nemen dat is getraind om onderscheid te maken tussen foto's van dieren en mensen, doe een bescheiden bedragberekening, en laat het me het verschil vertellen tussen een top-quarkjet en background?' zei Holzman. 'Dat is iets waar ik versteld van sta.'

Soorten distillatie

Soorten distillatie  Chemici ontwikkelen een eenvoudige, gebruiksvriendelijke methode om verontreinigende stoffen in water af te breken

Chemici ontwikkelen een eenvoudige, gebruiksvriendelijke methode om verontreinigende stoffen in water af te breken P450-peroxygenase omzetten in peroxidase via mechanismegestuurde eiwittechnologie

P450-peroxygenase omzetten in peroxidase via mechanismegestuurde eiwittechnologie Kans op hypersonische reizen neemt toe met ontdekking van nieuwe materialen

Kans op hypersonische reizen neemt toe met ontdekking van nieuwe materialen Bepaal de creatie van chiraliteit door organische katalysatoren

Bepaal de creatie van chiraliteit door organische katalysatoren

Hoeveel uitstoot van broeikasgassen komt door tropische ontbossing en verlies van veengebieden?

Hoeveel uitstoot van broeikasgassen komt door tropische ontbossing en verlies van veengebieden? Insecteneiwit heeft een groot potentieel om de ecologische voetafdruk van Europese consumenten te verkleinen

Insecteneiwit heeft een groot potentieel om de ecologische voetafdruk van Europese consumenten te verkleinen Aardverschuiving Myanmar doodt 34, veel meer gevreesd vermist

Aardverschuiving Myanmar doodt 34, veel meer gevreesd vermist Meelwormen voeden met Bluebirds

Meelwormen voeden met Bluebirds Franse bosbrand verteert huis, dwingt evacuaties

Franse bosbrand verteert huis, dwingt evacuaties

Hoofdlijnen

- De nadelen van melkzuurvergisting

- Genotypes bepalen

- Hoe zuurstofgas wordt geproduceerd tijdens fotosynthese?

- Bioprocessing-ingenieurs winnen glucosinolaat uit oliezaadmeel

- Celstructuren en hun drie belangrijkste functies

- Onderzoek toont aan dat commerciële oogst van brekende schildpadden leidt tot bevolkingsafname

- Gestresste stokstaartjes helpen minder snel groep

- Horror als Noorse goederentreinen meer dan 100 rendieren neermaaien

- Geef twee redenen waarom het vrijwel onmogelijk is om veel menselijke eigenschappen te associëren met enkele genen

Onaantastbare communicatie wordt praktisch met nieuw systeem in toekomstig kwantuminternet

Onaantastbare communicatie wordt praktisch met nieuw systeem in toekomstig kwantuminternet Een zeer lichtabsorberend en afstembaar materiaal

Een zeer lichtabsorberend en afstembaar materiaal Hoe HP naar KVA te converteren

Hoe HP naar KVA te converteren  Zachte draagbare gezondheidsmonitor maakt gebruik van rekbare elektronica

Zachte draagbare gezondheidsmonitor maakt gebruik van rekbare elektronica Clubs en bars moeten vrouwen steunen door seksuele agressie aan te pakken

Clubs en bars moeten vrouwen steunen door seksuele agressie aan te pakken Een opwarmende wereld verhoogt de luchtvervuiling

Een opwarmende wereld verhoogt de luchtvervuiling Duurzaam winkelen - haal het zwerfvuil uit glitter

Duurzaam winkelen - haal het zwerfvuil uit glitter Je doel opgeven? Lees dit eerst

Je doel opgeven? Lees dit eerst

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Swedish | German | Dutch | Danish | Norway | Portuguese |

-

Wetenschap © https://nl.scienceaq.com