Wetenschap

Berkeley Lab maakt de weg vrij voor realtime ptychografische datastreaming

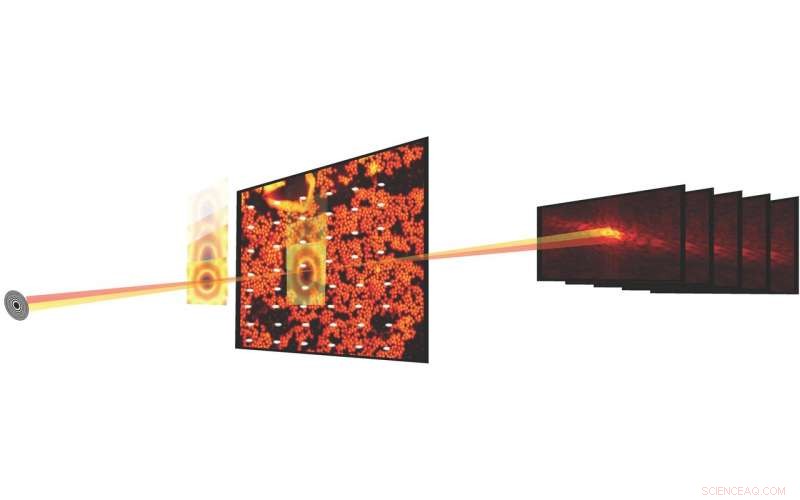

Bij wetenschappelijke experimenten, ptychografische beeldvorming combineert scanningmicroscopie met diffractiemetingen om de structuur en eigenschappen van materie en materialen te karakteriseren. Vooruitgang in detectoren en röntgenmicroscopen bij lichtbronnen heeft het nu mogelijk gemaakt om een ptychografische dataset in seconden te meten. Krediet:Stefano Marchesini, Berkeley Lab

Wat bijna tien jaar geleden begon als een voorstel voor Berkeley Lab Laboratory-Directed Research and Development (LDRD), is nu een realiteit. en het verandert al de manier waarop wetenschappers experimenten uitvoeren bij de Advanced Light Source (ALS) - en, eventueel, andere lichtbronnen in het Department of Energy (DOE) -complex - door realtime streaming van ptychografische beeldgegevens in een productieomgeving mogelijk te maken.

Bij wetenschappelijke experimenten, ptychografische beeldvorming combineert scanningmicroscopie met diffractiemetingen om de structuur en eigenschappen van materie en materialen te karakteriseren. Hoewel de methode al zo'n 50 jaar bestaat, breed gebruik werd belemmerd door het feit dat het experimentele proces traag was en de computationele verwerking van de gegevens om een gereconstrueerd beeld te produceren duur was. Maar de afgelopen jaren hebben vorderingen in detectoren en röntgenmicroscopen bij lichtbronnen zoals de ALS het mogelijk gemaakt om een ptychografische dataset in seconden te meten.

Reconstructie van ptychografische datasets, echter, is geen triviale zaak; het proces omvat het oplossen van een moeilijk fase-ophaalprobleem, kalibreren van optische elementen en omgaan met experimentele uitschieters en "ruis". Voer SHARP in (schaalbare heterogene adaptieve real-time ptychografie), een algoritmisch raamwerk en computersoftware waarmee miljoenen fasen van ptychografische beeldgegevens per seconde kunnen worden gereconstrueerd. Ontwikkeld in Berkeley Lab via een internationale samenwerking en uitgerold in 2016, SHARP heeft een aantoonbare impact gehad op de productiviteit van wetenschappers die werkzaam zijn bij de ALS en andere lichtbronnen in het hele Department of Energy-complex.

Nu financierde een intergouvernementele instantie de samenwerking van wetenschappers van het DOE-gefinancierde Center for Advanced Mathematics for Energy Research Applications (CAMERA) van Berkeley Lab, de ALS en STROBE, het Science and Technology Center van de National Science Foundation, heeft nog een primeur opgeleverd voor ptychografische beeldvorming:een software/algoritmische pijplijn die realtime streaming van ptychografische beeldgegevens mogelijk maakt tijdens een bundellijnexperiment, doorvoer leveren, compressie en resolutie, evenals snelle feedback aan de gebruiker terwijl het experiment nog loopt.

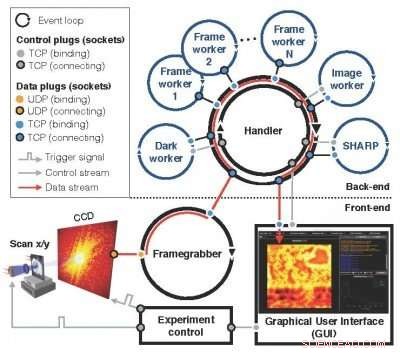

Geïntegreerd, modulair, schaalbaar

Een opvolger van het Nanosurveyor-concept dat voor het eerst werd geïntroduceerd in een LDRD-voorstel uit 2010, de modulaire, schaalbaar Nanosurveyor II-systeem - nu operationeel bij de ALS - maakt gebruik van een tweezijdige infrastructuur die de ptychografische beeldgegevensacquisitie integreert, voorbewerking, transmissie- en visualisatieprocessen. De front-end component bij de bundellijn bestaat uit de detector, frame-grabber, een schaalbare preprocessor en grafische gebruikersinterface (GUI), terwijl de back-endcomponent in het rekencluster SHARP bevat voor beeldreconstructie met hoge resolutie gecombineerd met communicatiekanalen voor gegevensstroom, instructies en synchronisatie. In bedrijf, zodra een nieuwe scan is geactiveerd door de experimentcontrole, de frame-grabber ontvangt continu onbewerkte datapakketten van de camera, assembleert ze tot een frame en, parallel, verwerkt een set onbewerkte frames voor in een schoon en gereduceerd blok voor de computationele back-end. Inkomende blokken worden verdeeld onder de SHARP-werknemers in de berekeningsback-end, en gereduceerde gegevens worden teruggestuurd naar de front-end en gevisualiseerd in een GUI. Het nieuwe streamingsoftwaresysteem wordt bij de ALS uitgerold voor actief gebruik bij experimenten op de bundellijnen, zoals het COSMIC-röntgenmicroscopieplatform dat onlangs online is gekomen.

"Wat we zijn gelukt, is om zeer complexe berekeningen en gegevensworkflows zo transparant mogelijk te maken, " zei David Shapiro, een stafwetenschapper in de Experimental Systems Group bij de ALS die een belangrijke rol heeft gespeeld bij het faciliteren van de implementatie en het testen van het nieuwe systeem. "Als de software eenmaal werkt, microscoopoperators hebben geen idee dat ze gigabytes aan gegevens genereren en het gaat door deze pijplijn en komt er dan weer op terug."

ALS-gebruikers kunnen de bundellijnen doorgaans ongeveer twee dagen gebruiken, waarin ze ongeveer een dozijn monsters kunnen bestuderen, merkte Shapiro op. Dit betekent dat ze maar een paar uur per monster hebben, en binnen die uren moeten ze een aantal beslissingen nemen over de gegevens. De pytchografische realtime streamingmogelijkheid geeft hen realtime feedback en helpt hen om nauwkeurigere beslissingen te nemen.

De modulaire, schaalbaar Nanosurveyor II-systeem - nu operationeel bij de ALS - maakt gebruik van een tweezijdige infrastructuur die de ptychografische beeldgegevensacquisitie integreert, voorbewerking, transmissie- en visualisatieprocessen. Krediet:Lawrence Berkeley National Laboratory

"Het feit dat SHARP nu gegevens in realtime kan opnemen en onmiddellijk kan verwerken, zelfs als het experiment niet is voltooid, maakt het high-performance en operationeel voor de wetenschap in een productieomgeving, " zei Stefano Marchesini, een CAMERA-wetenschapper en de PI over het oorspronkelijke LDRD-voorstel.

Productieklare omgeving

Het integreren van alle componenten was een van de grootste uitdagingen bij het implementeren van Nanosurveyor II, zoals het klaarmaken om te functioneren in een productieklare omgeving versus een testbed, volgens Hari Krishnan, een computersysteemingenieur bij CAMERA die verantwoordelijk was voor de ontwikkeling van de communicatiemotor van de pijpleiding. Het vergde een inspanning van meerdere jaren om de real-time gegevensverwerkingsmogelijkheden tot bloei te brengen, met bijdragen van wiskundigen, computer wetenschappers, software-ingenieurs, natuurkundigen en beamline-wetenschappers. Naast Marchesini en Krishnan, CAMERA-wetenschappers Pablo Enfedaque en Huibin Chang waren betrokken bij de ontwikkeling van de SHARP-interface en de communicatie-engine. In aanvulling, Filipe Maia en Benedict Daurer van de Universiteit van Uppsala, die een samenwerking heeft met CAMERA, speelde een integraal onderdeel in de ontwikkeling van de streamingsoftware. In de tussentijd, natuurkundige Bjoern Enders van Berkeley's Physics Department en STROBE was gericht op de detector en preprocessor, en Berkeley Physics Ph.D. student Kasra Nowrouzi was betrokken bij de aanleg van pijpleidingen.

"Het was belangrijk om de verantwoordelijkheden en taken van het systeem te scheiden en vervolgens een gemeenschappelijke interface te vinden om over te communiceren, Enders zei over de teamprestatie. "Hierdoor kwam een deel van de verantwoordelijkheid terug in de bundel. We hebben allemaal samengewerkt om het streaming-algoritme netjes te scheiden van het preprocessing-gedeelte, zodat we ervoor kunnen zorgen dat de bundellijn echt werkt."

Vooruit kijken, De schaalbaarheid van Nanosurveyor II zal van cruciaal belang zijn als de volgende generatie lichtbronnen en detectoren online komt. De datasnelheden van de pijplijn weerspiegelen die van de detector; de huidige detector werkt met een snelheid van maximaal 400 megabyte per seconde en kan enkele terabytes aan gegevens per dag genereren. Detectoren van de volgende generatie zullen gegevens 100 tot 1 produceren 000 keer sneller.

"De streamingoplossing werkt op dit moment net zo snel als de data-acquisitie, "Zei Enfedaque. "Je kunt het ptychografische beeld reconstrueren met de snelheid waarmee de gegevens worden vastgelegd en voorbewerkt."

In aanvulling, het team wil de mogelijkheden van de pijplijn verbeteren door machine learning-algoritmen op te nemen die het gegevensanalyseproces verder kunnen automatiseren.

"Het doel is om het naadloos te maken, "Zei Krishnan. "Op dit moment kijken de gebruikers naar een grof beeld om snelle beslissingen te nemen en een fijner beeld om complexere beslissingen te nemen. Uiteindelijk willen we helemaal af van de onbewerkte frames en gegevens en eindigen in dit rijk waar alle beslissingen en alle punten slechts een enkel gereconstrueerd beeld zijn. Al deze andere tussenliggende dingen verdwijnen."

"De mogelijkheid om gegevens te streamen brengt analyse in de tijdschaal van menselijke besluitvorming voor operators, maar het vergemakkelijkt ook de toekomst, dat zijn machines die beslissingen nemen en de metingen leiden, ' voegde Shapiro toe.

Het minimaliseren van brandstofexplosies en branden door ongelukken en terroristische daden met polymeren

Het minimaliseren van brandstofexplosies en branden door ongelukken en terroristische daden met polymeren IJsblokjes smeltproces

IJsblokjes smeltproces Onderzoekers ontwikkelen sensoren die menselijke biomarkers en giftig gas detecteren

Onderzoekers ontwikkelen sensoren die menselijke biomarkers en giftig gas detecteren Een verbeterde methode voor visualisatie van eiwitkristalstructuur

Een verbeterde methode voor visualisatie van eiwitkristalstructuur Eindelijk, het antwoord op een brandende vraag van 40 jaar

Eindelijk, het antwoord op een brandende vraag van 40 jaar

De kenmerken en fysieke kenmerken van een Tiger

De kenmerken en fysieke kenmerken van een Tiger Een van 's werelds droogste woestijnen is de focus van een nieuwe studie over ons veranderende klimaat

Een van 's werelds droogste woestijnen is de focus van een nieuwe studie over ons veranderende klimaat Studie ontdekt waarom de opwarming van de aarde zal versnellen naarmate de CO2-niveaus stijgen

Studie ontdekt waarom de opwarming van de aarde zal versnellen naarmate de CO2-niveaus stijgen Waarom storten beschavingen in?

Waarom storten beschavingen in?  Hoe spinnen te identificeren in Alberta

Hoe spinnen te identificeren in Alberta

Hoofdlijnen

- De oudste kleur van de aarde was roze

- Ontdekkingen van donkere materie kunnen licht werpen op nieuwe behandelingen voor ziekten

- Neem een dosis Dickinson:poëzie als therapie

- Plant: definitie, evolutie, taxonomie

- Waarom hebben de meeste mensen 23 paar chromosomen?

- Lovelorn koala gepakt na ontsnapping uit dierentuin op jacht naar partner

- Gemengde organisatie van darmbacteriën wordt onthuld door microbioombeeldvormingstechnologie

- Wat is het verschil tussen een nucleotide en een nucleoside?

- Wat is een zuivere eigenschap en een hybride eigenschap?

- CLEAR-studie maakt de weg vrij voor nieuwe op elektronen gebaseerde kankertherapie

- Experiment in een doos suggereert dat een paar koude vallende regendruppels kunnen leiden tot een regenbui

- Kwantumsnelkoppelingen kunnen de wetten van de thermodynamica niet omzeilen

- Onderzoekers suggereren wijziging van het kwantumversleutelingssysteem met compacte detector

- MAGNDATA:Op weg naar een database van magnetische structuren

De vier ruiters van de COVID-19-pandemie

De vier ruiters van de COVID-19-pandemie Ocean meeting haalt meer dan $7 miljard op voor mariene bescherming

Ocean meeting haalt meer dan $7 miljard op voor mariene bescherming Onderzoekers onderzoeken eigenschappen van supernova SN 2012au

Onderzoekers onderzoeken eigenschappen van supernova SN 2012au Cyberbeveiliging vereist internationale samenwerking, vertrouwen

Cyberbeveiliging vereist internationale samenwerking, vertrouwen Onderzoekers onderzoeken alomtegenwoordige interactie van biomoleculen met water

Onderzoekers onderzoeken alomtegenwoordige interactie van biomoleculen met water Een goede klantenservice kan leiden tot hogere winsten, zelfs voor nutsbedrijven zonder concurrentie

Een goede klantenservice kan leiden tot hogere winsten, zelfs voor nutsbedrijven zonder concurrentie Bedrading van de kwantumcomputer van de toekomst:een nieuwe, eenvoudige build met bestaande technologie

Bedrading van de kwantumcomputer van de toekomst:een nieuwe, eenvoudige build met bestaande technologie Afbeelding:lancering van SpaceX CRS-12 vrachtmissie

Afbeelding:lancering van SpaceX CRS-12 vrachtmissie

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | Italian |

-

Wetenschap © https://nl.scienceaq.com