Wetenschap

High-performance computing verkort de voorbereidingstijd voor gegevens over botsingen tussen deeltjes

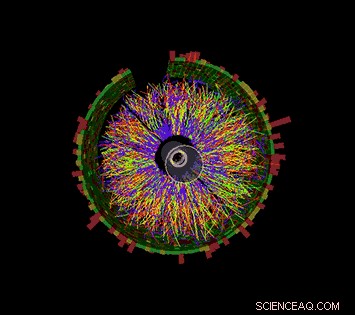

Deze animatie toont een reeks botsingen bij STAR, elk met duizenden deeltjessporen en de signalen die zijn geregistreerd terwijl sommige van die deeltjes verschillende detectorcomponenten treffen. Het zou je een idee moeten geven van hoe complex de uitdaging is om een compleet verslag van elk afzonderlijk deeltje te reconstrueren en de omstandigheden waaronder het is gemaakt, zodat wetenschappers honderden miljoenen gebeurtenissen kunnen vergelijken om trends te zoeken en ontdekkingen te doen. Krediet:Brookhaven National Laboratory

Voor de eerste keer, wetenschappers hebben high-performance computing (HPC) gebruikt om de gegevens te reconstrueren die zijn verzameld door een kernfysisch experiment - een vooruitgang die de tijd die nodig is om gedetailleerde gegevens beschikbaar te maken voor wetenschappelijke ontdekkingen drastisch zou kunnen verkorten.

Het demonstratieproject maakte gebruik van de Cori-supercomputer van het National Energy Research Scientific Computing Center (NERSC), een high-performance computercentrum in het Lawrence Berkeley National Laboratory in Californië, om meerdere datasets te reconstrueren die door de STAR-detector zijn verzameld tijdens deeltjesbotsingen bij de Relativistic Heavy Ion Collider (RHIC), een onderzoeksfaciliteit voor kernfysica in het Brookhaven National Laboratory in New York. Door meerdere computertaken tegelijkertijd uit te voeren op de toegewezen supercomputerkernen, het team transformeerde 4,73 petabyte aan onbewerkte gegevens in 2,45 petabyte aan "physics-ready" gegevens in een fractie van de tijd die het zou hebben gekost met in-house high-throughput computerresources, zelfs met een transcontinentale datareis in twee richtingen.

"De reden waarom dit echt fantastisch is, " zei Brookhaven-natuurkundige Jérôme Lauret, die de computerbehoeften van STAR beheert, "is dat deze krachtige computerbronnen elastisch zijn. Je kunt bellen om een grote hoeveelheid rekenkracht te reserveren wanneer je die nodig hebt, bijvoorbeeld, vlak voor een grote conferentie wanneer natuurkundigen haast hebben om nieuwe resultaten te presenteren." Volgens Lauret, het voorbereiden van ruwe gegevens voor analyse duurt doorgaans vele maanden, waardoor het bijna onmogelijk is om zo'n reactie op korte termijn te bieden. "Maar met HPC, misschien kunt u zoveel maanden productietijd in een week samenvatten. Dat zou de wetenschappers echt machtigen!"

De prestatie toont de synergetische mogelijkheden van RHIC en NERSC-U.S. Department of Energy (DOE) Office of Science Gebruikersfaciliteiten in door DOE gerunde nationale laboratoria aan tegenovergestelde kusten - verbonden door een van de meest uitgebreide krachtige netwerken voor het delen van gegevens ter wereld, DOE's Energy Sciences Network (ESnet), een andere DOE Office of Science User Facility.

"Dit is een belangrijk gebruiksmodel van high-performance computing voor experimentele gegevens, aantonen dat onderzoekers hun ruwe gegevensverwerking of simulatiecampagnes in een paar dagen of weken op een kritiek moment kunnen uitvoeren in plaats van zich over maanden te spreiden op hun eigen toegewijde middelen, " zei Jeff Porter, een lid van het data- en analyseservicesteam van NERSC.

Miljarden datapunten

Om natuurkundige ontdekkingen te doen bij RHIC, wetenschappers moeten honderden miljoenen botsingen tussen ionen die zijn versneld tot zeer hoge energie sorteren. STER, een verfijnde, elektronisch instrument op huisformaat, registreert het subatomaire puin dat uit deze deeltjesinslagen stroomt. Bij de meest energieke evenementen, vele duizenden deeltjes raken detectorcomponenten, het produceren van vuurwerkachtige displays van kleurrijke deeltjessporen. Maar om erachter te komen wat deze complexe signalen betekenen, en wat ze ons kunnen vertellen over de intrigerende vorm van materie die is ontstaan bij de botsingen van RHIC, wetenschappers hebben gedetailleerde beschrijvingen nodig van alle deeltjes en de omstandigheden waaronder ze zijn geproduceerd. Ze moeten ook enorme statistische steekproeven van veel verschillende soorten botsingen vergelijken.

Het catalogiseren van die informatie vereist geavanceerde algoritmen en patroonherkenningssoftware om signalen van de verschillende uitleeselektronica te combineren, en een naadloze manier om die gegevens te matchen met gegevens over aanrijdingen. Alle informatie moet dan zo worden verpakt dat natuurkundigen ze kunnen gebruiken voor hun analyses.

Cori, de nieuwste supercomputer van het National Energy Research Scientific Computing Center (NERSC), is een Cray XC40 met een piekprestatie van ongeveer 30 petaflops. Krediet:Brookhaven National Laboratory

Sinds RHIC begon te lopen in het jaar 2000, deze ruwe gegevensverwerking, of reconstructie, is uitgevoerd op speciale computerbronnen bij de RHIC en ATLAS Computing Facility (RACF) in Brookhaven. High-throughput computing (HTC)-clusters kraken de gegevens, gebeurtenis per gebeurtenis, en schrijf de gecodeerde details van elke botsing naar een gecentraliseerde massaopslagruimte die toegankelijk is voor STAR-natuurkundigen over de hele wereld.

Maar de uitdaging om de gegevens bij te houden is groter geworden met de steeds betere botsingspercentages van RHIC en omdat er nieuwe detectorcomponenten zijn toegevoegd. In recente jaren, De jaarlijkse onbewerkte datasets van STAR hebben miljarden gebeurtenissen bereikt met gegevensgroottes in het bereik van meerdere Petabyte. Daarom onderzocht het STAR-computerteam het gebruik van externe bronnen om te voldoen aan de vraag naar tijdige toegang tot natuurkundige gegevens.

Veel kernen maken licht werk

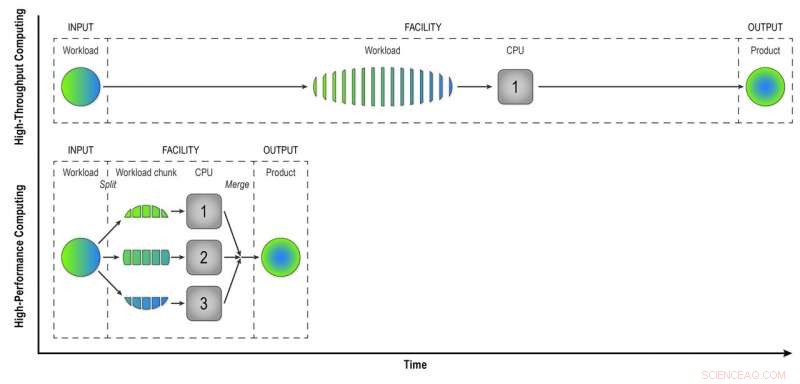

In tegenstelling tot de high-throughput computers bij de RACF, die gebeurtenissen één voor één analyseren, HPC-resources zoals die bij NERSC splitsen grote problemen op in kleinere taken die parallel kunnen worden uitgevoerd. Dus de eerste uitdaging was om de verwerking van STAR-gebeurtenisgegevens te "paralleliseren".

"We schreven workflowprogramma's die het eerste niveau van parallellisatie bereikten:parallellisatie van gebeurtenissen, " zei Lauret. Dat betekent dat ze minder opdrachten indienen die zijn gemaakt van veel gebeurtenissen die tegelijkertijd kunnen worden verwerkt op de vele HPC-computerkernen.

"Stel je voor dat je een stad bouwt met 100 huizen. Als dit op een high-throughput manier zou gebeuren, elk huis zou één bouwer hebben die alle taken in volgorde uitvoert:de fundering bouwen, de muren, enzovoort, Lauret zei. "Maar met HPC veranderen we het paradigma. In plaats van één arbeider per huis hebben we 100 arbeiders per huis, en elke arbeider heeft een taak:de muren of het dak bouwen. Ze werken parallel, tegelijkertijd, en aan het eind assembleren we alles samen. Met deze aanpak, we zullen dat huis 100 keer sneller bouwen."

Natuurlijk, er is enige creativiteit voor nodig om na te denken over hoe dergelijke problemen kunnen worden opgedeeld in taken die tegelijkertijd in plaats van opeenvolgend kunnen worden uitgevoerd, voegde Lauret toe.

HPC bespaart ook tijd bij het matchen van onbewerkte detectorsignalen met gegevens over de omgevingsomstandigheden tijdens elk evenement. Om dit te doen, de computers moeten toegang hebben tot een "conditiedatabase" - een record van de spanning, temperatuur, druk, en andere detectorcondities waarmee rekening moet worden gehouden bij het begrijpen van het gedrag van de deeltjes die bij elke botsing worden geproduceerd. Per gebeurtenis, reconstructie met hoge doorvoer, de computers roepen de database op om gegevens voor elke afzonderlijke gebeurtenis op te halen. Maar omdat HPC-kernen wat geheugen delen, gebeurtenissen die kort in de tijd plaatsvinden, kunnen dezelfde conditiegegevens in de cache gebruiken. Minder aanroepen naar de database betekent snellere gegevensverwerking.

Bij high-throughput computing, een werklast die bestaat uit gegevens van veel STAR-botsingen wordt gebeurtenis voor gebeurtenis op een sequentiële manier verwerkt om natuurkundigen "gereconstrueerde gegevens" te geven - het product dat ze nodig hebben om de gegevens volledig te analyseren. High-performance computing verdeelt de werklast in kleinere brokken die door afzonderlijke CPU's kunnen worden geleid om de gegevensreconstructie te versnellen. In deze eenvoudige illustratie het splitsen van een werklast van 15 gebeurtenissen in drie delen van vijf parallel verwerkte gebeurtenissen levert hetzelfde product op in een derde van de tijd als de high-throughput-methode. Het gebruik van 32 CPU's op een supercomputer zoals Cori kan de tijd die nodig is om de onbewerkte gegevens van een echte STAR-dataset te transformeren aanzienlijk verkorten, met vele miljoenen evenementen, omzetten in bruikbare informatie die natuurkundigen kunnen analyseren om ontdekkingen te doen. Krediet:Brookhaven National Laboratory

Netwerken teamwerk

Een andere uitdaging bij het migreren van de taak van de reconstructie van onbewerkte gegevens naar een HPC-omgeving was het verkrijgen van de gegevens van New York naar de supercomputers in Californië en terug. Zowel de input- als outputdatasets zijn enorm. Het team begon klein met een proof-of-principle-experiment - slechts een paar honderd banen - om te zien hoe hun nieuwe workflowprogramma's zouden presteren.

"We hebben veel hulp gehad van de netwerkprofessionals van Brookhaven, " zei Lauret, "in het bijzonder Mark Lukascsyk, een van onze netwerkingenieurs, die zo enthousiast was over de wetenschap en ons hielp ontdekkingen te doen." Collega's in de RACF en ESnet hielpen ook bij het identificeren van hardwareproblemen en het ontwikkelen van oplossingen terwijl het team nauw samenwerkte met Jeff Porter, Mustafa Mustafa, en anderen bij NERSC om de gegevensoverdracht en de end-to-end workflow te optimaliseren.

Begin klein, vergroot

Na het verfijnen van hun methoden op basis van de eerste tests, het team begon op te schalen naar 6, 400 rekenkernen bij NERSC, dan omhoog en omhoog en omhoog.

"6, 400 cores is al de helft van de middelen die beschikbaar zijn voor datareconstructie bij RACF, " zei Lauret. "Uiteindelijk gingen we naar 25, 600 cores in onze meest recente test." Met alles van tevoren klaar voor een vooraf gereserveerde toewijzing van tijd op de Cori-supercomputer, "we hebben deze test een paar dagen gedaan en hadden in een mum van tijd een volledige dataproductie gedaan, " zei Lauret. Volgens Porter van NERSC, "Dit model is potentieel behoorlijk transformerend, en NERSC heeft gewerkt om dergelijk gebruik van hulpbronnen te ondersteunen door, bijvoorbeeld, door zijn centrumbrede, krachtige schijfsysteem rechtstreeks te koppelen aan zijn infrastructuur voor gegevensoverdracht en aanzienlijke flexibiliteit te bieden bij het plannen van taakslots."

De end-to-end efficiëntie van het hele proces - de tijd dat het programma liep (niet stilzitten, wachten op computerbronnen) vermenigvuldigd met de efficiëntie van het gebruik van de toegewezen supercomputing-slots en het verkrijgen van bruikbare output helemaal terug naar Brookhaven - was 98 procent.

"We hebben bewezen dat we de HPC-bronnen efficiënt kunnen gebruiken om achterstanden van onverwerkte gegevens weg te werken en tijdelijke vraag naar bronnen op te lossen om wetenschappelijke ontdekkingen te versnellen, ' zei Lauret.

Hij onderzoekt nu manieren om de workflow te generaliseren naar het Open Science Grid - een wereldwijd consortium dat computerbronnen verzamelt - zodat de hele gemeenschap van hoge-energie- en kernfysici er gebruik van kan maken.

Snel bewegende elektronen creëren stroom in organische zonnecellen

Snel bewegende elektronen creëren stroom in organische zonnecellen Definitie van moleculaire obligaties

Definitie van moleculaire obligaties  Wetenschappers stellen nieuwe methode voor om atomair gedispergeerde Cu-N-C-katalysator te synthetiseren

Wetenschappers stellen nieuwe methode voor om atomair gedispergeerde Cu-N-C-katalysator te synthetiseren Microben die samenwerken vermenigvuldigen de conversiemogelijkheden van biomassa

Microben die samenwerken vermenigvuldigen de conversiemogelijkheden van biomassa Screening op ziekte of toxines in een druppel bloed

Screening op ziekte of toxines in een druppel bloed

Giftige bijproducten van Agent Orange blijven het milieu in Vietnam vervuilen, studie zegt:

Giftige bijproducten van Agent Orange blijven het milieu in Vietnam vervuilen, studie zegt: De klok tikt op netto-nul, en Australische boeren mogen geen gratis pas krijgen

De klok tikt op netto-nul, en Australische boeren mogen geen gratis pas krijgen Hoe Cycloon Debbie aan haar naam kwam

Hoe Cycloon Debbie aan haar naam kwam Voedingstypes van Bacteria

Voedingstypes van Bacteria Nieuwe gegevens van NOAA GOES-16s Space Environment In-Situ Suite (SEISS) instrument

Nieuwe gegevens van NOAA GOES-16s Space Environment In-Situ Suite (SEISS) instrument

Hoofdlijnen

- Hoe een 3D-dwarsdoorsnedemodel van de huid te maken

- Waar komt collageen vandaan?

- Verschil tussen differentiatie en morfogenese

- Federale overheid:geen lijst van bedreigde soorten voor walrus

- Ecologische onderzoeksmethoden: observeren, experimenteren en modelleren

- De genetica van schijfziekte bij honden ontrafelen

- Beschrijving van de basisfuncties van enzymen in cellen

- Wat is vergelijkende biochemie?

- Ziektekiemen kunnen onze persoonlijkheid helpen vormen

- Onderzoekers demonstreren een supergeleider die voorheen voor onmogelijk werd gehouden

- Studie biedt een nieuwe theoretische benadering voor het beschrijven van faseovergangen die niet in evenwicht zijn

- Onderzoekers identificeren kenmerken die van iemand een superverspreider van virussen kunnen maken

- Eerste waarneming van een vierkant rooster van meronen en antimerons

- Slim oppervlak maakt geavanceerde manipulatie van druppels mogelijk

Facebook heeft regulering nodig - hier is waarom het moet worden gedaan door algoritmen

Facebook heeft regulering nodig - hier is waarom het moet worden gedaan door algoritmen Vooroordeel tegen vrouwen aan de macht is groter dan we denken

Vooroordeel tegen vrouwen aan de macht is groter dan we denken Moeten schrijvers alleen schrijven wat ze weten? Wat ik heb geleerd van mijn onderzoek

Moeten schrijvers alleen schrijven wat ze weten? Wat ik heb geleerd van mijn onderzoek EU-parlement keurt verbod op plastic voor eenmalig gebruik goed

EU-parlement keurt verbod op plastic voor eenmalig gebruik goed Hoe Gaslijnen te Grootte

Hoe Gaslijnen te Grootte  Wat zijn de purine basen van DNA?

Wat zijn de purine basen van DNA?  Versnelling zoeken in Gs

Versnelling zoeken in Gs Onderzoekers ontwikkelen overstromingsvoorspellingsmodel

Onderzoekers ontwikkelen overstromingsvoorspellingsmodel

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com