Wetenschap

Hersen-computerinterface kan hoortoestellen verbeteren

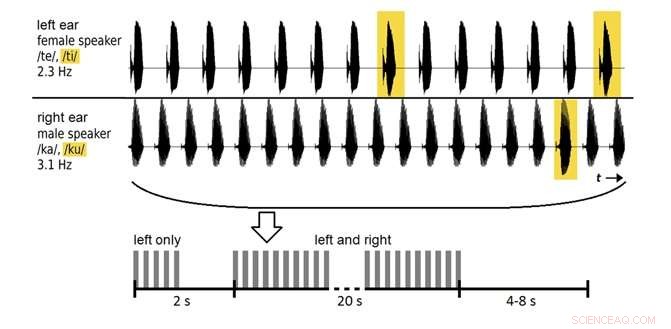

Een auditieve hersencomputer-interface kan met een nauwkeurigheid tot 80% vertellen naar welke spreker een luisteraar luistert, afhankelijk van de analysetijd. Krediet:Souto et al. ©2016 IOP Publishing

(Phys.org)—Onderzoekers werken aan de vroege stadia van een brain-computer interface (BCI) die kan vertellen naar wie je luistert in een kamer vol lawaai en andere mensen die praten. In de toekomst, de technologie zou in hoortoestellen kunnen worden verwerkt als kleine straalvormers die in de gewenste richting wijzen, zodat ze afstemmen op bepaalde gesprekken, klinkt, of stemmen waar een persoon aandacht aan schenkt, terwijl u ongewenste achtergrondgeluiden uitschakelt.

De onderzoekers, Carlos da Silva Souto en co-auteurs van de afdeling Medische Fysica en Cluster of Excellence Hearing4all van de Universiteit van Oldenburg, hebben een paper gepubliceerd over een proof-of-concept auditieve BCI in een recent nummer van: Biomedische Fysica en Engineering Express .

Tot dusver, het meeste BCI-onderzoek heeft zich voornamelijk gericht op visuele stimuli, die momenteel beter presteert dan systemen die auditieve stimuli gebruiken, mogelijk vanwege het grotere corticale oppervlak van het visuele systeem in vergelijking met de auditieve cortex. Echter, voor personen die slechtziend of volledig verlamd zijn, auditieve BCI zou een mogelijk alternatief kunnen bieden.

In de nieuwe studie 12 vrijwilligers luisterden naar twee opgenomen stemmen (een man, één vrouw) herhaalde lettergrepen spreken, en werd gevraagd om aandacht te schenken aan slechts een van de stemmen. In vroege sessies, elektro-encefalogram (EEG) gegevens over de elektrische activiteit van de hersenen werden gebruikt om de deelnemers te trainen. In latere sessies, het systeem werd getest op hoe nauwkeurig het de EEG-gegevens classificeerde om te bepalen aan welke stem de vrijwilliger aandacht besteedde.

Aanvankelijk, het systeem classificeerde de gegevens met een nauwkeurigheid van ongeveer 60% - boven het kansniveau, maar niet goed genoeg voor praktisch gebruik. Door de analysetijd te verhogen van 20 seconden naar 2 minuten, de onderzoekers konden de nauwkeurigheid verbeteren tot bijna 80%. Hoewel dit analysevenster te lang is voor levensechte situaties, en de nauwkeurigheid kan verder worden verbeterd, de resultaten behoren tot de eerste die aantonen dat het mogelijk is om EEG-gegevens te classificeren die worden opgeroepen door gesproken lettergrepen.

In de toekomst, de onderzoekers zijn van plan de classificatiemethoden te optimaliseren om de prestaties van het systeem verder te verbeteren.

© 2017 Fys.org

Onderzoekers ontdekken een nieuw mechanisme voor het werven van ARF-familie-eiwitten

Onderzoekers ontdekken een nieuw mechanisme voor het werven van ARF-familie-eiwitten Wat is atoomnummer?

Wat is atoomnummer?  Opbreken (eiwitcomplexen) is moeilijk te doen, maar nieuwe studie laat zien hoe

Opbreken (eiwitcomplexen) is moeilijk te doen, maar nieuwe studie laat zien hoe Wetenschappers berekenen stralingsdosis in botresten van slachtoffer bomaanslag Hiroshima

Wetenschappers berekenen stralingsdosis in botresten van slachtoffer bomaanslag Hiroshima Op weg naar het oplossen van oplosbaarheidsproblemen in de organische chemie

Op weg naar het oplossen van oplosbaarheidsproblemen in de organische chemie

Hoofdlijnen

- Aanwijzingen voor de aangeboren resistentie tegen geneesmiddelen van een cacaofermenterende ziekteverwekker

- Forensische wetenschapsprojecten voor middelbare scholieren

- Middelgrote carnivoren lopen het grootste risico door veranderingen in het milieu

- Een plantencelmodel maken met een schoenendoos

- Klimaatverandering zal naar verwachting kleiner worden, gestalte van dominante Midwest-plant, studie vondsten

- Wetenschappers ontwerpen bacteriën om sonarsignalen te reflecteren voor ultrasone beeldvorming

- Plantaanpassingen: woestijn, tropisch regenwoud, toendra

- Hoe worden genen aan- en uitgezet?

- eDNA gebruiken om de broedhabitat van bedreigde diersoorten te identificeren

- Stroomlijning van massaproductie van afdrukbare elektronica

- Voorbij Einstein:natuurkundigen lossen mysterie rond foton-momentum op

- Materie inspecteren met terahertz light

- Nieuw mondstuk bespaart kristallen - concept met dubbele stroom vergroot het spectrum voor eiwitkristallografie

- De ontwikkeling van fusie-energie versnellen om onbeperkte energie op aarde te creëren

Nieuwe bemanning legt aan bij het eerste permanente ruimtestation van China

Nieuwe bemanning legt aan bij het eerste permanente ruimtestation van China Mijlpaal:Capsule met dummy aan boord van dokken bij ruimtestation (update)

Mijlpaal:Capsule met dummy aan boord van dokken bij ruimtestation (update) Wat zijn de voordelen van eiwitten die worden geproduceerd door middel van recombinante DNA-technologie?

Wat zijn de voordelen van eiwitten die worden geproduceerd door middel van recombinante DNA-technologie?  Onderzoekers ontdekken dat inkomende studenten aparte netwerken opzetten voor empathie, plezier

Onderzoekers ontdekken dat inkomende studenten aparte netwerken opzetten voor empathie, plezier PPPL bestudeert de rol van plasma's bij het synthetiseren van nanodeeltjes

PPPL bestudeert de rol van plasma's bij het synthetiseren van nanodeeltjes Wanneer de beste stuntwaardige acrobaat een robot is

Wanneer de beste stuntwaardige acrobaat een robot is Wat als er geen zwaartekracht op aarde zou zijn?

Wat als er geen zwaartekracht op aarde zou zijn?  Biomimetische fotodetector ziet in kleur

Biomimetische fotodetector ziet in kleur

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com