Wetenschap

Nieuwe studie combineert lithofaan en 3D-printen zodat individuen gegevens kunnen zien, ongeacht hun gezichtsvermogen

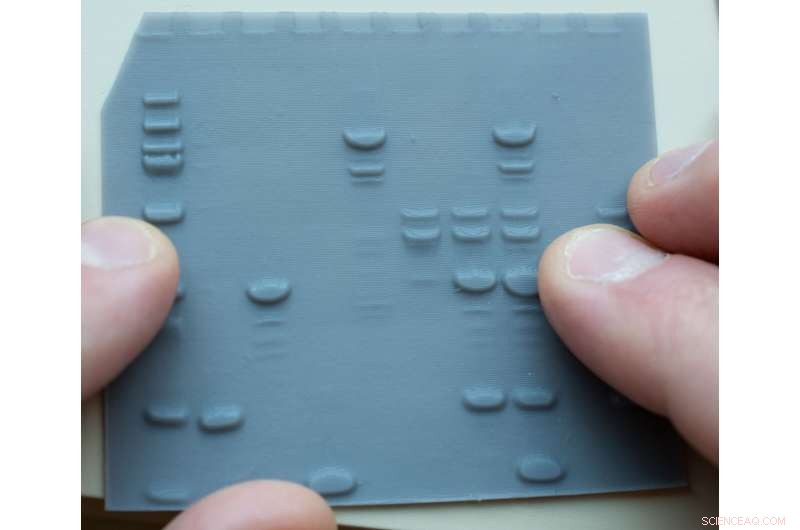

3D-geprinte lithofanen kunnen optisch gehandicapte wetenschappers helpen om gegevens, zoals van eiwitscheidingsgels, met hun vingertoppen te "zien". Krediet:Elizabeth Shaw

Een onderzoeksteam onder leiding van chemici van Baylor University heeft een baanbrekende stap voorwaarts gezet in het elimineren van de uitsluiting van personen met blindheid van scheikundeonderwijs en -ervaringen. In een artikel dat vandaag is gepubliceerd in Science Advances , beschrijven de onderzoekers hoe ze lithofaan - een ouderwetse kunstvorm - en 3D-printen gebruikten om wetenschappelijke gegevens om te zetten in tactiele afbeeldingen die gloeien met een video-achtige resolutie, waardoor universele visualisatie van hetzelfde stuk gegevens door zowel blinde als ziende personen mogelijk wordt.

Hoewel litofaan een oud artistiek medium is, is het tot nu toe nooit gebruikt om wetenschappelijke gegevens en beelden op een kwantitatieve, gecontroleerde manier weer te geven voor tactiele visualisatie en tactiele integratie.

De Baylor-studie, getiteld "Gegevens voor iedereen:tactiele afbeeldingen die oplichten met een perfecte resolutie", vergeleek hoe blinden en ziende mensen lithofaangegevens interpreteerden door aanraking of gezichtsvermogen. De deelnemerscohorten testten de vijf lithofaanvormen - gelelektroferogrammen, microfoto's, elektronische en massaspectra en tekstboekillustraties - en interpreteerden alle vijf lithofanen door tactiele waarneming of gezichtsvermogen met een algehele nauwkeurigheid van 79%, volgens het onderzoek.

De onderzoekers concentreerden zich op het maken en testen van lithofanen van gegevens die in de chemische wetenschappen worden gevonden vanwege de expliciete en systematische uitsluiting van studenten met blindheid van scheikunde, wat de onderzoekers opmerkten "kan worden gezien als een deugd door opvoeders, ouders, leeftijdsgenoten of zelf, op de basis van laboratoriumveiligheid en het 'visuele' karakter van chemie."

"Dit onderzoek is een voorbeeld van kunst die wetenschap toegankelijker en inclusiever maakt. Kunst redt de wetenschap van zichzelf", zegt Bryan Shaw, Ph.D., hoogleraar scheikunde en biochemie, die de Shaw Research Group bij Baylor leidt en corresponderend auteur is. op het tijdschriftartikel. "De gegevens en beelden van de wetenschap - bijvoorbeeld de verbluffende beelden die uit de nieuwe Webb-telescoop komen - zijn ontoegankelijk voor mensen die blind zijn. We laten echter zien dat dunne, doorschijnende tactiele afbeeldingen, lithofanen genaamd, al deze beelden kunnen maken toegankelijk voor iedereen, ongeacht het gezichtsvermogen. Zoals we graag zeggen, 'data for all.'"

Nieuw gebruik voor oude kunstvorm

Lithophanes zijn waarschijnlijk al in de zesde eeuw in China gemaakt en in de jaren 1800 populair in Europa. Het zijn dunne gravures gemaakt van doorschijnende materialen (eerst porselein en was, nu plastic) en lijken aanvankelijk ondoorzichtig in omgevingslicht. Als een lithofaan echter wordt verlicht door een lichtbron - van een plafondlamp tot zonlicht - gloeit een lithofaan als een digitaal beeld, waarbij de verstrooiing van licht door het doorschijnende materiaal ervoor zorgt dat dunnere gebieden helderder lijken en dikkere gebieden donkerder. Met behulp van gratis online software om een tweedimensionaal beeld om te zetten in een 3D-topograaf, gebruikten wetenschappers in dit onderzoek 3D-printen voor de lithofanen.

"Het idee van lithofanen was een concept waarmee Dr. Shaw aan het spelen was, en ik dacht dat het een geweldige kans was om een groep individuen te helpen die gestigmatiseerd zijn op het gebied van chemie," zei co-hoofdauteur Jordan Koone, een promovendus in de chemie bij Baylor en lid van Shaw's lab. "Het was geweldig om te zien dat blinde mensen, die hun hele leven te horen hebben gekregen dat ze niet kunnen uitblinken in de wetenschap, gegevens net zo gemakkelijk interpreteren als een ziend persoon."

De deelnemerscohorten omvatten ziende studenten met of zonder blinddoeken en vijf personen met blindheid die sinds hun kindertijd of adolescentie totale blindheid of slechtziendheid hebben ervaren. Vier van deze personen met blindheid hebben Ph.D. graden in scheikunde voor het testen, en de vijfde persoon is een niet-gegradueerde student aan Baylor die volledig verlies van het gezichtsvermogen ervoer als laatstejaarsstudent op de middelbare school. Deze blinde personen zijn co-auteurs van deze studie, maar hebben niet deelgenomen aan het ontwerp van de specifieke datasets.

"Voordat ik aan het lithofaanproject werkte, geloofde ik dat onderzoek beperkt was tot experimenten in een laboratoriumomgeving", zegt co-lead auteur Chad Dashnaw, een promovendus in de chemie bij Baylor, ook in het laboratorium van Shaw. "Maar onderzoek probeert gewoon onbeantwoorde vragen te beantwoorden, en ons werk hier beantwoordt een heel belangrijke:kunnen blinden deel uitmaken van STEM? Lithophanes bieden een gegevensformaat dat universeel kan worden gedeeld tussen ziende en blinde personen, waardoor STEM toegankelijker wordt voor degenen die eerder over het hoofd werden gezien."

Uit de studie bleek dat de gemiddelde testnauwkeurigheid voor alle vijf lithofanen was:

- 96,7% voor blinde tactiele interpretatie,

- 92,2% voor ziende interpretatie van lithofanen met tegenlicht, en

- 79,8% voor geblinddoekte tactiele interpretatie.

Ziende deelnemers waren in staat om digitale beelden op een computerscherm nauwkeurig te interpreteren met een gezichtsvermogen van 88,4%. Voor 80% van de vragen was de tactiele nauwkeurigheid van de blinde chemici gelijk aan of beter dan de visuele interpretatie van lithofanen, wat suggereert dat lithofanen zouden kunnen functioneren als een deelbaar gegevensformaat. Shaw zei zelfs dat sommige van de blinde chemici in het onderzoek zo'n tactiele gevoeligheid hebben dat ze tactiele kenmerken van de gegevens konden voelen die ziende individuen zichzelf nauwelijks konden zien.

Voor het eerst datasets 'zien'

Studie co-auteur Hoby B. Wedler, Ph.D., een ondernemer, chemicus en CEO van de Wedland Group in Petaluma, Californië, interpreteerde voor het eerst lithofaangegevens tijdens een Zoom-gesprek met Shaw. Voor zijn studieco-auteurs en collega-chemici was dit een zeer betekenisvol moment aangezien Wedler, die blind werd geboren maar een Ph.D. in theoretische scheikunde zag je voor het eerst gegevens door tactiele afbeeldingen met hoge resolutie aan te raken.

"Je kunt hiernaar kijken, en het ziet er precies uit wat ik voel," zei Wedler. "Ik heb nog nooit een massaspecificatie gevoeld. Ik had nooit gedacht dat ik door een analytische dataset als deze zou kunnen praten. The sky is the limit hier."

"Ze waren zo opgewonden om eindelijk de gegevens en beelden te zien waar ze al zo lang over hadden gehoord. En ze hebben deze gegevens ook gezien. Omdat je kijkt met je geest, niet met je ogen," zei Shaw.

Een van de meest opvallende co-auteurs van de studie was Baylor-student en onderzoeker, Noah Cook. Cook beëindigde afgelopen lente zijn eerste semester bij Baylor, ondanks het feit dat hij al zijn gezichtsvermogen verloor tijdens zijn laatste jaar op de middelbare school.

"De vijf blinde co-auteurs van dit project zijn enkele van de meest interessante en hardwerkende personen met wie ik ooit het genoegen heb gehad om mee samen te werken," zei Dashnaw. "Ze hebben jarenlang gehoord van dingen als SDS-PAGE of massaspectra. Maar ze hadden nooit de kans gehad om er zelf een te observeren, laat staan te interpreteren. De lithofanen gaven hen die mogelijkheid. Ze konden tot in detail uitleggen wat ze voelden en het kwam perfect overeen met wat we zagen."

Scheikunde openen voor de klassen K-12

Deze laatste studie waarbij de groep van Shaw betrokken is, breidt het onderzoek van Baylor uit om belemmeringen voor de studie en discipline van scheikunde voor K-12-studenten met blindheid of slechtziendheid weg te nemen.

Shaw ontving onlangs een subsidie van $ 1,3 miljoen van de National Institutes of Health (NIH) voor een eerste-van-zijn-soort vroege-interventieproject dat laboratoriumwerk opent en tactiele scheikunde-onderwijsmaterialen en -apparatuur levert. Door hightech en lowtech benaderingen te combineren, combineert het project robotica en technologie met educatief materiaal en "lab-hacks" die blinde en slechtziende studenten in staat stellen deel te nemen aan dezelfde rollen en routines als hun ziende tegenhangers, inclusief het gebruik van lithofanen.

"Het leuke van de tactiele afbeeldingen die oplichten met een perfecte resolutie, is dat alles wat ik met mijn ogen kan zien, een andere persoon die blind is met zijn vingers kan voelen. Dus het maakt alle afbeeldingen en gegevens met hoge resolutie toegankelijk en deelbaar, ongeacht het gezichtsvermogen. We kunnen met iedereen, blind of slechtziend, rondhangen en over exact dezelfde gegevens of afbeelding praten," zei Shaw.

Shaw en zijn medewerkers richten hun project in eerste instantie op middelbare scholieren door een proefprogramma te ontwikkelen voor 150 TSBVI-studenten om deel te nemen aan onderwijs en curriculum en om materiaal te trainen op zowel de schoolcampus als in het lab van Shaw in Baylor. De pilot zal naar verwachting dit najaar van start gaan, en het volledige programma zal naar verwachting van start gaan in het voorjaar van 2023 tot 2027. In de toekomst hoopt het team het programma op te schalen met hulpmiddelen voor kinderen die net beginnen met de studie van de wetenschap.

Voorbij chemie

Het litofaan-gegevensformaat of LDF, en de gegevens voor alle bewegingen, gaan verder dan scheikunde of wetenschap en kunnen worden gebruikt voor elk onderwerp, van kunst, geschiedenis, filosofie en overal waar beelden of afbeeldingen worden gebruikt, zei Shaw. Met dit laatste onderzoek is het pad naar deelbare en toegankelijke gegevens beschikbaar voor iedereen met tactiele zintuigen.

Voor promovendi Koone en Dashnaw benadrukt het onderzoek een van de kernwaarden van Baylor:de ontdekking van nieuwe kennis en onderzoek faciliteren dat de mensheid ten goede komt.

"Het meeste van het onderzoek dat ik dagelijks doe, zal geen significante impact hebben op de wetenschappelijke gemeenschap, maar het lithofaanproject zorgt voor echte verandering in realtime", zei Dashnaw. "We maken STEM toegankelijker voor mensen met een visuele beperking en vragen aandacht voor hun systemische uitsluiting." + Verder verkennen

Studie gebruikt snoepachtige modellen om STEM toegankelijk te maken voor slechtziende leerlingen

Lenen van de natuur om de kracht van de zon aan te boren

Lenen van de natuur om de kracht van de zon aan te boren Welke objecten zijn gemaakt van nikkel?

Welke objecten zijn gemaakt van nikkel?  AI zocht naar single-atom-alloy katalysatoren, 200 veelbelovende kandidaten gevonden

AI zocht naar single-atom-alloy katalysatoren, 200 veelbelovende kandidaten gevonden Kunnen we grafiet maken van steenkool? Onderzoekers beginnen met het vinden van nieuwe vaste koolstof

Kunnen we grafiet maken van steenkool? Onderzoekers beginnen met het vinden van nieuwe vaste koolstof Bacteriën onder een microscoop bekijken

Bacteriën onder een microscoop bekijken

NASA- en NOAA-satellieten volgen Alberto in het zuiden van de VS

NASA- en NOAA-satellieten volgen Alberto in het zuiden van de VS Meteoriet bevat het oudste materiaal op aarde:7 miljard jaar oud sterrenstof

Meteoriet bevat het oudste materiaal op aarde:7 miljard jaar oud sterrenstof Diepe sneeuwbedekking in het Noordpoolgebied intensiveert hittegolven in Eurazië

Diepe sneeuwbedekking in het Noordpoolgebied intensiveert hittegolven in Eurazië Onderzoekers onthullen dat Amerikaanse maïsgewassen gevoeliger worden voor droogte

Onderzoekers onthullen dat Amerikaanse maïsgewassen gevoeliger worden voor droogte Een lijst met landvormen in de tropische regio

Een lijst met landvormen in de tropische regio

Hoofdlijnen

- De definitie van lichaamssystemen

- Appelbomen dragen meer fruit als ze omringd zijn door goede buren

- Deoxyribonucleïnezuur (DNA): structuur, functie en belang

- Chloroplast & Mitochondria: wat zijn de overeenkomsten en verschillen?

- De ontwerpprincipes van celcompartimenten blootleggen

- Voeding die de productiviteit in de intensieve veehouderij verhoogt

- Arbusculaire mycorrhiza-schimmelgemeenschappen blootgesteld met nieuwe benadering van DNA-sequencing

- De terugkeer van wolven naar Oregon brengt conflicten en kansen

- Wild, eetbaar en voedzaam:onderzoek en recepten onthullen de voordelen van regionale Turkse planten

- Apple sluit tijdelijk winkels in China wegens virusuitbraak

- Hoe Ghana de overgang naar mobiele financiële diensten versnelt

- Nog geen akkoord tussen VS, China op ZTE:Trump-assistent

- Opkomende technologie toepassen om milieu-uitdagingen op te lossen

- Groene financiering bloeit nu beleggers verder kijken dan winst

NASA Twins-onderzoek wordt gerepliceerd op Everest

NASA Twins-onderzoek wordt gerepliceerd op Everest  Hoe AMU naar Mole te converteren

Hoe AMU naar Mole te converteren  Satellietweergave van de overgang van tropische storm Krosa in de zee van Japan

Satellietweergave van de overgang van tropische storm Krosa in de zee van Japan Werken internationale verdragen eigenlijk? Onderzoek zegt dat ze dat meestal niet

Werken internationale verdragen eigenlijk? Onderzoek zegt dat ze dat meestal niet Hoe een batterij te maken met Coke & Vinegar

Hoe een batterij te maken met Coke & Vinegar Echte patronen onderscheiden van eenvoudige menselijke misvattingen

Echte patronen onderscheiden van eenvoudige menselijke misvattingen Slimmer trainen van neurale netwerken

Slimmer trainen van neurale netwerken Voorspellingstool laat zien hoe het dunner worden van bossen de sneeuwlaag van Sierra Nevada kan vergroten

Voorspellingstool laat zien hoe het dunner worden van bossen de sneeuwlaag van Sierra Nevada kan vergroten

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com