Wetenschap

Als het om robots gaat, betrouwbaarheid kan belangrijker zijn dan redeneren

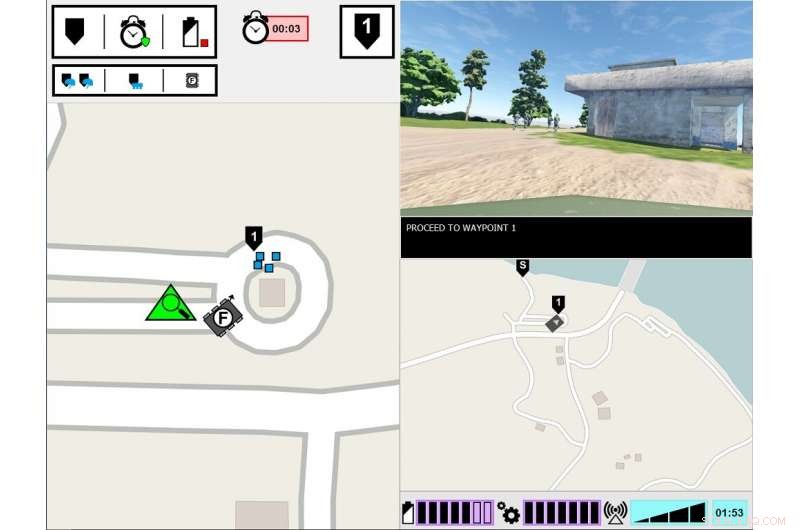

ASM experimentele interface. De linkermonitor toont het standpunt van de hoofdsoldaat van de taakomgeving. De rechtermonitor geeft de communicatie-interface van de ASM weer. Krediet:Amerikaanse leger

Wat is er nodig voor een mens om een robot te vertrouwen? Dat ontdekken legeronderzoekers in een nieuwe studie naar hoe mens en robot samenwerken.

Onderzoek naar mens-agent teaming, of HOED, heeft onderzocht hoe de transparantie van agenten, zoals robots, onbemande voertuigen of softwareagenten - beïnvloedt het menselijk vertrouwen, taakuitvoering, werkdruk en percepties van de agent. Transparantie van agenten verwijst naar het vermogen om de bedoeling, redeneerproces en toekomstplannen.

Nieuw door het leger geleid onderzoek toont aan dat het vertrouwen van mensen in robots afneemt nadat de robot een fout maakt. zelfs als het transparant is met zijn redeneringsproces. De krant, "Transparantie en betrouwbaarheid van agenten in interactie tussen mens en robot:de invloed op het vertrouwen van de gebruiker en de waargenomen betrouwbaarheid, " is gepubliceerd in het augustusnummer van IEEE-transacties op mens-machinesystemen .

Daten, onderzoek heeft zich grotendeels gericht op HAT met perfect betrouwbare intelligente agenten - wat betekent dat agenten geen fouten maken - maar dit is een van de weinige onderzoeken waarin is onderzocht hoe transparantie van agenten samenwerkt met betrouwbaarheid van agenten. In deze laatste studie mensen waren getuige van een robot die een fout maakte, en onderzoekers richtten zich op de vraag of de mensen de robot als minder betrouwbaar beschouwden, ook als de mens inzicht kreeg in het redeneerproces van de robot.

"Begrijpen hoe het gedrag van de robot hun menselijke teamgenoten beïnvloedt, is cruciaal voor de ontwikkeling van effectieve mens-robotteams, evenals het ontwerp van interfaces en communicatiemethoden tussen teamleden, " zei dr. Julia Wright, hoofdonderzoeker voor dit project en onderzoeker bij het legeronderzoekslaboratorium van het Amerikaanse leger Combat Capabilities Development Command, ook wel ARL genoemd. "Dit onderzoek draagt bij aan de inspanningen van het leger voor meerdere domeinen om te zorgen voor overmatch in capaciteiten die op kunstmatige intelligentie zijn gebaseerd. Maar het is ook interdisciplinair, aangezien zijn bevindingen het werk van psychologen zullen informeren, robotici, ingenieurs, en systeemontwerpers die werken aan een beter begrip tussen mensen en autonome agenten in een poging om autonome teamgenoten te maken in plaats van alleen maar hulpmiddelen.

Dit onderzoek was een gezamenlijke inspanning van ARL en het University of Central Florida Institute for Simulations and Training, en is de derde en laatste studie in het project Autonomous Squad Member (ASM), gesponsord door het Autonomy Research Pilot Initiative van de minister van Defensie. De ASM is een kleine grondrobot die interageert met en communiceert met een infanterieploeg.

Eerdere ASM-onderzoeken onderzochten hoe een robot zou communiceren met een menselijke teamgenoot. Met behulp van het Situation Awareness-based Agent Transparency-model als richtlijn, verschillende visualisatiemethoden om de doelen van de agent over te brengen, bedoelingen, redenering, beperkingen, en geprojecteerde resultaten werden verkend en getest. Op basis van deze vroege onderzoeksresultaten werd een in één oogopslag een iconografische module ontwikkeld. en werd vervolgens in daaropvolgende onderzoeken gebruikt om de werkzaamheid van agenttransparantie in HAT te onderzoeken.

Onderzoekers voerden deze studie uit in een gesimuleerde omgeving, waarin deelnemers een militair-agent-team observeerden, waaronder de ASM, een opleiding volgen. De taak van de deelnemers was om het team te monitoren en de robot te evalueren. Het Soldier-robot-team kwam verschillende gebeurtenissen langs het parcours tegen en reageerde dienovereenkomstig. Terwijl de Soldiers altijd correct reageerden op de gebeurtenis, af en toe begreep de robot de situatie verkeerd, leidt tot verkeerde handelingen. De hoeveelheid informatie die de robot deelde, varieerde tussen de proeven. Terwijl de robot altijd zijn acties uitlegde, de redenen achter zijn acties en het verwachte resultaat van zijn acties, in sommige proeven deelde de robot ook de redenering achter zijn beslissingen, zijn onderliggende logica. Deelnemers bekeken meerdere Soldier-robot teams, en hun beoordelingen van de robots werden vergeleken.

Uit de studie bleek dat, ongeacht de transparantie van de robot bij het uitleggen van zijn redenering, de betrouwbaarheid van de robot was de ultieme bepalende factor bij het beïnvloeden van de projecties van de deelnemers over de toekomstige betrouwbaarheid van de robot, vertrouwen in de robot en percepties van de robot. Dat is, nadat deelnemers getuige waren van een fout, ze bleven de betrouwbaarheid van de robot lager beoordelen, zelfs als de robot daarna geen fouten meer maakte. Hoewel deze evaluaties in de loop van de tijd langzaam verbeterden, zolang de robot geen verdere fouten maakte, het vertrouwen van de deelnemers in hun eigen beoordeling van de betrouwbaarheid van de robot bleef gedurende de rest van de proeven verminderd, in vergelijking met deelnemers die nooit een fout hebben gezien. Verder, deelnemers die getuige waren van een robotfout rapporteerden een lager vertrouwen in de robot, in vergelijking met degenen die nog nooit een robotfout hebben gezien.

Het vergroten van de transparantie van agenten bleek het vertrouwen van deelnemers in de robot te vergroten, maar alleen wanneer de robot informatie aan het verzamelen of filteren was. Dit zou erop kunnen wijzen dat het delen van diepgaande informatie enkele van de effecten van onbetrouwbare automatisering voor specifieke taken kan verminderen, zei Wright. Aanvullend, deelnemers beoordeelden de onbetrouwbare robot als minder levendig, sympathiek, intelligent, en veilig dan de betrouwbare robot.

"Eerdere studies suggereren dat context van belang is bij het bepalen van het nut van transparantie-informatie, Wright zei. "We moeten beter begrijpen welke taken een meer diepgaand begrip van de redenering van de agent vereisen, en hoe te onderscheiden wat die diepte zou inhouden. Toekomstig onderzoek moet manieren onderzoeken om transparantie-informatie te leveren op basis van de taakvereisten."

Chemische detectiecellen helemaal opnieuw synthetiseren

Chemische detectiecellen helemaal opnieuw synthetiseren Efficiënte scheiding van glycopeptiden bereikt door grensvlakgepolymeriseerde polymeerdeeltjes

Efficiënte scheiding van glycopeptiden bereikt door grensvlakgepolymeriseerde polymeerdeeltjes Ferrofluide oppervlaktesimulaties gaan verder dan alleen de huid

Ferrofluide oppervlaktesimulaties gaan verder dan alleen de huid Onderzoekers ontwikkelen chemie die nodig is om marihuana-ademtester te maken

Onderzoekers ontwikkelen chemie die nodig is om marihuana-ademtester te maken Dankzij de techniek voor het bewerken van genen kunnen zijderupsen spinnenzijde produceren

Dankzij de techniek voor het bewerken van genen kunnen zijderupsen spinnenzijde produceren

Hoeveel koolstof kunnen polaire ecosystemen op de zeebodem opslaan?

Hoeveel koolstof kunnen polaire ecosystemen op de zeebodem opslaan? Oceaancirculatie is waarschijnlijk de oorzaak van de ernst van het rode tij van 2018

Oceaancirculatie is waarschijnlijk de oorzaak van de ernst van het rode tij van 2018 Geen El Niño? Geen probleem. Aarde sist tot bijna recordhitte

Geen El Niño? Geen probleem. Aarde sist tot bijna recordhitte Een warmer klimaat zal ook een droger klimaat zijn, met negatieve gevolgen voor de bosgroei

Een warmer klimaat zal ook een droger klimaat zijn, met negatieve gevolgen voor de bosgroei Hoe Californië de terugdraaiing van het milieu van Trump blijft blokkeren

Hoe Californië de terugdraaiing van het milieu van Trump blijft blokkeren

Hoofdlijnen

- Wat is een Mordant in de microbiologie?

- De dichtheid van de Wolbachia-bacterie verandert per seizoen bij vlinders

- Valse oogvlekken intimideren roofdieren, onderzoekers vinden

- Meer bewijs dat Neanderthalers niet dom waren:ze maakten hun eigen touwtje

- Typen morfologie

- Verdraaide seks zorgt ervoor dat slakken in spiegelbeeld face-to-face kunnen paren, onderzoek vindt

- Waarom hebben we enzymen nodig voor de spijsvertering?

- Een benadering van het hele lichaam om chemosensorische cellen te begrijpen

- Welke chemische verbindingen zijn verantwoordelijk voor de smaken van bitter, zuur, zout en zoet?

- Een multi-representatieve convolutionele neurale netwerkarchitectuur voor tekstclassificatie

- Onderzoeker bestudeert stroomverbruik van cloudinfrastructuren

- VW schrapt duizenden banen om elektrische transitie te financieren

- IJsland bovenaan Europa als duurste

- Facebook stopt productie drones voor internetbezorging

Recordbrekende chaotische gegevensoverdracht

Recordbrekende chaotische gegevensoverdracht Nanoporiën liggen ten grondslag aan ons vermogen om af te stemmen op een enkele stem

Nanoporiën liggen ten grondslag aan ons vermogen om af te stemmen op een enkele stem Newfoundland meerdere keren bevolkt door verschillende groepen, DNA-bewijs laat zien

Newfoundland meerdere keren bevolkt door verschillende groepen, DNA-bewijs laat zien Als je niest met je ogen open,

Als je niest met je ogen open,  10 nieuwe toepassingen voor oude uitvindingen

10 nieuwe toepassingen voor oude uitvindingen  Wat zijn energiegerelateerde organellen?

Wat zijn energiegerelateerde organellen?  Wetenschappers zetten koolstofemissies om in bruikbare energie

Wetenschappers zetten koolstofemissies om in bruikbare energie Nieuwe methode voor snelle 3D-microscopie

Nieuwe methode voor snelle 3D-microscopie

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- Italian | Spanish | Portuguese | Swedish | German | Dutch | French | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com