Wetenschap

Vooroordelen in AI elimineren

Krediet:Sébastien Thibault

Bij mensen, intelligentie is geen inenting tegen vooringenomenheid en onverdraagzaamheid. Hetzelfde geldt voor computers. Intelligente machines leren over de wereld door de filters van menselijke taal en historisch gedrag - wat betekent dat ze net zo gemakkelijk de slechtste waarden van de mensheid kunnen absorberen als haar beste.

Onderzoekers die steeds slimmere machines willen ontwikkelen, hebben hun werk te doen om ervoor te zorgen dat ze niet per ongeluk computers doordrenken met vrouwenhaat, racisme of andere vormen van onverdraagzaamheid.

"Het is een enorm risico, " zegt Marzyeh Ghassemi, een assistent-professor aan de afdeling computerwetenschappen en de faculteit geneeskunde van de Universiteit van Toronto, die zich richt op toepassingen in de gezondheidszorg voor kunstmatige intelligentie (AI). "Zoals alle vorderingen die samenlevingen vooruit helpen, er zijn grote risico's die we moeten beslissen om te accepteren of niet te accepteren."

Bias kan op veel manieren in algoritmen kruipen. In een zeer invloedrijke tak van AI die bekend staat als "natuurlijke taalverwerking, " problemen kunnen voortkomen uit het "tekstcorpus" - het bronmateriaal dat het algoritme gebruikt om meer te weten te komen over de relaties tussen verschillende woorden.

Natuurlijke taalverwerking, of "NLP, " stelt een computer in staat om menselijke spraak te begrijpen - informeel, conversatie en contextueel. NLP-algoritmen kammen door miljarden woorden trainingstekst - het corpus zou kunnen zijn, zeggen, het geheel van Wikipedia. Eén algoritme werkt door aan elk woord een reeks getallen toe te kennen die verschillende aspecten van de betekenis weerspiegelt, bijvoorbeeld 'koning' en 'koningin', zou vergelijkbare scores hebben met betrekking tot het idee van royalty's, maar tegengestelde scores met betrekking tot geslacht. NLP is een krachtig systeem waarmee machines kunnen leren over relaties tussen woorden - in sommige gevallen zonder directe menselijke tussenkomst.

"Ook al leren we ze niet altijd specifiek, wat ze leren is ongelooflijk, " zegt Kawin Ethayarajh, een onderzoeker die zich mede richt op eerlijkheid en rechtvaardigheid in AI-toepassingen. "Maar het is ook een probleem. In het corpus, de relatie tussen 'koning' en 'koningin' kan vergelijkbaar zijn met de relatie tussen 'dokter' en 'verpleegster'."

Maar natuurlijk, alle koningen zijn mannen; niet alle artsen zijn mannen. En niet alle verpleegsters zijn vrouwen.

Wanneer een algoritme de seksistische stijlfiguren van historische menselijke attitudes absorbeert, het kan leiden tot levensechte gevolgen, zoals gebeurde in 2014 toen Amazon een algoritme ontwikkelde om de cv's van sollicitanten te controleren. Het bedrijf heeft zijn machines getraind met behulp van 10 jaar aanwervingsbeslissingen. Maar anno 2015 zij erkenden dat, bij testen, het systeem gaf onverdiende voorkeur aan cv's van mannelijke sollicitanten. Ze hebben het systeem aangepast om het te dwingen genderinformatie te negeren, maar sloot uiteindelijk het project af voordat het daadwerkelijk in gebruik werd genomen, omdat ze er niet zeker van konden zijn dat hun algoritme geen andere vormen van discriminatie pleegde.

Het verzachten van seksistisch bronnenmateriaal kan technologische en methodologische aanpassingen met zich meebrengen. "Als we precies kunnen begrijpen welke onderliggende aannames het corpus heeft die ervoor zorgen dat deze vooroordelen worden geleerd, we kunnen corpora selecteren zonder die vooroordelen of het corrigeren tijdens het trainingsproces, ", zegt Ethaharajh.

Het is gebruikelijk dat onderzoekers een algoritme ontwerpen dat nadelige aannames automatisch corrigeert. Door het gewicht aan te passen van de getallen die het aan elk woord toekent, de computer kan seksistische of racistische associaties vermijden.

Maar wat zijn precies de aannames die moeten worden gecorrigeerd? Hoe ziet een eerlijke AI er echt uit? Debatten over voorrechten, onverdraagzaamheid, diversiteit en systemische vooroordelen zijn nog lang niet opgelost. Moet een wervingsalgoritme een standpunt innemen over positieve actie? Moet een zelfrijdende auto extra oppassen als een ander voertuig een "Baby aan boord"-sticker heeft? Hoe moet een AI-gestuurde analyse van juridische documenten een rol spelen bij de historische behandeling van inheemse volkeren? Omstreden maatschappelijke vraagstukken verdwijnen niet alleen doordat machines bepaalde aanbevelingen of beslissingen overnemen.

Veel mensen zien Canada's gebrekkige maar relatief succesvolle model van multiculturalisme als een kans om het voortouw te nemen in eerlijk AI-onderzoek.

"Canada heeft zeker een kans, " zegt Ronald Baecker, emeritus hoogleraar informatica en auteur van Computers and Society:Modern Perspectives. Hij ziet een rol voor de overheid om de maatschappelijke ongelijkheid te herstellen, onrechtvaardigheden en vooroordelen in verband met AI door, bijvoorbeeld, het instellen van bescherming voor werknemers die ervoor kiezen om zich uit te spreken tegen vooringenomen of oneerlijke AI-gestuurde producten. "Er is behoefte aan meer denkwerk en wetgeving met betrekking tot het concept van wat ik 'gewetensbezwaren' van hightech-medewerkers zou noemen."

Hij vindt ook dat de computerwetenschappers die slimme technologieën ontwikkelen, verplicht zouden moeten worden om de maatschappelijke impact van dergelijk werk te bestuderen. "Het is belangrijk dat professionals die in AI werken hun verantwoordelijkheid erkennen, " zegt hij. "We hebben te maken met situaties van leven en dood in steeds belangrijker wordende activiteiten waarbij AI wordt gebruikt."

Algoritmen die rechters helpen bij het vaststellen van borgtocht en het veroordelen van criminelen, kunnen al lang bestaande vooroordelen in het rechtssysteem opvangen, zoals het behandelen van geracialiseerde mensen alsof ze meer kans hebben om nog meer misdaden te plegen. De algoritmen kunnen mensen uit bepaalde gemeenschappen markeren als een te hoog risico om een banklening te ontvangen. Ze zijn mogelijk ook beter in het diagnosticeren van huidkanker bij blanke mensen dan bij mensen met een donkerdere huid, als gevolg van het feit dat ze zijn getraind op scheef bronmateriaal.

Er staat ongelooflijk veel op het spel in de gezondheidszorg, waar onbillijke algoritmen mensen die in het verleden slecht werden bediend nog verder in de marge zouden kunnen duwen.

In haar werk aan de U of T en aan het Vector Institute for Artificial Intelligence, Ghassem, net als andere onderzoekers, doet er alles aan om mogelijke vooringenomenheid en ongelijkheid in haar algoritmen te identificeren. Ze vergelijkt de aanbevelingen en voorspellingen van haar diagnostische tools met real-world resultaten, het meten van hun nauwkeurigheid voor verschillende geslachten, rassen, leeftijden en sociaaleconomische factoren.

In theorie, Canada biedt een voorsprong voor onderzoekers die geïnteresseerd zijn in toepassingen in de gezondheidszorg die de waarden van eerlijkheid weerspiegelen, diversiteit en inclusie. Ons universele gezondheidszorgsysteem creëert een opslagplaats van elektronische medische dossiers die een schat aan medische gegevens biedt die kunnen worden gebruikt om AI-gestuurde toepassingen te trainen. Dit potentieel trok Ghassemi naar Toronto. Maar de technologie, informatie, opmaak en regels om toegang te krijgen tot deze records variëren van provincie tot provincie, waardoor het ingewikkeld wordt om het soort datasets te maken die het onderzoek vooruit kunnen helpen.

Ghassemi was ook verrast om te horen dat deze records slechts zelden gegevens over ras bevatten. Dit betekent dat als ze een algoritme gebruikt om te bepalen hoe goed een bepaalde behandeling verschillende sectoren van de samenleving bedient, ze kon verschillen tussen mannen en vrouwen identificeren, bijvoorbeeld, maar niet tussen blanke mensen en geracialiseerde mensen. Als resultaat, in haar onderwijs en onderzoek, ze gebruikt openbaar beschikbare Amerikaanse gegevens die informatie over ras bevatten.

"Mijn eigen modellen controleren [met behulp van Amerikaanse gegevens], Ik kan laten zien wanneer iets een grotere onnauwkeurigheid heeft voor mensen met verschillende etniciteiten, "zegt ze. "Ik kan deze beoordeling niet maken in Canada. Ik kan het op geen enkele manier controleren."

Ghassemi is geïnteresseerd in het maken van AI-applicaties die op zichzelf eerlijk zijn - en die mensen ook kunnen helpen hun eigen vooroordelen tegen te gaan. "Als we instrumenten kunnen bieden op basis van grote diverse populaties, we geven artsen iets waardoor ze betere keuzes kunnen maken, " ze zegt.

Vrouwen, bijvoorbeeld, zijn aanzienlijk ondergediagnosticeerd voor hartaandoeningen. Een AI kan zo'n gevaar signaleren voor een arts die het misschien over het hoofd ziet. "Dat is een plek waar een technologische oplossing kan helpen, omdat artsen mensen zijn, en mensen zijn bevooroordeeld, " ze zegt.

Ethaharajh is het met Ghassemi en Baecker eens dat Canada een belangrijke kans heeft om zijn voordeel uit te oefenen op eerlijkheid en vooringenomenheid in onderzoek naar kunstmatige intelligentie.

"Ik denk dat AI-onderzoekers hier zich zeer bewust zijn van het probleem, " Zegt Ethaharajh. "Ik denk dat een deel daarvan is, als je het kantoor rondkijkt, je ziet veel verschillende gezichten. De mensen die aan deze modellen werken, zijn eindgebruikers van deze modellen. Breder, Ik denk dat er een zeer sterke culturele focus is op eerlijkheid, waardoor dit een belangrijk gebied is voor onderzoekers in dit land."

Kookchemie minus hitte is gelijk aan nieuwe niet-giftige lijm

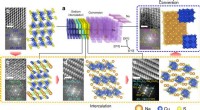

Kookchemie minus hitte is gelijk aan nieuwe niet-giftige lijm Een nieuwe strategie om 2-D anorganische materialen te synthetiseren die in condensatoren worden gebruikt, batterijen, en composieten

Een nieuwe strategie om 2-D anorganische materialen te synthetiseren die in condensatoren worden gebruikt, batterijen, en composieten Doorbraak in de elektrochemie vereenvoudigt het maken van felbegeerde moleculen voor medicijnen, elektronica

Doorbraak in de elektrochemie vereenvoudigt het maken van felbegeerde moleculen voor medicijnen, elektronica Onderzoekers ontwikkelen sensoren die menselijke biomarkers en giftig gas detecteren

Onderzoekers ontwikkelen sensoren die menselijke biomarkers en giftig gas detecteren Efficiënte bottom-up synthese van nieuw perovskietmateriaal voor de productie van ammoniak

Efficiënte bottom-up synthese van nieuw perovskietmateriaal voor de productie van ammoniak

VN-rapport over opwarming van de aarde bevat waarschuwing op leven of dood

VN-rapport over opwarming van de aarde bevat waarschuwing op leven of dood Afbeelding:Halloween-scheur in de Brunt-ijsplaat

Afbeelding:Halloween-scheur in de Brunt-ijsplaat Ongebruikte bron, of de dreiging van broeikasgassen, gevonden onder de rifting-as voor de kust van Okinawa

Ongebruikte bron, of de dreiging van broeikasgassen, gevonden onder de rifting-as voor de kust van Okinawa Californië verklaart hardnekkige droogte officieel voorbij

Californië verklaart hardnekkige droogte officieel voorbij Welke twee factoren beïnvloeden regio's Fotosynthetische productiviteit?

Welke twee factoren beïnvloeden regio's Fotosynthetische productiviteit?

Hoofdlijnen

- Celstructuurdefinities

- De soorten elektroforese

- Bang voor spinnen? Het kan in je DNA zitten

- Wat zijn de verschillen tussen PCR en klonen?

- Oude Egyptische zwangerschapstest overleefde millennia omdat het werkte

- Op de vleugels van Lepidoptera

- Flagella: soorten, functie en structuur

- We kunnen allemaal stoppen met het misbruiken van deze psychologische termen

- Zouttolerante planten kweken

- YouTube breidt muziekstreamingservice uit naar Europa

- Zijn wervingsalgoritmen eerlijk? Ze zijn te ondoorzichtig om te vertellen, studie vondsten

- Team ontwikkelt natriumionbatterijen met kopersulfide

- Poll:Privacydebacle leidt tot veranderingen op sociale media

- Drones kunnen nu terrein en opgravingen scannen zonder menselijke tussenkomst

Het goede, slecht en het onbekende van de nieuwe diensten van Apple

Het goede, slecht en het onbekende van de nieuwe diensten van Apple FCC houdt grote 5G-veiling $ 20 miljard uitgeven aan internet op het platteland

FCC houdt grote 5G-veiling $ 20 miljard uitgeven aan internet op het platteland Schokfront gesondeerd door protonen

Schokfront gesondeerd door protonen Muggenzwermen vertonen mechanische eigenschappen, gedragen als een visco-elastisch materiaal

Muggenzwermen vertonen mechanische eigenschappen, gedragen als een visco-elastisch materiaal Bereken de antenne en torenhoogte

Bereken de antenne en torenhoogte Verwijderen van Mucus

Verwijderen van Mucus In vergelijking met nomadische gemeenschappen, Steden aan de zijderoute waren stedelijke voedselwoestijnen

In vergelijking met nomadische gemeenschappen, Steden aan de zijderoute waren stedelijke voedselwoestijnen Nieuwe supercomputer in Texas om de grenzen van de wetenschap te verleggen

Nieuwe supercomputer in Texas om de grenzen van de wetenschap te verleggen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Swedish | German | Dutch | Danish | Norway | Portuguese |

-

Wetenschap © https://nl.scienceaq.com