Wetenschap

Facebook genereert automatisch video's waarin extremistische beelden worden gevierd

Een banner met de tekst "De Islamitische Staat" wordt weergegeven op de Facebook-pagina van een gebruiker die zichzelf identificeert als Nawan Al-Farancsa. De pagina was dinsdag nog live, 7 mei 2019, toen de schermgreep werd gemaakt. Facebook zegt dat het robuuste systemen heeft om inhoud van extremistische groepen te verwijderen, maar de klacht van een verzegelde klokkenluider die door de AP is beoordeeld, zegt dat verboden inhoud op internet blijft en gemakkelijk te vinden is. (Facebook via AP)

De animatievideo begint met een foto van de zwarte vlaggen van de jihad. Seconden later, het flitst hoogtepunten uit een jaar van posts op sociale media:plaquettes met antisemitische verzen, praten over vergelding en een foto van twee mannen die meer jihadistische vlaggen dragen terwijl ze de sterren en strepen verbranden.

Het is niet geproduceerd door extremisten; het is gemaakt door Facebook. In een slim stukje zelfpromotie, de socialemediagigant neemt een jaar van de inhoud van een gebruiker en genereert automatisch een feestelijke video. In dit geval, de gebruiker noemde zichzelf "Abdel-Rahim Moussa, het kalifaat."

"Bedankt dat je er bent, van Facebook, " de video eindigt in een cartoon-bubbel voordat de beroemde "duim omhoog" van het bedrijf flitst.

Facebook wil graag de indruk wekken extremisten voor te blijven door hun berichten te verwijderen, vaak voordat gebruikers ze zelfs maar zien. Maar de klacht van een vertrouwelijke klokkenluider bij de Securities and Exchange Commission, verkregen door The Associated Press, beweert dat het socialemediabedrijf zijn succes heeft overdreven. Nog erger, het laat zien dat het bedrijf onbedoeld gebruik maakt van propaganda van militante groepen om automatisch video's en pagina's te genereren die door extremisten kunnen worden gebruikt om te netwerken.

Volgens de klacht over een periode van vijf maanden vorig jaar, onderzoekers hebben pagina's gevolgd van gebruikers die zich hebben aangesloten bij groepen die het Amerikaanse ministerie van Buitenlandse Zaken heeft aangewezen als terroristische organisaties. In die periode, 38% van de berichten met prominente symbolen van extremistische groeperingen werd verwijderd. In zijn eigen recensie, de AP ontdekte dat vanaf deze maand, veel van de verboden inhoud die in het onderzoek wordt genoemd – een executievideo, afbeeldingen van afgehakte hoofden, propaganda ter ere van gemartelde militanten - glipte door het algoritmische web en bleef gemakkelijk te vinden op Facebook.

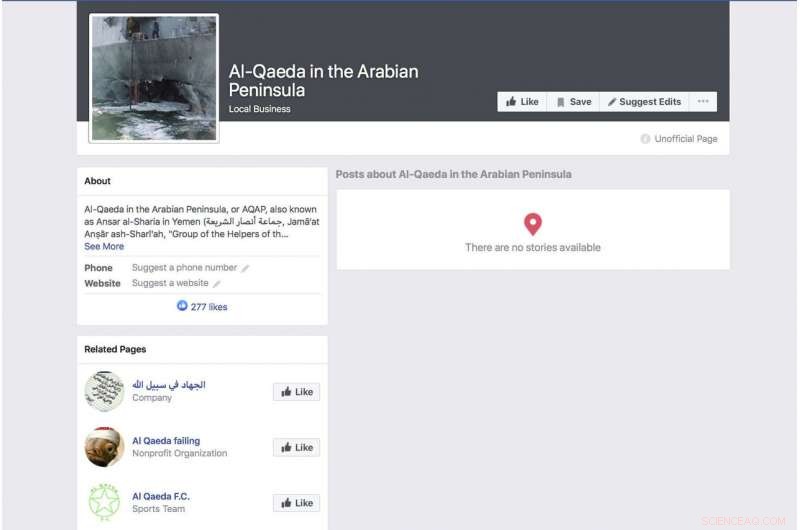

Een automatisch gegenereerde Facebook-pagina voor een groep die zichzelf identificeert als de terreurgroep "Al-Qaeda op het Arabische schiereiland" toont een foto van het gebombardeerde oorlogsschip USS Cole. De pagina was dinsdag nog steeds live, 7 mei 2019, toen de schermgreep werd gemaakt. Facebook zegt dat het robuuste systemen heeft om inhoud van extremistische groepen te verwijderen, maar de klacht van een verzegelde klokkenluider die door de AP is beoordeeld, zegt dat verboden inhoud op internet blijft en gemakkelijk te vinden is. (Facebook via AP)

De klacht komt binnen terwijl Facebook probeert een groeiend aantal kritiek voor te blijven op zijn privacypraktijken en zijn vermogen om haatdragende taal te houden, live gestreamde moorden en zelfmoorden buiten zijn dienst. Tegenover kritiek, CEO Mark Zuckerberg heeft gesproken over zijn trots op het vermogen van het bedrijf om gewelddadige berichten automatisch te verwijderen door middel van kunstmatige intelligentie. Tijdens een winstoproep vorige maand, bijvoorbeeld, hij herhaalde een zorgvuldig geformuleerde formulering die Facebook heeft gebruikt.

"Op gebieden als terrorisme, voor al-Qaida en ISIS-gerelateerde inhoud, nu 99 procent van de inhoud die we verwijderen in de categorie die onze systemen proactief markeren voordat iemand het ziet, " zei hij. Toen voegde hij eraan toe:"Dat is hoe echt goed eruit ziet."

Zuckerberg heeft geen schatting gegeven van hoeveel van het totale verboden materiaal wordt verwijderd.

Het onderzoek achter de SEC-klacht is gericht op het onder de aandacht brengen van flagrante gebreken in de aanpak van het bedrijf. Vorig jaar, onderzoekers begonnen gebruikers te monitoren die zich expliciet identificeerden als leden van extremistische groeperingen. Het was niet moeilijk om te documenteren. Sommige van deze mensen noemen zelfs de extremistische groeperingen als hun werkgevers. Een profiel dat werd aangekondigd door de zwarte vlag van een aan al-Qaida gelieerde groep, vermeldde zijn werkgever, misschien grappig, als Facebook. Het profiel met de automatisch gegenereerde video met het branden van de vlag bevatte ook een video van al-Qaida-leider Ayman al-Zawahiri die jihadistische groepen aanspoorde om niet onderling te vechten.

Hoewel het onderzoek verre van alomvattend is - deels omdat Facebook zelden veel van zijn gegevens openbaar maakt - zeggen onderzoekers die bij het project betrokken zijn dat het gemak waarmee deze profielen kunnen worden geïdentificeerd met behulp van een eenvoudige zoekopdracht op trefwoorden en het feit dat er zo weinig van zijn verwijderd, suggereren dat de beweringen van Facebook dat zijn systemen de meeste extremistische inhoud opvangen, niet kloppen.

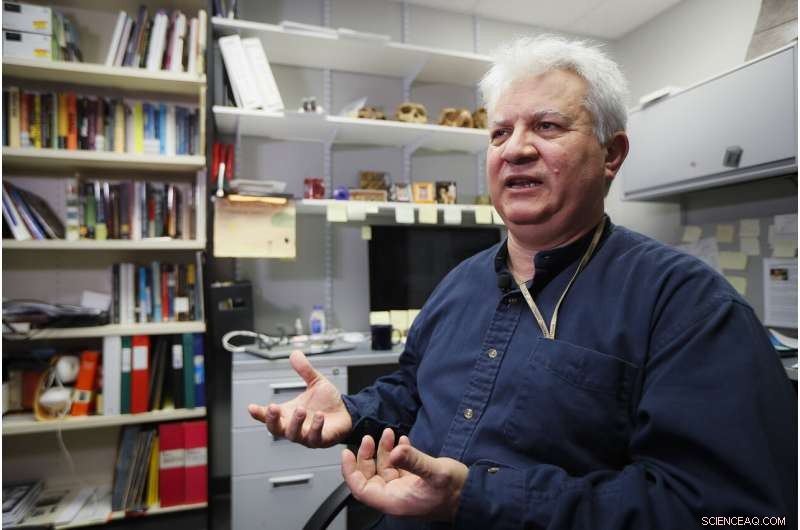

Amr Al Azm, een professor in de geschiedenis en antropologie van het Midden-Oosten aan de Shawnee State University, spreekt op zijn kantoor op 25 april 2019, in Portsmouth, Ohio. Facebook wekt de indruk dat het de overgrote meerderheid van extremistische berichten stopt voordat gebruikers ze ooit zien. Maar de klacht van een vertrouwelijke klokkenluider bij de Securities and Exchange Commission, verkregen door The Associated Press, beweert dat het socialemediabedrijf zijn succes heeft overdreven. "Ik bedoel, dat is gewoon de verbeelding uitrekken tot voorbij ongeloof, " zegt, Al Azm een van de bij het project betrokken onderzoekers. "Als een kleine groep onderzoekers met eenvoudige zoekopdrachten honderden pagina's met inhoud kan vinden, waarom kan een gigantisch bedrijf met al zijn middelen dat niet doen?" (AP Photo/John Minchillo)

"Ik bedoel, dat is gewoon de verbeelding uitrekken tot voorbij ongeloof, " zegt Amr Al Azm, een van de bij het project betrokken onderzoekers. "Als een kleine groep onderzoekers met eenvoudige zoekopdrachten honderden pagina's met inhoud kan vinden, waarom kan een gigantisch bedrijf met al zijn middelen dat niet doen?"

Al Azm, een professor in geschiedenis en antropologie aan de Shawnee State University in Ohio, heeft ook leiding gegeven aan een groep in Syrië die de plundering en smokkel van antiquiteiten documenteert.

Facebook geeft toe dat zijn systemen niet perfect zijn, maar zegt dat het verbeteringen aanbrengt.

"Na zware investeringen te hebben gedaan, we detecteren en verwijderen terrorisme-inhoud met een veel hoger succespercentage dan zelfs twee jaar geleden, "Het bedrijf zei in een verklaring. "We beweren niet alles te vinden en we blijven waakzaam in onze inspanningen tegen terroristische groeperingen over de hele wereld."

Reageren op de rapportage van de AP, Vertegenwoordiger Bennie Thompson, D-Miss., de voorzitter van de House Homeland Security Committee uitte zijn frustratie dat Facebook zo weinig vooruitgang heeft geboekt bij het blokkeren van inhoud, ondanks de geruststellingen die hij van het bedrijf kreeg.

Een Facebook-pagina voor gebruiker Ramadan kareem, dat, wanneer vertaald in het Engels, de gebruiker vermeldt als werkend bij "Islamic State in Sham and Iraq." De pagina was dinsdag nog live, 7 mei 2019, toen de schermgreep werd gemaakt. Facebook zegt dat het robuuste systemen heeft om inhoud van extremistische groepen te verwijderen, maar de klacht van een verzegelde klokkenluider die door de AP is beoordeeld, zegt dat verboden inhoud op internet blijft en gemakkelijk te vinden is. (Facebook via AP)

"Dit is opnieuw een zeer zorgwekkend voorbeeld van het onvermogen van Facebook om zijn eigen platforms te beheren - en de mate waarin het zijn daad moet opschonen, " zei hij. "Facebook moet niet alleen zijn platforms ontdoen van terroristische en extremistische inhoud, maar het moet ook kunnen voorkomen dat het wordt versterkt."

Maar als een grimmige indicatie van hoe gemakkelijk gebruikers Facebook kunnen ontwijken, een pagina van een gebruiker met de naam "Nawan al-Farancsa" heeft een kop waarvan de witte letters tegen een zwarte achtergrond in het Engels "The Islamic State" zeggen. De banner wordt onderbroken door een foto van een explosieve paddenstoelwolk die oprijst uit een stad.

Het profiel had de aandacht van Facebook moeten trekken, evenals van contra-inlichtingenbureaus. Het werd opgericht in juni 2018, vermeldt de gebruiker als afkomstig uit Tsjetsjenië, ooit een militante hotspot. Er staat dat hij in Heidelberg woonde, Duitsland, en studeerde aan een universiteit in Indonesië. Sommige vrienden van de gebruiker plaatsten ook militante inhoud.

De pagina, nog steeds de laatste dagen, blijkbaar ontsnapt aan de systemen van Facebook, vanwege een voor de hand liggende en langdurige ontduiking van moderatie die Facebook bedreven zou moeten zijn in het herkennen:de letters waren geen doorzoekbare tekst, maar ingebed in een grafisch blok. Maar het bedrijf zegt dat zijn technologie audio scant, video en tekst, ook wanneer deze is ingesloten, voor afbeeldingen die geweld weerspiegelen, wapens of logo's van verboden groepen.

De sociale netwerkgigant heeft een zware twee jaar doorstaan, beginnend in 2016, toen het Russische gebruik van sociale media om zich met de Amerikaanse presidentsverkiezingen te bemoeien in beeld kwam. Zuckerberg bagatelliseerde aanvankelijk de rol die Facebook speelde bij de beïnvloedingsoperatie van de Russische inlichtingendienst, maar het bedrijf verontschuldigde zich later.

Een Facebook-pagina voor een gebruiker die zich in het Engels vertaalt als "Lights of bitterness" waarop de gebruiker wordt vermeld als arts bij de Islamitische Staat. De pagina was dinsdag nog steeds live, 7 mei 2019, toen de schermgreep werd gemaakt. Facebook zegt dat het robuuste systemen heeft om inhoud van extremistische groepen te verwijderen, maar de klacht van een klokkenluider die door de AP is beoordeeld, zegt dat verboden inhoud op internet blijft en gemakkelijk te vinden is. (Facebook via AP)

Facebook zegt dat er nu 30 mensen in dienst zijn, 000 mensen die werken aan de veiligheids- en beveiligingspraktijken, het beoordelen van mogelijk schadelijk materiaal en al het andere dat mogelijk niet op de site thuishoort. Nog altijd, het bedrijf stelt veel vertrouwen in kunstmatige intelligentie en het vermogen van zijn systemen om uiteindelijk slechte dingen te verwijderen zonder de hulp van mensen. Het nieuwe onderzoek suggereert dat het doel nog ver weg is en sommige critici beweren dat het bedrijf geen oprechte inspanning levert.

Wanneer het materiaal niet wordt verwijderd, het wordt hetzelfde behandeld als al het andere dat is gepost door de 2,4 miljard gebruikers van Facebook - gevierd in geanimeerde video's, gekoppeld en gecategoriseerd en aanbevolen door algoritmen.

Maar het zijn niet alleen de algoritmen die de schuld krijgen. De onderzoekers ontdekten dat sommige extremisten de "Frame Studio" van Facebook gebruiken om militante propaganda te plaatsen. Met de tool kunnen mensen hun profielfoto's binnen grafische kaders versieren - om goede doelen te steunen of verjaardagen te vieren, bijvoorbeeld. Facebook zegt dat die ingelijste afbeeldingen door het bedrijf moeten worden goedgekeurd voordat ze worden geplaatst.

Hany Farid, een digitale forensisch expert aan de Universiteit van Californië, Berkeley, die het Counter-Extremism Project adviseert, een in New York en Londen gevestigde groep die zich richt op het bestrijden van extremistische berichten, zegt dat het kunstmatige intelligentiesysteem van Facebook faalt. Hij zegt dat het bedrijf niet gemotiveerd is om het probleem aan te pakken omdat het duur zou zijn.

"De hele infrastructuur is fundamenteel gebrekkig, "zei hij. "En er is heel weinig zin om het te repareren, want wat Facebook en de andere sociale-mediabedrijven weten, is dat zodra ze verantwoordelijk worden voor materiaal op hun platforms, er een heel blik wormen opengaat."

-

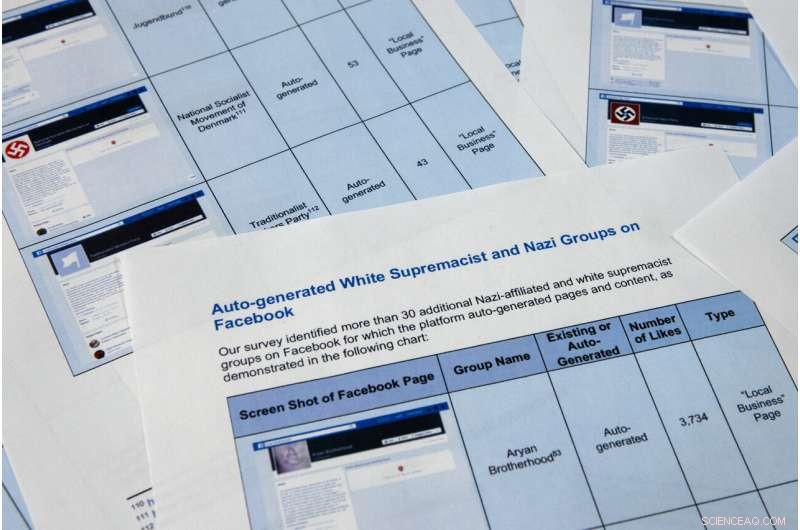

Pagina's uit een vertrouwelijk klokkenluidersrapport, verkregen door The Associated Press, zijn dinsdag gefotografeerd, 7 mei 2019, in Washington. Facebook wil graag de indruk wekken dat het de overgrote meerderheid van extremistische berichten stopt voordat gebruikers ze ooit zien., maar de klacht van de vertrouwelijke klokkenluider bij de Securities and Exchange Commission beweert dat het socialemediabedrijf zijn succes heeft overdreven. Nog erger, het laat zien dat het bedrijf gebruik maakt van propaganda van militante groepen om automatisch video's en pagina's te genereren die door extremisten kunnen worden gebruikt om te netwerken. (AP Foto/Jon Elswick)

-

Pagina's uit een vertrouwelijk klokkenluidersrapport, verkregen door The Associated Press, zijn dinsdag gefotografeerd, 7 mei 2019, in Washington. Facebook wil graag de indruk wekken dat het de overgrote meerderheid van extremistische berichten stopt voordat gebruikers ze ooit zien., maar de klacht van de vertrouwelijke klokkenluider bij de Securities and Exchange Commission beweert dat het socialemediabedrijf zijn succes heeft overdreven. Nog erger, het laat zien dat het bedrijf gebruik maakt van propaganda van militante groepen om automatisch video's en pagina's te genereren die door extremisten kunnen worden gebruikt om te netwerken. De onderzoekers in de SEC-klacht identificeerden meer dan 30 automatisch gegenereerde pagina's voor blanke supremacistische groepen, waarvan de inhoud Facebook verbiedt. (AP Foto/Jon Elswick)

-

Op deze 11 april 2018, bestand foto, Facebook-CEO Mark Zuckerberg getuigt voor een hoorzitting van House Energy and Commerce op Capitol Hill in Washington. Facebook wekt de indruk dat het de overgrote meerderheid van extremistische berichten stopt voordat gebruikers ze ooit zien. Maar de klacht van een vertrouwelijke klokkenluider bij de Securities and Exchange Commission, verkregen door The Associated Press, beweert dat het socialemediabedrijf zijn succes heeft overdreven. (AP Foto/Andrew Harnik, Bestand)

Een andere automatische generatiefunctie van Facebook die fout is gegaan, schrapt werkgelegenheidsinformatie van gebruikerspagina's om bedrijfspagina's te maken. De functie zou pagina's moeten produceren die bedoeld zijn om bedrijven te helpen netwerken, maar in veel gevallen dienen ze als branded landingsplaats voor extremistische groeperingen. Met de functie kunnen Facebook-gebruikers pagina's van extremistische organisaties leuk vinden, inclusief Al Qaida, the Islamic State group and the Somali-based al-Shabab, effectively providing a list of sympathizers for recruiters.

At the top of an auto-generated page for al-Qaida in the Arabian Peninsula, the AP found a photo of the damaged hull of the USS Cole, which was bombed by al-Qaida in a 2000 attack off the coast of Yemen that killed 17 U.S. Navy sailors. It's the defining image in AQAP's own propaganda. The page includes the Wikipedia entry for the group and had been liked by 277 people when last viewed this week.

As part of the investigation for the complaint, Al Azm's researchers in Syria looked closely at the profiles of 63 accounts that liked the auto-generated page for Hay'at Tahrir al-Sham, a group that merged from militant groups in Syria, including the al-Qaida affiliated al-Nusra Front. The researchers were able to confirm that 31 of the profiles matched real people in Syria. Some of them turned out to be the same individuals Al Azm's team was monitoring in a separate project to document the financing of militant groups through antiquities smuggling.

Facebook also faces a challenge with U.S. hate groups. In maart, the company announced that it was expanding its prohibited content to also include white nationalist and white separatist content— previously it only took action with white supremacist content. It says that it has banned more than 200 white supremacist groups. But it's still easy to find symbols of supremacy and racial hatred.

The researchers in the SEC complaint identified over 30 auto-generated pages for white supremacist groups, whose content Facebook prohibits. They include "The American Nazi Party" and the "New Aryan Empire." A page created for the "Aryan Brotherhood Headquarters" marks the office on a map and asks whether users recommend it. One endorser posted a question:"How can a brother get in the house."

A Facebook page for an auto generated Facebook page for a local business, translated into English from Arabic, calling itself 'Islamic State in Sham and Iraq. The page was still live as of Tuesday, May 7, 2019, when the screen grab was made. Facebook says it has robust systems in place to remove content from extremist groups, but a sealed whistleblower's complaint reviewed by the AP says banned content remains on the web and easy to find. (Facebook via AP)

Even supremacists flagged by law enforcement are slipping through the net. Following a sweep of arrests beginning in October, federal prosecutors in Arkansas indicted dozens of members of a drug trafficking ring linked to the New Aryan Empire. A legal document from February paints a brutal picture of the group, alleging murder, kidnapping and intimidation of witnesses that in one instance involved using a searing-hot knife to scar someone's face. It also alleges the group used Facebook to discuss New Aryan Empire business.

But many of the individuals named in the indictment have Facebook pages that were still up in recent days. They leave no doubt of the users' white supremacist affiliation, posting images of Hitler, swastikas and a numerical symbol of the New Aryan Empire slogan, "To The Dirt"—the members' pledge to remain loyal to the end. One of the group's indicted leaders, Jeffrey Knox, listed his job as "stomp down Honky." Facebook then auto-generated a "stomp down Honky" business page.

Social media companies have broad protection in U.S. law from liability stemming from the content that users post on their sites. But Facebook's role in generating videos and pages from extremist content raises questions about exposure. Legal analysts contacted by the AP differed on whether the discovery could open the company up to lawsuits.

At a minimum, the research behind the SEC complaint illustrates the company's limited approach to combatting online extremism. The U.S. State Department lists dozens of groups as "designated foreign terrorist organizations" but Facebook in its public statements says it focuses its efforts on two, the Islamic State group and al-Qaida. But even with those two targets, Facebook's algorithms often miss the names of affiliated groups. Al Azm says Facebook's method seems to be less effective with Arabic script.

Bijvoorbeeld, a search in Arabic for "Al-Qaida in the Arabian Peninsula" turns up not only posts, but an auto-generated business page. One user listed his occupation as "Former Sniper" at "Al-Qaida in the Arabian Peninsula" written in Arabic. Another user evaded Facebook's cull by reversing the order of the countries in the Arabic for ISIS or "Islamic State of Iraq and Syria."

Amr Al Azm, a professor of Middle East History and Anthropology at Shawnee State University, speaks at his office on April 25, 2019, in Portsmouth, Ohio. Facebook gives the impression that it's stopping the vast majority of extremist posts before users ever see them. But a confidential whistleblower's complaint to the Securities and Exchange Commission obtained by The Associated Press alleges the social media company has exaggerated its success. "I mean that's just stretching the imagination to beyond incredulity, " zegt, Al Azm one of the researchers involved in the project. "If a small group of researchers can find hundreds of pages of content by simple searches, why can't a giant company with all its resources do it?" (AP Photo/John Minchillo)

John Kostyack, a lawyer with the National Whistleblower Center in Washington who represents the anonymous plaintiff behind the complaint, said the goal is to make Facebook take a more robust approach to counteracting extremist propaganda.

"Right now we're hearing stories of what happened in New Zealand and Sri Lanka—just heartbreaking massacres where the groups that came forward were clearly openly recruiting and networking on Facebook and other social media, " he said. "That's not going to stop unless we develop a public policy to deal with it, unless we create some kind of sense of corporate social responsibility."

Farid, the digital forensics expert, says that Facebook built its infrastructure without thinking through the dangers stemming from content and is now trying to retrofit solutions.

"The policy of this platform has been:'Move fast and break things.' I actually think that for once their motto was actually accurate, " he says. "The strategy was grow, grow, grow, profit, profit, profit and then go back and try to deal with whatever problems there are."

© 2019 The Associated Press. Alle rechten voorbehouden.

Nieuwe chemische synthesemethode kan een opwindende reeks nieuwe verbindingen produceren

Nieuwe chemische synthesemethode kan een opwindende reeks nieuwe verbindingen produceren Drie soorten warmteoverdrachten

Drie soorten warmteoverdrachten

Warmteoverdracht neemt een veld in beslag dat een breed scala aan functies omvat, van de eenvoudige processen van objecten verwarmen en koelen tot geavanceerde thermodynamische concepten in de thermische fysica. Om t

Moderne alchemisten maken scheikunde groener

Moderne alchemisten maken scheikunde groener Typen metalen aan het periodiek systeem

Typen metalen aan het periodiek systeem Kleurveranderende vloeibare experimenten

Kleurveranderende vloeibare experimenten

50 jaar aan gegevens van een laboratorium met een levend zuurstofminimum kunnen de toekomst van de oceanen helpen voorspellen

50 jaar aan gegevens van een laboratorium met een levend zuurstofminimum kunnen de toekomst van de oceanen helpen voorspellen Is regenwater veilig om te drinken?

Is regenwater veilig om te drinken?  Een krabbenperspectief van opkomend tij in een veranderende wereld

Een krabbenperspectief van opkomend tij in een veranderende wereld Nieuwe permafrost thermische stabiliteitskaart beschrijft de permafrost op het Tibetaanse plateau beter

Nieuwe permafrost thermische stabiliteitskaart beschrijft de permafrost op het Tibetaanse plateau beter Hoe led-lampen werken

Hoe led-lampen werken

Hoofdlijnen

- Verrassend snelle evolutie waargenomen bij hagedissoorten

- Oud skelet-DNA suggereert genetische link met eerste mensen in Noord-Amerika

- Chimpstudie onthult hoe de hersenstructuur onze evolutie heeft gevormd

- IJsbeerblogs onthullen gevaarlijke kloof tussen feiten en meningen over klimaatverandering

- Dit wetenschappelijke experiment duurt 500 jaar

- Factoren die de primaire productiviteit beïnvloeden

- Voeding door mensen verandert het gedrag en de fysiologie van groene schildpadden op de Canarische Eilanden

- Drie voorbeelden van protisten met wetenschappelijke namen

- Onderzoekers onthullen het mechanisme waarmee cellulaire kernen hun positie in spiercellen bereiken

- Facebook stuurt privacywaarschuwingen naar getroffen gebruikers

- Amazon biedt aan om werknemers te helpen bij het opstarten van een bezorgbedrijf

- Mark Zuckerberg:Facebook heeft de campagnes van Rusland en Iran stopgezet om zich te bemoeien met de verkiezingen van 2020

- Teslas Musk bespot het Amerikaanse bureau slechts enkele dagen nadat hij er genoegen mee heeft genomen

- Halfjaarwinst Emirates Airline daalt met 86% door oliestijging

Vulkaanuitbarstingen veroorzaakten ooit massale uitstervingen in de oceanen - zou klimaatverandering hetzelfde kunnen doen?

Vulkaanuitbarstingen veroorzaakten ooit massale uitstervingen in de oceanen - zou klimaatverandering hetzelfde kunnen doen? Wetenschappers demonstreren doorbraak in tunnelbarrièretechnologie

Wetenschappers demonstreren doorbraak in tunnelbarrièretechnologie Klein formaat verbetert de ladingsoverdracht in kwantumdots

Klein formaat verbetert de ladingsoverdracht in kwantumdots Wat is de relatie tussen krachtmassa en versnelling?

Wat is de relatie tussen krachtmassa en versnelling?  Hoe groot was de explosie in Beiroet in 2020?

Hoe groot was de explosie in Beiroet in 2020? Nieuwe doorbraak opent deuren voor de behandeling van aan melanine gerelateerde huidaandoeningen

Nieuwe doorbraak opent deuren voor de behandeling van aan melanine gerelateerde huidaandoeningen De moderne mens ontstond meer dan 300, 000 jaar geleden, nieuwe studie suggereert:

De moderne mens ontstond meer dan 300, 000 jaar geleden, nieuwe studie suggereert: CEO's in de gezondheidszorg lopen voorop in beloning

CEO's in de gezondheidszorg lopen voorop in beloning

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Portuguese | Swedish | German | Dutch | Danish | Norway | Spanish |

-

Wetenschap © https://nl.scienceaq.com