Wetenschap

Chinees-specifieke codering leren voor fonetische gelijkenis

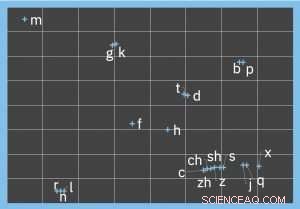

Visualisatie die de fonetische codering van Pinyin-initialen weergeeft. Krediet:IBM

De mentale gymnastiek uitvoeren om het feenetische onderscheid te maken tussen woorden en zinnen zoals "Ik hoor" tot "Ik ben hier" of "Ik kan niet zo maar tonnen" tot "Ik kan geen knopen naaien, " is bekend bij iedereen die automatisch gecorrigeerde sms-berichten is tegengekomen, punny posts op sociale media en dergelijke. Hoewel het op het eerste gezicht lijkt dat fonetische overeenkomst alleen kan worden gekwantificeerd voor hoorbare woorden, dit probleem is vaak aanwezig in puur tekstuele ruimtes.

AI-benaderingen voor het ontleden en begrijpen van tekst vereisen schone invoer, wat op zijn beurt een noodzakelijke hoeveelheid voorbewerking van ruwe gegevens impliceert. Onjuiste homofonen en synofonen, hetzij per vergissing of voor de grap gebruikt, moet worden gecorrigeerd, net als elke andere vorm van spel- of grammaticafout. In het bovenstaande voorbeeld het nauwkeurig transformeren van de woorden "horen" en "zo" naar hun fonetisch gelijkaardige correcte tegenhangers vereist een robuuste weergave van fonetische overeenkomst tussen woordparen.

De meeste algoritmen voor fonetische gelijkenis worden gemotiveerd door Engelse use-cases, en ontworpen voor Indo-Europese talen. Echter, veel talen, zoals Chinees, een andere fonetische structuur hebben. Het spraakgeluid van een Chinees karakter wordt weergegeven door een enkele lettergreep in Pinyin, het officiële romaniseringssysteem van het Chinees. Een Pinyin-lettergreep bestaat uit:een (optioneel) initiaal (zoals 'b', 'z', of 'x'), een finale (zoals 'a', 'u', 'wa', of 'yuan') en toon (waarvan er vijf zijn). Het toewijzen van deze spraakklanken aan Engelse fonemen resulteert in een tamelijk onnauwkeurige weergave, en het gebruik van Indo-Europese algoritmen voor fonetische gelijkenis verergert het probleem. Bijvoorbeeld, twee bekende algoritmen, Soundex en dubbele metafoon, indexmedeklinkers terwijl klinkers worden genegeerd (en hebben geen concept van tonen).

Pinyin

Aangezien een Pinyin-lettergreep gemiddeld zeven verschillende Chinese karakters vertegenwoordigt, het overwicht van homofonen is zelfs groter dan in het Engels. In de tussentijd, het gebruik van Pinyin voor het maken van tekst is extreem gangbaar in mobiele en chattoepassingen, zowel bij het gebruik van spraak-naar-tekst als bij het rechtstreeks typen, omdat het praktischer is om een Pinyin-lettergreep in te voeren en het bedoelde teken te selecteren. Als resultaat, fonetische invoerfouten komen zeer vaak voor, benadrukt de noodzaak van een zeer nauwkeurig algoritme voor fonetische gelijkenis waarop kan worden vertrouwd om fouten te verhelpen.

Gemotiveerd door deze use-case, die generaliseert naar vele andere talen die niet gemakkelijk passen in de fonetische vorm van het Engels, we hebben een aanpak ontwikkeld voor het leren van een n-dimensionale fonetische codering voor Chinees, Een belangrijk kenmerk van Pinyin is dat de drie componenten van een lettergreep (begin, finale en toon) moeten onafhankelijk worden bekeken en vergeleken. Bijvoorbeeld, de fonetische overeenkomst van de finale "ie" en "ue" is identiek in de Pinyin-paren {"xie2, " "xue2"} en {"lie2, " "lue2"}, ondanks de wisselende initialen. Dus, de gelijkenis van een paar Pinyin-lettergrepen is een samenvoeging van de overeenkomsten tussen hun initialen, finale, en tonen.

Echter, het kunstmatig beperken van de coderingsruimte tot een lage dimensie (bijv. indexeren van elke initiaal tot een enkele categorische, of zelfs numerieke waarde) beperkt de nauwkeurigheid van het vastleggen van de fonetische variaties. de juiste, datagestuurde benadering is daarom om organisch een codering van de juiste dimensionaliteit te leren. Het leermodel leidt nauwkeurige coderingen af door gezamenlijk de linguïstische kenmerken van Pinyin te beschouwen, zoals articulatieplaats en uitspraakmethoden, evenals geannoteerde trainingsdatasets van hoge kwaliteit.

Aantonen van een verbetering van 7,5x ten opzichte van bestaande benaderingen van fonetische gelijkenis

De geleerde coderingen kunnen daarom worden gebruikt om, bijvoorbeeld, accepteer een woord als invoer en retourneer een gerangschikte lijst van fonetisch vergelijkbare woorden (gerangschikt op afnemende fonetische overeenkomst). Rangschikking is belangrijk omdat downstream-aanvragen niet worden geschaald om een groot aantal vervangende kandidaten voor elk woord in overweging te nemen, vooral als je in realtime loopt. Als een voorbeeld uit de echte wereld, we hebben onze aanpak geëvalueerd voor het genereren van een gerangschikte lijst van kandidaten voor elk van 350 Chinese woorden uit een dataset van sociale media, en demonstreerde een verbetering van 7,5X ten opzichte van bestaande benaderingen voor fonetische gelijkenis.

We hopen dat de verbeteringen die dit werk oplevert voor het weergeven van taalspecifieke fonetische gelijkenis, bijdragen aan de kwaliteit van talrijke meertalige toepassingen voor natuurlijke taalverwerking. Dit werk, onderdeel van het IBM Research SystemT-project, werd onlangs gepresenteerd op de 2018 SIGNLL Conference on Computational Natural Language Learning, en het vooraf getrainde Chinese model is beschikbaar voor onderzoekers om te gebruiken als hulpmiddel bij het bouwen van chatbots, berichten-apps, spellingcontrole en andere relevante toepassingen.

Onderzoekers krijgen een glimp op nanoschaal van spleet- en putcorrosie terwijl het gebeurt

Onderzoekers krijgen een glimp op nanoschaal van spleet- en putcorrosie terwijl het gebeurt Big data identificeert lipiden als kenmerken van gezondheid en ziekte

Big data identificeert lipiden als kenmerken van gezondheid en ziekte Op weg naar het oplossen van oplosbaarheidsproblemen in de organische chemie

Op weg naar het oplossen van oplosbaarheidsproblemen in de organische chemie Zijdevezels verbeteren bioinkt voor 3D-geprinte kunstmatige weefsels en organen

Zijdevezels verbeteren bioinkt voor 3D-geprinte kunstmatige weefsels en organen Detectie van fermentatieprocessen in elektriciteitopwekkende bacteriën

Detectie van fermentatieprocessen in elektriciteitopwekkende bacteriën

Getijdencycli kunnen helpen bij het voorspellen van vulkaanuitbarstingen, studie suggereert:

Getijdencycli kunnen helpen bij het voorspellen van vulkaanuitbarstingen, studie suggereert: Feiten over Plantae

Feiten over Plantae  Mānoa:Herstel van hybride bos komt ten goede aan gemeenschappen en verhoogt de veerkracht

Mānoa:Herstel van hybride bos komt ten goede aan gemeenschappen en verhoogt de veerkracht Verwoest Venetië zet zich schrap voor derde grote overstroming

Verwoest Venetië zet zich schrap voor derde grote overstroming Met plastic stro verbod, Washington keert zijn eigen uitvinding de rug toe

Met plastic stro verbod, Washington keert zijn eigen uitvinding de rug toe

Hoofdlijnen

- Nieuwe aanpak kan de sleutel zijn tot de behandeling van antibioticaresistente bacteriën

- Chili vecht om een favoriete mossel te redden

- Karkas van Noord-Atlantische rechtse walvis gespot in Massachusetts

- Langstlevende dolfijn in gevangenschap sterft in aquarium Japan

- Wat is een Zygote?

- Je kunt echt op je naam lijken,

- Studie onthult nieuw inzicht in onsterfelijke plantencellen

- Meer wolfachtig worden is de sleutel tot de toekomst voor coyotes

- G2-fase: wat gebeurt er in deze subfase van de celcyclus?

Holografische histopathologie maakt snelle, nauwkeurige diagnose

Holografische histopathologie maakt snelle, nauwkeurige diagnose Lineaire dichtheid berekenen

Lineaire dichtheid berekenen In heet water? Onderzoek zegt dat opwarming het zeeleven met 17% kan verminderen

In heet water? Onderzoek zegt dat opwarming het zeeleven met 17% kan verminderen Wat is Mycelia in de microbiologie?

Wat is Mycelia in de microbiologie?  3D-scanning van zandsteenfossiel onthult het oudste bekende record van sporen van amfibieën in het VK

3D-scanning van zandsteenfossiel onthult het oudste bekende record van sporen van amfibieën in het VK Ingenieurs bouwen eerste sub-10-nm koolstof nanobuistransistor

Ingenieurs bouwen eerste sub-10-nm koolstof nanobuistransistor Waarom zijn walvissen zo groot?

Waarom zijn walvissen zo groot?  Hoe ontvangt de aarde warmte van de zon?

Hoe ontvangt de aarde warmte van de zon?

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | German | Dutch | Danish | Norway | Swedish |

-

Wetenschap © https://nl.scienceaq.com