Wetenschap

Een emotioneel diep uitlijningsnetwerk (DAN) om emoties te classificeren en te visualiseren

Krediet:Tautkutè &Trzcinski

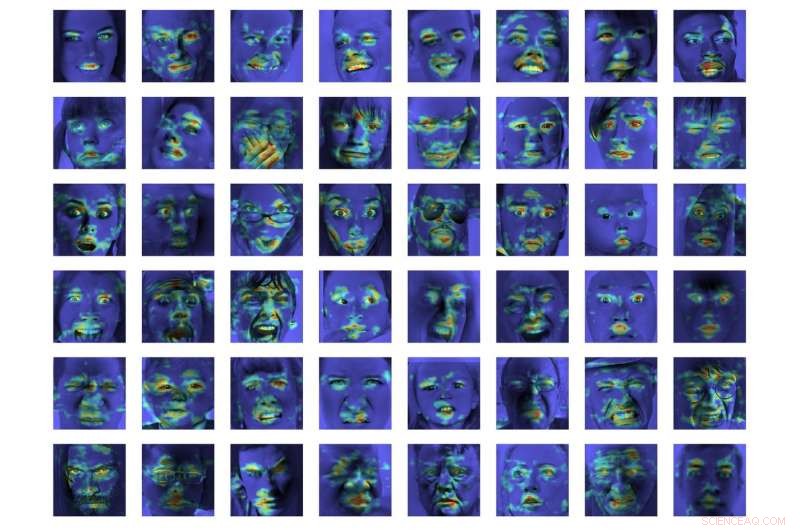

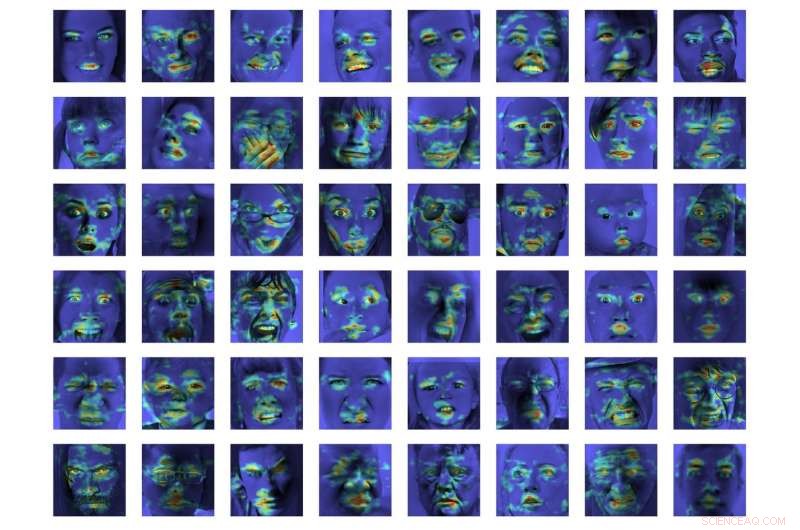

Onderzoekers van de Pools-Japanse Academie voor Informatietechnologie en de Technische Universiteit van Warschau hebben een DAN-model (Deep Alignment Network) ontwikkeld om emoties te classificeren en te visualiseren. Hun methode bleek beter te presteren dan de modernste emotieclassificatiemethoden op twee benchmarkdatasets.

Het ontwikkelen van modellen die menselijke emoties kunnen herkennen en classificeren is een belangrijke uitdaging op het gebied van machine learning en computer vision. De meeste bestaande emotieherkenningstools gebruiken meerlagige convolutionele netwerken, die in de classificatiefase niet expliciet gezichtskenmerken afleiden.

Ivona Tautkute en Tomasz Trzcinski, de onderzoekers die de recente studie hebben uitgevoerd, werkten aanvankelijk aan een systeem voor een in Californië gevestigde startup dat kan worden geïntegreerd in autonome auto's. Dit systeem was in staat om passagiers te tellen op basis van gegevens afkomstig van een enkele videocamera die in de auto was gemonteerd.

In een later stadium, de twee onderzoekers begonnen met het verkennen van modellen die meer konden doen dan dit, het creëren van bredere statistieken over passagiers door hun leeftijd en geslacht te schatten. Een voor de hand liggende uitbreiding van dit systeem was het detecteren van gezichtsuitdrukkingen en emoties, ook.

"Omdat het systeem voor oudere passagiers zou worden gebruikt, het was belangrijk om negatieve en positieve emoties vast te leggen die verband houden met het wegvallen van de bestuurder, Tautkute legde uit. "Bestaande benaderingen voor emotieherkenning zijn verre van perfect, dus gingen we op zoek naar interessante nieuwe manieren om te verbeteren. Een idee kwam bij ons op na een discussie met een collega computer vision-onderzoeker, Marek Kowalski, die werkte aan gezichtsuitlijning met deep alignment network (DAN). Locatie van gezichtsoriëntatiepunten is direct gerelateerd aan uitgedrukte emotie, dus we waren benieuwd of we een systeem konden bouwen dat die twee taken zou combineren."

EmotioneelDAN, het model bedacht door Tautkute en Trzcinski, is een aanpassing van Kowalski's DAN-model, die een term bevat die verband houdt met gelaatstrekken. Dankzij deze wijziging hun model leert tegelijkertijd de locatie van zowel gezichtsoriëntatiepunten als uitgedrukte emotie.

-

Krediet:Tautkutè &Trzcinski

-

Krediet:Tautkutè &Trzcinski

-

Krediet:Tautkutè &Trzcinski

-

Krediet:Tautkutè &Trzcinski

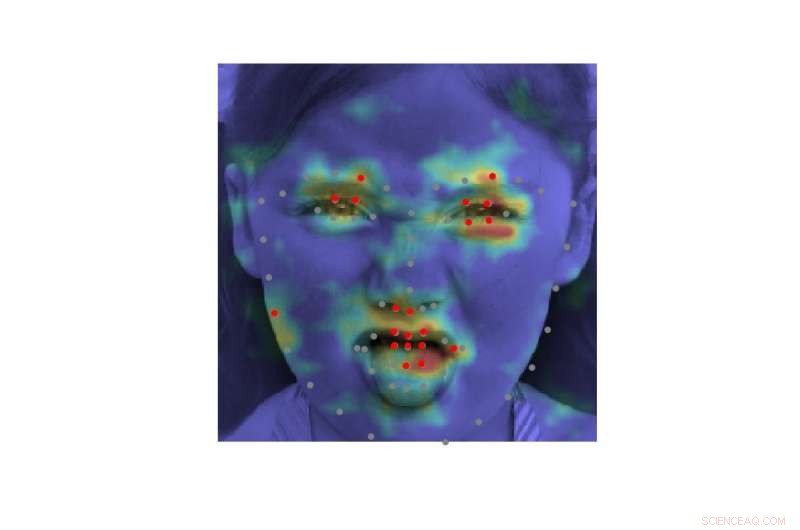

"We hebben dit bereikt door de verliesfunctie van de originele DAN uit te breiden met een term die verantwoordelijk is voor emotieclassificatie, " zei Tautkute. "Het neurale netwerk wordt getraind in opeenvolgende fasen die verfijning van gezichtsoriëntatiepunten en aangeleerde emoties mogelijk maken. Er is ook een overdracht van informatie tussen fasen, die de genormaliseerde gezichtsinvoer bijhoudt, functiekaart en de warmtekaart voor oriëntatiepunten."

Bij een eerste evaluatie EmotionalDAN presteerde 5 procent beter dan state-of-the-art classificatiemethoden op twee benchmarkdatasets, namelijk CK+ en ISED. De onderzoekers waren ook in staat om beeldregio's te visualiseren die door hun model werden geanalyseerd bij het nemen van een beslissing. Hun observaties onthulden dat EmotionalDAN gezichtsoriëntatiepunten die verband houden met de expressie van emoties bij mensen correct kon identificeren.

"Wat echt interessant is aan ons onderzoek, is dat hoewel we geen emotiegerelateerde ruimtelijke informatie aan het netwerk geven, het model is in staat om zelf te leren naar welke gezichtsgebieden moet worden gekeken bij het begrijpen van gezichtsuitdrukkingen, Tautkute zei. "Wij mensen kijken intuïtief naar iemands ogen en mond om glimlachen of verdriet op te merken, maar het neurale netwerk ziet alleen een matrix van pixels. Door te verifiëren welke afbeeldingsregio's worden geactiveerd voor een bepaalde classificatiebeslissing, komen we een stap dichter bij het begrijpen van het model en hoe het beslissingen neemt."

Krediet:Tautkutè &Trzcinski.

Ondanks de veelbelovende resultaten die zijn bereikt met EmotionalDAN en andere hulpmiddelen voor emotieherkenning, het begrijpen van menselijke emoties blijft een zeer complexe taak. Hoewel bestaande systemen opmerkelijke resultaten hebben behaald, ze hebben dat vooral kunnen doen wanneer emoties in significante mate worden geuit.

In levensechte situaties, echter, de emotionele signalen die door mensen worden uitgedrukt, zijn vaak veel subtieler. Bijvoorbeeld, iemands geluk wordt misschien niet altijd overgebracht door alle tanden te laten zien in een brede glimlach, maar kan slechts een lichte beweging van de liphoeken met zich meebrengen.

"Het zou echt interessant zijn om meer subjectieve aspecten van emotie te begrijpen en hoe hun expressie verschilt tussen individuen, ' zei Tautkute. 'Om verder te gaan, men zou kunnen proberen valse emoties te onderscheiden van echte. Bijvoorbeeld, neurologen stellen dat verschillende gezichtsspieren betrokken zijn bij echte en valse glimlachen. Vooral, oogspieren trekken niet samen in de geforceerde expressie. Het zou interessant zijn om vergelijkbare relaties te ontdekken met behulp van informatie die uit gegevens is geleerd."

© 2018 Wetenschap X Netwerk

Het mengen van kunstmatige zoetstoffen remt de bittere smaakreceptoren

Het mengen van kunstmatige zoetstoffen remt de bittere smaakreceptoren 302 Vs. 304 roestvrij staal

302 Vs. 304 roestvrij staal  Onderzoekers voorspellen materialen om lithium-ionbatterijen met recordhoge capaciteit te stabiliseren

Onderzoekers voorspellen materialen om lithium-ionbatterijen met recordhoge capaciteit te stabiliseren Spontane synthese van homogene polymeernetwerken

Spontane synthese van homogene polymeernetwerken Wetenschappers laten onderzoekshydrogel meer als biologische weefsels groeien

Wetenschappers laten onderzoekshydrogel meer als biologische weefsels groeien

Bezorgdheid groeit over besmet zuiveringsslib dat op akkers wordt verspreid

Bezorgdheid groeit over besmet zuiveringsslib dat op akkers wordt verspreid Stijgende overstromingsverzekeringskosten en toenemende lasten voor gemeenschappen en huiseigenaren in New York City

Stijgende overstromingsverzekeringskosten en toenemende lasten voor gemeenschappen en huiseigenaren in New York City Namen van planten met doornen

Namen van planten met doornen  bacteriën, dood hout en klimaatverandering - bosbodem als koolstofput

bacteriën, dood hout en klimaatverandering - bosbodem als koolstofput Het reguleren van de indirecte CO2-emissies door landgebruik door biobrandstoffen brengt hoge verborgen kosten met zich mee voor de brandstofverbruikers

Het reguleren van de indirecte CO2-emissies door landgebruik door biobrandstoffen brengt hoge verborgen kosten met zich mee voor de brandstofverbruikers

Hoofdlijnen

- De structurele stabiliteit van de DNA-dubbele helix

- Zal er ooit een gelukkige pil zijn?

- Verbetering van de neuronenfabriek - nieuwe modulator van stamcelidentiteit gevonden

- Hoe ziet een door vrouwen gerunde samenleving eruit?

- Licht schijnen op het sociale leven van virussen

- Het verschil tussen glycolyse en gluconeogenese

- Zijn er evolutionaire wortels voor menselijke obesitas?

- Hoe maak je een werkend hart Model

- Onderzoekers schijnen de schijnwerpers op illegale handel in wilde orchideeën

Met stormen in mei, wetgever wil een langer orkaanseizoen

Met stormen in mei, wetgever wil een langer orkaanseizoen Video:Wat is er precies gebeurd in Tsjernobyl?

Video:Wat is er precies gebeurd in Tsjernobyl? Welke pH-waarden worden als sterk en zwak beschouwd?

Welke pH-waarden worden als sterk en zwak beschouwd?  Waarom moeten een buret en pipet worden gespoeld met de juiste oplossing voor een titratie?

Waarom moeten een buret en pipet worden gespoeld met de juiste oplossing voor een titratie?  Oostelijke EU-landen tegen 2050 nul-emissiedoelstelling

Oostelijke EU-landen tegen 2050 nul-emissiedoelstelling Wetenschappers stellen machinale leermethode voor 2D-materiaalspectroscopie voor

Wetenschappers stellen machinale leermethode voor 2D-materiaalspectroscopie voor Amerikaanse bedrijven krijgen te maken met zware juridische strijd bij diefstal van IP in China

Amerikaanse bedrijven krijgen te maken met zware juridische strijd bij diefstal van IP in China Nieuw hulpmiddel voor de kristallisatie van eiwitten

Nieuw hulpmiddel voor de kristallisatie van eiwitten

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com