Wetenschap

Etalumis keert simulaties om om nieuwe wetenschap te onthullen

Etalumis voert Bayesiaanse gevolgtrekking uit - een methode voor statistische gevolgtrekking waarbij de stelling van Bayes wordt gebruikt om de waarschijnlijkheid van een hypothese bij te werken naarmate er meer bewijs of informatie beschikbaar komt - waarbij in wezen de simulator wordt omgekeerd om invoerparameters van waarnemingen te voorspellen. Deze afbeelding geeft een overzicht van het softwareframework. Krediet:Wahid Bhimji, Lawrence Berkeley National Laboratory

Wetenschappers hebben simulaties gebouwd om gedrag in de echte wereld te verklaren, inclusief modellering voor de overdracht en preventie van ziekten, autonome voertuigen, klimaatwetenschap, en in de zoektocht naar de fundamentele geheimen van het universum. Maar hoe grote hoeveelheden experimentele gegevens kunnen worden geïnterpreteerd in termen van deze gedetailleerde simulaties, blijft een belangrijke uitdaging. Probabilistisch programmeren biedt een oplossing - in wezen reverse-engineering van de simulatie - maar deze techniek is lange tijd beperkt geweest vanwege de noodzaak om de simulatie te herschrijven in aangepaste computertalen, plus de intense rekenkracht die nodig is.

Om deze uitdaging aan te gaan, een multinationale samenwerking van onderzoekers die computerbronnen gebruiken in het National Energy Research Scientific Computing Center (NERSC) van het Lawrence Berkeley National Laboratory, heeft het eerste probabilistische programmeerraamwerk ontwikkeld dat in staat is om bestaande simulatoren te besturen en op grote schaal op HPC-platforms te draaien. Het systeem, genaamd Etalumis ("simuleren" achterstevoren gespeld), is ontwikkeld door een groep wetenschappers van de Universiteit van Oxford, Universiteit van Brits-Columbia (UBC), Intel, New York Universiteit, CERN, en NERSC als onderdeel van een Big Data Center-project.

Etalumis voert Bayesiaanse gevolgtrekking uit - een methode voor statistische gevolgtrekking waarbij de stelling van Bayes wordt gebruikt om de waarschijnlijkheid van een hypothese bij te werken naarmate er meer bewijs of informatie beschikbaar komt - waarbij in wezen de simulator wordt omgekeerd om invoerparameters van waarnemingen te voorspellen. Het team zette Etalumis voor het eerst in voor de Large Hadron Collider (LHC) bij CERN, het brengen van een nieuw niveau van interpreteerbaarheid van data-analyse van de LHC's high-energy physics-detectoren. Een paper op basis van Etalumis is geselecteerd als finalist voor Best Paper op SC19. De auteurs spreken dinsdag op SC19 over Etalumis, 19 november om 16.30 uur

Van dagen tot minuten

Bayesiaanse gevolgtrekking wordt in vrijwel alle wetenschappelijke disciplines gebruikt, volgens Frank Wood, een medewerker van Etalumis, Universitair hoofddocent computerwetenschappen bij UBC, en een van de pioniers van probabilistische programmering.

"Ik was vooral geïnteresseerd in het toepassen van Bayesiaanse gevolgtrekkingen op een extreem complex natuurkundig probleem, en hoogenergetische fysica-detectoren voelden als de perfecte proeftuin voor het baanbrekende onderzoek van onze groep, ", zegt hij. "Het Etalumis-project bood een unieke kans om een geavanceerd neuraal netwerk te combineren op basis van een 'inferentiecompilatie'-aanpak met een softwareframework (pyprob) om deze inferentie-engine rechtstreeks te koppelen aan bestaande gedetailleerde deeltjesfysica-simulators en deze uit te voeren. op HPC-schaal bronnen."

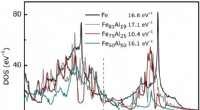

Een vergelijking van enkele van de voorspellingen van de inferentiecompilatiebenadering van het Etalumis-project (overzichtshistogrammen), die dezelfde nauwkeurigheidsniveaus kunnen bereiken als computationeel hardnekkige methoden (gevulde histogrammen). Krediet:Lawrence Berkeley National Laboratory

Wetenschappers hebben al robuuste simulatiesoftwarepakketten die de fysica en alles wat zich binnen de detector afspeelt, modelleren. Etalumis brengt probabilistische programmering in om te koppelen met deze bestaande software, in wezen geven onderzoekers de mogelijkheid om te zeggen:"We hadden deze observatie, hoe zijn we daar gekomen?"

"Dit project is opwindend omdat het bestaande simulatoren op vele gebieden van wetenschap en techniek onderwerpt aan probabilistische machine learning, " zegt Atilim Gunes Baydin, hoofdontwikkelaar van het Etalumis-project en hoofdauteur van de SC19-paper. Gunes is momenteel een postdoctoraal onderzoeker in machine learning aan de Universiteit van Oxford. "Dit betekent dat de simulator niet langer wordt gebruikt als een zwarte doos om synthetische trainingsgegevens te genereren, maar als een interpreteerbaar probabilistisch generatief model dat de code van de simulator al specificeert, waarin we gevolgtrekkingen kunnen maken.

"We moeten in staat zijn om het programma te controleren om elke mogelijkheid uit te schakelen, dus in dit project hebben we deze mogelijkheid toegevoegd als een softwarelaag, " voegt Wahid Bhimji toe, een Big Data Architect in het Data and Analytics Services-team bij NERSC. Echter, het uitvoeren van gevolgtrekkingen in dergelijke complexe omgevingen brengt rekenkundige uitdagingen met zich mee. "Conventionele methoden voor dit soort Bayesiaanse gevolgtrekkingen zijn extreem rekenkundig duur, "Bhimji voegt eraan toe. "Etalumis stelt ons in staat om in enkele minuten te doen wat normaal dagen zou duren, met behulp van NERSC HPC-bronnen."

Diepe interpretatie

Voor het LHC-gebruiksgeval, het team heeft een neuraal netwerk getraind om gevolgtrekkingen uit te voeren, leren om met goede voorstellen te komen over welke gedetailleerde keten van natuurkundige processen uit de simulator zou kunnen hebben plaatsgevonden. Dit vereiste verbeteringen aan het PyTorch deep-learning framework om een complex dynamisch neuraal netwerk te trainen op meer dan 1, 000 knooppunten (32, 000 CPU-kernen) van de Cori-supercomputer bij NERSC. Als resultaat, training die maanden zou duren met de oorspronkelijke niet-geoptimaliseerde software op een enkele node, kan nu in minder dan 10 minuten worden voltooid op Cori. Wetenschappers kregen zo de kans om de keuzes te bestuderen die nodig waren om elk resultaat te produceren, waardoor ze meer inzicht krijgen in de data.

"In veel gevallen weet je dat er een onzekerheid is bij het bepalen van de fysica die heeft plaatsgevonden bij een LHC-botsing, maar je kent niet de waarschijnlijkheden van alle processen die aanleiding kunnen geven tot een bepaalde waarneming; met Etalumis, daar krijg je een model van, ' legt Bhimji uit.

De diepe interpreteerbaarheid die Etalumis biedt voor data-analyse van de LHC kan belangrijke vooruitgang in de natuurkundige wereld ondersteunen. "Tekenen van nieuwe fysica kunnen heel goed verborgen zijn in de LHC-gegevens; het onthullen van die signalen kan een paradigmaverandering vereisen van de klassieke algoritmische verwerking van de gegevens naar een meer genuanceerde probabilistische benadering, " zegt Kyle Cranmer, een NYU-fysicus die deel uitmaakte van het Etalumis-project. "Deze benadering brengt ons tot de grens van wat kwantummechanisch bekend is."

Groene chemie en biobrandstof:het mechanisme van een sleutelfoto-enzym gedecodeerd

Groene chemie en biobrandstof:het mechanisme van een sleutelfoto-enzym gedecodeerd Wat moet je weten om molariteit te berekenen?

Wat moet je weten om molariteit te berekenen?  De moleculaire afbuiging van lichtstraling door middel van diamantaan

De moleculaire afbuiging van lichtstraling door middel van diamantaan Onderzoeksteam ontwikkelt sonde voor batterijonderzoek

Onderzoeksteam ontwikkelt sonde voor batterijonderzoek Waterafstotend materiaal werpt af als een slang bij beschadiging

Waterafstotend materiaal werpt af als een slang bij beschadiging

Afbeelding:Wildvuurvonken in suikerrietvelden op het eiland Maui

Afbeelding:Wildvuurvonken in suikerrietvelden op het eiland Maui Vergelijking tussen de skeletten van kikkers en mensen

Vergelijking tussen de skeletten van kikkers en mensen Ondergronds:Cambridge graaft in de geschiedenis van de geologie met een historische tentoonstelling

Ondergronds:Cambridge graaft in de geschiedenis van de geologie met een historische tentoonstelling Hoe reproduceren Aloë planten?

Hoe reproduceren Aloë planten?  NASA's Terra ziet het einde van de Atlantische tropische depressie 3

NASA's Terra ziet het einde van de Atlantische tropische depressie 3

Hoofdlijnen

- Sluwe kraaien weten wat er nodig is om een goed stuk gereedschap te maken

- Onderzoekers identificeren manier om malariaparasieten te verzwakken tegen populaire medicamenteuze behandelingen

- Honden zijn expressiever als iemand kijkt

- Microbieel moordmysterie opgelost

- Wetenschappers presenteren een nieuwe methode om elk eiwit in elk soort cel direct en snel te vernietigen

- Nieuwe studie verandert kijk op vliegende insecten

- Wat zijn de chemische zintuigen?

- Gaan roodharigen uitsterven?

- Schimmel is afhankelijk van bacteriën om de belangrijkste componenten van zijn voortplantingsmechanisme te reguleren

Brandblusmiddel doodt turfbranden van zombies 40% sneller dan alleen water

Brandblusmiddel doodt turfbranden van zombies 40% sneller dan alleen water Nano-hashtags kunnen de sleutel zijn tot het genereren van het zeer gewilde Majorana-quasideeltje

Nano-hashtags kunnen de sleutel zijn tot het genereren van het zeer gewilde Majorana-quasideeltje Facebook heeft een paar jaar nodig om problemen op te lossen:Zuckerberg

Facebook heeft een paar jaar nodig om problemen op te lossen:Zuckerberg Gratis wiskunde Teambuilding activiteiten

Gratis wiskunde Teambuilding activiteiten  Prachtige verloren vintage uit Bordeaux drijft kleine telers tot het uiterste

Prachtige verloren vintage uit Bordeaux drijft kleine telers tot het uiterste De onderwateroerwouden van de zee geven helderder water

De onderwateroerwouden van de zee geven helderder water Celdoodblokker voorkomt dat gezonde cellen afsterven

Celdoodblokker voorkomt dat gezonde cellen afsterven Hoe Mushroom Spawn te maken

Hoe Mushroom Spawn te maken

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com