Wetenschap

Computermodel van gezichtsverwerking zou kunnen onthullen hoe de hersenen zo snel rijk gedetailleerde visuele representaties produceren

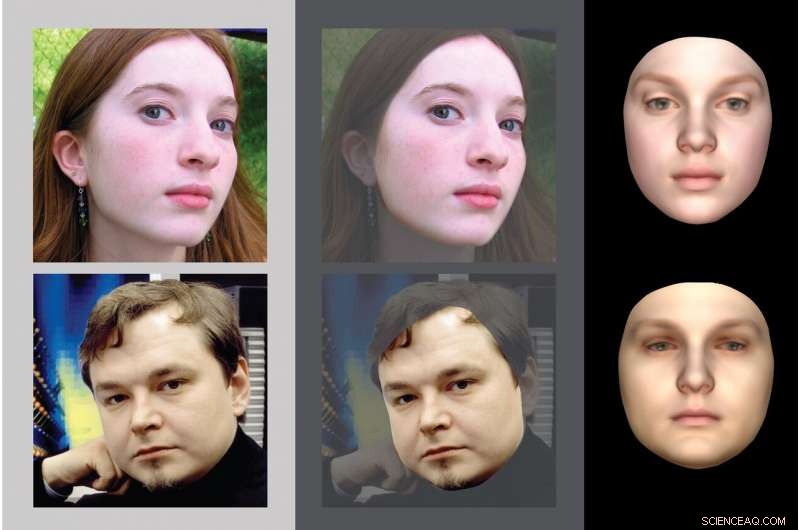

Cognitieve wetenschappers van MIT hebben een computermodel voor gezichtsherkenning ontwikkeld dat een reeks berekeningen uitvoert die de stappen omkeren die een grafisch computerprogramma zou gebruiken om een 2D-weergave van een gezicht te genereren. Cognitieve wetenschappers van MIT hebben een computermodel voor gezichtsherkenning ontwikkeld dat een reeks berekeningen die de stappen omkeren die een computergrafisch programma zou gebruiken om een 2D-weergave van een gezicht te genereren. Krediet:MIT

Als we onze ogen openen, we zien onze omgeving meteen heel gedetailleerd. Hoe de hersenen zo snel deze rijk gedetailleerde representaties van de wereld kunnen vormen, is een van de grootste onopgeloste puzzels in de studie van het gezichtsvermogen.

Wetenschappers die de hersenen bestuderen, hebben geprobeerd dit fenomeen te repliceren met behulp van computermodellen van visie, maar tot nu toe, toonaangevende modellen voeren alleen veel eenvoudigere taken uit, zoals het uitkiezen van een object of een gezicht tegen een rommelige achtergrond. Nutsvoorzieningen, een team onder leiding van cognitieve wetenschappers van het MIT heeft een computermodel geproduceerd dat het vermogen van het menselijke visuele systeem vastlegt om snel een gedetailleerde scènebeschrijving van een afbeelding te genereren, en biedt enig inzicht in hoe de hersenen dit bereiken.

"Wat we in dit werk probeerden te doen, is uitleggen hoe perceptie zoveel rijker kan zijn dan alleen semantische labels op delen van een afbeelding, en om de vraag te onderzoeken hoe we de hele fysieke wereld zien, " zegt Josh Tenenbaum, een professor in computationele cognitieve wetenschap en lid van MIT's Computer Science and Artificial Intelligence Laboratory (CSAIL) en het Center for Brains, geesten, en Machines (CBMM).

Het nieuwe model stelt dat wanneer de hersenen visuele input ontvangen, het voert snel een reeks berekeningen uit die de stappen omkeren die een computergrafisch programma zou gebruiken om een 2D-weergave van een gezicht of ander object te genereren. Dit type model, bekend als efficiënte inverse graphics (EIG), correleert ook goed met elektrische opnames van gezichtsselectieve regio's in de hersenen van niet-menselijke primaten, wat suggereert dat het visuele systeem van primaten op vrijwel dezelfde manier kan worden georganiseerd als het computermodel, zeggen de onderzoekers.

Ilker Yildirim, een voormalig MIT-postdoc die nu assistent-professor psychologie is aan de Yale University, is de hoofdauteur van het artikel, die vandaag verschijnt in wetenschappelijke vooruitgang . Tenenbaum en Winrich Freiwald, een professor in neurowetenschappen en gedrag aan de Rockefeller University, zijn de senior auteurs van de studie. Mario Belledonne, een afgestudeerde student aan Yale, is ook een auteur.

Omgekeerde afbeeldingen

Decennia van onderzoek naar het visuele systeem van de hersenen heeft bestudeerd, tot in detail, hoe lichtinvoer op het netvlies wordt omgezet in samenhangende scènes. Dit inzicht heeft onderzoekers van kunstmatige intelligentie geholpen bij het ontwikkelen van computermodellen die aspecten van dit systeem kunnen repliceren, zoals het herkennen van gezichten of andere objecten.

"Visie is het functionele aspect van de hersenen dat we het beste begrijpen, bij mensen en andere dieren, ", zegt Tenenbaum. "En computervisie is op dit moment een van de meest succesvolle gebieden van AI. We gaan ervan uit dat machines nu heel goed naar foto's kunnen kijken en gezichten kunnen herkennen, en andere soorten objecten detecteren."

Echter, zelfs deze geavanceerde kunstmatige-intelligentiesystemen komen niet in de buurt van wat het menselijke visuele systeem kan doen, zegt Yildirim.

"Onze hersenen detecteren niet alleen dat daar een object is, of iets herkennen en er een etiket op plakken, "zegt hij. "We zien alle vormen, de geometrie, de oppervlakken, de texturen. We zien een zeer rijke wereld."

Meer dan een eeuw geleden, de arts, natuurkundige, en filosoof Hermann von Helmholtz theoretiseerde dat de hersenen deze rijke representaties creëren door het proces van beeldvorming om te keren. Hij veronderstelde dat het visuele systeem een beeldgenerator bevat die zou worden gebruikt, bijvoorbeeld, om de gezichten te produceren die we tijdens dromen zien. Door deze generator in omgekeerde richting te draaien, kunnen de hersenen achteruit werken vanuit het beeld en afleiden welk soort gezicht of ander object dat beeld zou produceren, zeggen de onderzoekers.

Echter, de vraag bleef:hoe konden de hersenen dit proces uitvoeren, bekend als inverse graphics, zo snel? Computerwetenschappers hebben geprobeerd algoritmen te maken die deze prestatie kunnen leveren, maar de beste eerdere systemen vereisen veel cycli van iteratieve verwerking, het duurt veel langer dan de 100 tot 200 milliseconden die de hersenen nodig hebben om een gedetailleerde visuele weergave te maken van wat je ziet. Neurowetenschappers geloven dat perceptie in de hersenen zo snel kan verlopen omdat het wordt geïmplementeerd in een grotendeels feedforward door verschillende hiërarchisch georganiseerde lagen van neurale verwerking.

Het door MIT geleide team wilde een speciaal soort diep neuraal netwerkmodel bouwen om te laten zien hoe een neurale hiërarchie snel de onderliggende kenmerken van een scène kan afleiden - in dit geval, een bepaald gezicht. In tegenstelling tot de standaard diepe neurale netwerken die worden gebruikt in computervisie, die zijn getraind op basis van gelabelde gegevens die de klasse van een object in de afbeelding aangeven, het netwerk van de onderzoekers is getraind vanuit een model dat de interne representaties van de hersenen weerspiegelt van hoe scènes met gezichten eruit kunnen zien.

Hun model leert dus de stappen om te draaien die worden uitgevoerd door een computergrafisch programma voor het genereren van gezichten. Deze grafische programma's beginnen met een driedimensionale weergave van een individueel gezicht en zetten dit vervolgens om in een tweedimensionaal beeld, gezien vanuit een bepaald gezichtspunt. Deze afbeeldingen kunnen op een willekeurige achtergrondafbeelding worden geplaatst. De onderzoekers theoretiseren dat het visuele systeem van de hersenen iets soortgelijks kan doen als je droomt of een mentaal beeld oproept van iemands gezicht.

De onderzoekers trainden hun diepe neurale netwerk om deze stappen in omgekeerde volgorde uit te voeren, dat wil zeggen:het begint met de 2D-afbeelding en voegt vervolgens functies toe zoals textuur, kromming, en verlichting, om te creëren wat de onderzoekers een "2.5D" -weergave noemen. Deze 2.5D-afbeeldingen specificeren de vorm en kleur van het gezicht vanuit een bepaald gezichtspunt. Die worden vervolgens omgezet in 3D-weergaven, die niet afhankelijk zijn van het gezichtspunt.

"Het model geeft een overzicht op systeemniveau van de verwerking van gezichten in de hersenen, waardoor het een afbeelding kan zien en uiteindelijk tot een 3D-object kan komen, die representaties van vorm en textuur omvat, door deze belangrijke tussenfase van een 2,5D-beeld, ' zegt Yildirim.

Modelprestaties

De onderzoekers ontdekten dat hun model consistent is met gegevens die zijn verkregen door bepaalde regio's in de hersenen van makaken te bestuderen. In een in 2010 gepubliceerde studie Freiwald en Doris Tsao van Caltech registreerden de activiteit van neuronen in die regio's en analyseerden hoe ze reageerden op 25 verschillende gezichten, gezien vanuit zeven verschillende gezichtspunten. Die studie onthulde drie stadia van gezichtsverwerking op een hoger niveau, waarvan het MIT-team nu veronderstelt dat ze overeenkomen met drie fasen van hun inverse grafische model:ruwweg, een 2.5D gezichtspuntafhankelijke fase; een podium dat overbrugt van 2,5 naar 3D; en een 3D, gezichtspunt-invariant stadium van gezichtsrepresentatie.

"Wat we laten zien is dat zowel de kwantitatieve als kwalitatieve respons-eigenschappen van die drie niveaus van de hersenen opmerkelijk goed lijken te passen bij de drie hoogste niveaus van het netwerk dat we hebben gebouwd, ', zegt Tenenbaum.

De onderzoekers vergeleken ook de prestaties van het model met die van mensen bij een taak waarbij gezichten vanuit verschillende gezichtspunten worden herkend. Deze taak wordt moeilijker wanneer onderzoekers de gezichten veranderen door de textuur van het gezicht te verwijderen met behoud van de vorm, of het vervormen van de vorm terwijl de relatieve textuur behouden blijft. De prestaties van het nieuwe model leken veel meer op die van mensen dan computermodellen die worden gebruikt in geavanceerde gezichtsherkenningssoftware. aanvullend bewijs dat dit model mogelijk dichter bij het nabootsen van wat er gebeurt in het menselijke visuele systeem.

De onderzoekers zijn nu van plan door te gaan met het testen van de modelleringsaanpak op aanvullende afbeeldingen, inclusief objecten die geen gezichten zijn, om te onderzoeken of inverse graphics ook zouden kunnen verklaren hoe de hersenen andere soorten scènes waarnemen. In aanvulling, zij zijn van mening dat het aanpassen van deze benadering aan computervisie zou kunnen leiden tot beter presterende AI-systemen.

"Als we kunnen aantonen dat deze modellen overeenkomen met hoe de hersenen werken, dit werk zou ertoe kunnen leiden dat onderzoekers op het gebied van computervisie serieuzer nemen en meer technische middelen investeren in deze omgekeerde grafische benadering van perceptie, ", zegt Tenenbaum. "Het brein is nog steeds de gouden standaard voor elke soort machine die de wereld rijk en snel ziet."

Hoofdlijnen

- Hoe eetbare plantencellen te maken

- Hoe Tiny Robots je gezondheid kunnen verbeteren vanuit het lichaam

- Onderzoekers ontdekken hoe planten op moleculair niveau reageren op veranderingen in licht

- The Krebs Cycle Made Easy

- Karkas van Noord-Atlantische rechtse walvis gespot in Massachusetts

- Hoe wordt recombinant DNA gemaakt?

- Officiële vishandel onderschat wereldwijde vangsten enorm

- Hoe slaaplabs werken

- Wetenschappers tonen moleculaire basis voor mieren die als lijfwachten voor planten fungeren

Ja, Australië is een land van overstromende regens, maar klimaatverandering kan het erger maken

Ja, Australië is een land van overstromende regens, maar klimaatverandering kan het erger maken Australië belooft te stoppen met het exporteren van zijn afval

Australië belooft te stoppen met het exporteren van zijn afval Europa's verloren bossen - onderzoek toont aan dat de dekking in zes millennia is gehalveerd

Europa's verloren bossen - onderzoek toont aan dat de dekking in zes millennia is gehalveerd Wat gaf de vroege New Orleans-jazzklarinetten hun unieke geluid?

Wat gaf de vroege New Orleans-jazzklarinetten hun unieke geluid? Hoog, niet plat:nanodraden voor een nieuwe chiparchitectuur

Hoog, niet plat:nanodraden voor een nieuwe chiparchitectuur Onderzoeksbevinding kan het energieverbruik en de kosten bij het maken van silicium verlagen

Onderzoeksbevinding kan het energieverbruik en de kosten bij het maken van silicium verlagen Bepaling van de structuur van een molecuul met laser-geïnduceerde elektronendiffractie

Bepaling van de structuur van een molecuul met laser-geïnduceerde elektronendiffractie Waterhergebruik kan de sleutel zijn voor de toekomst van hydrofracturering

Waterhergebruik kan de sleutel zijn voor de toekomst van hydrofracturering

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | French |

-

Wetenschap © https://nl.scienceaq.com