Wetenschap

AVID:een raamwerk om imitatieleren in robots te verbeteren

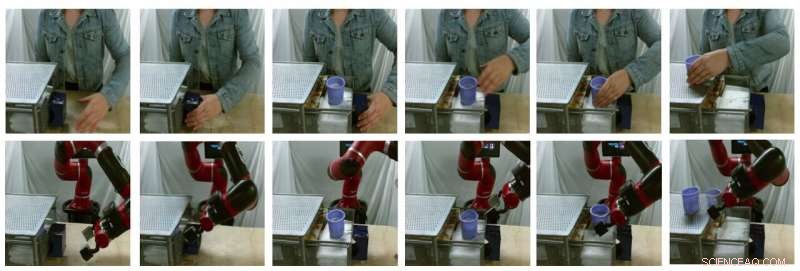

Voorbeeldstills van door modellen gegenereerde vertalingen (bovenste rij zijn echte menselijke afbeeldingen, onderste rij zijn nep-robotafbeeldingen). Krediet:Smith et al.

In recente jaren, onderzoeksteams over de hele wereld gebruiken wapeningsleer (RL) om robots te leren hoe ze verschillende taken moeten uitvoeren. Door deze algoritmen te trainen, echter, kan erg uitdagend zijn, omdat het ook aanzienlijke menselijke inspanningen vereist om de taken die de robot moet uitvoeren goed te definiëren.

Een manier om robots te leren specifieke taken uit te voeren, is door middel van demonstraties voor mensen. Hoewel dit misschien eenvoudig lijkt, het kan heel moeilijk zijn om te implementeren, vooral omdat robots en mensen heel verschillende lichamen hebben, daardoor zijn ze in staat tot verschillende bewegingen.

Onderzoekers van de University of California Berkeley hebben onlangs een nieuw raamwerk ontwikkeld dat kan helpen bij het overwinnen van enkele van de uitdagingen die zich voordoen bij het trainen van robots via imitatieleren (d.w.z. met behulp van menselijke demonstraties). Hun kader, genaamd AVID, gebaseerd op twee deep-learningmodellen die in eerder onderzoek zijn ontwikkeld.

"Bij het ontwikkelen van AVID, we bouwden grotendeels voort op twee recente werken, CycleGAN en SOLAR, die benaderingen introduceerde om fundamentele beperkingen aan te pakken die het leren van menselijke video's in domeinverschuiving en training op een fysieke robot van visuele invoer hebben uitgesloten, respectievelijk, "Laura Smit, een van de onderzoekers die het onderzoek heeft uitgevoerd, vertelde TechXplore.

In plaats van technieken te gebruiken die geen rekening houden met de verschillen tussen een robot en het lichaam van een menselijke gebruiker, Smith en haar collega's gebruikten Cycle-GAN, een techniek die afbeeldingen op pixelniveau kan transformeren. Met behulp van Cycle-GAN, hun methode zet menselijke demonstraties van het voltooien van een bepaalde taak om in video's van een robot die dezelfde taak voltooit. Met deze video's ontwikkelden ze vervolgens een beloningsfunctie voor een RL-algoritme.

Voorbeeldstills van door modellen gegenereerde vertalingen (bovenste rij zijn echte menselijke afbeeldingen, onderste rij zijn nep-robotafbeeldingen). Krediet:Smith et al.

"AVID werkt door de robot een mens te laten observeren die een taak uitvoert en zich vervolgens voorstelt hoe het eruit zou zien om hetzelfde uit te voeren, Smith legde uit. "Om te leren hoe je dit ingebeelde succes daadwerkelijk kunt bereiken, we laten de robot leren met vallen en opstaan."

Met behulp van het raamwerk ontwikkeld door Smith en haar collega's, een robot leert taken stap voor stap, elke fase opnieuw instellen en opnieuw proberen zonder tussenkomst van een menselijke gebruiker. Het leerproces wordt zo grotendeels geautomatiseerd, waarbij de robot nieuwe vaardigheden leert met minimale menselijke tussenkomst.

"Een belangrijk voordeel van onze aanpak is dat de menselijke leraar kan communiceren met de robotstudent terwijl deze aan het leren is, " legde Smith uit. "Bovendien, we ontwerpen ons trainingskader om met minimale inspanning langdurig gedrag aan te leren."

De onderzoekers evalueerden hun aanpak in een reeks proeven en ontdekten dat het robots effectief kan leren complexe taken uit te voeren, zoals het bedienen van een koffiezetapparaat, simpelweg door 20 minuten aan onbewerkte menselijke demonstratievideo's te verwerken en de nieuwe vaardigheid 180 minuten te oefenen. In aanvulling, AVID presteerde beter dan alle andere technieken die het was, inclusief imitatie-ablatie, pixel-ruimte ablatie, en gedragsmatige klonen.

"Wat we ontdekten, is dat we CycleGAN kunnen gebruiken om effectief video's van menselijke demonstraties begrijpelijk te maken voor de robot zonder een moeizaam proces voor het verzamelen van gegevens, " Smith zei. "We laten ook zien dat het benutten van de meertrapsaard van tijdelijk uitgebreide taken ons in staat stelt robuust gedrag te leren terwijl training gemakkelijk wordt. We zien ons werk als een zinvolle stap om de real-world inzet van autonome robots binnen handbereik te brengen, omdat het ons een heel natuurlijke, intuïtieve manier voor ons om ze te onderwijzen."

Het nieuwe leerkader geïntroduceerd door Smith en haar collega's maakt een ander type imitatieleren mogelijk, waar een robot leert om één doel op een hoger niveau tegelijk te voltooien, focussen op wat het bij elke stap het meest uitdagend vindt. Bovendien, in plaats van menselijke gebruikers te verplichten de scène na elke oefenproef opnieuw in te stellen, hiermee kunnen robots de scène automatisch resetten en doorgaan met oefenen. In de toekomst, AVID kan imitatieleerprocessen verbeteren, waardoor ontwikkelaars robots sneller en effectiever kunnen trainen.

"Een van de belangrijkste beperkingen van ons werk tot nu toe is dat we gegevensverzameling en training van de CycleGAN nodig hebben voor elke nieuwe scène die de robot tegenkomt. We hopen de CycleGAN-training als een eenmalige, kosten vooraf, zodat de robot met een paar demonstraties en een beetje oefening zeer snel een zeer breed scala aan vaardigheden kan oppikken door eenmaal op een groot gegevenscorpus te trainen."

© 2020 Wetenschap X Netwerk

Maleisië dringt bij EU aan op gepland verbod op palmolie in biobrandstoffen

Maleisië dringt bij EU aan op gepland verbod op palmolie in biobrandstoffen Kilauea begrijpen - een andere smaak van vulkaan

Kilauea begrijpen - een andere smaak van vulkaan Onderzoeker wil de macht om luchtvervuiling te modelleren in jouw handen leggen

Onderzoeker wil de macht om luchtvervuiling te modelleren in jouw handen leggen Wat zijn groenten en fruit die onder de grond groeien?

Wat zijn groenten en fruit die onder de grond groeien?  Klimaatverandering maakt herhaling Dust Bowl twee keer zo waarschijnlijk

Klimaatverandering maakt herhaling Dust Bowl twee keer zo waarschijnlijk

Hoofdlijnen

- Animal Cell Shoe Box Project

- Enorme golf van vlinders verlicht weerradar van Denver

- Designer-eiwitten die genetisch materiaal verpakken, kunnen helpen bij het leveren van gentherapie

- Een parasiet volgen die vissen verwoest

- Cellulaire ademhaling in ontkiemende zaden

- Fun Biology Presentatie Onderwerpen

- Is er eerder enige vorm van exploratie op Mercurius gedaan

- Eiwit beëindigt opzettelijk de eigen synthese door de synthesemachinerie te destabiliseren - het ribosoom

- Hoe hoog kan een boom worden?

Zeldzame metalen uit e-waste

Zeldzame metalen uit e-waste Groene IT:nieuw schakelproces in niet-vluchtige spintronica-apparaten

Groene IT:nieuw schakelproces in niet-vluchtige spintronica-apparaten Britse kerktorens gebruikten om telefoon te stimuleren, wifi signaal

Britse kerktorens gebruikten om telefoon te stimuleren, wifi signaal Grumman F4F Wildcat

Grumman F4F Wildcat  Bewoners verdeeld over toekomst van Roemeense vuilnisbelt-tijdbom

Bewoners verdeeld over toekomst van Roemeense vuilnisbelt-tijdbom Het aritmische kloppen van het hart van een zwart gat

Het aritmische kloppen van het hart van een zwart gat De drie fasen van fotosynthese

De drie fasen van fotosynthese Eerste vrouwelijke gamers kwalificeren zich voor NBA 2K League draft pool

Eerste vrouwelijke gamers kwalificeren zich voor NBA 2K League draft pool

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | French | Italian |

-

Wetenschap © https://nl.scienceaq.com