Wetenschap

Een nieuw deep learning-model voor EEG-gebaseerde emotieherkenning

Krediet:Hwang et al.

Recente ontwikkelingen op het gebied van machinaal leren hebben de ontwikkeling mogelijk gemaakt van technieken om menselijke emoties te detecteren en te herkennen. Sommige van deze technieken werken door het analyseren van elektro-encefalografie (EEG) signalen, die in wezen opnames zijn van de elektrische activiteit van de hersenen die zijn verzameld op de hoofdhuid van een persoon.

De meeste op EEG gebaseerde emotieclassificatiemethoden die in de afgelopen tien jaar zijn geïntroduceerd, maken gebruik van traditionele machine learning (ML) technieken zoals support vector machine (SVM) modellen, omdat deze modellen minder trainingsmonsters nodig hebben en er nog steeds een gebrek is aan grootschalige EEG-datasets. Onlangs, echter, onderzoekers hebben verschillende nieuwe datasets met EEG-hersenopnames samengesteld en vrijgegeven.

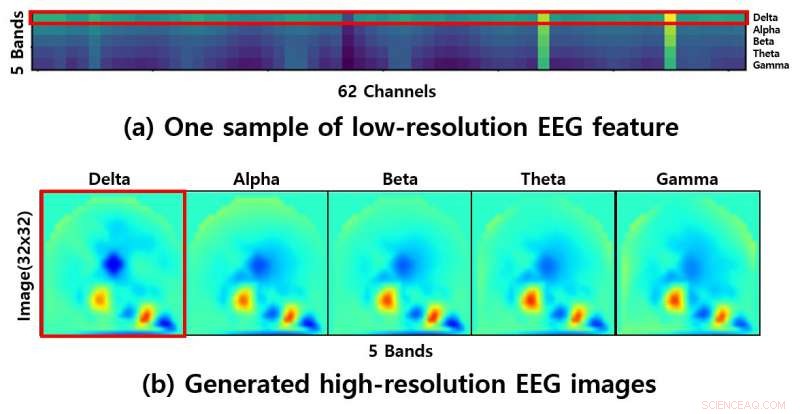

Het vrijgeven van deze datasets opent spannende nieuwe mogelijkheden voor op EEG gebaseerde emotieherkenning, omdat ze kunnen worden gebruikt om diepgaande leermodellen te trainen die betere prestaties leveren dan traditionele ML-technieken. Helaas, echter, de lage resolutie van EEG-signalen in deze datasets zou het trainen van deep-learningmodellen nogal moeilijk kunnen maken.

"Problemen met lage resolutie blijven een probleem voor op EEG gebaseerde emotieclassificatie, "Sunhee Hwang, een van de onderzoekers die het onderzoek heeft uitgevoerd, vertelde TechXplore. "We hebben een idee bedacht om dit probleem op te lossen, waarbij EEG-beelden met hoge resolutie worden gegenereerd."

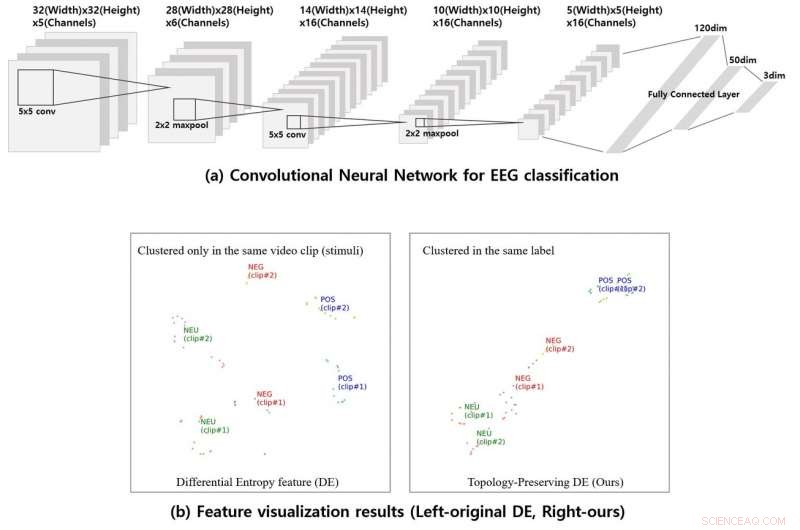

Om de resolutie van beschikbare EEG-gegevens te verbeteren, Hwang en haar collega's genereerden eerst zogenaamde "topologiebehoudende differentiële entropiekenmerken" met behulp van de elektrodecoördinaten op het moment dat de gegevens werden verzameld. Vervolgens, ze ontwikkelden een convolutioneel neuraal netwerk (CNN) en trainden het op de bijgewerkte gegevens, het leren om drie algemene klassen van emoties in te schatten (d.w.z. positief, neutraal en negatief).

Krediet:Hwang et al.

"Eerdere methoden hebben de neiging om de topologie-informatie van EEG-functies te negeren, maar onze methode verbetert de EEG-representatie door de gegenereerde EEG-beelden met hoge resolutie te leren, " Hwang zei. "Onze methode herclustert de EEG-functies via de voorgestelde CNN, wat het effect van clustering mogelijk maakt om een betere representatie te bereiken."

De onderzoekers trainden en evalueerden hun aanpak op de SEED-dataset, die 62-kanaals EEG-signalen bevat. Ze ontdekten dat hun methode emoties kon classificeren met een opmerkelijke gemiddelde nauwkeurigheid van 90,41 procent, beter presteren dan andere machine learning-technieken voor EEG-gebaseerde emotieherkenning.

"Als de EEG-signalen worden opgenomen van verschillende emotionele clips, de originele DE-functies kunnen niet worden geclusterd, "Hwang voegde toe. "We hebben onze methode ook toegepast op de taak om de waakzaamheid van een chauffeur te schatten om zijn kant-en-klare beschikbaarheid aan te tonen."

In de toekomst, de door Hwang en haar collega's voorgestelde methode zou de ontwikkeling van nieuwe op EEG gebaseerde hulpmiddelen voor emotieherkenning kunnen helpen, omdat het een haalbare oplossing introduceert voor het overwinnen van de problemen die verband houden met de lage resolutie van EEG-gegevens. Dezelfde benadering zou ook kunnen worden toegepast op andere diepgaande leermodellen voor de analyse van EEG-gegevens, zelfs die ontworpen voor iets anders dan het classificeren van menselijke emoties.

"Voor computervisietaken, grootschalige datasets maakten het enorme succes mogelijk van deep-learningmodellen voor beeldclassificatie, waarvan sommige verder reiken dan menselijke prestaties, "Hwang zei. "Ook, complexe voorbewerking van gegevens is niet langer nodig. In ons toekomstige werk, we hopen grootschalige EEG-datasets te genereren met behulp van een gegenereerd adversarial netwerk (GAN)."

© 2019 Wetenschap X Netwerk

Op ijzer gebaseerde zonnecellen op weg om efficiënter te worden

Op ijzer gebaseerde zonnecellen op weg om efficiënter te worden Wat is de pH-waarde van baking soda?

Wat is de pH-waarde van baking soda?  Vraag en antwoord:het fascinerende achtergrondverhaal van het periodiek systeem, die op het punt staat 150 jaar te worden

Vraag en antwoord:het fascinerende achtergrondverhaal van het periodiek systeem, die op het punt staat 150 jaar te worden Ultrasone trillingen dwingen een polymeer om een halfgeleider te zijn

Ultrasone trillingen dwingen een polymeer om een halfgeleider te zijn Wat is het effect van PH op levende organismen?

Wat is het effect van PH op levende organismen?

Afrikaanse landen kunnen niet industrialiseren? Ja, ze kunnen

Afrikaanse landen kunnen niet industrialiseren? Ja, ze kunnen Bemesting van de oceaan door ongewone microben strekt zich uit tot ijskoude wateren van de Noordelijke IJszee

Bemesting van de oceaan door ongewone microben strekt zich uit tot ijskoude wateren van de Noordelijke IJszee Satelliet vindt windschering die tropische storm Nadine treft

Satelliet vindt windschering die tropische storm Nadine treft Wat als een hoofdwatervoorziening besmet zou zijn met een of andere vorm van bacteriën?

Wat als een hoofdwatervoorziening besmet zou zijn met een of andere vorm van bacteriën?  EPA ziet Californië vooruitgang boeken met de achterstand in schone lucht na bedreigingen voor snelwegfinanciering

EPA ziet Californië vooruitgang boeken met de achterstand in schone lucht na bedreigingen voor snelwegfinanciering

Hoofdlijnen

- Waarom zijn de Neanderthalers uitgestorven?

- Is het menselijk brein nog in ontwikkeling?

- Uitgebreide quota voor blauwvintonijn kunnen het herstel ongedaan maken:wetenschappers

- Kan een viraal genoom worden gemaakt van zowel DNA als RNA?

- Sociale interacties hebben voorrang op genetica wanneer vogels nieuwe liedjes leren

- Wetenschappers zouden supermodelbouwers moeten zijn

- Mannelijke mammoeten vielen vaker in natuurlijke vallen en stierven, DNA-bewijs suggereert:

- Volledige structuur van mitochondriaal respiratoir supercomplex gedecodeerd

- Het bewijs zit in de voetafdruk:mensen kwamen eerder naar Amerika dan gedacht

- Ryanair waarschuwt voor banenverlies in Duitsland als stakingen aanhouden

- Het gebruik van je smartphone in de supermarkt kan 41% aan je boodschappenrekening toevoegen

- Jack Ma onthult opvolgingsplannen, niet aanstaande pensionering:SCMP

- Uitbetaling voor Musk aangezien de waarde van Tesla de $ 100 miljard overschrijdt

- Van dollars tot bytes:digitale betalingstechnologiebedrijven fuseren

Manipuleren van liganden:een nieuwe dimensie voor het bevorderen van elektrokatalyseprestaties door aerogels van edelmetaal

Manipuleren van liganden:een nieuwe dimensie voor het bevorderen van elektrokatalyseprestaties door aerogels van edelmetaal Het gewicht van verplaatst water berekenen

Het gewicht van verplaatst water berekenen Team ontwikkelt satellieten die andere satellieten repareren

Team ontwikkelt satellieten die andere satellieten repareren Engineers Smart Speaker Firewall isoleert Alexa-apparaten in een handomdraai

Engineers Smart Speaker Firewall isoleert Alexa-apparaten in een handomdraai Wetenschappers doen er alles aan om superlage wrijving te verlengen

Wetenschappers doen er alles aan om superlage wrijving te verlengen De rol van microben in de productie van yoghurt

De rol van microben in de productie van yoghurt  Common House Spiders en hun paring-habits

Common House Spiders en hun paring-habits Hoe asteroïde mijnbouw zal werken

Hoe asteroïde mijnbouw zal werken

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com