Wetenschap

ExAG:een spel voor het raden van afbeeldingen om de bruikbaarheid van machineverklaringen te evalueren

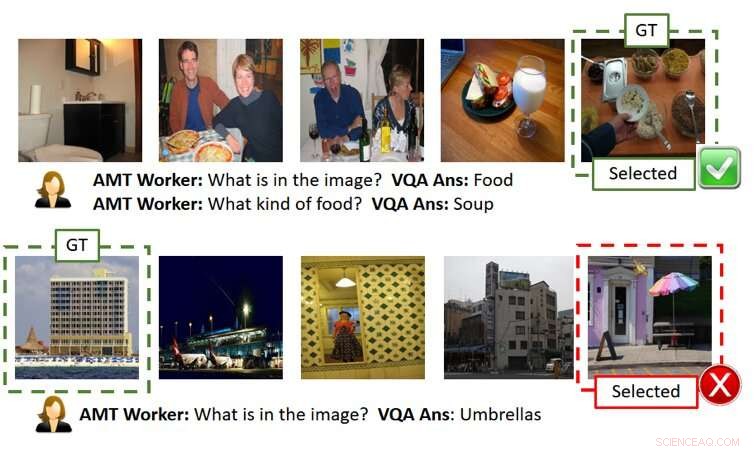

De afbeelding hierboven toont twee gameplay zonder uitleg (elke rij is een voorbeeld van een gameplay). Zoals weergegeven in de bovenste rij, de gebruiker (d.w.z. AMT Worker sinds we Amazon Mechanical Turk hebben gebruikt voor grootschalige crowd-source-gebaseerde evaluatie) is in staat om de geheime afbeelding correct te achterhalen, gegeven nauwkeurige AI-antwoorden. Echter, zoals weergegeven in de onderste rij, de gebruiker kan falen, zelfs als AI-antwoorden redelijk zijn, maar enigszins afwijkend (d.w.z. er is een paraplu-achtige structuur naast het gebouw, hoewel het niet de focus is van het grond-waarheidsbeeld). GT betekent Ground Truth (d.w.z. het geheime beeld), Geselecteerd is de afbeelding die door de gebruiker is geselecteerd na het stellen van de vragen en het krijgen van de antwoorden en/of uitleg. Krediet:Ray et al.

In recente jaren, onderzoekers hebben geprobeerd kunstmatige intelligentie (AI) transparanter te maken door algoritmen te ontwikkelen die hun acties en gedrag kunnen verklaren, omdat dit een groter vertrouwen in machines zou kunnen stimuleren en de interactie tussen mens en AI zou kunnen verbeteren. Ondanks hun inspanningen, tot nu toe hebben zeer weinig studies de impact van AI-verklaringen op de prestaties die worden behaald bij taken waarbij samenwerking tussen mens en AI betrokken is, tastbaar geëvalueerd.

Om deze lacune in de bestaande literatuur aan te pakken, een team van onderzoekers van SRI International heeft een mens-AI-beeldraadspel gemaakt, geïnspireerd op het populaire spel 20 Questions (20Q), die kan worden gebruikt om de bruikbaarheid van machineverklaringen te evalueren. hun papier, onlangs gepubliceerd op arXiv, is een van de eersten die de effecten onderzoekt van het ontwikkelen van meer 'verklaarbare' AI.

"Het idee ontstond toen we aan een DARPA-project werkten, "Arijit Ray, een computerwetenschapper bij SRI International die de studie heeft uitgevoerd, vertelde TechXolore. "In dit project, we ontwikkelen verklaarbare AI-systemen, die niet alleen de gewenste output genereren (bijv. objectdetectie, antwoorden op vragen, etc.) maar ook uitleg over hoe ze tot die output zijn gekomen. We hadden een mechanisme nodig om te evalueren of de aanvullende uitleg van AI's nuttig was voor de gebruiker om de AI-systemen beter te begrijpen. Hiertoe, we hebben een interactieve samenwerkingstaak tussen mens en AI gemaakt, Uitleg-geassisteerde GuessWhich (ExAG), wat een bewerking is van het beroemde 20Q-spel, om de effectiviteit aan te tonen van de verschillende machineverklaringstechnieken die we ontwikkelen."

Het door Ray en zijn collega's ontwikkelde beeld-raadspel lijkt sterk op het populaire spel 20 Questions, waarbij meestal twee spelers betrokken zijn. in 20Q, een speler denkt aan iets en de tweede speler probeert te raden wat het is door 20 gesloten vragen te stellen (d.w.z. vragen die alleen met 'ja' of 'nee' beantwoord kunnen worden).

In ExAG, de aanpassing van het spel bedacht door Ray en zijn collega's, een gebruiker krijgt vijf afbeeldingen te zien, waarvan er één door het AI-systeem is gekozen als het 'geheime beeld'. Eigenlijk, de gebruiker moet uitzoeken welke van de foto's hij/zij de 'geheime afbeelding' heeft gezien, ' door er natuurlijke taalvragen over te stellen.

In tegenstelling tot het traditionele 20Q-spel, in ExAG kunnen menselijke gebruikers zowel gesloten als open vragen stellen. Bijvoorbeeld, ze zouden kunnen vragen 'wat staat er op de afbeelding?, ' 'Waar is de foto genomen?' enzovoort. Het AI-systeem beantwoordt de vragen van een gebruiker één voor één en kan optioneel de antwoorden toelichten.

Op basis van deze antwoorden de gebruiker zal dan proberen de afbeelding te raden die de AI oorspronkelijk had geselecteerd. Het algemene doel van het spel is om het 'geheime beeld' correct te identificeren door zo min mogelijk vragen te stellen.

"Het AI-systeem biedt twee manieren van verklaringen, visueel en tekstueel, " legde Ray uit. "Voor visuele uitleg, het AI-systeem genereert warmtekaarten die de regio's benadrukken die de antwoorden ondersteunen. Bijvoorbeeld, als een gebruiker vraagt wat er in de afbeelding staat, en het lijkt op een hond, de AI zal de hondenregio markeren en zeggen dat dit leidt tot het antwoord 'het is een hond'. Voor tekstuele uitleg, anderzijds, het AI-systeem biedt antwoorden op gerelateerde vragen voor elk van de afbeeldingen. Dus, als je vraagt wat iemand doet en het antwoord is surfen, bijvoorbeeld, het beantwoordt ook gerelateerde vragen zoals 'wat zie ik in de afbeelding? Een surfer.' 'Waar is de foto genomen? Een strand.'

Vanwege de aard van het spel voor het raden van afbeeldingen, de kwaliteit van de antwoorden en uitleg van de AI kan het succes en de prestaties van een menselijke gebruiker aanzienlijk beïnvloeden. Het is vermeldenswaard dat de huidige state-of-the-art prestaties bij het beantwoorden van visuele vragen ongeveer 65 procent bedragen, wat betekent dat het AI-systeem 65 procent van de tijd correcte antwoorden genereert.

Ray en zijn collega's merkten op dat gebruikers doorgaans in ExAG slaagden door gebruik te maken van de AI's-verklaringen, vooral als de antwoorden zelf fout waren. Bijvoorbeeld, als het 'geheime beeld' een hond afbeeldt, maar de AI antwoordt 'het is een surfer, ' een visuele verklaring kan een menselijke gebruiker helpen de fout van de AI te beseffen. Volgens de onderzoekers is dit bewijst dat hun spel een geschikt hulpmiddel is om de bruikbaarheid van AI-verklaringen te evalueren.

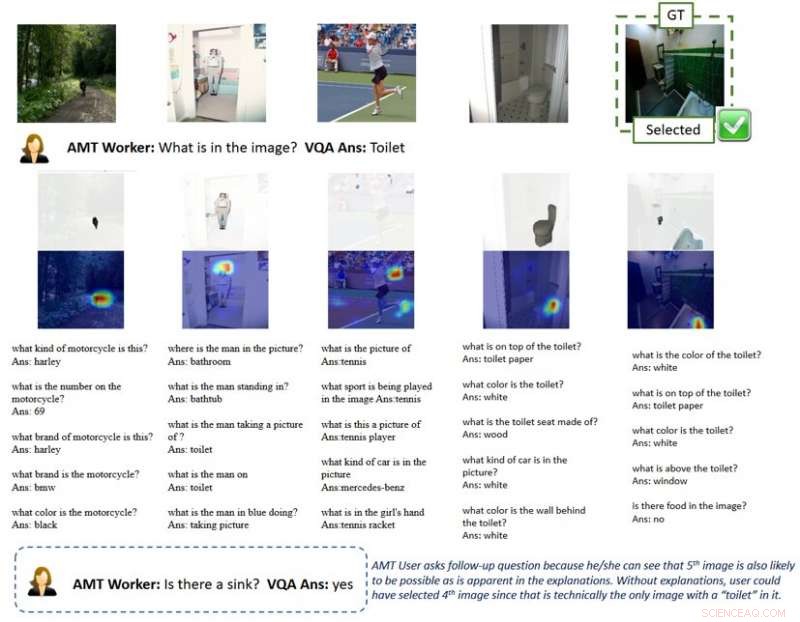

De afbeelding hierboven toont een gameplay met uitleg. De visuele uitleg van de heatmap markeert de regio's in de afbeeldingen die naar AI-antwoorden leiden. Met zo'n uitleg gebruikers begrijpen dat AI-systemen objecten kunnen oppikken die niet de belangrijkste focus van het beeld zijn vanuit het perspectief van de mens bij het beantwoorden van een algemene vraag als "wat staat er in het beeld". Dit geeft de gebruiker een hint om vervolgvragen te stellen en uiteindelijk de geheime afbeelding correct te selecteren. GT betekent Ground Truth (d.w.z. het geheime beeld), Geselecteerd is de afbeelding die door de gebruiker is geselecteerd na het stellen van de vragen en het krijgen van de antwoorden en/of uitleg. Krediet:Ray et al.

"Naar mijn mening, het meest interessante resultaat van ons onderzoek is dat gebruikers slechts een paar goede verklaringen kunnen gebruiken om games te winnen wanneer de AI-antwoorden meestal fout zijn, " zei Ray. "In tegenstelling, voor games met een vergelijkbare nauwkeurigheid van antwoorden, maar zonder uitleg, gebruikers blindelings vertrouwen op AI-gegenereerde antwoorden en verliezen het spel. Dit ondersteunt het belang van zelfs maar een paar goede verklaringen voor mens-AI-samenwerkingssystemen, vooral wanneer het AI-systeem onvolmaakt is, wat het tegenwoordig in de meeste gevallen is."

Om dit idee beter uit te leggen, Ray geeft het voorbeeld van zelfrijdende voertuigen. De afgelopen jaren is er is veel discussie geweest over hun veiligheid, ook als gevolg van ongevallen die plaatsvonden terwijl de voertuigen werden getest. Volgens Ray, effectieve AI-verklaringen zouden kunnen leiden tot meer vertrouwen in de veiligheid van zelfrijdende voertuigen, omdat ze menselijke bestuurders in staat zouden stellen problemen vooraf te identificeren en ongevallen te voorkomen.

"Bijvoorbeeld, laten we aannemen dat het AI-systeem problemen ondervindt om de rijstroken betrouwbaar te detecteren, " zei Ray. "Omdat de weg momenteel recht is, zonder aanvullende informatie, de gebruiker zou niet kunnen zeggen of de AI faalt. Zelfs als hij/zij enige twijfels had, hij/zij zou waarschijnlijk niets doen tot het laatste moment, wanneer de auto een bocht moet nemen, niet, en crashes, wat te laat zou zijn. In tegenstelling tot, als een scherm in de auto uitleg gaf over hoe AI de omgeving waarneemt, zoals warmtekaarten, de gebruiker zou het latente falen van de AI kunnen zien en van tevoren het stuur kunnen overnemen."

De onderzoekers ontdekten dat nuttige verklaringen de prestaties van menselijke gebruikers in het beeldraadspel positief beïnvloedden. Hun bevindingen suggereren dat het hebben van ten minste één 'juiste' verklaring significant nuttig was, vooral in gevallen waarin de antwoorden van de AI op gebruikersvragen 'luidruchtig' of slecht gedefinieerd waren. interessant, spelers ontwikkelden een voorkeur voor uitleg boven antwoorden en beoordeelden de AI-uitleg vaak als 'nuttig'.

"Ik denk dat terwijl verschillende werklijnen probeerden verklaringen te geven voor de resultaten of acties van een AI-systeem, de onze is de eerste studie die een samenwerkingstaak tussen mens en machine introduceert om de effectiviteit van AI-verklaringen te evalueren; dus, het bracht veel inzicht in hoe AI-verklaringen de interacties tussen mens en robot kunnen verbeteren, "Yi Yao, een senior technisch manager bij SRI International die betrokken was bij het onderzoek, vertelde TechXplore.

De studie van Ray en zijn collega's is een van de eerste die tastbaar bewijs levert van het nut van AI-verklaringen. De onderzoekers hopen dat hun onderzoek uiteindelijk zal leiden tot de ontwikkeling van AI-systemen die rationeel kunnen handelen in de samenleving, daardoor beter met mensen in contact komen en met mensen omgaan.

Volgens Ray, AI-systemen die de redenering en processen achter hun acties duidelijk kunnen uitleggen, zouden een belangrijke stap voorwaarts zijn in de ontwikkeling van intelligente machines. Door effectief vragen te beantwoorden en hun beslissingen te rationaliseren, deze systemen zouden een groter gevoel van vertrouwen in AI kunnen bevorderen, evenals een diepere relatie ermee.

"Veel andere bedrijven, groepen en onderzoeksgroepen hebben zich beziggehouden met verklaarbare AI, en er zijn veel voorstellen gedaan om bestaande AI-modellen en -systemen uit te breiden om gebruikers uitleg te geven, " zei Giedrius Burachas, een senior computerwetenschapper bij SRI International en hoofdonderzoeker achter de DARPA-studie die leidde tot de ontwikkeling van de Guess Which-game. "Hoewel er veel ideeën werden gegenereerd, bewijs dat deze ideeën werkten ontbrak, dus een van de sterke kanten van ons onderzoek is dat het onweerlegbaar bewijs levert dat bepaalde soorten verklaringen echt heel effectief zijn in het verbeteren van de samenwerking met de AI-systemen, maar ook om vertrouwen in hen op te bouwen."

Tot nu toe, het werk van Ray en zijn collega's was voornamelijk gericht op visuele vragen (VQA)-taken, waar gebruikers vragen stellen over afbeeldingen en een AI-antwoorden. Ze zijn nu van plan om hun onderzoek naar AI-verklaringstechnieken voort te zetten, deze technieken toepassen op een breder scala aan AI-taken.

"We zullen ook doorgaan met het ontwikkelen van protocollen om de effectiviteit van de door AI gegenereerde verklaringen te evalueren met meer granulariteit (bijvoorbeeld welke verklaring is effectiever in welke scenario's?) en vanuit verschillende perspectieven (bijvoorbeeld helpen verklaringen gebruikers om het mentale model op te bouwen?), ' zei Ray. 'Om de lus te sluiten, we zullen de lessen die uit deze evaluaties zijn getrokken gebruiken om effectievere uitlegmethoden te ontwikkelen. Wij geloven dat de heilige graal van verklaarbare AI is om verklaringen te bedenken die niet alleen gebruikers informeren, maar ook de machineprestaties verbeteren door het redeneervermogen te verbeteren."

Naast het onderzoeken van de effecten van AI-verklaringen op de prestaties en percepties van menselijke gebruikers, daarom, de onderzoekers willen hun impact op de AI-systemen zelf onderzoeken. Ze zijn van mening dat AI-verklaringen AI-systemen ook inherent beter kunnen maken, omdat ze geleidelijk aan vaardigheden zouden verwerven om te redeneren en te rationaliseren.

© 2019 Wetenschap X Netwerk

Hoe werken infrarood-thermometers?

Hoe werken infrarood-thermometers?  Nieuw krachtig antimicrobieel middel van thermofiele bacterie

Nieuw krachtig antimicrobieel middel van thermofiele bacterie De kracht van elektriciteitproducerende bacteriën benutten voor programmeerbare biohybriden

De kracht van elektriciteitproducerende bacteriën benutten voor programmeerbare biohybriden Nieuwe immunoassaytechniek meet extreem lage concentraties van kleine moleculen met behulp van detectie van één molecuul

Nieuwe immunoassaytechniek meet extreem lage concentraties van kleine moleculen met behulp van detectie van één molecuul Maak een lijst van enkele factoren die de diffusiesnelheid zouden verhogen

Maak een lijst van enkele factoren die de diffusiesnelheid zouden verhogen

Herzieningen van de drinkwaternorm verscherpen de uitloogtoelage voor loodgietersproducten

Herzieningen van de drinkwaternorm verscherpen de uitloogtoelage voor loodgietersproducten Hoe lang leeft een giraf?

Hoe lang leeft een giraf?  Wat is de levenscyclus van de Cobra?

Wat is de levenscyclus van de Cobra?  Hoe beïnvloeden internationale ontwikkelingsprojecten de waarde van onroerend goed?

Hoe beïnvloeden internationale ontwikkelingsprojecten de waarde van onroerend goed? Klimaatverandering en orkanen:hebben we een smoking gun nodig?

Klimaatverandering en orkanen:hebben we een smoking gun nodig?

Hoofdlijnen

- Hoe celorganellen samenwerken

- Vergeten is niet altijd slecht - het helpt ons betere beslissingen te nemen

- Spin eet spin:wetenschappers ontdekken 18 nieuwe op spinnen jagende pelikaanspinnen in Madagaskar

- Wat is osmotische lyse?

- Menselijk genoom DNA-sequentietypen

- Onderzoekers identificeren de gistgenen achter rozen- en honingaroma's in bier en wijn

- Is eclips gelijk aan nacht in het plantenleven? Onderzoekers testen plantritmes tijdens zonsverduistering

- Antibiotica uit een moleculaire puntenslijper

- Hoe verschilt mitose in de cellen van dieren en planten?

- SK Hynix boekt laagste winst in drie jaar

- Hoe ver moeten organisaties kunnen gaan in hun verdediging tegen cyberaanvallen?

- Singapore nodigt cyberaanvallen uit om verdediging te versterken

- Internet naar TLS 1.3:waar ben je mijn hele leven geweest

- Wetenschappers bevestigen eeuwenoude speculaties over de chemie van een krachtige batterij

Wetenschappers ontkrachten de effectiviteit van EnChroma-brillen voor kleurenblinde mensen

Wetenschappers ontkrachten de effectiviteit van EnChroma-brillen voor kleurenblinde mensen Science Fair Projects & Ideas on Art

Science Fair Projects & Ideas on Art  Nieuwe studie helpt verklaren hoe vuilvlekken zich vormen in de oceanen van de wereld

Nieuwe studie helpt verklaren hoe vuilvlekken zich vormen in de oceanen van de wereld Afbeelding:Grande America olieramp

Afbeelding:Grande America olieramp De effecten van waterpolariteit op levende wezens

De effecten van waterpolariteit op levende wezens Dakloosheid zal verergeren door de uitbraak van COVID-19, maar er zijn oplossingen

Dakloosheid zal verergeren door de uitbraak van COVID-19, maar er zijn oplossingen Uitzicht vanaf Juno tijdens zijn flyby van Ganymedes en Jupiter

Uitzicht vanaf Juno tijdens zijn flyby van Ganymedes en Jupiter Onderzoek suggereert dat sommige bevolkingsverschuivingen tijdens het vroege en late Holoceen te wijten waren aan klimaatveranderingen

Onderzoek suggereert dat sommige bevolkingsverschuivingen tijdens het vroege en late Holoceen te wijten waren aan klimaatveranderingen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com