Wetenschap

Onderzoekers maken het gezicht van Android-kinderen opvallend expressiever

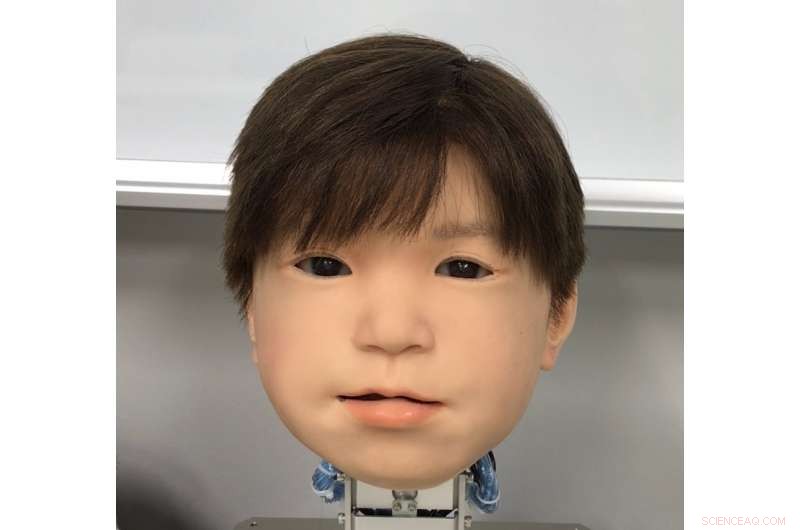

het nieuw ontwikkelde gezicht van de Affetto-kinderrobot voor Android. Affetto's gezicht werd voor het eerst onthuld in gepubliceerd onderzoek in 2011. Credit:Osaka University

Japans genegenheid voor robots is geen geheim. Maar is het gevoel wederzijds in de geweldige androïden van het land? Robotici zijn nu een stap dichter bij het geven van betere gezichtsuitdrukkingen aan androïden om mee te communiceren.

Ondanks vorderingen, het vastleggen van humanistische uitdrukkingen in een robotachtig gezicht blijft een ongrijpbare uitdaging. Hoewel hun systeemeigenschappen over het algemeen zijn aangepakt, gezichtsuitdrukkingen van androïden zijn niet in detail onderzocht. Dit is te wijten aan factoren zoals het enorme bereik en de asymmetrie van natuurlijke menselijke gezichtsbewegingen, de beperkingen van materialen die worden gebruikt in de Android-huid, en de ingewikkelde techniek en wiskunde die de bewegingen van robots aandrijven.

Een drietal onderzoekers van de Osaka University heeft nu een methode gevonden om gezichtsbewegingen op het hoofd van hun Android-robotkind te identificeren en kwantitatief te evalueren. genaamd Affetto, het model van de eerste generatie werd gerapporteerd in een publicatie uit 2011. De onderzoekers hebben nu een systeem ontwikkeld om de tweede generatie Affetto expressiever te maken. Hun bevindingen bieden een pad voor androïden om grotere reeksen van emoties uit te drukken, en uiteindelijk een diepere interactie met mensen hebben.

De onderzoekers rapporteerden hun bevindingen in het tijdschrift Grenzen in robotica en AI .

"Oppervlaktevervormingen zijn een belangrijk probleem bij het beheersen van Android-gezichten, " studie co-auteur Minoru Asada legt uit. "Bewegingen van hun zachte gezichtshuid creëren instabiliteit, en dit is een groot hardwareprobleem waarmee we worstelen. We zochten een betere manier om het te meten en te beheersen."

De onderzoekers onderzochten 116 verschillende gezichtspunten op Affetto om de driedimensionale beweging te meten. Gezichtspunten werden ondersteund door zogenaamde deformatie-eenheden. Elke eenheid bestaat uit een reeks mechanismen die een kenmerkende verdraaiing van het gezicht creëren, zoals het verlagen of verhogen van een deel van een lip of ooglid. Metingen hiervan werden vervolgens onderworpen aan een wiskundig model om hun oppervlaktebewegingspatronen te kwantificeren.

Terwijl de onderzoekers problemen ondervonden bij het balanceren van de uitgeoefende kracht en bij het aanpassen van de synthetische huid, ze konden hun systeem gebruiken om de vervormingseenheden aan te passen voor een nauwkeurige controle van de bewegingen van het gezichtsoppervlak van Affetto.

"Android-robotgezichten zijn nog steeds een black box-probleem:ze zijn geïmplementeerd, maar zijn alleen beoordeeld in vage en algemene termen, " studie eerste auteur Hisashi Ishihara zegt. "Onze precieze bevindingen zullen ons in staat stellen om Android-gezichtsbewegingen effectief te controleren om meer genuanceerde uitdrukkingen te introduceren, zoals glimlachen en fronsen."

Studie van Redoubt en andere vulkanen verbetert de detectie van onrust

Studie van Redoubt en andere vulkanen verbetert de detectie van onrust Onderzoek toont snelle zeespiegelstijging langs de Atlantische kust van Noord-Amerika in de 18e eeuw

Onderzoek toont snelle zeespiegelstijging langs de Atlantische kust van Noord-Amerika in de 18e eeuw Controleren microben de vorming van gigantische koperafzettingen?

Controleren microben de vorming van gigantische koperafzettingen? Industrie en actievoerders sparren over koolstofbelasting in Zuid-Afrika

Industrie en actievoerders sparren over koolstofbelasting in Zuid-Afrika Zwaar getroffen Indonesische stad begraaft doden terwijl tol de 840 . overschrijdt

Zwaar getroffen Indonesische stad begraaft doden terwijl tol de 840 . overschrijdt

Hoofdlijnen

- Langharige microben vernoemd naar Canadese band Rush

- Waar vindt transcriptie plaats in een eukaryote cel?

- Koeltechnologie om de levensvatbaarheid van het gekoelde muizensperma gedurende 10 dagen te behouden

- Deze spitsmuizen hebben koppen die krimpen met het seizoen

- Er zit een diepere vis in de zee

- Hagedis, schildpad tussen meer dan 100 nieuwe soorten gevonden in Mekong-regio

- Hoeveel weegt het leven?

- Vijf soorten isolatie in de biologie

- Radartracking onthult hoe bijen een route tussen bloemen ontwikkelen

- Het blockchain-concept

- Nissan-chef Ghosn gearresteerd wegens financieel wangedrag:rapporten

- Mede-oprichter van Apple zegt dat Goldmans Apple Card-algo discrimineert

- Rapport:Amazon-rekeningen controleren? Iets soortgelijks zou binnenkort kunnen komen

- Onderzoekers creëren een AI om ons te helpen het privacybeleid te begrijpen

Nieuwe catastrofale veranderlijke ster ontdekt

Nieuwe catastrofale veranderlijke ster ontdekt Een nieuwe methode om ionen door celmembranen te transporteren op basis van een enkel aminozuur

Een nieuwe methode om ionen door celmembranen te transporteren op basis van een enkel aminozuur Religieus geëngageerde adolescenten vertonen gewoonten die hen helpen betere cijfers te halen

Religieus geëngageerde adolescenten vertonen gewoonten die hen helpen betere cijfers te halen John Deere 4400 combineert specificaties

John Deere 4400 combineert specificaties  Nieuwe katalysator zet broeikasgassen om in waterstofgas

Nieuwe katalysator zet broeikasgassen om in waterstofgas Een lijst met interessante onderwerpen uit de landbouwtoespraak

Een lijst met interessante onderwerpen uit de landbouwtoespraak Smartphone-app gebruikt computervisie om verloren dieren te identificeren

Smartphone-app gebruikt computervisie om verloren dieren te identificeren Tekstboekformules voor het beschrijven van warmtestroomkarakteristieken, cruciaal in veel industrieën, zijn te eenvoudig, studie toont

Tekstboekformules voor het beschrijven van warmtestroomkarakteristieken, cruciaal in veel industrieën, zijn te eenvoudig, studie toont

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Spanish | Portuguese | German | Dutch | Danish | Norway | Italian | Swedish |

-

Wetenschap © https://nl.scienceaq.com