Wetenschap

Een algoritme om te detecteren wanneer online gesprekken waarschijnlijk lelijk worden

Krediet:CC0 Publiek Domein

Een team van onderzoekers van de Cornel University dat samenwerkt met de Wikimedia Foundation, heeft een digitaal raamwerk bedacht om te detecteren wanneer een online discussie waarschijnlijk lelijk wordt. In een paper geüpload naar de arXiv preprint-server, het team beschrijft hun aanpak en hoe goed hun algoritme werkte tijdens het testen.

Zoals de onderzoekers opmerken, online gesprekken kunnen vaak ontaarden in meningsverschillen en vaak persoonlijke aanvallen. Ze merken verder op dat dit vaak het geval is wanneer mensen een omgeving betreden waar kritiek, zoals Wikipedia. Daar, amateurredacteuren worden aangemoedigd om kritiek te leveren op het werk van anderen om de inhoud van de website te verbeteren. Helaas, veel mensen reageren niet goed op dergelijke kritiek, en als een resultaat, toevlucht nemen tot het plaatsen van vervelende opmerkingen. Het team van de Wikimedia Foundation zou dergelijke gesprekken willen beteugelen, want naast het koesteren van slechte gevoelens, het geeft de site ook een slechte reputatie. Om het probleem aan te pakken, het team werkte met de groep bij Cornell, die hetzelfde probleem hebben onderzocht; namelijk, het bouwen van een computersysteem dat in staat is te herkennen wanneer een menselijk gesprek dreigt te ontaarden in smerigheid, en om het ofwel te beteugelen, of beëindig het gesprek voor de betrokkenen.

Om dit probleem op te lossen, de onderzoekers keken naar meer dan 1, 200 online gesprekken op de Wikipedia-overlegpagina's op zoek naar taalkundige aanwijzingen. In deze context, cues waren woorden die houding en beleefdheid suggereerden. Door dit te doen, ze ontdekten dat wanneer mensen signalen als "alsjeblieft" en "bedankt" gebruikten, " er was minder kans dat dingen lelijk werden. Er waren ook positieve zinnen, zoals "ik denk" of "ik geloof" dat een poging deed om de zaken beschaafd te houden, die de neiging hadden om de zaken in evenwicht te houden. Anderzijds, ze vonden ook minder nuttige aanwijzingen, zoals wanneer gesprekken begonnen met directe vragen of het woord 'jij'. Dergelijke signalen leidden op een gegeven moment tot degradatie van beleefdheid en, suggereren de onderzoekers, worden door een lezer vaak gezien als vijandig en controversieel.

Het team ontwikkelde vervolgens een algoritme dat signalen als aangeleerde gegevens accepteerde en vervolgens zinnen ontleedde op zoek naar dergelijke signalen en er menselijke intuïtie op toepaste. Het resultaat, het team meldt, was een geautomatiseerd raamwerk dat vroeg kon herkennen wanneer een gesprek waarschijnlijk zou ontaarden in een lelijk spel van heen en weer. Ze vonden het systeem 61,6 procent nauwkeurig. Mensen die dezelfde test doen, echter, scoorde 72 procent.

© 2018 Fys.org

Modulerende spiraalvormige nanostructuren in vloeibare kristalfase door moleculair ontwerp

Modulerende spiraalvormige nanostructuren in vloeibare kristalfase door moleculair ontwerp Smelten van banden

Smelten van banden Duidelijk, geleidende coating kan geavanceerde zonnecellen beschermen, aanraakschermen

Duidelijk, geleidende coating kan geavanceerde zonnecellen beschermen, aanraakschermen Eiwit vermengt zich onder blauw licht

Eiwit vermengt zich onder blauw licht De weg verlichten voor het verwijderen van radioactieve elementen

De weg verlichten voor het verwijderen van radioactieve elementen

Hoe Ohio Wild Mushrooms te identificeren

Hoe Ohio Wild Mushrooms te identificeren Actieve farmaceutische ingrediënten kunnen in het milieu blijven bestaan

Actieve farmaceutische ingrediënten kunnen in het milieu blijven bestaan Pandemische afsluitingen resulteerden in minder smelten van sneeuw en ijs in het stroomgebied van de Indus

Pandemische afsluitingen resulteerden in minder smelten van sneeuw en ijs in het stroomgebied van de Indus Nepal lijkt toegang tot Everest te beperken na sterfgevallen, maar twijfels blijven hangen

Nepal lijkt toegang tot Everest te beperken na sterfgevallen, maar twijfels blijven hangen Geografen gebruiken big data om te voorspellen hoe helling de reissnelheid van mensen beïnvloedt

Geografen gebruiken big data om te voorspellen hoe helling de reissnelheid van mensen beïnvloedt

Hoofdlijnen

- Hoe de delen van de menselijke schedel te leren

- In vijverschuim, wetenschappers vinden antwoorden op een evolutie die het eerst kwam gevallen

- Onderzoekers ontwikkelen een gel voor het kweken van grote hoeveelheden neurale stamcellen

- Waarom is een atom elektrisch neutraal?

- Fysieke aanpassingen van rondwormen

- Wat zijn de vier macromoleculen van het leven?

- Wat zijn de voor- en nadelen van endotherm zijn?

- Wat zijn de twee hoofdfasen van de celcyclus?

- Hoe fenotypische ratio te berekenen

- Team bouwt de eerste levende robots

- Brandbeveiliging verhogen door virtual reality

- Argonne maakt gebruik van virtuele kracht om de meest complexe uitdagingen in de nucleaire wetenschap aan te pakken

- Shell:winst springt omhoog door hoge energieprijzen

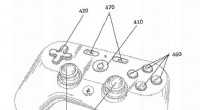

- Google:Patenttalk wekt nieuwsgierigheid op over controller voor streamingdienst

Aalto-2 reageert niet meer op commando's

Aalto-2 reageert niet meer op commando's Facebook heeft een paar jaar nodig om problemen op te lossen:Zuckerberg

Facebook heeft een paar jaar nodig om problemen op te lossen:Zuckerberg Afbeelding:Hubble ziet sterrenstelsels hemelse pailletten

Afbeelding:Hubble ziet sterrenstelsels hemelse pailletten Een sweet spot van de golven onthuld

Een sweet spot van de golven onthuld Warmte voelen op het dak van de wereld

Warmte voelen op het dak van de wereld orang-oetans, zoals mensen, geneeskrachtige planten gebruiken om gewrichts- en spierontsteking te behandelen

orang-oetans, zoals mensen, geneeskrachtige planten gebruiken om gewrichts- en spierontsteking te behandelen Jeff Bezoss Blue Origin-raket maakt 12e testvlucht

Jeff Bezoss Blue Origin-raket maakt 12e testvlucht Een test van 25 minuten kan de eerste diagnose van urineweginfecties vereenvoudigen, strijd tegen antibioticaresistentie

Een test van 25 minuten kan de eerste diagnose van urineweginfecties vereenvoudigen, strijd tegen antibioticaresistentie

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | Italian |

-

Wetenschap © https://nl.scienceaq.com