Wetenschap

De Adversarial Robustness Toolbox:AI beveiligen tegen vijandige bedreigingen

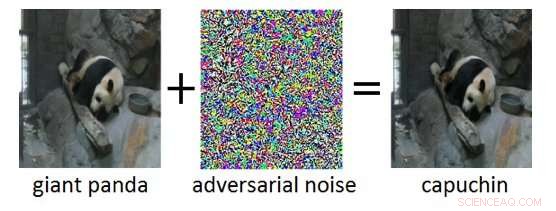

Afbeelding 1:Voorbeeld van een tegenstander (rechts) verkregen door vijandige ruis (midden) toe te voegen aan een schone invoerafbeelding (links). Hoewel de toegevoegde ruis in het tegenstrijdige voorbeeld niet waarneembaar is voor een mens, het leidt ertoe dat het Deep Neural Network de afbeelding verkeerd classificeert als 'kapucijner' in plaats van 'reuzenpanda'. Krediet:IBM Blog Research

De afgelopen jaren zijn er enorme vorderingen gemaakt in de ontwikkeling van kunstmatige intelligentie (AI). Moderne AI-systemen bereiken prestaties op menselijk niveau bij cognitieve taken zoals het herkennen van objecten in afbeeldingen, annoteren van video's, spraak omzetten in tekst, of vertalen tussen verschillende talen. Veel van deze baanbrekende resultaten zijn gebaseerd op Deep Neural Networks (DNN's). DNN's zijn complexe machinale leermodellen die enige gelijkenis vertonen met de onderling verbonden neuronen in het menselijk brein. DNN's kunnen omgaan met hoogdimensionale invoer (bijvoorbeeld miljoenen pixels in afbeeldingen met een hoge resolutie), patronen weergeven in die inputs op verschillende abstractieniveaus, en het relateren van die representaties aan semantische concepten op hoog niveau.

Een intrigerende eigenschap van DNN's is dat, terwijl ze normaal gesproken zeer nauwkeurig zijn, ze zijn kwetsbaar voor zogenaamde vijandige voorbeelden. Tegenstrijdige voorbeelden zijn inputs (zeg, afbeeldingen) die opzettelijk zijn aangepast om een gewenste reactie te produceren door een DNN. Een voorbeeld wordt getoond in figuur 1:hier leidt de toevoeging van een kleine hoeveelheid vijandige ruis aan het beeld van een reuzenpanda ertoe dat de DNN dit beeld verkeerd classificeert als een kapucijner. Vaak, het doelwit van vijandige voorbeelden is een verkeerde classificatie of een specifieke onjuiste voorspelling die een aanvaller ten goede zou komen.

Tegenstrijdige aanvallen vormen een reële bedreiging voor de inzet van AI-systemen in beveiligingskritieke toepassingen. Vrijwel niet-detecteerbare wijzigingen van afbeeldingen, video, toespraak, en andere gegevens zijn gemaakt om AI-systemen te verwarren. Dergelijke wijzigingen kunnen zelfs worden aangebracht als de aanvaller geen exacte kennis heeft van de architectuur van de DNN of toegang tot de parameters ervan. Nog zorgelijker, vijandige aanvallen kunnen worden gelanceerd in de fysieke wereld:in plaats van de pixels van een digitaal beeld te manipuleren, tegenstanders zouden gezichtsherkenningssystemen kunnen ontwijken door een speciaal ontworpen bril te dragen, of versla visuele herkenningssystemen in autonome voertuigen door patches op verkeersborden te plakken.

IBM Research Ireland brengt de Adversarial Robustness Toolbox uit, een open-source softwarebibliotheek, om zowel onderzoekers als ontwikkelaars te ondersteunen bij het verdedigen van DNN's tegen vijandige aanvallen en daardoor AI-systemen veiliger te maken. De release zal worden aangekondigd op de RSA-conferentie door Dr. Sridhar Muppidi, IBM-fellow, VP en CTO IBM Beveiliging, en Koos Lodewijkx, Vice President en CTO van Security Operations and Response (SOAR), IBM-beveiliging.

De Adversarial Robustness Toolbox is ontworpen om onderzoekers en ontwikkelaars te ondersteunen bij het creëren van nieuwe verdedigingstechnieken, evenals bij het inzetten van praktische verdediging van real-world AI-systemen. Onderzoekers kunnen de Adversarial Robustness Toolbox gebruiken om nieuwe verdedigingen te vergelijken met de allernieuwste. Voor ontwikkelaars, de bibliotheek biedt interfaces die de samenstelling van uitgebreide verdedigingssystemen ondersteunen met behulp van individuele methoden als bouwstenen.

De bibliotheek is geschreven in Python, de meest gebruikte programmeertaal voor het ontwikkelen, testen en implementeren van DNN's. Het omvat state-of-the-art algoritmen voor het maken van tegenstrijdige voorbeelden en methoden om DNN's daartegen te verdedigen. De aanpak voor het verdedigen van DNN's is drieledig:

- Robuustheid van modellen meten. Ten eerste, de robuustheid van een bepaalde DNN kan worden beoordeeld. Een eenvoudige manier om dit te doen, is door het verlies aan nauwkeurigheid vast te leggen op adversarieel gewijzigde invoer. Andere benaderingen meten hoeveel de interne representaties en de output van een DNN variëren wanneer kleine veranderingen worden toegepast op de inputs.

- Modelverharding. Ten tweede, een gegeven DNN kan worden "verhard" om het robuuster te maken tegen vijandige input. Veelvoorkomende benaderingen zijn het voorbewerken van de invoer van een DNN, om de trainingsgegevens aan te vullen met voorbeelden van tegenstanders, of om de DNN-architectuur te wijzigen om te voorkomen dat vijandige signalen zich door de interne representatielagen verspreiden.

- Runtime-detectie. Eindelijk, runtime-detectiemethoden kunnen worden toegepast om alle invoer te markeren waarmee een tegenstander mogelijk heeft getemperd. Die methoden proberen typisch abnormale activeringen te exploiteren in de interne representatielagen van een DNN veroorzaakt door de vijandige input.

Om aan de slag te gaan met de Adversarial Robustness Toolbox, bekijk de open-source release onder github.com/IBM/adversarial-robustness-toolbox . De release bevat uitgebreide documentatie en tutorials om onderzoekers en ontwikkelaars te helpen snel aan de slag te gaan. Een witboek met details van de methoden die in de bibliotheek zijn geïmplementeerd, is in voorbereiding.

Deze eerste release van de Adversarial Robustness Toolbox ondersteunt DNN's die zijn geïmplementeerd in de deep learning-frameworks TensorFlow en Keras. Toekomstige releases zullen de ondersteuning uitbreiden naar andere populaire frameworks zoals PyTorch of MXNet. Momenteel, de bibliotheek is in de eerste plaats bedoeld om de vijandige robuustheid van visuele herkenningssystemen te verbeteren, echter, we werken aan toekomstige releases die aanpassingen zullen bevatten aan andere datamodi zoals spraak, tekst of tijdreeksen.

Als een open source-project, de ambitie van de Adversarial Robustness Toolbox is om een levendig ecosysteem te creëren van medewerkers uit zowel de industrie als de academische wereld. Het belangrijkste verschil met soortgelijke lopende inspanningen is de focus op verdedigingsmethoden, en over de samenstelling van praktische verdedigingssystemen. We hopen dat het Adversarial Robustness Toolbox-project onderzoek en ontwikkeling rond vijandige robuustheid van DNN's zal stimuleren, en de inzet van veilige AI in toepassingen in de echte wereld bevorderen. Deel uw ervaring met het werken met de Adversarial Robustness Toolbox en eventuele suggesties voor toekomstige verbeteringen met ons.

Nieuwe studie werpt licht op het ontwerpen van heterogene katalysatoren voor selectieve fotoreductie van koolstofdioxide

Nieuwe studie werpt licht op het ontwerpen van heterogene katalysatoren voor selectieve fotoreductie van koolstofdioxide Nieuwe koolwaterstofbrandstofcellen met hoog rendement en lage kosten

Nieuwe koolwaterstofbrandstofcellen met hoog rendement en lage kosten Probiotica beschermen tegen de maag

Probiotica beschermen tegen de maag Een beter biosensorpolymeer bouwen

Een beter biosensorpolymeer bouwen Een SN1-reactie gebruiken om quaternaire stereocentra te maken

Een SN1-reactie gebruiken om quaternaire stereocentra te maken

Hoofdlijnen

- Kleine rode dieren schieten in het donker onder het ijs van een bevroren meer in Quebec

- Hoe een cellenvorm zijn functie beïnvloedt

- Drie soorten vezelig bindweefsel

- Voors en tegens van Recombinant DNA Technology

- The Krebs Cycle Made Easy

- Wat zijn stamcellen en waarvoor worden ze gebruikt?

- Waarom dromen we?

- Een keep-fit gadget voor uw hond deze kerst - wie heeft er echt baat bij?

- Het belang van asymmetrie bij bacteriën

- Gaat Facebook tv opnieuw uitvinden met Facebook Watch? We zullen, het is proberen

- Meten:ONR-technologie zorgt ervoor dat piloten en vliegtuigen perfect bij elkaar passen

- Canada nu 's werelds grootste legale marihuana-marktplaats

- Gebouwen energie geven

- Kunstmatige intelligentie werpt licht op het dark web

Chinese astronomen onderzoeken spectraal gedrag van gammastraling Blazar S5 0716+714

Chinese astronomen onderzoeken spectraal gedrag van gammastraling Blazar S5 0716+714 Wat is elektrolytisch koper?

Wat is elektrolytisch koper?  Draait de aarde aan de bovenkant langzamer of sneller?

Draait de aarde aan de bovenkant langzamer of sneller?  Gecoördineerde ontwikkeling kan windparken helpen betere buren te worden

Gecoördineerde ontwikkeling kan windparken helpen betere buren te worden Hoe maak je thuis een zonnestelselmodel voor een schoolproject

Hoe maak je thuis een zonnestelselmodel voor een schoolproject  Hoe leveranciers van alledaagse apparaten u kwetsbaar maken voor cyberaanvallen - en wat u eraan kunt doen

Hoe leveranciers van alledaagse apparaten u kwetsbaar maken voor cyberaanvallen - en wat u eraan kunt doen Gespot:vroege planetaire formatie rond een dubbelstersysteem

Gespot:vroege planetaire formatie rond een dubbelstersysteem  Grafeencoating die van kleur verandert bij vervorming of barsten

Grafeencoating die van kleur verandert bij vervorming of barsten

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | Italian |

-

Wetenschap © https://nl.scienceaq.com