Wetenschap

Het detecteren van deepfakes door goed te kijken, onthult een manier om zich ertegen te beschermen

Wanneer een computer het gezicht van Nicolas Cage op het hoofd van Elon Musk legt, het is mogelijk dat het gezicht en het hoofd niet correct worden uitgelijnd. Krediet:Siwei Lyu, CC BY-ND

Deepfake-video's zijn moeilijk te detecteren voor ongetrainde ogen omdat ze behoorlijk realistisch kunnen zijn. Of het nu wordt gebruikt als persoonlijke wraakwapens, om financiële markten te manipuleren of internationale betrekkingen te destabiliseren, video's waarin mensen worden afgebeeld die dingen doen en zeggen die ze nooit hebben gedaan of gezegd, vormen een fundamentele bedreiging voor het al lang bestaande idee dat 'zien is geloven'. Niet meer.

De meeste deepfakes worden gemaakt door een computeralgoritme veel afbeeldingen van een persoon te laten zien, en het vervolgens laten gebruiken wat het zag om nieuwe gezichtsafbeeldingen te genereren. Tegelijkertijd, hun stem is gesynthetiseerd, dus het ziet er zowel uit als klinkt alsof de persoon iets nieuws heeft gezegd.

Dankzij een deel van het eerdere werk van mijn onderzoeksgroep konden we deepfake-video's detecteren die niet de normale hoeveelheid oogknipperingen van een persoon bevatten, maar de nieuwste generatie deepfakes is aangepast, dus ons onderzoek is doorgegaan met vooruitgang.

Nutsvoorzieningen, ons onderzoek kan de manipulatie van een video identificeren door goed naar de pixels van specifieke frames te kijken. Een stap verder gaan, we hebben ook een actieve maatregel ontwikkeld om individuen te beschermen tegen het slachtoffer worden van deepfakes.

Fouten vinden

In twee recente onderzoekspapers, we hebben manieren beschreven om deepfakes te detecteren met fouten die niet gemakkelijk door de fakers kunnen worden verholpen.

Wanneer een deepfake-algoritme voor videosynthese nieuwe gezichtsuitdrukkingen genereert, de nieuwe afbeeldingen komen niet altijd overeen met de exacte positionering van het hoofd van de persoon, of de lichtomstandigheden, of de afstand tot de camera. Om de nepgezichten op te laten gaan in de omgeving, ze moeten geometrisch worden getransformeerd - gedraaid, verkleind of anderszins vervormd. Dit proces laat digitale artefacten achter in het resulterende beeld.

Je hebt misschien enkele artefacten opgemerkt van bijzonder ernstige transformaties. Deze kunnen ervoor zorgen dat een foto er duidelijk gemanipuleerd uitziet, zoals wazige randen en een kunstmatig gladde huid. Meer subtiele transformaties laten nog steeds bewijs achter, en we hebben een algoritme geleerd om het te detecteren, zelfs als mensen de verschillen niet kunnen zien.

Deze artefacten kunnen veranderen als een deepfake-video een persoon heeft die niet rechtstreeks in de camera kijkt. Video die een echt persoon vastlegt, laat zien dat hun gezicht in drie dimensies beweegt, maar deepfake-algoritmen zijn nog niet in staat om gezichten in 3D te fabriceren. In plaats daarvan, ze genereren een regelmatig tweedimensionaal beeld van het gezicht en proberen dan te roteren, verklein en vervorm die afbeelding zodat deze past in de richting waarin de persoon moet kijken.

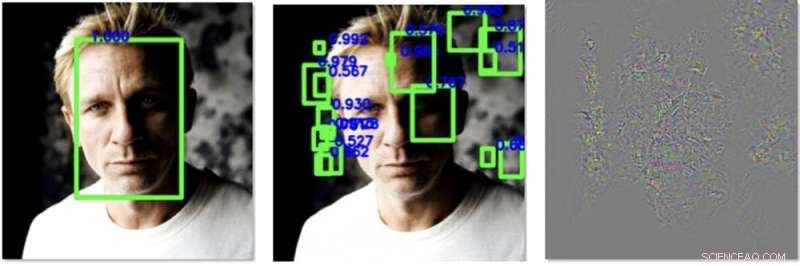

Links, een gezicht wordt gemakkelijk gedetecteerd in een afbeelding vóór onze verwerking. Middenin, we hebben verstoringen toegevoegd die ervoor zorgen dat een algoritme andere gezichten detecteert, maar niet de echte. Rechts staan de wijzigingen die we aan de afbeelding hebben toegevoegd, 30 keer verbeterd om zichtbaar te zijn. Krediet:Siwei Lyu, CC BY-ND

Dat doen ze nog niet zo goed, wat een detectiemogelijkheid biedt. We ontwierpen een algoritme dat berekent naar welke kant de neus van de persoon wijst in een afbeelding. Het meet ook in welke richting het hoofd wijst, berekend met behulp van de contour van het gezicht. In een echte video van het hoofd van een echte persoon, die moeten allemaal vrij voorspelbaar in de rij staan. In deepfakes, Hoewel, ze zijn vaak verkeerd uitgelijnd.

Verdedigen tegen deepfakes

De wetenschap van het detecteren van deepfakes is, effectief, een wapenwedloop - fakers zullen beter worden in het maken van hun ficties, en dus moet ons onderzoek altijd proberen bij te blijven, en zelfs een beetje vooruit.

Als er een manier was om de algoritmen die deepfakes maken, te beïnvloeden om slechter te zijn in hun taak, het zou onze methode beter maken in het detecteren van vervalsingen. Mijn fractie heeft onlangs een manier gevonden om dat te doen.

Beeldbibliotheken van gezichten worden samengesteld door algoritmen die duizenden online foto's en video's verwerken en machine learning gebruiken om gezichten te detecteren en te extraheren. Een computer kan naar een klassenfoto kijken en de gezichten van alle leerlingen en de leraar detecteren, en voeg alleen die gezichten toe aan de bibliotheek. Wanneer de resulterende bibliotheek veel gezichtsafbeeldingen van hoge kwaliteit heeft, de resulterende deepfake heeft meer kans om zijn publiek te misleiden.

We hebben een manier gevonden om speciaal ontworpen ruis toe te voegen aan digitale foto's of video's die niet zichtbaar zijn voor menselijke ogen, maar de gezichtsdetectie-algoritmen voor de gek kunnen houden. Het kan de pixelpatronen verbergen die gezichtsdetectoren gebruiken om een gezicht te lokaliseren, en creëert lokvogels die suggereren dat er een gezicht is waar er geen is, zoals in een stuk van de achtergrond of een vierkant van iemands kleding.

Met minder echte gezichten en meer niet-gezichten die de trainingsgegevens vervuilen, een deepfake-algoritme zal slechter zijn in het genereren van een nepgezicht. Dat vertraagt niet alleen het proces van het maken van een deepfake, maar maakt de resulterende deepfake ook gebrekkiger en gemakkelijker te detecteren.

Terwijl we dit algoritme ontwikkelen, we hopen het te kunnen toepassen op alle afbeeldingen die iemand uploadt naar sociale media of een andere online site. Tijdens het uploadproces, misschien, ze zouden kunnen worden gevraagd, "Wilt u de gezichten in deze video of afbeelding beschermen tegen gebruik in deepfakes?" Als de gebruiker ja kiest, dan kan het algoritme de digitale ruis toevoegen, mensen online de gezichten laten zien, maar ze effectief verbergen voor algoritmen die hen proberen na te doen.

Dit artikel is opnieuw gepubliceerd vanuit The Conversation onder een Creative Commons-licentie. Lees het originele artikel.

Xylitol en cellulose nanovezels maken van papierpasta – naar een groene en duurzame samenleving

Xylitol en cellulose nanovezels maken van papierpasta – naar een groene en duurzame samenleving Slakkenlijm onthult aanwijzingen voor het maken van betere medische lijmen

Slakkenlijm onthult aanwijzingen voor het maken van betere medische lijmen Chemici gebruiken elektrochemie om de productie van medicijnen te versterken

Chemici gebruiken elektrochemie om de productie van medicijnen te versterken Onderzoekers ontwikkelen micro-elektro-fluïdische sonde (MeFP) om cellen te isoleren en te modelleren

Onderzoekers ontwikkelen micro-elektro-fluïdische sonde (MeFP) om cellen te isoleren en te modelleren Easy Microbiology Lab Projects

Easy Microbiology Lab Projects

De eeuwenoude menselijke geschiedenis van de Amazone staat in de bomen geschreven

De eeuwenoude menselijke geschiedenis van de Amazone staat in de bomen geschreven 7 Classificaties van Earthworms

7 Classificaties van Earthworms Nieuwe studie voorspelt dat het opwarmende klimaat duizenden naar ER zal drijven voor hitteziekte

Nieuwe studie voorspelt dat het opwarmende klimaat duizenden naar ER zal drijven voor hitteziekte Misdaad in de wijnstokken:Elzas bestrijdt druivendiefstal te paard

Misdaad in de wijnstokken:Elzas bestrijdt druivendiefstal te paard Waarom stoppen bij plastic zakken en rietjes? Het pleidooi voor een wereldwijd verdrag dat de meeste plastics voor eenmalig gebruik verbiedt

Waarom stoppen bij plastic zakken en rietjes? Het pleidooi voor een wereldwijd verdrag dat de meeste plastics voor eenmalig gebruik verbiedt

Hoofdlijnen

- 10 toepassingen voor zuurstof

- Hoe Ninja-deeltjes werken

- Hoe beïnvloedt de structuur van DNA zijn functie?

- Celwand: definitie, structuur en functie (met diagram)

- Morfogenese en de ontwikkeling van levende vormen

- Laat mijn brein me dingen kopen die ik niet nodig heb?

- Wat is interfase, metafase en anafase?

- Hoe MRNA naar TRNA

- Wat gebeurt er wanneer Pepsin zich mengt met voedsel in de maag?

- Ford snijdt meer dan 5 aan, 000 Duitse banen in Europese revisie

- Australische waakhond geeft strenge regels om de macht van Google te beteugelen, Facebook

- Advance verhoogt de efficiëntie van flash-opslag in datacenters

- Hitachi koopt meerderheidsbelang in ABB's elektriciteitsnetwerk voor $ 6,4 miljard

- Nepnieuws is niet alleen slecht nieuws - het is slecht voor de winst, te

Hoe kwantumtechnologie een revolutie teweeg kan brengen in de detectie en behandeling van ziekten

Hoe kwantumtechnologie een revolutie teweeg kan brengen in de detectie en behandeling van ziekten Robotachtige drijvers geven een nieuwe kijk op de gezondheid van de oceaan en de wereldwijde koolstofcyclus

Robotachtige drijvers geven een nieuwe kijk op de gezondheid van de oceaan en de wereldwijde koolstofcyclus TESS-missie om nieuwe planeten te ontdekken gaat richting lancering

TESS-missie om nieuwe planeten te ontdekken gaat richting lancering Sms-belasting in Californië:wat we weten over het voorstel

Sms-belasting in Californië:wat we weten over het voorstel Japanse SoftBank investeert in WeWork voor het delen van kantoorruimte in de VS

Japanse SoftBank investeert in WeWork voor het delen van kantoorruimte in de VS Fransman geniet van triomfantelijke oversteek van Atlantische oceaan

Fransman geniet van triomfantelijke oversteek van Atlantische oceaan Wetenschappers gebruiken radiografie om de evolutie van vloeibare en vaste microjets te begrijpen

Wetenschappers gebruiken radiografie om de evolutie van vloeibare en vaste microjets te begrijpen Onderzoeker gebruikt grafeen-quilts om dingen koel te houden

Onderzoeker gebruikt grafeen-quilts om dingen koel te houden

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com