Wetenschap

Het stimuleren van rekenkracht voor de toekomst van de deeltjesfysica

Kunstmatige intelligentie gekoppeld aan de Large Hadron Collider kan leiden tot hogere precisie bij gegevensanalyse, die de metingen van fundamentele fysica-eigenschappen kunnen verbeteren en mogelijk tot nieuwe ontdekkingen kunnen leiden. Krediet:FermiLab

Een nieuwe machine learning-technologie die is getest door een internationaal team van wetenschappers, waaronder MIT-assistent-professor Philip Harris en postdoc Dylan Rankin, beide van het Laboratorium voor Nucleaire Wetenschappen, kan in een oogwenk specifieke deeltjessignaturen herkennen in een oceaan van Large Hadron Collider (LHC) -gegevens.

Verfijnd en snel, het nieuwe systeem biedt een kijkje in de baanbrekende rol die machine learning zal spelen bij toekomstige ontdekkingen in de deeltjesfysica naarmate datasets groter en complexer worden.

De LHC veroorzaakt elke seconde zo'n 40 miljoen botsingen. Met zulke enorme hoeveelheden gegevens om door te spitten, er zijn krachtige computers nodig om die botsingen te identificeren die van belang kunnen zijn voor wetenschappers, of, misschien, een vleugje donkere materie of een Higgs-deeltje.

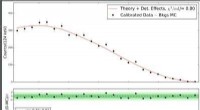

Nutsvoorzieningen, wetenschappers van Fermilab, CERN, MIT, de Universiteit van Washington, en elders hebben ze een machine-learningsysteem getest dat de verwerking 30 tot 175 keer versnelt in vergelijking met bestaande methoden.

Dergelijke methoden verwerken momenteel minder dan één afbeelding per seconde. In tegenstelling tot, het nieuwe machine-learningsysteem kan tot 600 beelden per seconde beoordelen. Tijdens zijn stageperiode het systeem leerde een specifiek type postcollision-deeltjespatroon te onderscheiden.

"De botsingspatronen die we identificeren, top-quarks, zijn een van de fundamentele deeltjes die we onderzoeken bij de Large Hadron Collider, " zegt Harrie, die lid is van het MIT Department of Physics. "Het is erg belangrijk dat we zoveel mogelijk gegevens analyseren. Elk stukje gegevens bevat interessante informatie over hoe deeltjes op elkaar inwerken."

Die gegevens zullen als nooit tevoren binnenstromen nadat de huidige LHC-upgrades zijn voltooid; tegen 2026, de 17-mijls deeltjesversneller zal naar verwachting 20 keer zoveel data produceren als nu. Om de zaak nog dringender te maken, toekomstige beelden zullen ook met hogere resoluties worden genomen dan nu het geval is. In alles, wetenschappers en ingenieurs schatten dat de LHC meer dan 10 keer de rekenkracht nodig heeft die hij momenteel heeft.

"De uitdaging van toekomstig hardlopen, " zegt Harrie, "wordt steeds moeilijker naarmate onze berekeningen nauwkeuriger worden en we steeds nauwkeuriger effecten onderzoeken."

Onderzoekers van het project hebben hun nieuwe systeem getraind om afbeeldingen van top-quarks te identificeren, het meest massieve type elementair deeltje, zo'n 180 keer zwaarder dan een proton. "Met de machine learning-architecturen die voor ons beschikbaar zijn, we in staat zijn om hoogwaardige resultaten van wetenschappelijke kwaliteit te krijgen, vergelijkbaar met de beste top-quark-identificatie-algoritmen ter wereld, Harris legt uit. "De implementatie van kernalgoritmen op hoge snelheid geeft ons de flexibiliteit om LHC-computing te verbeteren op de kritieke momenten waar dat het meest nodig is."

Dit verhaal is opnieuw gepubliceerd met dank aan MIT News (web.mit.edu/newsoffice/), een populaire site met nieuws over MIT-onderzoek, innovatie en onderwijs.

Grootschalig en duurzaam 3D-printen met het meest alomtegenwoordige natuurlijke materiaal

Grootschalig en duurzaam 3D-printen met het meest alomtegenwoordige natuurlijke materiaal Varkensvlees in wezen vrij van residuen van diergeneesmiddelen

Varkensvlees in wezen vrij van residuen van diergeneesmiddelen Gebruik van PVC Plastic

Gebruik van PVC Plastic Computerwetenschappers en materiaalonderzoekers werken samen om staalclassificatie te optimaliseren

Computerwetenschappers en materiaalonderzoekers werken samen om staalclassificatie te optimaliseren Hoe hard water te maken

Hoe hard water te maken

De stam die een beschadigde kustlijn weer tot leven bracht

De stam die een beschadigde kustlijn weer tot leven bracht Stijgende zeespiegel kan de wereld tegen 2100 $ 14 biljoen per jaar kosten

Stijgende zeespiegel kan de wereld tegen 2100 $ 14 biljoen per jaar kosten Hoe de VS hun belofte van Parijs zouden kunnen nakomen zonder het Witte Huis?

Hoe de VS hun belofte van Parijs zouden kunnen nakomen zonder het Witte Huis? Ethanol stimuleert grootschalige uitbreiding van Braziliaanse landbouwgrond

Ethanol stimuleert grootschalige uitbreiding van Braziliaanse landbouwgrond Krachtige storm laat 2 doden achter, zware gewasschade in Midwest

Krachtige storm laat 2 doden achter, zware gewasschade in Midwest

Hoofdlijnen

- Waarom sommige mensen flauwvallen als ze bloed zien

- Waar bestaat het cytoplasma uit?

- Sumatraanse neushoorns zijn nooit hersteld van verliezen tijdens het Pleistoceen, genoom bewijs toont

- Warmteminnende Australische mieren geloven in diversiteit, hint 74 soorten nieuw voor de wetenschap

- Wat zijn de vijf klassen van immunoglobulines?

- De natuur laat zien hoe bacteriën lignine afbreken en geeft beter inzicht om biobrandstoffen te maken

- UV-licht: positieve en negatieve effecten

- Trofisch niveau (voedselketen en web): definitie en voorbeelden (met diagram)

- Griezelige bescherming:bedreigde diersoorten redden boven onze dode lichamen

- Hogedruksleutel tot aansteker, sterkere metaallegeringen, wetenschappers vinden

- Lichtturbulentie gebruiken om frequentiekammen te genereren uit kleine ringlasers

- Wolfraam ontwikkelt lagen onder extreme hitte van fusiereactoren

- Een stap voorwaarts in het oplossen van het reactor-neutrinofluxprobleem

- Een model grot maken voor kinderen

Het modelleren van oude Antarctische ijskappen helpt ons de toekomst van de opwarming van de aarde te zien

Het modelleren van oude Antarctische ijskappen helpt ons de toekomst van de opwarming van de aarde te zien Smeltproces van ijsblokjes

Smeltproces van ijsblokjes Eerste Spacebus Neo-satelliet gelanceerd

Eerste Spacebus Neo-satelliet gelanceerd Het New Horizons-team stelt de beste afbeeldingen samen die ze hebben van Plutos verre kant

Het New Horizons-team stelt de beste afbeeldingen samen die ze hebben van Plutos verre kant Om volledig meeslepend te zijn, bronnen van haptische stimulatie in VR-apps moeten worden getoond, onderzoekers vinden

Om volledig meeslepend te zijn, bronnen van haptische stimulatie in VR-apps moeten worden getoond, onderzoekers vinden Nu zie je warmte, nu jij niet

Nu zie je warmte, nu jij niet Onderzoekers lossen magnetische structuren van verschillende topologische semimetalen op

Onderzoekers lossen magnetische structuren van verschillende topologische semimetalen op Dit enzym stelde het leven in staat een vijandige aarde te veroveren

Dit enzym stelde het leven in staat een vijandige aarde te veroveren

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Portuguese | Swedish | German | Dutch | Danish | Norway | Spanish |

-

Wetenschap © https://nl.scienceaq.com