Wetenschap

Een nieuw verklaarbaar AI-paradigma dat de samenwerking tussen mens en robot kan verbeteren

In het scout-verkenningsspel leert de robot, om af te stemmen op menselijke waarden, van menselijke feedback op de voorstellen. Afbeelding tegoed:mevrouw Zhen Chen@BIGAI.

Methoden voor kunstmatige intelligentie (AI) zijn de afgelopen decennia steeds geavanceerder geworden en hebben opmerkelijke resultaten behaald bij veel taken in de echte wereld. Desalniettemin delen de meeste bestaande AI-systemen hun analyses en de stappen die tot hun voorspellingen hebben geleid niet met menselijke gebruikers, wat een betrouwbare evaluatie ervan uiterst uitdagend kan maken.

Een groep onderzoekers van UCLA, UCSD, Peking University en Beijing Institute for General Artificial Intelligence (BIGAI) heeft onlangs een nieuw AI-systeem ontwikkeld dat de besluitvormingsprocessen aan menselijke gebruikers kan uitleggen. Dit systeem, geïntroduceerd in een paper gepubliceerd in Science Robotics , zou een nieuwe stap kunnen zijn in de richting van het creëren van meer betrouwbare en begrijpelijke AI.

"Het gebied van verklaarbare AI (XAI) heeft tot doel een samenwerkingsvertrouwen tussen robots en mensen op te bouwen, en het DARPA XAI-project diende als een geweldige katalysator voor het bevorderen van onderzoek op dit gebied," Dr. Luyao Yuan, een van de eerste auteurs van het artikel , vertelde TechXplore. "Aan het begin van het DARPA XAI-project richten onderzoeksteams zich voornamelijk op het inspecteren van modellen voor classificatietaken door het besluitvormingsproces van AI-systemen aan de gebruiker te onthullen; sommige modellen kunnen bijvoorbeeld bepaalde lagen van CNN-modellen visualiseren en beweren een bepaalde niveau van XAI."

Dr. Yuan en zijn collega's namen deel aan het DARPA XAI-project, dat specifiek gericht was op het ontwikkelen van nieuwe en veelbelovende XAI-systemen. Tijdens hun deelname aan het project begonnen ze na te denken over wat XAI in bredere zin zou betekenen, met name over de effecten die het zou kunnen hebben op samenwerkingen tussen mens en machine.

De recente paper van het team bouwt voort op een van hun eerdere werken, ook gepubliceerd in Science Robotics , waar het team de impact onderzocht die verklaarbare systemen kunnen hebben op de perceptie van een gebruiker en het vertrouwen in AI tijdens mens-machine-interacties. In hun eerdere onderzoek implementeerde en testte het team een AI-systeem fysiek (d.w.z. in de echte wereld), terwijl ze het in hun nieuwe onderzoek in simulaties testten.

"Ons paradigma staat in contrast met bijna al het paradigma dat is voorgesteld door teams in het DARPA XAI-programma, dat zich voornamelijk richtte op wat wij het passieve machine-actieve gebruikersparadigma noemen", vertelde prof. Yixin Zhu, een van de supervisors van het project, aan TechXplore. "In deze paradigma's moeten menselijke gebruikers actief controleren en proberen te achterhalen wat de machine doet (dus 'actieve gebruiker') door gebruik te maken van enkele modellen die het potentiële besluitvormingsproces van de AI-modellen onthullen."

XAI-systemen die volgen wat prof. Zhu het paradigma van de "passieve machine-actieve gebruiker" noemt, vereisen dat gebruikers constant inchecken bij de AI om de processen achter zijn beslissingen te begrijpen. In deze context heeft het begrip van een gebruiker van de processen van een AI en het vertrouwen in zijn voorspellingen geen invloed op de toekomstige besluitvormingsprocessen van de AI, daarom wordt de machine 'passief' genoemd.

Het nieuwe paradigma, geïntroduceerd door Dr. Yuan, Prof. Zhu en hun collega's, volgt daarentegen wat het team een actief machine-actief gebruikersparadigma noemt. Dit betekent in wezen dat hun systeem actief kan leren en zijn besluitvorming kan aanpassen op basis van de feedback die het on-the-fly van gebruikers ontvangt. Dit vermogen om zich contextueel aan te passen is kenmerkend voor wat vaak de derde/volgende golf van AI wordt genoemd.

"Om AI-systemen hun gebruikers te laten helpen zoals we van hen verwachten, vereisen de huidige systemen dat de gebruiker codeert in door experts gedefinieerde doelstellingen", zei Dr. Yuan. "Dit beperkt het potentieel van mens-machine-teaming, aangezien dergelijke doelstellingen bij veel taken moeilijk te definiëren zijn, waardoor AI-systemen voor de meeste mensen ontoegankelijk zijn. Om dit probleem aan te pakken, stelt ons werk robots in staat om de bedoelingen en waarden van gebruikers tijdens de samenwerking in te schatten in realtime, waardoor het niet nodig is om vooraf ingewikkelde en specifieke doelstellingen voor de robots te coderen, waardoor een beter mens-machine-teamingparadigma wordt geboden."

Het doel van het systeem dat door Dr. Yuan en zijn collega's is gecreëerd, is het bereiken van zogenaamde 'waarde-afstemming'. Dit betekent in wezen dat een menselijke gebruiker kan begrijpen waarom een robot of machine op een specifieke manier handelt of tot specifieke conclusies komt, en de machine of robot kan afleiden waarom de menselijke gebruiker op specifieke manieren handelt. Dit kan de communicatie tussen mens en robot aanzienlijk verbeteren.

"Deze bidirectionele aard en realtime prestaties zijn de grootste uitdagingen van het probleem en het hoogtepunt van onze bijdragen", zei prof. Zhu. "Als we de bovenstaande punten samenvoegen, denk ik dat u nu begrijpt waarom de titel van ons artikel "In situ bidirectionele mens-robotwaarde-uitlijning" is.

Om hun XAI-systeem te trainen en te testen, ontwierpen de onderzoekers een spel genaamd 'verkenningsverkenning', waarin mensen een taak in teams moeten voltooien. Een van de belangrijkste aspecten van dit spel is dat mensen en robots hun zogenaamde 'waardefuncties' op elkaar moeten afstemmen.

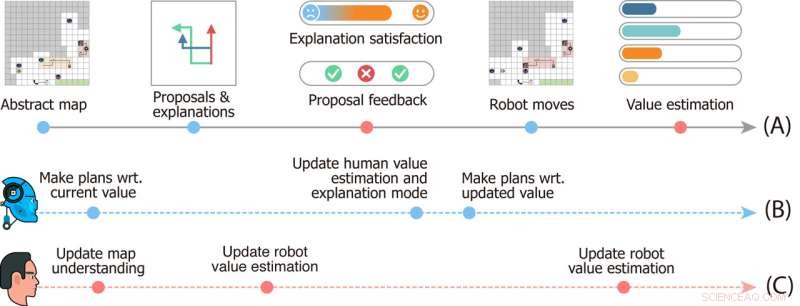

Studie ontwerp van de Scout Exploration Game. Tijdlijn (A) geeft gebeurtenissen aan die plaatsvinden in een enkele spelronde. Tijdlijnen (B) en (C) geven de mentale dynamiek van respectievelijk de robots en de gebruiker weer. Afbeelding tegoed:mevrouw Zhen Chen@BIGAI.

"In het spel kan een groep robots de omgeving waarnemen; dit emuleert real-world toepassingen waarbij de groep robots autonoom zou moeten werken om menselijke tussenkomsten te minimaliseren", zei prof. Zhu. "De menselijke gebruiker kan echter niet rechtstreeks communiceren met de omgeving; in plaats daarvan kreeg de gebruiker een bepaalde waardefunctie, weergegeven door het belang van een paar factoren (bijvoorbeeld de totale tijd om de tijd te voltooien en middelen die onderweg werden verzameld). )."

In het verkenningsspel heeft het team van robots geen toegang tot de waardefunctie die aan menselijke gebruikers wordt gegeven, en ze moeten deze afleiden. Omdat deze waarde niet gemakkelijk kan worden uitgedrukt en gecommuniceerd, moeten de robot en het menselijke team deze van elkaar afleiden om de taak te voltooien.

"De communicatie is bidirectioneel in het spel:aan de ene kant stelt de robot meerdere taakplannen voor aan de gebruiker en legt hij de voor- en nadelen voor elk van hen uit, en aan de andere kant geeft de gebruiker feedback op de voorstellen en beoordeelt elke uitleg, "Dr. Xiaofeng Gao, een van de eerste auteurs van het artikel, vertelde TechXplore. "Deze bidirectionele communicatie maakt wat bekend staat als waardeafstemming mogelijk."

In wezen moet het team van robots, om taken in 'verkenningsverkenning' te voltooien, begrijpen wat de waardefunctie van de menselijke gebruiker is, simpelweg gebaseerd op de feedback van de mens. Ondertussen leren menselijke gebruikers de huidige waardeschattingen van de robots en kunnen ze feedback geven die hen helpt te verbeteren en hen uiteindelijk naar de juiste reactie leidt.

"We hebben ook theory of mind in ons rekenmodel geïntegreerd, waardoor het AI-systeem de juiste verklaringen kan genereren om de huidige waarde ervan te onthullen en de waarde van gebruikers in realtime te schatten op basis van hun feedback tijdens de interactie," zei Dr. Gao. "Vervolgens hebben we uitgebreide gebruikersonderzoeken uitgevoerd om ons raamwerk te evalueren."

In de eerste evaluaties heeft het systeem dat is ontwikkeld door Dr. Yuan, Prof. Zhu, Dr. Gao en hun collega's opmerkelijke resultaten behaald, wat heeft geleid tot het direct en op een interactieve manier afstemmen van waarden in het verkenningsverkenningsspel. Het team ontdekte dat de robot al voor 25% in het spel in lijn was met de waardefunctie van de menselijke gebruiker, terwijl gebruikers ongeveer halverwege het spel een nauwkeurig beeld konden krijgen van de waardefuncties van de machine.

"De combinatie van convergentie (i) van de waarde van de robots naar de werkelijke waarden van de gebruiker en (ii) van de schatting van de gebruiker van de waarden van de robots naar de huidige waarden van de robots, vormt een bidirectionele waarde-uitlijning verankerd door de werkelijke waarde van de gebruiker," Dr. zei Yuan. "Wij zijn van mening dat ons raamwerk de noodzaak benadrukt van het bouwen van intelligente machines die onze bedoelingen en waarden leren en begrijpen door middel van interacties, die van cruciaal belang zijn om veel van de dystopische sciencefictionverhalen te vermijden die in romans en op het grote scherm worden weergegeven."

Het recente werk van dit team van onderzoekers is een belangrijke bijdrage aan het onderzoeksgebied dat zich richt op de ontwikkeling van begrijpelijker AI. Het door hen voorgestelde systeem zou als inspiratie kunnen dienen voor de creatie van andere XAI-systemen waar robots of slimme assistenten actief met mensen omgaan, hun processen delen en hun prestaties verbeteren op basis van de feedback die ze van gebruikers ontvangen.

"Waardeafstemming is onze eerste stap in de richting van generieke samenwerking tussen mens en robot", legt Dr. Yuan uit. "In dit werk vindt waardeafstemming plaats in de context van een enkele taak. In veel gevallen werkt een groep agenten echter samen aan veel taken. We verwachten bijvoorbeeld dat één huishoudrobot ons helpt met veel dagelijkse klusjes, in plaats van te kopen veel robots, die elk maar één soort werk kunnen doen."

Tot nu toe heeft het XAI-systeem van de onderzoekers veelbelovende resultaten bereikt. In hun volgende studies zijn Dr. Yuan, Prof. Zhu, Dr. Gao en hun collega's van plan om gevallen van afstemming van de waarde van mens en robot te onderzoeken die kunnen worden toegepast op veel verschillende taken in de echte wereld, zodat menselijke gebruikers en AI-agenten zich kunnen ophopen informatie die ze hebben verkregen over elkaars processen en capaciteiten terwijl ze samenwerken aan verschillende taken.

"In onze volgende onderzoeken proberen we ons raamwerk ook toe te passen op meer taken en fysieke robots", zei Dr. Gao. "Naast waarden, geloven we dat het afstemmen van andere aspecten van mentale modellen (bijvoorbeeld overtuigingen, verlangens, intenties) tussen mensen en robots ook een veelbelovende richting zou zijn."

De onderzoekers hopen dat hun nieuwe verklaarbare AI-paradigma zal helpen om de samenwerking tussen mens en machine bij tal van taken te verbeteren. Bovendien hopen ze dat hun aanpak het vertrouwen van mensen in op AI gebaseerde systemen zal vergroten, inclusief slimme assistenten, robots, bots en andere virtuele agenten.

"Je kunt bijvoorbeeld Alexa of Google Home corrigeren wanneer het een fout maakt, maar het zal dezelfde fout maken de volgende keer dat je het gebruikt", voegde prof. Zhu eraan toe. "Als je Roomba ergens heen gaat waar je niet wilt dat hij gaat en probeert te vechten, begrijpt hij het niet omdat het alleen de vooraf gedefinieerde AI-logica volgt. Al deze verbieden moderne AI om onze huizen binnen te gaan. Als eerste stap toont ons werk het potentieel van het oplossen van deze problemen, een stap dichter bij het bereiken van wat DARPA 'contextuele aanpassing' noemde in de derde golf van AI." + Verder verkennen

Sociale robots toestaan relaties te leren tussen de routines van gebruikers en hun humeur

© 2022 Science X Network

Belangrijkste bewijsmateriaal dat hydrofobiciteit associeert met effectieve zuurkatalyse

Belangrijkste bewijsmateriaal dat hydrofobiciteit associeert met effectieve zuurkatalyse Beknopte synthese van pleurotine ontwikkeld

Beknopte synthese van pleurotine ontwikkeld Gemanipuleerde microben kunnen biologisch afbreekbare kunststoffen produceren tegen lagere kosten en milieu-impact dan plantaardige kunststoffen

Gemanipuleerde microben kunnen biologisch afbreekbare kunststoffen produceren tegen lagere kosten en milieu-impact dan plantaardige kunststoffen Kleine hoeveelheden virus detecteren bij vroege infecties

Kleine hoeveelheden virus detecteren bij vroege infecties Groeven houden belofte in voor verfijnde genezing

Groeven houden belofte in voor verfijnde genezing

Studie van het oude klimaat suggereert dat de toekomstige opwarming zou kunnen versnellen

Studie van het oude klimaat suggereert dat de toekomstige opwarming zou kunnen versnellen Brown Snakes in Mississippi

Brown Snakes in Mississippi  Vlekkeloze dekking:klimaatmodellen onderschatten het verkoelende effect van de dagelijkse bewolking

Vlekkeloze dekking:klimaatmodellen onderschatten het verkoelende effect van de dagelijkse bewolking Hoe muziek luisteren het klimaat beïnvloedt

Hoe muziek luisteren het klimaat beïnvloedt Onderzoekers bouwen veerkracht op te midden van het kolkende water

Onderzoekers bouwen veerkracht op te midden van het kolkende water

Hoofdlijnen

- Onderzoekers fabriceren geminiaturiseerde bionische oceaanbatterij

- Twee neuropeptiden in zebravissen geven aanwijzingen voor de complexe neurale mechanismen die ten grondslag liggen aan slaap

- Vergeet uw huisdieren niet tijdens koud weer

- Hoe bacteriën worden gereproduceerd?

- Hoe verschilt Cytokinese bij planten en dieren?

- De kracht van saffraankleur benutten voor voedsel en toekomstige therapieën

- Definieer Contrast in microscopen

- Planten kunnen zichzelf verdedigen door rupsen kannibaal te maken

- Kipferl:begeleiding van de verdediging tegen springgenen

- Sprint lanceert mobiel 5G-netwerk in Atlanta, Dallas-Fort Worth, Houston en Kansas City

- Elektrisch vervoer in Trikala, Griekenland

- Gradiënt Li-rijke oxide kathodedeeltjes voor batterijen met minimale zuurstofafgifte

- Facebook besteedt $ 1 miljard aan betaalbare woningen in de VS

- Coronavirus-crisis verspreidt zich:Google vertelt Noord-Amerikaanse werknemers om vanuit huis te werken

Vergeet de blingbling:hoge statussignalering schrikt nieuwe vriendschappen af

Vergeet de blingbling:hoge statussignalering schrikt nieuwe vriendschappen af Gigantische uitgestorven gravende vleermuis ontdekt in Nieuw-Zeeland

Gigantische uitgestorven gravende vleermuis ontdekt in Nieuw-Zeeland Wat is deliberatieve democratie? Onderzoek in Nepal toont aan dat het de stemming van jongeren wereldwijd kan stimuleren

Wat is deliberatieve democratie? Onderzoek in Nepal toont aan dat het de stemming van jongeren wereldwijd kan stimuleren  Zwarte stikstof:onderzoekers ontdekken nieuw hogedrukmateriaal en lossen een puzzel van het periodiek systeem op

Zwarte stikstof:onderzoekers ontdekken nieuw hogedrukmateriaal en lossen een puzzel van het periodiek systeem op De vorm van water:hoe watermoleculen eruit zien op het oppervlak van materialen

De vorm van water:hoe watermoleculen eruit zien op het oppervlak van materialen Verstrooiing van adiabatisch uitgelijnde moleculen door niet-resonante optische staande golven

Verstrooiing van adiabatisch uitgelijnde moleculen door niet-resonante optische staande golven Reconstructie van Arctische Barentsz-Kara-zee-ijsveranderingen in het afgelopen millennium

Reconstructie van Arctische Barentsz-Kara-zee-ijsveranderingen in het afgelopen millennium Het apothem van een polygoon berekenen

Het apothem van een polygoon berekenen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com