Wetenschap

Onderzoekers ontwikkelen een AI-model voor autonoom rijden

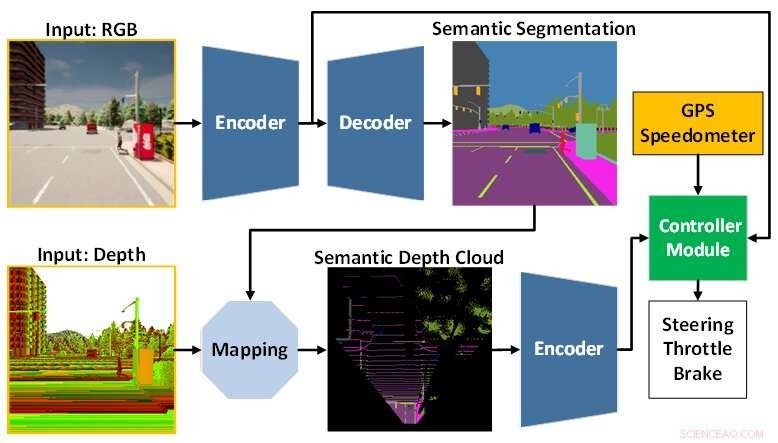

De AI-modelarchitectuur is samengesteld uit de perceptiemodule (blauw) en de controllermodule (groen). De waarnemingsmodule is verantwoordelijk voor het waarnemen van de omgeving op basis van de waarnemingsgegevens van een RGBD-camera. Ondertussen is de controllermodule verantwoordelijk voor het decoderen van de geëxtraheerde informatie om de mate van sturen, gasgeven en remmen te schatten. Krediet:Toyohashi University of Technology

Een onderzoeksteam bestaande uit Oskar Natan, een Ph.D. student, en zijn supervisor, professor Jun Miura, die verbonden zijn aan het Active Intelligent System Laboratory (AISL), Department of Computer Science Engineering, Toyohashi University of Technology, hebben een AI-model ontwikkeld dat waarneming en controle tegelijkertijd kan verwerken voor autonoom rijden voertuig.

Het AI-model neemt de omgeving waar door verschillende zichttaken uit te voeren terwijl het voertuig een reeks routepunten volgt. Bovendien kan het AI-model het voertuig onder verschillende scenario's veilig besturen in verschillende omgevingsomstandigheden. Geëvalueerd onder punt-naar-punt navigatietaken, bereikt het AI-model de beste rijeigenschappen van bepaalde recente modellen in een standaard simulatieomgeving.

Autonoom rijden is een complex systeem dat bestaat uit verschillende subsystemen die meerdere waarnemings- en controletaken afhandelen. Het implementeren van meerdere taakspecifieke modules is echter kostbaar en inefficiënt, aangezien er nog steeds talloze configuraties nodig zijn om een geïntegreerd modulair systeem te vormen.

Bovendien kan het integratieproces leiden tot informatieverlies omdat veel parameters handmatig worden aangepast. Met snel deep learning-onderzoek kan dit probleem worden aangepakt door een enkel AI-model te trainen met end-to-end en multi-task-manieren. Het model kan dus navigatiecontroles bieden die uitsluitend zijn gebaseerd op de waarnemingen van een reeks sensoren. Omdat handmatige configuratie niet langer nodig is, kan het model de informatie helemaal zelf beheren.

De uitdaging die overblijft voor een end-to-end model is hoe nuttige informatie eruit te halen, zodat de controller de navigatiebesturingen goed kan inschatten. Dit kan worden opgelost door veel gegevens aan de waarnemingsmodule te verstrekken om de omgeving beter waar te nemen. Bovendien kan een sensorfusietechniek worden gebruikt om de prestaties te verbeteren, omdat verschillende sensoren worden samengevoegd om verschillende gegevensaspecten vast te leggen.

Een enorme rekenbelasting is echter onvermijdelijk omdat er een groter model nodig is om meer gegevens te verwerken. Bovendien is een techniek voor het voorbewerken van gegevens noodzakelijk, aangezien verschillende sensoren vaak met verschillende gegevensmodaliteiten komen. Bovendien kan onevenwichtig leren tijdens het trainingsproces een ander probleem zijn, aangezien het model zowel waarnemings- als controletaken tegelijkertijd uitvoert.

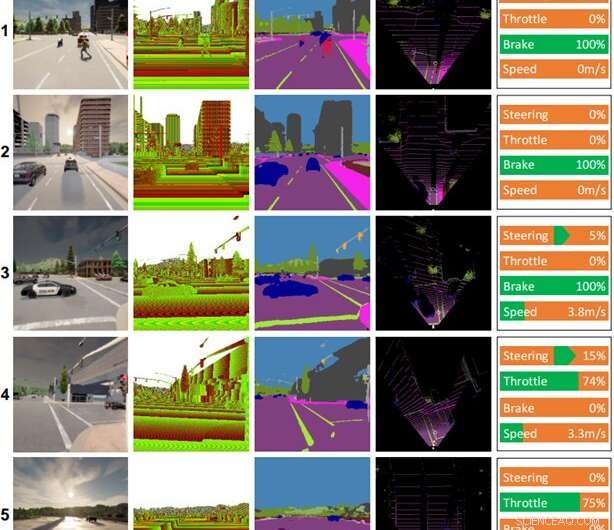

Enkele rijrecords gemaakt door het AI-model. Kolommen (van links naar rechts):kleurenbeeld, dieptebeeld, semantisch segmentatieresultaat, vogelvluchtkaart (BEV), besturingsopdracht. Het weer en de tijd voor elke scène zijn als volgt:(1) heldere middag, (2) bewolkte zonsondergang, (3) halverwege de regenachtige middag, (4) harde regenzonsondergang, (5) natte zonsondergang. Krediet:Toyohashi University of Technology

Om deze uitdagingen aan te gaan, stelt het team een AI-model voor dat is getraind met end-to-end en multi-task-manieren. Het model is opgebouwd uit twee hoofdmodules, namelijk perceptie- en controllermodules. De waarnemingsfase begint met het verwerken van RGB-afbeeldingen en dieptekaarten die worden geleverd door een enkele RGBD-camera.

Vervolgens wordt de informatie die wordt geëxtraheerd uit de waarnemingsmodule samen met de meting van de voertuigsnelheid en de coördinaten van het routepunt gedecodeerd door de besturingsmodule om de navigatiebedieningen te schatten. Om ervoor te zorgen dat alle taken gelijk kunnen worden uitgevoerd, gebruikt het team een algoritme dat gemodificeerde gradiëntnormalisatie (MGN) wordt genoemd om het leersignaal tijdens het trainingsproces in evenwicht te brengen.

Het team beschouwt imitatieleren omdat het het model in staat stelt te leren van een grootschalige dataset om te voldoen aan een bijna menselijke standaard. Bovendien heeft het team het model zo ontworpen dat het een kleiner aantal parameters gebruikt dan andere om de rekenbelasting te verminderen en de inferentie op een apparaat met beperkte middelen te versnellen.

Op basis van het experimentele resultaat in een standaard autonome rijsimulator, CARLA, is gebleken dat het samensmelten van RGB-afbeeldingen en dieptekaarten om een semantische kaart met vogelperspectief (BEV) te vormen, de algehele prestaties kan verbeteren. Omdat de perceptiemodule een beter algemeen begrip van de scène heeft, kan de controllermodule nuttige informatie gebruiken om de navigatiebedieningen correct in te schatten. Verder stelt het team dat het voorgestelde model de voorkeur verdient voor implementatie, omdat het beter bestuurbaar is met minder parameters dan andere modellen.

Het onderzoek is gepubliceerd in IEEE Transactions on Intelligent Vehicles , en het team werkt momenteel aan aanpassingen en verbeteringen aan het model om verschillende problemen aan te pakken bij het rijden in slechte lichtomstandigheden, zoals 's nachts, bij hevige regen, enz. Als hypothese is het team van mening dat het toevoegen van een sensor die wordt niet beïnvloed door veranderingen in helderheid of verlichting, zoals LiDAR, zal de mogelijkheden van het model voor het begrijpen van scènes verbeteren en resulteren in betere rijeigenschappen. Een andere toekomstige taak is om het voorgestelde model toe te passen op autonoom rijden in de echte wereld. + Verder verkennen

Nieuw basismodel verbetert de nauwkeurigheid voor beeldinterpretatie via teledetectie

Nieuwe röntgentechnologie kan een revolutie teweegbrengen in de manier waarop artsen afwijkingen identificeren

Nieuwe röntgentechnologie kan een revolutie teweegbrengen in de manier waarop artsen afwijkingen identificeren Hoe werkt chemische energie?

Hoe werkt chemische energie?  Eenvoudige methode om koolstofdioxide om te zetten in bruikbare verbindingen

Eenvoudige methode om koolstofdioxide om te zetten in bruikbare verbindingen Olie- en waterlagen scheiden

Olie- en waterlagen scheiden  Studie identificeert meest veelbelovende grondstoffen voor op pyrolyse gebaseerde bioraffinage

Studie identificeert meest veelbelovende grondstoffen voor op pyrolyse gebaseerde bioraffinage

Doden van dieren in het wild toegeschreven aan scheepsramp in Sri Lanka

Doden van dieren in het wild toegeschreven aan scheepsramp in Sri Lanka Tropische storm Jongdari meer georganiseerd in NASA's Terra-satellietbeelden

Tropische storm Jongdari meer georganiseerd in NASA's Terra-satellietbeelden Hoe van het land te leven... in een grote Amerikaanse stad

Hoe van het land te leven... in een grote Amerikaanse stad Het is officieel:de afgelopen vijf jaar waren de warmste ooit gemeten

Het is officieel:de afgelopen vijf jaar waren de warmste ooit gemeten Hoe veranderen drones de landbouw?

Hoe veranderen drones de landbouw?

Hoofdlijnen

- Syngenta schikt Amerikaanse boerenrechtszaken in Chinese maïshandelzaak

- Lake Michigan watervogels botulisme sterfgevallen in verband met warm water, algen

- De definitie van moleculaire celbiologie

- Kan de wetenschap verklaren waarom we zoenen met onze ogen dicht?

- Synthetisch muizenembryo met hersenen en kloppend hart gegroeid uit stamcellen

- Chemische stoffen gebruikt in DNA-analyse

- What Is Crossing Over in Genetics?

- Wat betekent Kaukasisch echt?

- Onderzoekers ontdekken moleculaire add-ons die eiwitinterfaces aanpassen

- Onderzoekers ontdekken hoe routers kunnen worden gerekruteerd in botnetleger

- Maak je klaar voor een hobbelige rit:Cybersecurity-trends in 2020

- Technische cadeaus 2019:voor elk wat wils

- Daimler verlaagt winstprognose Amerikaanse en Chinese tarieven de schuld geven

- Uber, Lyft-chauffeurs protesteren in de VS, overzee

Het eerste draadloos vliegende robotinsect stijgt op

Het eerste draadloos vliegende robotinsect stijgt op Stamgestuurde autonome regeling van kationdistributie voor kunstmatige ferro-elektriciteit

Stamgestuurde autonome regeling van kationdistributie voor kunstmatige ferro-elektriciteit Kwaadaardige kanker voor het eerst gediagnosticeerd bij een dinosaurus

Kwaadaardige kanker voor het eerst gediagnosticeerd bij een dinosaurus Wildwild en -duiven voeren

Wildwild en -duiven voeren Hoe beïnvloedt de stikstofdynamiek de koolstof- en waterbudgetten in China?

Hoe beïnvloedt de stikstofdynamiek de koolstof- en waterbudgetten in China? Uber verliest $ 1,1 miljard aan investeringen in voedselbezorging, auto's zonder bestuurder

Uber verliest $ 1,1 miljard aan investeringen in voedselbezorging, auto's zonder bestuurder Neuronen bij ruggenmergletsels worden in vivo opnieuw verbonden via koolstofnanobuissponzen

Neuronen bij ruggenmergletsels worden in vivo opnieuw verbonden via koolstofnanobuissponzen Droomteam om ijsverlies op Groenlandse gletsjer te bestuderen om stijgende oceanen beter te voorspellen

Droomteam om ijsverlies op Groenlandse gletsjer te bestuderen om stijgende oceanen beter te voorspellen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com