Wetenschap

Mensen geven er de voorkeur aan dat robots zichzelf uitleggen - en een korte samenvatting snijdt het niet

Een robot en mens die op elkaar inwerken. Krediet:Tommy Ton, tommy.com, CC BY-ND

Kunstmatige intelligentie komt op veel manieren ons leven binnen:op onze smartphones, in onze huizen, in onze auto's. Deze systemen kunnen mensen helpen bij het maken van afspraken, autorijden en zelfs ziektes diagnosticeren. Maar aangezien AI-systemen een belangrijke en collaboratieve rol blijven spelen in het leven van mensen, een natuurlijke vraag is:kan ik ze vertrouwen? Hoe weet ik dat ze zullen doen wat ik verwacht?

Explainable AI (XAI) is een tak van AI-onderzoek die onderzoekt hoe kunstmatige agentia transparanter en betrouwbaarder kunnen worden gemaakt voor hun menselijke gebruikers. Betrouwbaarheid is essentieel als robots en mensen willen samenwerken. XAI streeft ernaar AI-systemen te ontwikkelen die mensen betrouwbaar vinden, terwijl ze ook goed presteren om ontworpen taken uit te voeren.

Bij het Centrum voor Visie, cognitie, Aan het leren, en autonomie aan de UCLA, wij en onze collega's zijn geïnteresseerd in welke factoren machines betrouwbaarder maken, en hoe goed verschillende leeralgoritmen vertrouwen mogelijk maken. Ons laboratorium gebruikt een soort kennisrepresentatie - een model van de wereld dat een AI gebruikt om zijn omgeving te interpreteren en beslissingen te nemen - dat gemakkelijker door mensen kan worden begrepen. Dit helpt natuurlijk bij uitleg en transparantie, waardoor het vertrouwen van menselijke gebruikers wordt verbeterd.

In ons laatste onderzoek, we experimenteerden met verschillende manieren waarop een robot zijn acties kon uitleggen aan een menselijke waarnemer. interessant, de vormen van uitleg die het meeste menselijk vertrouwen wekten, kwamen niet overeen met de leeralgoritmen die de beste taakuitvoering opleverden. Dit suggereert dat prestatie en verklaring niet inherent van elkaar afhankelijk zijn:optimaliseren voor de een alleen leidt mogelijk niet tot het beste resultaat voor de ander. Deze divergentie vraagt om robotontwerpen die rekening houden met zowel goede taakuitvoering als betrouwbare verklaringen.

Robots aanleren

Bij het uitvoeren van deze studie, onze groep was geïnteresseerd in twee dingen. Hoe leert een robot een bepaalde taak het beste uit te voeren? Vervolgens, hoe reageren mensen op de uitleg van de robot over zijn acties?

We leerden een robot om van menselijke demonstraties te leren hoe een medicijnfles met een veiligheidsslot te openen. Een persoon droeg een tactiele handschoen die de houdingen en krachten van de menselijke hand vastlegde terwijl deze de fles opende. Die informatie hielp de robot op twee manieren te leren wat de mens deed:symbolisch en haptisch. Symbolisch verwijst naar betekenisvolle representaties van uw acties:bijvoorbeeld het woord "grijpen". Haptisch verwijst naar de gevoelens die verband houden met de houdingen en bewegingen van uw lichaam:bijvoorbeeld het gevoel dat je vingers samenkomen.

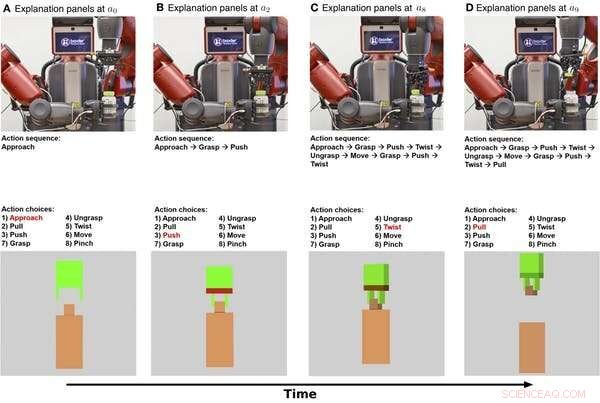

Symbolische en haptische uitleg van een robot die een medicijnfles opent, getoond in de loop van de tijd. De bovenste rij zijn stills uit een video van de robot die de taak uitvoert. De middelste rij toont een symbolische uitleg van de taak. De onderste rij toont een haptische uitleg. Krediet:Edmonds et al., Wetenschap. Robot. 4, eaay4663 (2019)

Eerst, de robot leerde een symbolisch model dat de volgorde van stappen codeert die nodig zijn om de taak van het openen van de fles te voltooien. Tweede, de robot leerde een haptisch model waarmee de robot zichzelf kan 'verbeelden' in de rol van de menselijke demonstrator en kan voorspellen welke actie een persoon zou ondernemen bij het tegenkomen van bepaalde houdingen en krachten.

Het blijkt dat de robot zijn beste prestaties kon leveren bij het combineren van de symbolische en haptische componenten. De robot deed het beter met kennis van de stappen voor het uitvoeren van de taak en realtime detectie van zijn grijper dan een van beide alleen te gebruiken.

Menselijk vertrouwen winnen

Nu de robot weet wat hij moet doen, hoe kan het zijn gedrag aan een persoon uitleggen? En hoe goed bevordert die uitleg het menselijk vertrouwen?

Om zijn acties uit te leggen, de robot kan zowel putten uit zijn interne beslissingsproces als uit zijn gedrag. Het symbolische model geeft stapsgewijze beschrijvingen van de acties van de robot, en het haptische model geeft een idee van wat de robotgrijper 'voelt'.

In ons experiment, we hebben een extra uitleg voor mensen toegevoegd:een tekstbericht dat een samenvatting gaf nadat de robot klaar was met proberen de medicijnfles te openen. We wilden zien of beknopte beschrijvingen net zo effectief zouden zijn als de stapsgewijze symbolische uitleg om menselijk vertrouwen te winnen.

We vroegen 150 menselijke deelnemers, verdeeld in vier groepen, om de robot te observeren die probeert de medicijnfles te openen. De robot gaf vervolgens elke groep een andere uitleg van de taak:symbolisch, stap voor stap, haptische armposities en bewegingen, tekst samenvatting, of symbolisch en haptisch samen. Een baselinegroep observeerde alleen een video van de robot die probeerde de fles te openen, zonder verdere uitleg.

We ontdekten dat het geven van zowel de symbolische als de haptische uitleg het meeste vertrouwen wekte, waarbij de symbolische component het meest bijdraagt. interessant, de uitleg in de vorm van een tekstsamenvatting wekte niet meer vertrouwen op dan simpelweg kijken naar de robot die de taak uitvoert, wat aangeeft dat mensen de voorkeur geven aan robots om stapsgewijze uitleg te geven over wat ze doen.

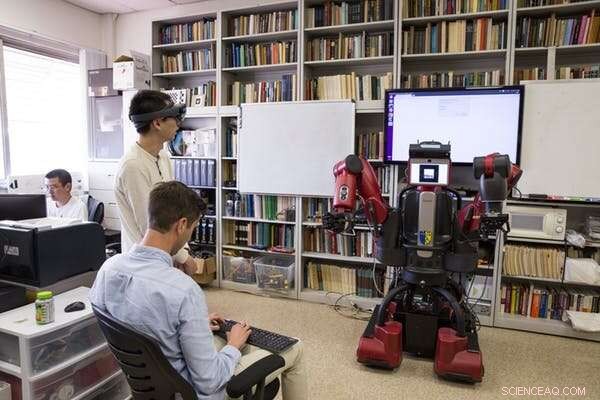

UCLA-onderzoekers testen een robot nadat hij heeft geleerd hoe hij een medicijnfles moet openen door menselijke demonstranten te observeren. Krediet:UCLA Samueli School of Engineering, CC BY-ND

Ontwerpen voor zowel prestaties als vertrouwen

De meest interessante uitkomst van dit onderzoek is dat wat ervoor zorgt dat robots goed presteren, niet hetzelfde is als waardoor mensen ze als betrouwbaar zien. De robot had zowel de symbolische als de haptische componenten nodig om het beste werk te doen. Maar het was de symbolische verklaring die ervoor zorgde dat mensen de robot het meest vertrouwden.

Deze divergentie benadrukt belangrijke doelen voor toekomstig AI- en robotica-onderzoek:focussen op het nastreven van zowel taakprestaties als verklaarbaarheid. Alleen focussen op taakuitvoering leidt mogelijk niet tot een robot die zichzelf goed uitlegt. Ons lab gebruikt een hybride model om zowel hoge prestaties als betrouwbare verklaringen te bieden.

Prestaties en uitleg vullen elkaar niet vanzelf aan, dus beide doelen moeten vanaf het begin een prioriteit zijn bij het bouwen van AI-systemen. Dit werk vertegenwoordigt een belangrijke stap in het systematisch bestuderen van hoe mens-machinerelaties zich ontwikkelen, maar er moet nog veel meer gebeuren. Een uitdagende stap voor toekomstig onderzoek zal zijn om van "Ik vertrouw erop dat de robot X doet" naar "Ik vertrouw de robot".

Om robots een plek te laten verdienen in het dagelijks leven van mensen, mensen moeten hun robotachtige tegenhangers vertrouwen. Begrijpen hoe robots verklaringen kunnen geven die menselijk vertrouwen bevorderen, is een belangrijke stap om mensen en robots in staat te stellen samen te werken.

Dit artikel is opnieuw gepubliceerd vanuit The Conversation onder een Creative Commons-licentie. Lees het originele artikel.

Hoe vindt u hoeveel mol in een verbinding

Hoe vindt u hoeveel mol in een verbinding  Nieuw ontwikkelde screeningprocessen zullen het onderzoek naar koolstofafvang versnellen

Nieuw ontwikkelde screeningprocessen zullen het onderzoek naar koolstofafvang versnellen Het gebruik en de voorraden van hoogverrijkt uranium door Rusland vormen aanzienlijke nucleaire risico's

Het gebruik en de voorraden van hoogverrijkt uranium door Rusland vormen aanzienlijke nucleaire risico's Doorbraak in lignine-onderzoek - bolvormige deeltjes vermenigvuldigen de enzymefficiëntie

Doorbraak in lignine-onderzoek - bolvormige deeltjes vermenigvuldigen de enzymefficiëntie Röntgenstralen onthullen een verborgen eigenschap die leidt tot defecten in een lithium-ionbatterijmateriaal

Röntgenstralen onthullen een verborgen eigenschap die leidt tot defecten in een lithium-ionbatterijmateriaal

10 manieren om nu te stoppen met het gebruik van plastic

10 manieren om nu te stoppen met het gebruik van plastic  Grote hoeveelheden waardevolle energie, voedingsstoffen, water verloren in snel stijgende afvalwaterstromen ter wereld

Grote hoeveelheden waardevolle energie, voedingsstoffen, water verloren in snel stijgende afvalwaterstromen ter wereld Boven onze hoofden woedt een strijd om de jetstream

Boven onze hoofden woedt een strijd om de jetstream Oude boeren hebben ons gespaard van gletsjers, maar hebben het klimaat op aarde ingrijpend veranderd

Oude boeren hebben ons gespaard van gletsjers, maar hebben het klimaat op aarde ingrijpend veranderd Satelliettechnologie kan landbouwproducenten helpen om de vochtigheid van de ondergrond nauwkeuriger te meten

Satelliettechnologie kan landbouwproducenten helpen om de vochtigheid van de ondergrond nauwkeuriger te meten

Hoofdlijnen

- Celademhalingsexperimenten

- Sarcodina Life Cycle

- Simpele microscoopexperimenten

- Geometrie speelt een belangrijke rol in hoe cellen zich gedragen, onderzoekers rapporteren

- Ribosomen: definitie, functie en structuur (eukaryoten en prokaryoten)

- Computerprogramma detecteert verschillen tussen menselijke cellen

- Nieuwe mechanismen ontdekt die bacteriën gebruiken om zichzelf te beschermen tegen antibiotica

- Prokaryotische versus eukaryotische cellen: overeenkomsten en verschillen

- Genomics onthult hoe concurrentie tussen bacteriën de impact van vaccinatie beïnvloedt

- Je arm gebruiken als touchscreen van een smartwatch

- Akamai spreekt zich uit over toename van DDoS-aanvallen

- Uber hervat testen voor zelfrijdende auto's in handmatige modus

- Magnetische levitatieprojecten voor kinderen

- Stanford-onderzoekers helpen bij het ontwikkelen van een op privacy gerichte app voor coronaviruswaarschuwing

Dendrietvrije lithiummetaalanoden met N-gedoteerde grafeenmatrix

Dendrietvrije lithiummetaalanoden met N-gedoteerde grafeenmatrix Kubieke voet naar Lbs

Kubieke voet naar Lbs Inheemse gezondheidstraining is een reis, geen selectievakje

Inheemse gezondheidstraining is een reis, geen selectievakje Drie aanpassingen voor een dolfijn

Drie aanpassingen voor een dolfijn Grafeen en aanverwante materialen beloven goedkoop, flexibele bedrukte camera's

Grafeen en aanverwante materialen beloven goedkoop, flexibele bedrukte camera's Japanse Suzuki in binnenlandse terugroepactie van 2 miljoen voertuigen

Japanse Suzuki in binnenlandse terugroepactie van 2 miljoen voertuigen In een eerste, onderzoekers gebruiken ultrasnelle elektronencamera's om meer te weten te komen over moleculen in vloeibare monsters

In een eerste, onderzoekers gebruiken ultrasnelle elektronencamera's om meer te weten te komen over moleculen in vloeibare monsters Nieuw onderzoek onthult dat continentale korst 500 miljoen jaar eerder ontstond dan gedacht

Nieuw onderzoek onthult dat continentale korst 500 miljoen jaar eerder ontstond dan gedacht

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | French |

-

Wetenschap © https://nl.scienceaq.com