Wetenschap

Nu regeringen kunstmatige intelligentie adopteren, er is weinig toezicht en veel gevaar

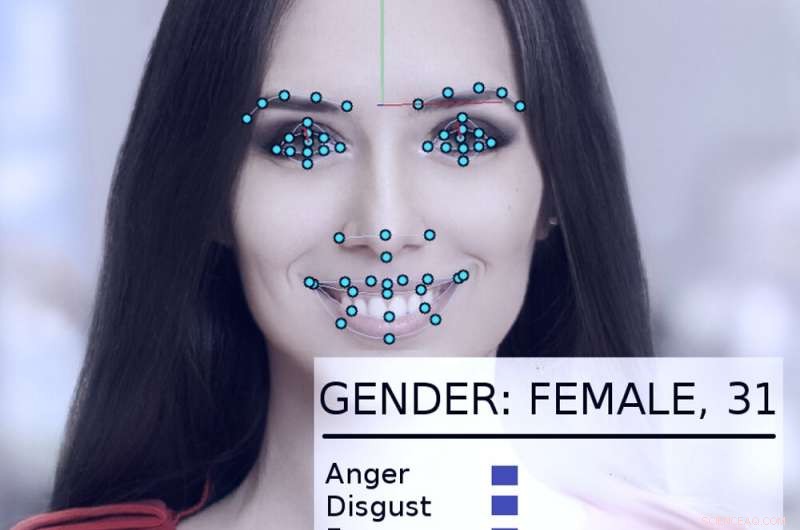

Een gezichtsvolg- en analysesysteem kijkt naar het gezicht van een vrouw. Krediet:Abyssus/Wikimedia Commons, CC BY-SA

Kunstmatige-intelligentiesystemen kunnen – als ze op de juiste manier worden gebruikt – helpen om de overheid effectiever en responsiever te maken, het leven van de burgers te verbeteren. Verkeerd gebruikt, echter, de dystopische visioenen van George Orwells "1984" worden realistischer.

Op eigen kracht en aangespoord door een nieuw presidentieel uitvoerend bevel, regeringen in de VS, inclusief staats- en federale agentschappen, onderzoeken manieren om AI-technologieën te gebruiken.

Als AI-onderzoeker al meer dan 40 jaar, die adviseur of deelnemer aan veel overheidsprojecten is geweest, Ik denk dat het de moeite waard is om op te merken dat ze het soms goed hebben gedaan - en andere keren niet zo goed. De mogelijke nadelen en voordelen zijn aanzienlijk.

Een vroeg succes

in 2015, het Amerikaanse ministerie van Binnenlandse Veiligheid heeft een AI-systeem ontwikkeld met de naam "Emma, " een chatbot die vragen kan beantwoorden in gewoon Engels, zonder te hoeven weten wat "haar" inleidende website "overheid spreekt" noemt - alle officiële termen en acroniemen die in documenten van instanties worden gebruikt.

Tegen eind 2016, DHS meldde dat Emma al hielp bij het beantwoorden van bijna een half miljoen vragen per maand, waardoor het DHS veel meer vragen kan behandelen dan voorheen, en menselijke werknemers meer tijd te laten besteden aan het helpen van mensen met meer gecompliceerde vragen die Emma's mogelijkheden te boven gaan. Dit soort conversatie-automatiserende kunstmatige intelligentie is nu gebruikt door andere overheidsinstanties, in steden en landen over de hele wereld.

Het water van vuursteen

Een ingewikkelder voorbeeld van hoe overheden AI treffend kunnen toepassen, is te zien in Flint, Michigan. Terwijl de lokale en deelstaatregeringen worstelden om loodverontreiniging in het drinkwater van de stad te bestrijden, het werd duidelijk dat ze de resterende loden waterleidingen van de stad moesten vervangen. Echter, de gegevens van de stad waren onvolledig, en het zou extreem duur zijn om alle leidingen van de stad op te graven om te zien of ze van lood of van koper waren.

In plaats daarvan, computerwetenschappers en overheidsmedewerkers werkten samen om een breed scala aan gegevens te analyseren over elk van de 55, 000 woningen in de stad, inclusief hoe oud het huis was, om de waarschijnlijkheid te berekenen dat het werd bediend door loden leidingen. Voordat het systeem in gebruik werd genomen, 80% van de opgegraven leidingen was aan vervanging toe, wat 20% van de tijd betekende, er werd geld en moeite verspild aan leidingen die niet vervangen hoefden te worden.

Het AI-systeem hielp ingenieurs zich te concentreren op vastgoed met een hoog risico, het identificeren van een reeks eigenschappen die het meest waarschijnlijk pijpvervanging nodig hebben. Toen stadsinspecteurs de situatie bezochten, het algoritme had 70% van de tijd gelijk. Dat beloofde enorm veel geld te besparen en het proces van pijpvervanging te versnellen.

Echter, de lokale politiek stond in de weg. Veel leden van het publiek begrepen niet waarom het systeem de huizen identificeerde, en maakte bezwaar, zeggen dat de AI-methode hun huizen op oneerlijke wijze negeerde. Nadat stadsambtenaren het algoritme niet meer gebruikten, slechts 15% van de opgegraven leidingen was van lood. Dat maakte het vervangingsproject trager en duurder.

Schrijnende voorbeelden

Het probleem in Flint was dat mensen niet begrepen dat AI-technologie goed werd gebruikt, en dat mensen zijn bevindingen verifieerden met onafhankelijke inspecties. Gedeeltelijk, dit was omdat ze AI niet vertrouwden - en in sommige gevallen is daar een goede reden voor.

in 2017, Ik behoorde tot een groep van meer dan vier dozijn AI-onderzoekers die een brief stuurden naar de waarnemend secretaris van het Amerikaanse ministerie van Binnenlandse Veiligheid. We hebben onze bezorgdheid geuit over een voorstel om geautomatiseerde systemen te gebruiken om te bepalen of een persoon die asiel zoekt in de VS een "positief bijdragend lid van de samenleving" zou worden of een grotere kans zou hebben om een terroristische dreiging te vormen.

"Simpel gezegd, "In onze brief stond:"geen enkele computermethode kan betrouwbare of objectieve beoordelingen geven van de eigenschappen die [DHS] wil meten." We hebben uitgelegd dat machine learning vatbaar is voor een probleem dat 'gegevensscheef, " waarbij het vermogen van het systeem om een kenmerk te voorspellen gedeeltelijk afhangt van hoe vaak dat kenmerk voorkomt in de gegevens die worden gebruikt om het systeem te trainen.

Dus in een database van 300 miljoen Amerikanen, als één op de 100 mensen dat is, zeggen, van Indiase afkomst, het systeem zal vrij nauwkeurig zijn in het identificeren ervan. Maar als we kijken naar een kenmerk dat door slechts één op de miljoen Amerikanen wordt gedeeld, er zijn echt niet genoeg gegevens voor het algoritme om een goede analyse te maken.

Zoals de brief uitlegde, "op de schaal van de Amerikaanse bevolking en immigratiecijfers, strafbare feiten zijn relatief zeldzaam, en terroristische daden zijn uiterst zeldzaam." Algoritmische analyse is uiterst onwaarschijnlijk om potentiële terroristen te identificeren. Gelukkig, onze argumenten waren overtuigend. In mei 2018, DHS heeft aangekondigd dat het een machine learning-algoritme niet op deze manier zou gebruiken.

Andere verontrustende inspanningen

Andere toepassingen van AI door de overheid worden in twijfel getrokken, ook – zoals pogingen tot "predictive policing, het instellen van borgsommen en strafrechtelijke veroordelingen en het inhuren van overheidspersoneel. Al deze zaken blijken gevoelig te zijn voor technische problemen en gegevensbeperkingen die hun beslissingen kunnen beïnvloeden op basis van ras, geslacht of culturele achtergrond.

Andere AI-technologieën zoals gezichtsherkenning, geautomatiseerde bewaking en massale gegevensverzameling leiden tot echte zorgen over veiligheid, privacy, eerlijkheid en nauwkeurigheid in een democratische samenleving.

Zoals het uitvoerend bevel van Trump aantoont, er is aanzienlijke belangstelling voor het benutten van AI voor zijn volledige positieve potentieel. Maar de grote gevaren van misbruik, misbruik en vooringenomenheid – al dan niet opzettelijk – kunnen in strijd zijn met de principes waarop internationale democratieën zijn gebouwd.

Naarmate het gebruik van AI-technologieën toeneemt, hetzij oorspronkelijk goed bedoeld of opzettelijk autoritair, de kans op misbruik neemt ook toe. Aangezien er momenteel geen overheidsbreed toezicht bestaat in de VS, de beste manier om deze misstanden te voorkomen, is het publiek te leren over het juiste gebruik van AI door middel van gesprekken tussen wetenschappers, bezorgde burgers en overheidsbestuurders om te helpen bepalen wanneer en waar het ongepast is om deze krachtige nieuwe instrumenten in te zetten.

Dit artikel is opnieuw gepubliceerd vanuit The Conversation onder een Creative Commons-licentie. Lees het originele artikel.

Welk habitattype leven garnalen?

Welk habitattype leven garnalen?  Niet alle gletsjers op Antarctica zijn getroffen door klimaatverandering

Niet alle gletsjers op Antarctica zijn getroffen door klimaatverandering Wat hebben fossielen te maken met Wegeners-theorie?

Wat hebben fossielen te maken met Wegeners-theorie?  Meteorietbombardement heeft waarschijnlijk de oudste rotsen van de aarde gevormd

Meteorietbombardement heeft waarschijnlijk de oudste rotsen van de aarde gevormd Bacteriën beheersen niveaus van gevaarlijke verontreinigende stof bij zeevogels

Bacteriën beheersen niveaus van gevaarlijke verontreinigende stof bij zeevogels

Hoofdlijnen

- Welke sequenties zorgen ervoor dat DNA uitpakt en ademt?

- Sardines nemen ons mee naar de bronnen van biodiversiteit in de Amazone-rivier

- Theorie van de evolutie van geslachten getest met algen

- Wat is de schijfachtige structuur aan de zijde van chloroplasten?

- Langharige microben vernoemd naar Canadese band Rush

- Klimaatveranderingsmodellen van vogeleffecten slagen voor de test

- Evolutie in je achtertuin - koolmezen passen hun snavel misschien aan aan vogelvoeders

- Cambodja neemt lading ivoor in beslag, verborgen in holle boomstammen

- Hoe neemt een slijmvorm beslissingen zonder hersenen?

- Ontwikkeling van kankercellen volgen met drinkbare elektronische sensoren

- Techreuzen beloven de strijd tegen online extremisme op te voeren

- VS keuren Winklevoss dollar-gekoppelde cryptocurrencies goed

- Bezorgd dat je op Facebook zit? Enkele opties uitgelegd

- Google-advertenties:effectief, een beetje frustrerend, bedrijven zeggen:

Hoe zich te ontdoen van vleermuizen in mijn kelder

Hoe zich te ontdoen van vleermuizen in mijn kelder  Een warm ruimtestation welkom voor coole nieuwe hardware

Een warm ruimtestation welkom voor coole nieuwe hardware Beeldvormende middelen ontwikkeld om de groei van tumoren beter te volgen

Beeldvormende middelen ontwikkeld om de groei van tumoren beter te volgen Onze Amazone:Brazilianen die in het grootste regenwoud ter wereld leven

Onze Amazone:Brazilianen die in het grootste regenwoud ter wereld leven Namen van de structurele componenten van het menselijk hart

Namen van de structurele componenten van het menselijk hart  Warmtemotor: definitie, typen en voorbeelden

Warmtemotor: definitie, typen en voorbeelden Onderzoekers modelleren grafeen/nanobuishybriden om eigenschappen te testen

Onderzoekers modelleren grafeen/nanobuishybriden om eigenschappen te testen Onderzoekers melden een verband tussen aardbevingen en valutasprongen

Onderzoekers melden een verband tussen aardbevingen en valutasprongen

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway | French |

-

Wetenschap © https://nl.scienceaq.com