Wetenschap

Nieuw beeldvormingssysteem maakt foto's door tijd te meten

Krediet:Universiteit van Glasgow

Een radicaal nieuwe beeldvormingsmethode die kunstmatige intelligentie gebruikt om tijd om te zetten in visioenen van 3D-ruimte, zou auto's kunnen helpen, mobiele apparaten en gezondheidsmonitors ontwikkelen 360-graden bewustzijn.

Foto's en video's worden meestal geproduceerd door fotonen - de bouwstenen van licht - vast te leggen met digitale sensoren. Bijvoorbeeld, digitale camera's bestaan uit miljoenen pixels die beelden vormen door de intensiteit en kleur van het licht op elk punt van de ruimte te detecteren. 3D-beelden kunnen vervolgens worden gegenereerd door twee of meer camera's rond het onderwerp te plaatsen om het vanuit meerdere hoeken te fotograferen, of door fotonenstromen te gebruiken om de scène te scannen en deze in drie dimensies te reconstrueren. Hoe dan ook, een afbeelding wordt alleen opgebouwd door ruimtelijke informatie van de scène te verzamelen.

In een nieuw artikel dat vandaag in het tijdschrift is gepubliceerd: optiek , onderzoekers gevestigd in het VK, Italië en Nederland beschrijven een geheel nieuwe manier om geanimeerde 3D-beelden te maken:door tijdelijke informatie over fotonen vast te leggen in plaats van hun ruimtelijke coördinaten.

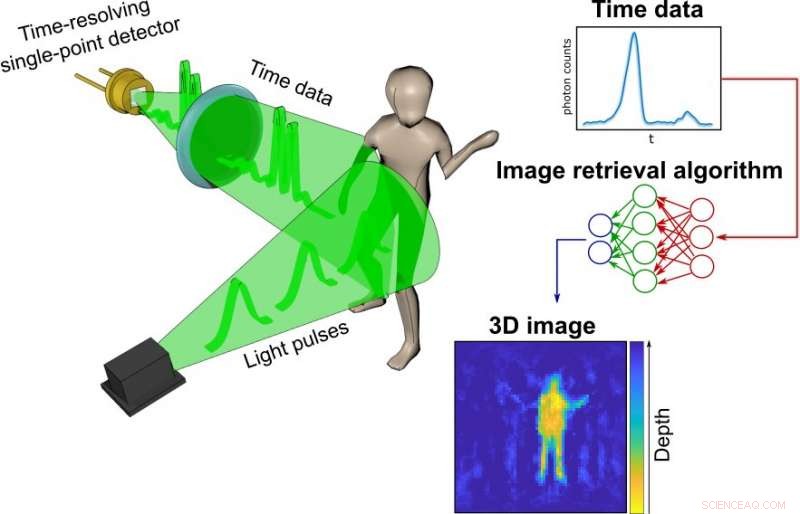

Hun proces begint met een eenvoudige, goedkope eenpuntsdetector die is afgestemd om als een soort stopwatch voor fotonen te fungeren. In tegenstelling tot camera's, het meten van de ruimtelijke verdeling van kleur en intensiteit, de detector registreert alleen hoe lang het duurt voordat de fotonen die worden geproduceerd door een puls van een fractie van een seconde laserlicht, van elk object in een bepaalde scène weerkaatsen en de sensor bereiken. Hoe verder weg een object is, hoe langer het duurt voordat elk gereflecteerd foton de sensor bereikt.

De informatie over de timing van elk foton dat in de scène wordt weerspiegeld - wat de onderzoekers de tijdelijke gegevens noemen - wordt verzameld in een zeer eenvoudige grafiek.

Die grafieken worden vervolgens omgezet in een 3D-beeld met behulp van een geavanceerd neuraal netwerkalgoritme. De onderzoekers trainden het algoritme door het duizenden conventionele foto's te laten zien van het team dat objecten in het lab beweegt en draagt. naast tijdelijke gegevens die tegelijkertijd door de enkelpuntsdetector zijn vastgelegd.

Eventueel, het netwerk had genoeg geleerd over hoe de temporele gegevens overeenkwamen met de foto's dat het in staat was zeer nauwkeurige afbeeldingen te maken van alleen de tijdelijke gegevens. In de proof-of-principle experimenten, het team slaagde erin bewegende beelden te construeren met ongeveer 10 frames per seconde uit de tijdelijke gegevens, hoewel de gebruikte hardware en het gebruikte algoritme het potentieel hebben om duizenden afbeeldingen per seconde te produceren.

Dr. Alex Turpin, Lord Kelvin Adam Smith Fellow in Data Science aan de School of Computing Science van de University of Glasgow, leidde het onderzoeksteam van de universiteit samen met Prof. Daniele Faccio, met steun van collega's van de Polytechnische Universiteit van Milaan en de Technische Universiteit Delft.

Dr. Turpin zei:"Camera's in onze mobiele telefoons vormen een afbeelding door miljoenen pixels te gebruiken. Afbeeldingen maken met alleen een enkele pixel is onmogelijk als we alleen ruimtelijke informatie beschouwen, zoals een enkelpuntsdetector er geen heeft. Echter, zo'n detector kan nog steeds waardevolle informatie over de tijd geven. We zijn erin geslaagd een nieuwe manier te vinden om eendimensionale gegevens - een eenvoudige tijdmeting - om te zetten in een bewegend beeld dat de drie dimensies van de ruimte in een bepaalde scène vertegenwoordigt. De belangrijkste manier die verschilt van conventionele beeldvorming is dat onze aanpak in staat is om licht volledig los te koppelen van het proces. Hoewel veel van het artikel bespreekt hoe we gepulseerd laserlicht hebben gebruikt om de tijdelijke gegevens van onze scènes te verzamelen, het laat ook zien hoe we radargolven voor hetzelfde doel hebben kunnen gebruiken. We zijn ervan overtuigd dat de methode kan worden aangepast aan elk systeem dat in staat is een scène met korte pulsen af te tasten en de retourecho nauwkeurig te meten. Dit is eigenlijk nog maar het begin van een geheel nieuwe manier om de wereld te visualiseren met behulp van tijd in plaats van licht."

Momenteel, het vermogen van het neurale netwerk om afbeeldingen te maken, is beperkt tot wat het is getraind om te kiezen uit de tijdelijke gegevens van scènes die door de onderzoekers zijn gemaakt. Echter, met bijscholing en zelfs door gebruik te maken van meer geavanceerde algoritmen, het zou kunnen leren een gevarieerd scala aan scènes te visualiseren, verbreding van de potentiële toepassingen in real-world situaties.

Dr. Turpin voegde toe:"De enkelpuntsdetectoren die de tijdelijke gegevens verzamelen, zijn klein, licht en goedkoop, wat betekent dat ze eenvoudig kunnen worden toegevoegd aan bestaande systemen zoals de camera's in autonome voertuigen om de nauwkeurigheid en snelheid van hun padvinding te vergroten. Alternatief, ze zouden bestaande sensoren in mobiele apparaten zoals de Google Pixel 4 kunnen uitbreiden, die al een eenvoudig gebarenherkenningssysteem heeft op basis van radartechnologie. Toekomstige generaties van onze technologie kunnen zelfs worden gebruikt om het stijgen en dalen van de borstkas van een patiënt in het ziekenhuis te volgen om het personeel te waarschuwen voor veranderingen in hun ademhaling, of om hun bewegingen bij te houden om hun veiligheid op een gegevensconforme manier te waarborgen. We zijn erg enthousiast over het potentieel van het systeem dat we hebben ontwikkeld, en we kijken ernaar uit om het potentieel ervan te blijven verkennen. Onze volgende stap is om te werken aan een op zichzelf staand, draagbaar systeem-in-een-doos en we willen graag beginnen met het onderzoeken van onze opties om ons onderzoek te bevorderen met input van commerciële partners."

De krant van het team, getiteld "Ruimtelijke beelden uit tijdelijke gegevens, " is gepubliceerd in optiek .

Ultrasnelle herhaalde kleuring en ontkleuring van celmonsters voor tumordiagnostiek

Ultrasnelle herhaalde kleuring en ontkleuring van celmonsters voor tumordiagnostiek Zuur kan een belangrijk ingrediënt zijn voor een betere kleefkracht, elektronische componenten

Zuur kan een belangrijk ingrediënt zijn voor een betere kleefkracht, elektronische componenten De verschillen tussen HPLC en GC

De verschillen tussen HPLC en GC Team zorgt voor stabiliteit van ontziltingsproces met magnesium

Team zorgt voor stabiliteit van ontziltingsproces met magnesium Opwaarderen van biomassa met selectieve oppervlakte-gemodificeerde katalysatoren

Opwaarderen van biomassa met selectieve oppervlakte-gemodificeerde katalysatoren

Tijdens abrupte opwarming, kreeften in zuur water hebben een verminderde hartfunctie, minder infectiebestrijdende cellen

Tijdens abrupte opwarming, kreeften in zuur water hebben een verminderde hartfunctie, minder infectiebestrijdende cellen Hoe reproduceren pijnbomen?

Hoe reproduceren pijnbomen?  Koolstofemissie permafrostbodems met 14% onderschat

Koolstofemissie permafrostbodems met 14% onderschat Abiotische dingen in het loofbos

Abiotische dingen in het loofbos  Golven en getijden hebben een grotere impact op het leven in zee dan menselijke activiteit

Golven en getijden hebben een grotere impact op het leven in zee dan menselijke activiteit

Hoofdlijnen

- Noorse rechtbank verleent uitstel aan zeven wolven

- Babyneushoorn galoppeert naar publiek in Singapore Zoo

- Neurale opnames van wilde vleermuizen onthullen een unieke organisatie van het middenhersenengebied voor het volgen en vangen van prooien

- Wedstrijden om vrouwelijke aandacht maken van mannen betere presteerders - in fruitvliegjes

- Hoe de droogrot Serpula lacrymans zich aanpasten aan een nieuwe ecologische habitat

- Beschrijving van de basisfuncties van enzymen in cellen

- Roofzuchtige bacteriën die patrijspoorten maken en fresco's schilderen in schadelijke bacteriën

- Wanneer wordt een mutatie in een DNA-molecuul doorgegeven aan nakomelingen?

- Maak een lijst van de 3 stappen die zich voordoen tijdens de interfase

Hoe planten planten energie opslaan tijdens fotosynthese?

Hoe planten planten energie opslaan tijdens fotosynthese?  Superzware zwarte gaten groeien uit hun sterrenstelsels

Superzware zwarte gaten groeien uit hun sterrenstelsels Onderzoekers observeren spontaan optreden van skyrmionen in atomair dunne kobaltfilms

Onderzoekers observeren spontaan optreden van skyrmionen in atomair dunne kobaltfilms De Broglie Golflengte: definitie, vergelijking & hoe te berekenen

De Broglie Golflengte: definitie, vergelijking & hoe te berekenen  Een implanteerbaar apparaat dat energie produceert met behulp van ultrageluid

Een implanteerbaar apparaat dat energie produceert met behulp van ultrageluid Wetenschappers sluiten zich aan bij oproep voor grote verschuiving in begrip om de oceaan te beschermen

Wetenschappers sluiten zich aan bij oproep voor grote verschuiving in begrip om de oceaan te beschermen In de schoenen van een robot:de toekomst nadert

In de schoenen van een robot:de toekomst nadert BMW roept 323 terug, 700 dieselauto's boven brandgevaar:rapport

BMW roept 323 terug, 700 dieselauto's boven brandgevaar:rapport

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com