Wetenschap

Meer informatie over deeltjesbotsingen met machine learning

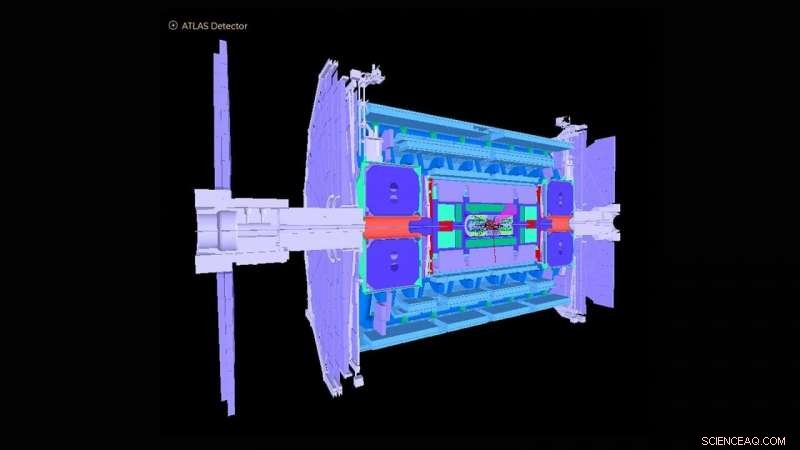

Schema van de ATLAS-detector in de Large Hadron Collider. Krediet:ATLAS-samenwerking

De Large Hadron Collider (LHC) bij Genève, Zwitserland werd in 2012 wereldberoemd met de detectie van het Higgs-deeltje. De waarneming markeerde een cruciale bevestiging van het standaardmodel van de deeltjesfysica, die de subatomaire deeltjes organiseert in groepen die lijken op elementen in het periodiek systeem uit de chemie.

Het Argonne National Laboratory van het Amerikaanse Department of Energy (DOE) heeft veel cruciale bijdragen geleverd aan de constructie en werking van de ATLAS-experimentele detector bij de LHC en aan de analyse van door de detector geregistreerde signalen die de onderliggende fysica van deeltjesbotsingen blootleggen. Argonne speelt nu een leidende rol bij de upgrade met hoge helderheid van de ATLAS-detector voor operaties die gepland zijn om in 2027 te beginnen. een team van natuurkundigen en computerwetenschappers uit Argonne heeft een op machine learning gebaseerd algoritme bedacht dat benadert hoe de huidige detector zou reageren op de sterk toegenomen gegevens die met de upgrade worden verwacht.

Als de grootste fysica-machine ooit gebouwd, de LHC schiet twee bundels protonen in tegengestelde richtingen rond een ring van 17 mijl tot ze bijna de lichtsnelheid naderen, slaat ze aan elkaar en analyseert de botsingsproducten met gigantische detectoren zoals ATLAS. Het ATLAS-instrument is ongeveer zo hoog als een gebouw van zes verdiepingen en weegt ongeveer 7, 000 ton. Vandaag, de LHC blijft het Higgs-deeltje bestuderen, evenals fundamentele vragen over hoe en waarom de materie in het universum is zoals het is.

"De meeste onderzoeksvragen bij ATLAS hebben betrekking op het vinden van een speld in een gigantische hooiberg, waar wetenschappers alleen geïnteresseerd zijn in het vinden van één gebeurtenis die plaatsvindt onder een miljard andere, " zei Walter Hopkins, assistent-fysicus in de divisie High Energy Physics (HEP) van Argonne.

Als onderdeel van de LHC-upgrade, er worden nu inspanningen geleverd om de helderheid van de LHC - het aantal proton-tot-proton-interacties per botsing van de twee protonenbundels - met een factor vijf te verhogen. Dit zal ongeveer 10 keer meer gegevens per jaar opleveren dan wat momenteel wordt verzameld door de LHC-experimenten. Hoe goed de detectoren reageren op deze verhoogde frequentie moet nog worden begrepen. Dit vereist het uitvoeren van krachtige computersimulaties van de detectoren om bekende processen als gevolg van LHC-botsingen nauwkeurig te beoordelen. Deze grootschalige simulaties zijn kostbaar en vergen grote hoeveelheden rekentijd op 's werelds beste en krachtigste supercomputers.

Het Argonne-team heeft een algoritme voor machine learning ontwikkeld dat als voorlopige simulatie wordt uitgevoerd vóór volledige simulaties. Dit algoritme benadert, op zeer snelle en goedkopere manieren, hoe de huidige detector zou reageren op de sterk toegenomen gegevens die met de upgrade worden verwacht. Het omvat simulatie van detectorreacties op een deeltjesbotsingsexperiment en de reconstructie van objecten uit de fysieke processen. Deze gereconstrueerde objecten omvatten jets of sprays van deeltjes, evenals individuele deeltjes zoals elektronen en muonen.

"De ontdekking van nieuwe fysica bij de LHC en elders vereist steeds complexere methoden voor big data-analyses, " zei Doug Benjamin, een computationele wetenschapper in HEP. "Tegenwoordig betekent dat meestal het gebruik van machine learning en andere kunstmatige-intelligentietechnieken."

De eerder gebruikte analysemethoden voor initiële simulaties hebben geen machine learning-algoritmen gebruikt en zijn tijdrovend omdat ze experimentele parameters handmatig moeten bijwerken wanneer de omstandigheden bij de LHC veranderen. Sommigen missen mogelijk ook belangrijke gegevenscorrelaties voor een bepaalde set invoervariabelen voor een experiment. Het door Argonne ontwikkelde algoritme leert, in realtime terwijl een trainingsprocedure wordt toegepast, de verschillende functies die moeten worden geïntroduceerd door middel van gedetailleerde volledige simulaties, waardoor de noodzaak om experimentele parameters met de hand te maken, wordt vermeden. De methode kan ook complexe onderlinge afhankelijkheden van variabelen vastleggen die voorheen niet mogelijk waren.

"Met onze uitgeklede simulatie, je kunt de basis leren tegen relatief weinig rekenkosten en tijd, dan kunt u op een later tijdstip veel efficiënter doorgaan met volledige simulaties, " zei Hopkins. "Ons algoritme voor machine learning biedt gebruikers ook een beter onderscheidingsvermogen bij het zoeken naar nieuwe of zeldzame gebeurtenissen in een experiment, " hij voegde toe.

Het algoritme van het team zou van onschatbare waarde kunnen zijn, niet alleen voor ATLAS, maar voor de meerdere experimentele detectoren bij de LHC, evenals andere deeltjesfysica-experimenten die nu over de hele wereld worden uitgevoerd.

Deze studie, getiteld "Geautomatiseerde detectorsimulatie en reconstructieparametrisering met behulp van machine learning, " verscheen in de Tijdschrift voor Instrumentatie .

Onderzoekers kunnen gevaarlijke chemicaliën uit fastfoodverpakkingen in het lichaam volgen

Onderzoekers kunnen gevaarlijke chemicaliën uit fastfoodverpakkingen in het lichaam volgen Vloeibare zwavel verandert van vorm en wordt kritisch onder druk

Vloeibare zwavel verandert van vorm en wordt kritisch onder druk Een nieuwe generatie kunstmatige netvliezen op basis van 2D-materialen

Een nieuwe generatie kunstmatige netvliezen op basis van 2D-materialen Wetenschappers gebruiken micro-organismen om functionele bacteriële cellulose in situ te fabriceren

Wetenschappers gebruiken micro-organismen om functionele bacteriële cellulose in situ te fabriceren Veiligere toekomst voor spoorvervoer van gevaarlijke stoffen in ontwikkeling

Veiligere toekomst voor spoorvervoer van gevaarlijke stoffen in ontwikkeling

Klimaatverandering vraagt om een frisse benadering van waterproblemen

Klimaatverandering vraagt om een frisse benadering van waterproblemen Klimaatonderzoek heeft meer aandacht nodig voor menselijke populaties

Klimaatonderzoek heeft meer aandacht nodig voor menselijke populaties Nieuwe studie van planktonschelpen vernietigt decennia-oud begrip van hun vorming en chemie

Nieuwe studie van planktonschelpen vernietigt decennia-oud begrip van hun vorming en chemie Mold Science Fair Project Ideas

Mold Science Fair Project Ideas  Groot, diep Antarctisch ozongat houdt aan tot november

Groot, diep Antarctisch ozongat houdt aan tot november

Hoofdlijnen

- Behandeling voor honden verlicht de angst voor lawaaierig vuurwerk

- Neurale opnames van wilde vleermuizen onthullen een unieke organisatie van het middenhersenengebied voor het volgen en vangen van prooien

- In welke levensfase komt mitose sneller voor?

- Een model van een menselijke cel bouwen

- Microbiële bewoner stelt kevers in staat zich te voeden met een bladdieet

- Hoe hoog kan een boom worden?

- Twee hersengebieden werken samen om vinken te helpen weten wanneer en hoe ze hun liedjes moeten afstemmen op specifieke situaties

- High School Biology Experiment Ideas

- Structuur van het cardiovasculaire systeem

Amerikaanse autoarbeiders bij VW-fabriek wijzen bod op vakbond af

Amerikaanse autoarbeiders bij VW-fabriek wijzen bod op vakbond af Video:NASA's Artemis-astronaut Victor Glover

Video:NASA's Artemis-astronaut Victor Glover Realistische avatars voor de virtuele dierentuin

Realistische avatars voor de virtuele dierentuin Hoe vuur van vandaag het water van morgen zal beïnvloeden

Hoe vuur van vandaag het water van morgen zal beïnvloeden Hoe maak je een project van Mars

Hoe maak je een project van Mars  Onderzoeker ontdekt dat wanneer sperma concurreert, eieren hebben een keuze

Onderzoeker ontdekt dat wanneer sperma concurreert, eieren hebben een keuze Studies onderzoeken mariene hittegolven, verschuivende oceaanstromingen

Studies onderzoeken mariene hittegolven, verschuivende oceaanstromingen Een planeet genaamd KOI-5Ab draait in een drievoudig stersysteem met een scheve configuratie

Een planeet genaamd KOI-5Ab draait in een drievoudig stersysteem met een scheve configuratie

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com