Wetenschap

Het grote probleem van kleine gegevens:een nieuwe aanpak

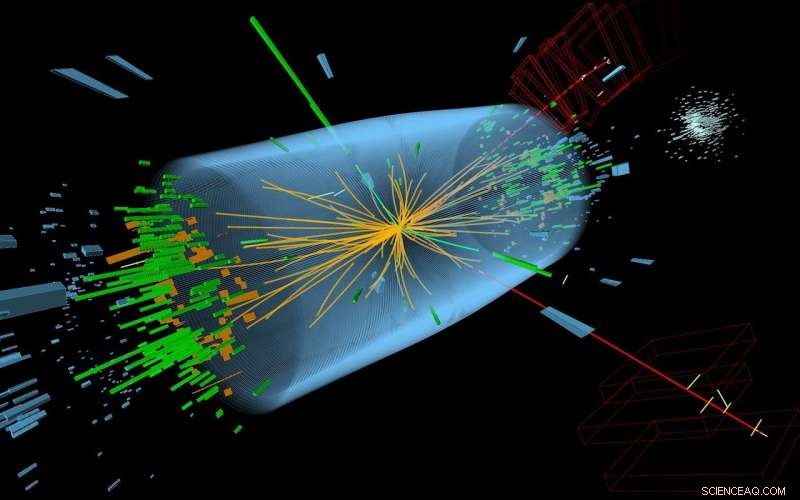

Om aan te tonen dat DEFT kan worden toegepast op een verscheidenheid aan kleine datasets, Wetenschappers van CSHL gebruikten het om gegevens van de CMS Higgs Boson-detector te analyseren. Van 60 deeltjesafdrukken, DEFT schatte dat er tot zes van echte gebeurtenissen waren. (Afgebeeld:een 3D-perspectief van een Higgs Boson-gebeurtenis opgenomen in 2012. Indrukken worden gekenmerkt door groene torens en rode lijnen.) Credit:McCauley, T; Taylor, L; CERN

Big Data is tegenwoordig een rage, maar Small Data is ook belangrijk! Betrouwbare conclusies trekken uit kleine datasets, zoals die van klinische proeven voor zeldzame ziekten of in studies van bedreigde soorten, blijft een van de lastigste obstakels in de statistieken. Nutsvoorzieningen, Onderzoekers van Cold Spring Harbor Laboratory (CSHL) hebben een nieuwe manier ontwikkeld om kleine gegevens te analyseren. een geïnspireerd door geavanceerde methoden in de theoretische natuurkunde, maar beschikbaar als gebruiksvriendelijke software.

"Omgaan met kleine datasets is een fundamenteel onderdeel van wetenschap, " CSHL-assistent-professor Justin Kinney legde uit. De uitdaging is dat, met zeer weinig gegevens, het is niet alleen moeilijk om tot een conclusie te komen; het is ook moeilijk om te bepalen hoe zeker uw conclusies zijn.

"Het is belangrijk om niet alleen de beste schatting te maken voor wat er aan de hand is, maar ook om te zeggen 'Deze gissing is waarschijnlijk juist, ' zei Kinney.

Een goed voorbeeld zijn klinische geneesmiddelenonderzoeken.

"Als elk datapunt een patiënt is, je hebt altijd te maken met kleine datasets, en om zeer goede redenen, " zei hij. "U wilt niet een behandeling op meer mensen testen dan u moet alvorens te bepalen of de drug veilig en efficiënt is. Het is echt belangrijk om deze beslissingen te kunnen nemen met zo min mogelijk data."

Het was moeilijk om die zekerheid te kwantificeren vanwege de aannames die in gemeenschappelijke statistische methoden worden gemaakt. Deze aannames waren nodig toen standaardmethoden werden ontwikkeld, vóór het computertijdperk. Maar deze benaderingen, Kinney merkt op, "kan catastrofaal zijn" op kleine datasets.

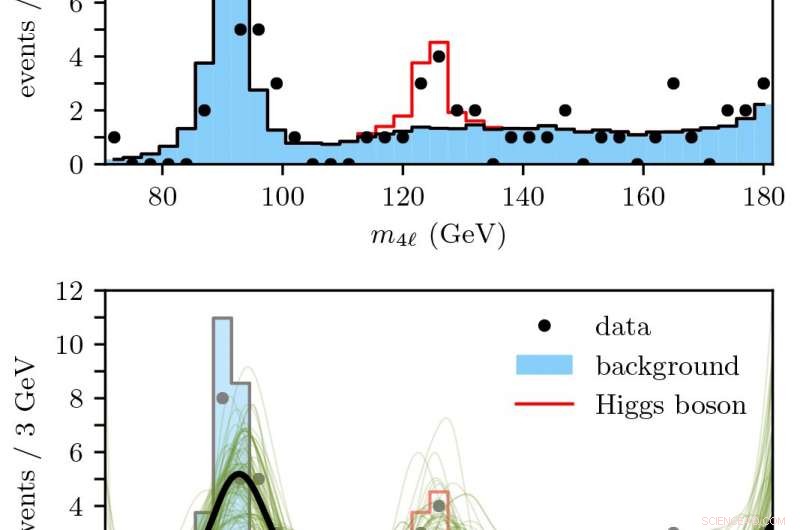

Boven:aantal verwachte Higgs Boson-deeltjesgebeurtenissen op basis van standaardmodelsimulaties.

Onder:DEFT werd gebruikt om soepel te voorspellen (zwart) hoeveel 4-lepton-vervalgebeurtenissen indicatoren waren van een echte Higgs Boson-gebeurtenis binnen een onzekerheidsmarge (groen). Krediet:Kinney Lab/CSHL

Nutsvoorzieningen, Kinney's lab heeft een moderne computationele benadering ontwikkeld, genaamd Density Estimation met behulp van veldtheorie, of BESCHIKBAAR, die deze tekortkomingen verhelpt. DEFT is gratis beschikbaar via een open source pakket genaamd SUFTware.

In hun recente krant gepubliceerd in Fysieke beoordelingsbrieven , Kinney's lab demonstreert DEFT op twee datasets:nationale gezondheidsstatistieken samengesteld door de Wereldgezondheidsorganisatie, en sporen van subatomaire deeltjes die door natuurkundigen bij de Large Hadron Collider zijn gebruikt om het bestaan van het Higgs-deeltje te onthullen.

Kinney zegt dat het kunnen toepassen van DEFT op zulke drastisch diverse 'real-world' situaties - ondanks dat de berekeningen zijn geïnspireerd door theoretische fysica - wat de nieuwe benadering zo krachtig maakt.

"Flexibiliteit is echt een goede zaak... We passen DEFT nu aan aan problemen in overlevingsanalyse, het type statistieken dat wordt gebruikt in klinische onderzoeken, "Zei Kinney. "Deze nieuwe mogelijkheden zullen aan SUFTware worden toegevoegd terwijl we doorgaan met het ontwikkelen van deze nieuwe benadering van statistiek."

Elementen combineren om verbindingen te vormen

Elementen combineren om verbindingen te vormen Wondgenezende biomaterialen activeren het immuunsysteem voor een sterkere huid

Wondgenezende biomaterialen activeren het immuunsysteem voor een sterkere huid Hoop op nieuwe katalysatoren met hoge activiteit

Hoop op nieuwe katalysatoren met hoge activiteit Typen instrumenten die worden gebruikt bij het meten van lichaamstemperatuur

Typen instrumenten die worden gebruikt bij het meten van lichaamstemperatuur Biofysici mengen onverenigbare componenten tot één nanovezel

Biofysici mengen onverenigbare componenten tot één nanovezel

Paradijs verloren:branden in Californië woeden voort

Paradijs verloren:branden in Californië woeden voort Team bestudeert evolutie van activisme tegen klimaatverandering

Team bestudeert evolutie van activisme tegen klimaatverandering Landbouw vervangt fossiele brandstoffen als grootste menselijke bron van zwavel voor het milieu

Landbouw vervangt fossiele brandstoffen als grootste menselijke bron van zwavel voor het milieu Nieuwe wereldwijde database zal wetenschappers helpen de rol van meren in de ecologie van de aarde te volgen

Nieuwe wereldwijde database zal wetenschappers helpen de rol van meren in de ecologie van de aarde te volgen Planten die in het koraalrif zitten

Planten die in het koraalrif zitten

Hoofdlijnen

- Tsunami onthult menselijke geluidsoverlast in Hawaiiaanse wateren

- Hebben vogelgezang en menselijke spraak biologische wortels?

- De definitie van abiotische en biotische factoren

- Een 3D-plantencel maken met huishoudelijke materialen

- Biomedical Engineering Project Onderwerpen voor High School

- Wat is een Zygote?

- Is hangry een echte emotie?

- Het Bohr-model:snel vervangen maar nooit vergeten

- Berekening van de tijd voor celverdubbeling

Een systeem om hypnagogische microdromen te beïnvloeden

Een systeem om hypnagogische microdromen te beïnvloeden Hoe vierkante voetjes omzetten in vierkante meters

Hoe vierkante voetjes omzetten in vierkante meters  Vloeistofmicroscopietechniek onthult nieuw probleem met lithium-zuurstofbatterijen

Vloeistofmicroscopietechniek onthult nieuw probleem met lithium-zuurstofbatterijen Ideeën om olie uit het water te halen

Ideeën om olie uit het water te halen  Verband gevonden tussen vroege postkantoorlocaties en moderne misdaadcijfers

Verband gevonden tussen vroege postkantoorlocaties en moderne misdaadcijfers Dinosaurushersenen van baby tot volwassene

Dinosaurushersenen van baby tot volwassene Gemini North-waarnemingen zorgen voor doorbraak in eeuwenoude poging om astronomisch mysterie te ontrafelen

Gemini North-waarnemingen zorgen voor doorbraak in eeuwenoude poging om astronomisch mysterie te ontrafelen Cheese Mold Experiments

Cheese Mold Experiments

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Swedish | German | Dutch | Danish | Norway | Portuguese |

-

Wetenschap © https://nl.scienceaq.com