Wetenschap

Als gezichten gedeeltelijk bedekt zijn, zijn noch mensen, noch algoritmen goed in het lezen van emoties

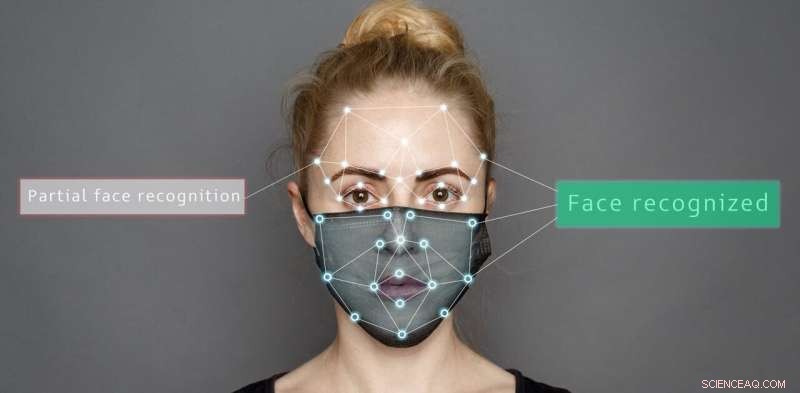

Credit:Shutterstock/Sergey Tinyakov

Kunstmatige systemen zoals thuiszorgrobots of rijhulptechnologie komen steeds vaker voor, en het is tijd om te onderzoeken of mensen of algoritmen beter zijn in het lezen van emoties, vooral gezien de extra uitdaging die gezichtsbedekkingen met zich meebrengen.

In onze recente studie hebben we vergeleken hoe gezichtsmaskers of zonnebrillen ons vermogen om verschillende emoties te bepalen beïnvloeden in vergelijking met de nauwkeurigheid van kunstmatige systemen.

We presenteerden afbeeldingen van emotionele gezichtsuitdrukkingen en voegden twee verschillende soorten maskers toe:het volledige masker dat wordt gebruikt door eerstelijnswerkers en een recent geïntroduceerd masker met een transparant venster om liplezen mogelijk te maken.

Onze bevindingen laten zien dat algoritmen en mensen beide moeite hebben wanneer gezichten gedeeltelijk worden verduisterd. Maar kunstmatige systemen hebben meer kans om emoties op ongebruikelijke manieren verkeerd te interpreteren.

Kunstmatige systemen presteerden significant beter dan mensen bij het herkennen van emoties wanneer het gezicht niet bedekt was:98,48% vergeleken met 82,72% voor zeven verschillende soorten emoties.

Maar afhankelijk van het type bekleding varieerde de nauwkeurigheid voor zowel mensen als kunstmatige systemen. Zonnebrillen verdoezelden bijvoorbeeld de angst voor mensen, terwijl gedeeltelijke maskers zowel mensen als kunstmatige systemen hielpen om geluk correct te identificeren.

Belangrijk is dat mensen onbekende uitdrukkingen voornamelijk als neutraal classificeerden, maar kunstmatige systemen waren minder systematisch. Ze selecteerden vaak ten onrechte woede voor afbeeldingen die verborgen waren met een volledig masker, en ofwel woede, geluk, neutraal of verrassing voor gedeeltelijk gemaskeerde uitdrukkingen.

De studie gebruikte volledige en gedeeltelijke maskers en zonnebrillen om delen van het gezicht te verbergen. Auteur verstrekt

Gelaatsuitdrukkingen decoderen

Ons vermogen om emoties te herkennen gebruikt het visuele systeem van de hersenen om te interpreteren wat we zien. We hebben zelfs een hersengebied dat gespecialiseerd is voor gezichtsherkenning, het spoelvormige gezichtsgebied, dat helpt bij het interpreteren van informatie die door de gezichten van mensen wordt onthuld.

Samen met de context van een bepaalde situatie (sociale interactie, spraak en lichaamsbeweging) en ons begrip van gedrag uit het verleden en sympathie voor onze eigen gevoelens, kunnen we ontcijferen hoe mensen zich voelen.

Er is een systeem van gezichtsactie-eenheden voorgesteld voor het decoderen van emoties op basis van gezichtssignalen. Het omvat eenheden zoals 'de wangverhoger' en 'de liphoektrekker', die beide worden beschouwd als onderdeel van een uitdrukking van geluk.

Daarentegen analyseren kunstmatige systemen pixels van afbeeldingen van een gezicht bij het categoriseren van emoties. Ze geven pixelintensiteitswaarden door een netwerk van filters die het menselijke visuele systeem nabootsen.

De bevinding dat kunstmatige systemen emoties van gedeeltelijk verduisterde gezichten verkeerd classificeren, is belangrijk. Het kan leiden tot onverwacht gedrag van robots die interactie hebben met mensen die gezichtsmaskers dragen.

Stel je voor dat ze een negatieve emotie, zoals woede of verdriet, verkeerd classificeren als een positieve emotionele uitdrukking. De kunstmatige systemen zouden proberen te communiceren met een persoon die actie onderneemt op basis van de misleide interpretatie waar hij blij mee is. Dit kan nadelige gevolgen hebben voor de veiligheid van deze kunstmatige systemen en de interactie tussen mensen.

Kun je de emotie van de onderzoekers aflezen van hun bedekte gezichten? Zowel kunstmatige systemen als mensen worden gecompromitteerd bij het categoriseren van emoties wanneer gezichten worden verduisterd. Auteur verstrekt

Risico's van het gebruik van algoritmen om emoties te lezen

Ons onderzoek herhaalt dat algoritmen vatbaar zijn voor vooroordelen in hun oordeel. De prestaties van kunstmatige systemen worden bijvoorbeeld sterk beïnvloed als het gaat om het categoriseren van emoties uit natuurlijke beelden. Zelfs alleen de hoek of schaduw van de zon kan de resultaten beïnvloeden.

Algoritmen kunnen ook raciaal vooringenomen zijn. Zoals eerdere studies hebben aangetoond, kan zelfs een kleine verandering in de kleur van het beeld, die niets te maken heeft met emotionele expressies, leiden tot een verminderde prestatie van algoritmen die worden gebruikt in kunstmatige systemen.

Alsof dat nog niet genoeg van een probleem was, kunnen zelfs kleine visuele verstoringen, niet waarneembaar voor het menselijk oog, ervoor zorgen dat deze systemen een invoer verkeerd identificeren als iets anders.

Sommige van deze problemen met verkeerde classificatie kunnen worden aangepakt. Algoritmen kunnen bijvoorbeeld worden ontworpen om rekening te houden met emotiegerelateerde kenmerken zoals de vorm van de mond, in plaats van informatie te halen uit de kleur en intensiteit van pixels.

Een andere manier om dit aan te pakken is door de kenmerken van de trainingsgegevens te wijzigen:de trainingsgegevens oversamplen zodat algoritmen menselijk gedrag beter nabootsen en minder extreme fouten maken wanneer ze een uitdrukking verkeerd classificeren.

Maar over het algemeen nemen de prestaties van deze systemen af bij het interpreteren van afbeeldingen in echte situaties wanneer gezichten gedeeltelijk bedekt zijn.

Hoewel robots een hogere dan menselijke nauwkeurigheid claimen in emotieherkenning voor statische afbeeldingen van volledig zichtbare gezichten, is hun prestatie in echte situaties die we elke dag ervaren, nog steeds niet menselijk.

Nieuwe klasse zachte halfgeleiders kan HD-schermen transformeren

Nieuwe klasse zachte halfgeleiders kan HD-schermen transformeren Verbinding kan magnetisch beter presteren dan neodymiummagneten

Verbinding kan magnetisch beter presteren dan neodymiummagneten Realtime atomaire beweging volgen tussen kristalkorrels in metalen

Realtime atomaire beweging volgen tussen kristalkorrels in metalen Techniek kan helpen bij massaproductie van biologisch afbreekbaar plastic

Techniek kan helpen bij massaproductie van biologisch afbreekbaar plastic Wetenschappers onthullen verborgen katalytisch oppervlak van Ni-Au-kernschil in kooldioxidehydrogenering

Wetenschappers onthullen verborgen katalytisch oppervlak van Ni-Au-kernschil in kooldioxidehydrogenering

bufferzones, betere regelgeving nodig om landbouwvervuiling in rivieren te voorkomen, stromen

bufferzones, betere regelgeving nodig om landbouwvervuiling in rivieren te voorkomen, stromen Uitputting van de ozonlaag leidt tot klimaatverandering op het zuidelijk halfrond

Uitputting van de ozonlaag leidt tot klimaatverandering op het zuidelijk halfrond Wat is het verschil tussen een Amerikaanse zeearend en een steenarend?

Wat is het verschil tussen een Amerikaanse zeearend en een steenarend?  Studie beschrijft de aanwezigheid van textielmicrovezels in Zuid-Europese zeebodems

Studie beschrijft de aanwezigheid van textielmicrovezels in Zuid-Europese zeebodems NASA's Terra-satelliet toont rokerige bleekheid over het grootste deel van Californië

NASA's Terra-satelliet toont rokerige bleekheid over het grootste deel van Californië

Hoofdlijnen

- Verrassend snelle evolutie waargenomen bij hagedissoorten

- Natuurlijke selectie: definitie, Darwins-theorie, voorbeelden en feiten

- "Fingerprint Experiments

- Wat gebeurt er met een dierlijke cel in een hypotone oplossing?

- Pharmacy Research Topics

- Wat hebben alle levende organismen gemeen?

- Bepaling van allelfrequenties

- Robotapparaat volgt plantengroei op cellulair niveau

- Hoe een utility-functie af te leiden

- Onderzoekers koppelen realisme aan blockchain-belofte

- Carpentry Compiler helpt houtbewerkers bij het ontwerpen van objecten die ze ook echt kunnen maken

- Facebooks Mark Zuckerberg zegt dat het sociale netwerk politici niet mag censureren

- Renault behaalt nieuw verkooprecord dankzij opkomende markten

- Onderzoekers ontwikkelen nieuwe 3D-printmethode voor transparant glas

Polarisatie van licht: definitie, reflectie, breking en verstrooiing

Polarisatie van licht: definitie, reflectie, breking en verstrooiing Chelsea Manning en de opkomst van big data klokkenluiders in het digitale tijdperk

Chelsea Manning en de opkomst van big data klokkenluiders in het digitale tijdperk Nieuwe atoominterferometer kan traagheidskrachten meten met recordnauwkeurigheid

Nieuwe atoominterferometer kan traagheidskrachten meten met recordnauwkeurigheid Hoe te bepalen of koper echt is

Hoe te bepalen of koper echt is  Micronaaldpleister levert gelokaliseerde kankerimmunotherapie aan melanoom

Micronaaldpleister levert gelokaliseerde kankerimmunotherapie aan melanoom Is het zelfs mogelijk om Facebook effectief te reguleren? Meerdere pogingen hebben tot hetzelfde resultaat geleid

Is het zelfs mogelijk om Facebook effectief te reguleren? Meerdere pogingen hebben tot hetzelfde resultaat geleid Een stap om te bepalen welke auto-ongelukken traumatisch hersenletsel veroorzaken - en welke niet

Een stap om te bepalen welke auto-ongelukken traumatisch hersenletsel veroorzaken - en welke niet De gecompliceerde relaties tussen mens en natuur ontwarren voor een betere toekomst

De gecompliceerde relaties tussen mens en natuur ontwarren voor een betere toekomst

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com