Wetenschap

Deepfake-video's in een oogwenk detecteren

Het is eigenlijk heel moeilijk om foto's te vinden van mensen met hun ogen dicht. Krediet:Bulin/Shutterstock.com

Een nieuwe vorm van verkeerde informatie staat op het punt om zich via online gemeenschappen te verspreiden naarmate de tussentijdse verkiezingscampagnes van 2018 in volle gang zijn. Deze nepvideo's worden "deepfakes" genoemd naar het pseudonieme online-account dat de techniek populair heeft gemaakt - die de naam mogelijk heeft gekozen omdat het proces een technische methode gebruikt die "deep learning" wordt genoemd. Deze nepvideo's zien er erg realistisch uit.

Tot dusver, mensen hebben deepfake-video's in pornografie en satire gebruikt om het te laten lijken dat beroemde mensen dingen doen die ze normaal niet zouden doen. Maar het is vrijwel zeker dat er tijdens het campagneseizoen deepfakes zullen verschijnen, zogenaamd om kandidaten weer te geven die dingen zeggen of naar plaatsen gaan waar de echte kandidaat niet zou komen.

Omdat deze technieken zo nieuw zijn, mensen hebben moeite om het verschil te zien tussen echte video's en de deepfake-video's. Mijn werk, met mijn collega Ming-Ching Chang en onze Ph.D. student Yuezun Li, heeft een manier gevonden om op betrouwbare wijze echte video's van deepfake-video's te onderscheiden. Het is geen permanente oplossing, omdat de technologie zal verbeteren. Maar het is een begin, en biedt hoop dat computers mensen kunnen helpen waarheid van fictie te onderscheiden.

Wat is een 'deepfake', ' hoe dan ook?

Het maken van een deepfake-video lijkt veel op vertalen tussen talen. Diensten zoals Google Translate gebruiken machine learning – computeranalyse van tienduizenden teksten in meerdere talen – om woordgebruikpatronen te detecteren die ze gebruiken om de vertaling te maken.

Deepfake-algoritmen werken op dezelfde manier:ze gebruiken een soort machine learning-systeem dat een diep neuraal netwerk wordt genoemd om de gezichtsbewegingen van één persoon te onderzoeken. Vervolgens synthetiseren ze beelden van het gezicht van een andere persoon en maken daarbij analoge bewegingen. Door dit effectief te doen, wordt een video gemaakt van de doelpersoon die de dingen lijkt te doen of te zeggen die de bronpersoon deed.

Voordat ze goed kunnen werken, diepe neurale netwerken hebben veel broninformatie nodig, zoals foto's van de personen die de bron of het doelwit zijn van imitatie. Hoe meer afbeeldingen er worden gebruikt om een deepfake-algoritme te trainen, hoe realistischer de digitale nabootsing zal zijn.

Knipperen detecteren

Er zijn nog steeds fouten in dit nieuwe type algoritme. Een daarvan heeft te maken met hoe de gesimuleerde gezichten knipperen - of niet. Gezonde volwassen mensen knipperen ergens tussen de 2 en 10 seconden, en een enkele knippering duurt tussen een tiende en vier tiende van een seconde. Dat is wat normaal zou zijn om te zien in een video van een pratende persoon. Maar het is niet wat er in veel deepfake-video's gebeurt.

Wanneer een deepfake-algoritme wordt getraind op gezichtsbeelden van een persoon, het is afhankelijk van de foto's die op internet beschikbaar zijn en die als trainingsgegevens kunnen worden gebruikt. Zelfs voor mensen die vaak gefotografeerd worden, er zijn maar weinig afbeeldingen online beschikbaar waarop hun ogen gesloten zijn. Niet alleen zijn zulke foto's zeldzaam - omdat de ogen van mensen meestal open zijn - maar fotografen publiceren meestal geen afbeeldingen waarbij de ogen van de hoofdonderwerpen gesloten zijn.

Zonder trainingsbeelden van knipperende mensen, deepfake-algoritmen maken minder snel gezichten die normaal knipperen. Als we de totale knippersnelheid berekenen, en vergelijkt dat met het natuurlijke verspreidingsgebied, we ontdekten dat karakters in deepfake-video's veel minder vaak knipperen in vergelijking met echte mensen. Ons onderzoek maakt gebruik van machine learning om het openen en sluiten van ogen in video's te onderzoeken.

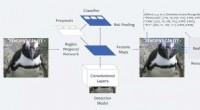

Dit geeft ons inspiratie om deepfake-video's te detecteren. Vervolgens, we ontwikkelen een methode om te detecteren wanneer de persoon in de video knippert. Om specifieker te zijn, het scant elk frame van een video in kwestie, detecteert de gezichten erin en lokaliseert vervolgens automatisch de ogen. Vervolgens gebruikt het een ander diep neuraal netwerk om te bepalen of het gedetecteerde oog open of dicht is. het uiterlijk van het oog gebruiken, geometrische kenmerken en beweging.

We weten dat ons werk misbruik maakt van een fout in het soort gegevens dat beschikbaar is om deepfake-algoritmen te trainen. Om te voorkomen dat u ten prooi valt aan een soortgelijke fout, we hebben ons systeem getraind op een grote bibliotheek met afbeeldingen van zowel open als gesloten ogen. Deze methode lijkt goed te werken, en als een resultaat, we hebben een detectiepercentage van meer dan 95 procent bereikt.

Dit is niet het laatste woord over het detecteren van deepfakes, natuurlijk. De technologie verbetert snel, en de concurrentie tussen het genereren en detecteren van nepvideo's is analoog aan een schaakspel. Vooral, knipperen kan worden toegevoegd aan deepfake-video's door gezichtsafbeeldingen op te nemen met gesloten ogen of door videosequenties te gebruiken voor training. Mensen die het publiek in verwarring willen brengen, zullen beter worden in het maken van valse video's - en wij en anderen in de technologiegemeenschap zullen manieren moeten blijven vinden om ze te detecteren.

Dit artikel is oorspronkelijk gepubliceerd op The Conversation. Lees het originele artikel.

Hoofdlijnen

- Wat is het verschil tussen een bacteriële en virale infectie?

- Wat maakt DNA-vingerafdrukken uniek?

- Een plantencel maken uit gerecycleerde materialen

- Moleculaire genetica (biologie): een overzicht

- Belangrijke foerageerplaatsen voor onechte karetschildpadden geïdentificeerd

- Lijst met genotypes

- Walviskarkas opgegraven van Australisch strand vanwege angst voor haaien

- Waarom lopen mensen meestal in dezelfde richting?

- Wat zijn de vier fasen van volledige glucose-afbraak?

- Rosetta-systeem ontketend door Facebook kan whoa zeggen tegen aanstootgevende memes

- Chauffeurs op de luchthaven van Denver komen vast te zitten in de modder met Google Maps

- Grote nieuwe studie brengt koers naar netto nul industriële emissies

- Hulpmiddelen voor gezichtsherkenning verbeteren met generatieve gezichtsaanvulling

- Wat zijn weerstanden gebruikt voor?

Beoordeling van biologisch afbreekbare zakken laat zien dat er niet genoeg bekend is om te beoordelen of ze veilig zijn voor het milieu

Beoordeling van biologisch afbreekbare zakken laat zien dat er niet genoeg bekend is om te beoordelen of ze veilig zijn voor het milieu Nieuwe methode maakt de weg vrij voor snijgereedschappen met een langere levensduur

Nieuwe methode maakt de weg vrij voor snijgereedschappen met een langere levensduur Internet-tv en mobiel video kijken dreigen de energiebehoefte te doen stijgen

Internet-tv en mobiel video kijken dreigen de energiebehoefte te doen stijgen Analyse van gegevensbronnen verbetert het vermogen om te reageren op klimaatverandering in Oost-Afrika

Analyse van gegevensbronnen verbetert het vermogen om te reageren op klimaatverandering in Oost-Afrika Sociale media doorzoeken om de dynamiek van outlaw-motorbendes te begrijpen

Sociale media doorzoeken om de dynamiek van outlaw-motorbendes te begrijpen Waarom de verkeerde informatie over COVID-19 zich begin maart sneller verspreidde dan een pandemie

Waarom de verkeerde informatie over COVID-19 zich begin maart sneller verspreidde dan een pandemie De peetvader van eco-bling:Brandos Tahitiaans paradijs

De peetvader van eco-bling:Brandos Tahitiaans paradijs Een zeer gevoelige nieuwe bloedtest kan zeldzame kankereiwitten detecteren

Een zeer gevoelige nieuwe bloedtest kan zeldzame kankereiwitten detecteren

- Elektronica

- Biologie

- Zonsverduistering

- Wiskunde

- French | Italian | Spanish | Portuguese | Swedish | German | Dutch | Danish | Norway |

-

Wetenschap © https://nl.scienceaq.com